Exercices : Algèbre 3 - Unité de Recherche en Mathématiques

Algèbre 3

Semestre d’hiver 2012/2013

Université du Luxembourg

Gabor Wiese

Version du 19 décembre 2012

Préface

L’objet principal du cours sera l’étude des extensions algébriques des corps commutatifs. En par-

ticulier, la théorie de Galois sera développée et appliquée. Elle permet entre autres de démontrer que

l’équation générale de degré au moins 5ne peut pas être résolue en radicaux et de résoudre (parfois

de manière négative) plusieurs problèmes classiques (provenant des anciens Grecs) de construction à

la règle et au compas comme la trisection d’un angle et la quadrature du cercle.

Au début du cours nous allons finir le traitement de la réduction de Jordan d’une matrice com-

mencé avant l’été.

Littérature

Voici quelques références sur la théorie de Galois en français :

– Jean-Pierre Escoffier : Théorie de Galois

– Jean-Claude Carrega : Théorie des corps, la règle et le compas

– Antoine Chambert-Loir : Algèbre corporelle

– Yvan Gozard : Théorie de Galois

– Patrice Tauvel : Corps commutatifs et théorie de Galois

– Josette Calais : Extension de corps, théorie de Galois

– Evariste Galois : le texte original!

Voici quelques d’autres références :

– Siegfried Bosch : Algebra (en allemand), Springer-Verlag. Ce livre est très complet et bien

lisible.

– Ian Stewart : Galois Theory. Ce livre est bien lisible. Le traitement de la théorie de Galois dans

le cours sera un peu plus général puisque Stewart se restreint dans les premiers chapîtres aux

sous-corps des nombres complexes.

– Serge Lang : Algebra (en anglais), Springer-Verlag. C’est comme une encyclopédie de l’al-

gèbre; on y trouve beaucoup de sujets rassemblés, écrits de façon concise.

1

1 RÉDUCTION DE JORDAN

2

1 Réduction de Jordan

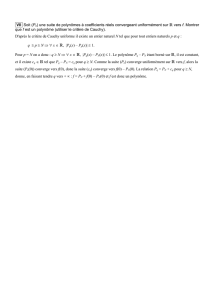

Nous commençons ce cours par la réduction de Jordan que nous avons bien préparée le semestre

précédent, mais, pas encore finie. Rappelons d’abord les définitions et résultats principaux déjà mis

en place avant l’été. Dans toute cette section, soit Kun corps commutatif.

Le théorème suivant est souvent appellé théorème fondamental sur les matrices, ce qui montre son

rôle fondamental : il dit que – après un choix de bases (pas oublier! !) – chaque application linéaire

peut être décrite de façon unique par une matrice, et que, réciproquement, chaque matrice – encore

pour un choix de bases fixé – définit une application linéaire.

Un mot sur les notations : contrairement à l’usage au semestre précédent, je noterai les bases main-

tenant avec des parenthèses, S= (v1,...,vn), et non avec des accolades car la forme des matrices

dépend de l’ordre des vecteur. Mais, maintenant il faut se méfier de ne pas confondre Savec un vecteur

(qui est aussi noté avec des parenthèses). Si nous avons deux sous-espace W1et W2d’un espace vec-

toriel Vavec des bases S1= (v1,...,vn)et S2= (w1,...,wm), on notera (v1,...,vn, w1,...,wm)

quand-même par S1∪S2.

Théorème 1.1. Soient V, W deux K-espaces vectoriels de dimensions finies net m. Rappellons

que nous notons HomK(V, W )l’ensemble de toutes les applications ϕ:V→Wqui sont K-

linéaires. Soient S= (v1,...,vn)une K-base de Vet T= (w1,...,wm)une K-base de W. Pour

ϕ∈HomK(V, W )et 1≤i≤n, le vecteur ϕ(vi)appartient à W, alors, on peut l’exprimer en tant

que combinaison K-linéaire des vecteurs dans la base Tainsi :

ϕ(vi) =

m

X

j=1

aj,iwj.

Nous « rassemblons » les coefficients aj,i dans une matrice :

MT,S (ϕ) :=

a1,1a1,2··· a1,n

a2,1a2,2··· a2,n

.

.

..

.

.....

.

.

am,1am,2··· am,n

∈Matm×n(K).

L’utilité de cette matrice est la suivante : Soit v∈Vun vecteur qui s’écrit en coordonnées pour

la base Scomme v=

b1

b2

.

.

.

bn

. Alors, le produit matriciel

a1,1a1,2··· a1,n

a2,1a2,2··· a2,n

.

.

..

.

.....

.

.

am,1am,2··· am,n

b1

b2

.

.

.

bn

est égale au vecteur ϕ(v)écrit en coordonnées pour la base T. C’est à dire que nous avons exprimé

l’image ϕ(v)en coordonnées. Alors, la matrice MT,S(ϕ)décrit l’application linéaire ϕen coordon-

nées.

1 RÉDUCTION DE JORDAN

3

L’assertion principale du théorème c’est : L’application

HomK(V, W )→Matm×n(K), ϕ 7→ MT,S (ϕ)

est une bijection. Elle est même un isomorphisme de K-algèbres.

Démonstration. La preuve n’est qu’un calcul assez simple et a été donnée avant l’été. Elle fait partie

de celles que chaqu’un(e) devrait pouvoir reproduire. Alors, c’est le cas?

Dans le reste de cette section nous nous intéressons au cas spécial W=V. Une application

K-linéaire ϕ:V→Vest aussi appellée endomorphisme et nous écrivons

EndK(V) := HomK(V, V ).

A partir d’ici, fixons un K-espace vectoriel Vde dimension finie n.

Définition 1.2. Soit ϕ∈EndK(V).

–a∈Kest appellé valeur propre de ϕs’il existe 06=v∈Vt.q. ϕ(v) = av (ou équivalent :

ker(ϕ−a·idV)6= 0).

– On pose Eϕ(a) := ker(ϕ−a·idV). Si aest une valeur propre de ϕ, on appelle Eϕ(a)l’espace

propre pour a.

– Chaque 06=v∈Eϕ(a)est appellé vecteur propre pour la valeur propre a.

– On pose Spec(ϕ) = {a∈K|aest valeur propre de ϕ}.

– On appelle ϕdiagonalisable si V=La∈Spec(ϕ)Eϕ(a).

Vous avez déjà vu beaucoup d’exemples, en algèbre linéaire et en algèbre 2 avant l’été. Rappellons

quand-même une formulation équivalente de la diagonalisabilité (qui explique le nom).

Proposition 1.3. Soit ϕ∈EndK(V)et Spec(ϕ) = {a1,...,ar}. Les assertions suivantes sont

équivalentes :

(i) ϕest diagonalisable.

(ii) Il existe une base Sde Vt.q.

MS,S(ϕ) =

a100000 0000

0...00000 0000

0 0 a10000 0000

0 0 0 a2000 0000

0 0 0 0 ...00 0000

0 0 0 0 0 a20 0000

0 0 0 0 0 0 ...0000

0 0 0 0 0 0 0 ...000

0 0 0 0 0 0 0 0 ar0 0

0 0 0 0 0 0 0 0 0 ...0

0 0 0 0 0 0 0 0 0 0 ar

.

Pour 1≤i≤r, la valeur aiapparaît dimKEϕ(ai)fois sur la diagonale.

1 RÉDUCTION DE JORDAN

4

Démonstration. «(i) ⇒(ii) » : Pour chaque 1≤i≤rnous choisissons (par exemple, en la calculant)

une base Side Eϕ(ai)et posons S=S1∪S2∪···∪Sr. Puisque ϕest diagonalisable, Vest la somme

directe des Eϕ(ai); ceci ne dit rien d’autre que Sest une base de V. La forme diagonale de la matrice

provient immédiatement du théorème fondamental sur les matrices 1.1.

« (ii) ⇒(i) » : Ecrivons S= (v1,...,vn)et eipour le nombre de fois que aiapparaît sur la

diagonale. Alors, Eϕ(a1)est le sous-espace de Vengendré par les premiers e1vecteurs de S; ensuite,

Eϕ(a2)est le sous-espace de Vengendré par les prochains e2vecteurs de S, etc. Ceci montre que V

est bien la somme directe des Eϕ(ai)pour 1≤i≤r.

Définition 1.4. – Soit M∈Matn×n(K)une matrice. Le polynôme caractéristique de Mest

défini comme

carM(X) := det X·idn−M∈K[X].

– Soit ϕ∈EndK(V). Le polynôme caractéristique de ϕest défini comme

carφ(X) := carMS,S (ϕ)(X).

Avant l’été nous nous sommes convaincues que carϕne dépend pas du choix de la base S. Nous

avons aussi vu plusieurs exemples que nous n’allons pas répeter ici.

Proposition 1.5. Spec(ϕ) = {a∈K|carϕ(a) = 0}={a∈K|(X−a)|carϕ(X)}.

Démonstration. C’est facile, n’est-ce pas?

A part le polynôme caractéristique nous avons également introduit le polynôme minimal dont

on rappelle aussi la définition. On se souvient qu’on a démontré que K[X]est un anneau euclidien

(pour la division euclidienne de polynômes, c’est à dire « avec reste »), alors, comme on l’a démontré

également, K[X]est un anneau principal : chaque idéal est principal, c’est à dire, peut être engendré

par un seul élément. Nous allons utiliser ce fait maintenant.

Définition-Lemme 1.6. (a) Soit M∈Matn×n(K)une matrice. Si f(X) = Pd

i=0 aiXi∈K[X]

est un polynôme, alors nous posons f(M) := Pd

i=0 aiMi, ce qui est encore une matrice dans

Matn×n(K).

(b) L’application « evaluation »

evM:K[X]→Matn×n(K), f(X)7→ f(M)

est un homomorphisme d’anneaux (même de K-algèbres).

(c) Le noyau ker(evM)est un idéal principal non-nul de l’anneau principal K[X], alors, il existe

un unique polynôme normalisé mM(X)∈K[X]qui engendre ker(evM). On appelle mM(X)le

polynôme minimal de M.

(d) mM(X)est le polynôme normalisé de degré minimal qui annule M(c’est à dire : mM(M) = 0n

où 0nest la matrice zéro dans Matn×n(K)(qu’on denotéra aussi 0pour simplicité)).

(e) Soit ϕ∈EndK(V). Nous posons

mϕ(X) := mMS,S (ϕ)(X)

et l’appellons polynôme minimal de ϕ. Ce polynôme ne dépend pas du choix de la base S.

1 RÉDUCTION DE JORDAN

5

Démonstration. (a) est clair.

(b) C’est un calcul facile.

(c) Remarquons que K[X]est de dimension infinie alors que la dimension de Matn×n(K)est

finie, ce qui montre que evMne peut pas être injective. Alors, son noyau est non-nul et engendré par

un polynôme qui est unique à multiplication par K×près, ce qui nous permet de le normaliser.

(d) est clair.

(e) L’indépendence du choix de la base provient du fait que la conjugaison avec la matrice de

changement de base décrit un isomorphisme de Matn×n(K).

Le polynôme caracteristique carM(X)et le polynôme minimal mM(X)sont liés par le théorème

de Cayley-Hamilton.

Théorème 1.7 (Cayley-Hamilton).Soit M∈Matn×n(K). Alors,

carM(M) = 0n∈Matn×n(K).

En particulier, mM(X)est un diviseur de carM(X).

Démonstration. L’astuce est d’utiliser les matrices adjointes. Nous avons

(X·idn−M)adj ·(X·idn−M) = det(X·idn−M)·idndéf

= carM(X)·idn.(1.1)

Notez que la matrice X·idn−Mest à coefficients dans l’anneau des polynômes K[X]. Mais, il

est facile de vérifier que la propriété principale des matrices adjointes que nous venons d’utiliser est

valable pour chaque anneau commutative et pas seulement pour R, le cas pour lequel vous avez vu la

preuve en algèbre linéaire.

La définition de la matrice adjointe montre que la plus grande puissance de Xqui peut apparaître

dans un coefficient de la matrice (X·idn−M)adj est n−1. Nous pouvons alors écrire cette matrice

en tant que polynôme de degré n−1à coefficients dans Matn×n(K):

(X·idn−M)adj =

n−1

X

i=0

BiXiavec Bi∈Matn×n(K).

Nous écrivons carM(X) = Pn

i=0 aiXiet reprenons l’équation (1.1) :

carM(X)·idn=

n

X

i=0

ai·idn·Xi=n−1

X

i=0

BiXi(X·idn−M)

=

n−1

X

i=0

(BiXi+1 −BiMXi) = −B0M+

n−1

X

i=1

(Bi−1−BiM)Xi+Bn−1Xn.

Nous comparons les coefficients (encore des matrices!) pour obtenir

a0·idn=−B0M, ai·idn=Bi−1−BiMpour 1≤i≤n−1et Bn−1= 0.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

1

/

83

100%