Probabilités - 2eme année d`économie et de gestion

Probabilités

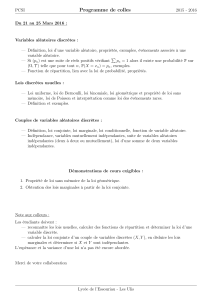

Chapitre 6 : Loi normale ou loi de Laplace-Gauss ........................................................................................ 1

Section 1 : Définition. ................................................................................................................................... 1

Section 2 : Représentation graphique. ....................................................................................................... 1

Section 3 : Fonction de répartition. ............................................................................................................. 2

Section 4 : Définitions .................................................................................................................................. 2

A- Espérance - Variance .......................................................................................................................... 2

B- Variable aléatoire centrée réduite .................................................................................................... 2

C- Somme de variables aléatoires. ........................................................................................................ 3

Section 5 : Calcul de probabilités pour N(0, 1). ........................................................................................ 3

A- Utilisation de la table ......................................................................................................................... 3

B- Utilisation de la table 2. ..................................................................................................................... 4

Section 6 : Calculs de probabilité pour une loi N (m,

) ....................................................................... 4

Chapitre 7 : Condition d’application de la loi normale................................................................................ 5

Section 1 : Théorème central limite. ........................................................................................................... 6

Section 2 : Approximation d’une loi binomiale. ...................................................................................... 6

Section 3 : Approximation d’une loi de Poisson. ..................................................................................... 7

Chapitre 8 : Couples de variables aléatoires discrètes. ................................................................................ 7

Section 1 : Couples de variables aléatoires discrètes. ............................................................................. 7

Section 2 : Lois marginales ........................................................................................................................... 8

Section 3 : Fonction de répartition. ............................................................................................................. 8

A- Fonction de répartition du couple. .................................................................................................. 8

B- Fonction de répartition marginale. .................................................................................................. 9

Section 4 : Loi de probabilité conditionnelle. .......................................................................................... 9

Section 5 : Indépendance de deux variables. .......................................................................................... 10

Section 6 : Espérance conditionnelle ........................................................................................................ 11

Section 7 : Variance conditionnelle. ......................................................................................................... 12

Chapitre 6 : Loi normale ou loi de Laplace-Gauss

Section 1 : Définition.

La variable aléatoire absolument continue X suit une loi normale (ou loi de Laplace-Gauss) si

X prend ses valeurs dans R si elle admet pour densité de probabilité :

2

mx

2

1

e

2

1

)x(f

On dit que X est une variable aléatoire normale (ou gaussienne) de paramètres m,

),m(N~X

On admettra que

1dt)t(f

Section 2 : Représentation graphique.

La fonction présente un maximum en x = m.

Elle est croissante de

à m, et décroissante de m à

.

La fonction présente deux points d’inflexion : m -

et m +

.

Soit x

R, 2m – x

R

f (2m – x) =

2

mxm2

2

1

e

2

1

f (2m – x) =

2

xm

2

1

e

2

1

f (2m – x) = f (x)

Section 3 : Fonction de répartition.

Par définition.

F (x) =

xdt)t(f

F (x) =

xmt

2

1

dte

2

1

2

F’ (x) = f (x)

f > 0 donc F’ > 0 croissante.

F’’(x) = f’(x)

F’’(m) = 0 F’’ change de signe en m

x = m est un point d’inflexion de F.

Cf est symétrique par rapport à x = m.

1dt)t(f

mm

2

1

)m(F5,0dt)t(f1dt)t(f2

Section 4 : Définitions

A- Espérance - Variance

),m(N~X

E(X) = m

V(X) =

²

B- Variable aléatoire centrée réduite

Soit X une variable aléatoire.

Définition :

La variable aléatoire

)X(EX

est la variable aléatoire centrée réduite associée à X.

Propriété :

La variable aléatoire centrée réduite associée à X a une espérance nulle et une variance égale à 1.

1²

²

1

)X(V

²

1

)X(EX

V

0)]X(E)X(E[

1

))X(EX(E

1

)X(EX

E

Propriété :

Soit

),m(N~X

Alors

)1,0(N~

mX

.

La loi N (0, 1) est la loi normale centrée réduite de densité f(x) =

2

²x

e

2

1

C- Somme de variables aléatoires.

Soit

),m(N~X 111

et

),m(N~X 222

X1 et X2 indépendantes.

)²²,mm(N~XX 212121

Soit

),m(N~X 21i

pour i = 1, …, n

Xi indépendantes.

n

1i

n

1i

ii ²,m

Section 5 : Calcul de probabilités pour N(0, 1).

Soit U ~ N(0, 1) de densité f (x) =

2

²x

e

2

1

de fonction de répartition

x2

²t

e

2

1

)x(

Table 1 :

p (U < u) connaissant u on lit les probabilités.

Table 2 :

On connaît la probabilité, on lit les fractiles.

A- Utilisation de la table

On lit

)uU(p)u(

connaissant u.

Exemple 1 :

U ~ N(0, 1)

p (U < 0,27) = 0,6064

p (U < 1,74) = 0,9591

p (U > 1,21) = 0,1131

Propriété 1 :

U ~ N(0, 1)

p (U > u) = 1 – p (U < u) = 1 -

(u)

Exemple :

p (U < - 0,38) = p (U > 0,38) = 1 – p (U < 0,38) = 1 – 0,648 = 0,352.

Propriété 2 :

Soit U ~ N(0, 1)

P (U < - u) = 1 – p (U < u) = 1 -

(u)

Propriété 3 :

Soit U ~ N(0, 1)

0u5,0)u(

0u5,0)u(

Propriété 4 :

U ~ N (0, 1)

)u()u(uUup 1221

Exemple :

p ( - 0,2 < u < 1,07) =

(1,07) -

(- 0,2) =

(1,07) – 1 +

(0,2) = 0,8577 – 1 + 0,5793 = 0,437

p ( -1 < u < 1) =

(1) -

(-1) =

(1) – 1 +

(-1) = 2

(1) – 1 = 0,6826

Propriété 5 :

Soit U ~ N(0, 1)

p (

U

< u) = 2

(u) – 1

p (

U

> u) = 2 - 2

(u)

p (

U

> 0) = 1 – p (

U

< u) = 1 – (2

(u) – 1) = 2 - 2

(u).

Exemple :

P (U < 1,646)

(1,64) = 0,9495 et

(1,65) = 0,9505

(1,646) = 0,9501

p (U < 1,646) = 0,9501.

B- Utilisation de la table 2.

Définition :

On appelle fractile d’ordre

(

[0 ; 1]) pour une fonction de répartition F, la valeur

U

/ F (

U

) =

. P (U <

U

) =

.

Exemples :

U ~ N (0, 1)

Déterminer u / p (U < u) = 0,975

U = 1,96

Déterminer u / p (U < u) = 0,2.

0,2 < 0,5

u < 0.

On lit 0,8416.

u = - 0,8416.

Déterminer u / p (U > u) = 0,05

u / p (U < u) = 0,95

u = 1,6449.

Déterminer u / p (-1,16 < U < u) = 0,5.

(-1,16) = 0,123.

(u) = 0,623

U = 0,3134.

Section 6 : Calculs de probabilité pour une loi N (m,

)

X ~ N (m,

) alors

mX

~ N (0, 1)

Exemples de calcul de probabilité :

1) X ~ N (3, 2) p (X < 6,24)

1ère étape : Se ramener à une loi centrée réduite.

P (X < 6,24) = p

2

324,6

2

3X

= p

62,1

2

3X

.

On pose U =

2

3X

U ~ N (0, 1).

2ème étape : On fait le calcul avec U. p (U < 1,62) = 0,9474

3ème étape : Conclusion p (X < 6,24) = 0,9474.

2) X ~ N (-4, 5) p (X < 1,65)

p (X < 1,65) = p

5

465,1

5

4X

p (U < 1,13) = 0,8709

p (X < 1,65) = 0,8709.

3) X ~ N (-2, 4) p (X > 4,94)

p (X > 4,94) = p

4

294,4

4

2X

p (U > 1,735) = 1 – 0,9587 = 0,0413

p (X > 4,94) = 0,0413

4) X ~ N (-3, 4) p (-5 < X < -1)

p (-5 < X < -1) = p

4

31

4

3X

4

35

p (-0,5 < U) = 0,3085

P (U < 0,5) = 0,6905

P (-5 < X < -1) = 0,6905 – 0,3085 = 0,383

1) Soit X ~ N (2, 0,5)

Déterminer x / p (X < x) = 0,675

p

5,0

2x

5,0

2X

= 0,675

p (2X – 4 < 2x – 4) = 0,675

2x – 4 = 0,4538

2x = 4,4538

x = 2,2269

2) Soit X ~ N (1, 3)

Déterminer x / p (X < x) = 0,294.

X = - 0,5417 * 3 + 1 = - 0,6251

3) Soit X ~ N (-3, 1)

Déterminer x / p (- 4,53 < X < x) = 0,687

P

1

3x

1

3X

1

353,4

= 0,687

P ( - 1,53 < U < x + 3 ) = 0,687

( - 1,53) = 0,063

( x + 3 ) = 0,75

x + 3 = 0,6745

x = - 2,3255

Chapitre 7 : Condition d’application de la loi normale.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

1

/

13

100%