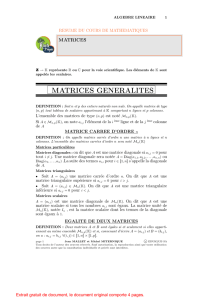

Fiche 5

M(p, n, )

(p, n)

A∈ M(p, n, )ai,j i`eme j`eme A= (ai,j )

M(p, n, )p n

p n ∆i,j

(i, j)∈ {1,· · · , p}×{1,· · · , n}∆i,j = (i, j) 1

p n

(i, j)p

A= (ai,j )

A=

p

X

i=1

n

X

j=1

ai,j ∆i,j

A∈ M(p, n, )

A

V(L1(A),· · · , Lp(A)) M(1, n, )p A

A∈ M(p, n, )t

A∈ M(n, p, )

A A = (ai,j )t

A= (aj,i)

t(t

A) = A

t(αA +βB) = αt

A+βt

B

(t

A) = (A)

AV(C1(A),· · · , Cn(A))

M(p, 1,)n A

t

A=A

A= (ai,j ) (n, n)⇐⇒ ∀i, j ∈ {1,· · · , n}, aj,i =ai,j

(n, n)S(n, )n2+n

2M(n, )

t

A=−A

A= (ai,j ) (n, n)⇐⇒ ∀i, j ∈ {1,· · · , n}, aj,i =−ai,j

(n, n)A(n, )n2−n

2M(n, )

S(n, )A(n, )M(n, )

A∈ M(n, )A=1

2A+t

A+1

2A−t

A

k s1,· · · , sk∈r

t1,· · · , tr∈M= (mi,j )∈ M(k, r, )

s1

sk

=

m1,1t1+· · · +m1,rtr

mk,1t1+· · · +mk,r tr

.

s1

sk

=

m1,1· · · m1,r

mk,1· · · mk,r

t1

tr

s1

sk

=M

t1

tr

.

p z1,· · · , zp∈q y1,· · · , yq

n x1,· · · , xnz1,· · · , zp

x1,· · · , xnA∈ M(p, q, )B∈ M(q, n, )C∈ M(p, n, )

z1

zp

=A

y1

yq

y1

yq

=B

x1

xn

z1

zp

=C

x1

yn

z1

zp

=C

x1

xn

=A

y1

yq

=A

B

x1

xn

C A B AB

A1· · · An

A1· · · AnA1

An

×(α1· · · αq)

β1

βq

= (α1β1+· · · +αqβq)

ci,j AB ×

ci,j =Li(A)×Cj(B)

∀A, B ∈ M(p, q, )∀M, N, ∈ M(q, n, )A(M+N) = AM +AN (A+B)M=AM +BM

AB A B

M(p, q, )p=q

InM(n, )

t(AB) = t

Bt

A

Li(M)Cj(M)M

AB Li(AB) = Li(A)×B

AB B

AB Cj(AB) = A×Cj(B)

AB A

(AB)6min ( (A),(B))

Ik

N

M(p, q, )∀A∈ M(p, q, )N A =A

N(p, p)

A∆i,j M(p, q, )

N Ipp1

M(p, q, )Iq

A∈ M(p, q, )

A∈ M(p, q, )A0A0A=I

q q 6p

A∈ M(p, q, )A00 AA00 =I

p p 6q

A p

A−1

AA−1=A−1A=Ip

Ip

A

n

X

k=0

αkAk= 0 α06= 0

A A

A−1=−

n

X

k=1

αk

α0Ak−1

A∈ M(p, )

3A4−A3+ 5A2−7A1+ 2A0= 0

3A4−A3+ 5A2−7A1=−2Ip

−3

2A4+1

2A3−5

2A2+7

2A1=Ip

A

−3

2A3+1

2A2−5

2A1+7

2IpA=IpI1

A A−1=−3

2A3+1

2A2−5

2A+7

2Ip

A

A p

A AX =Y

X=A−1Y A−1

A p p

A A−1

(A|I)

AX =Y

(A|I)⇐⇒ · · · ⇐⇒ (I|A−1)

A A−1

A

A

(A|I)⇐⇒ (E1A|E1I)⇐⇒ · · · ⇐⇒ (Ek· · · E1A|Ek· · · E1I)=(I|A−1)

A−1=Ek· · · E1

A1· · · An

(A1· · · An)−1=A−1

n· · · A−1

1

A

Ek· · · E1A−1

A= (Ek· · · E1)−1=E−1

1· · · E−1

kE−1

jEj

A

A

A p M ∈ M(p, n, )

N∈ M(n, p, ) (AM) = (M) (N A) = (N)

A AM

NA

A

At

At

A−1=tA−1.

2 3

M(p, ) ( p)p

p

p

(p)pp−(p)p

1p(e1,· · · , ep)pp

A∈ M(p, )

det(A)|A|p A

p A

det(Ip)=1

A

A Li←λLiλ

A Li←Li+µLkk6=i

Adet(A) = 0

Adet(A)=0

Adet(A)

Adet(A)

C1det(t

A) = det(A)

C2C62 6

p×p p (p−1) ×(p−1)

A= (ai,j )∈ M(p, )

Ac

i,j ∈ M(p−1,)i j A

ai,j (−1)i+jdet Ac

i,j

i`eme

det(A) =

p

X

j=1

ai,j (−1)i+jdet Ac

i,j

j`eme

det(A) =

p

X

i=1

ai,j (−1)i+jdet Ac

i,j

6

6

1

/

6

100%