Probabilités : variables aléatoires

Probabilités : variables aléatoires

C. Charignon

Table des matières

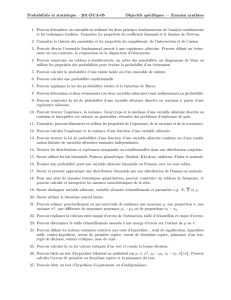

I Cours 2

1 Vocabulaire 2

2 Caractéristiques d’une loi 3

2.1 Espérance............................................... 3

2.2 Varianceetécart-type ........................................ 4

3 Plusieurs variables aléatoire 6

3.1 Loisconjointesetmarginales .................................... 6

3.2 Indépendance............................................. 6

3.3 Indépendancemutuelle........................................ 8

4 lois usuelles 8

4.1 loiuniforme.............................................. 8

4.2 Bernoulli ............................................... 9

4.3 Loibinomiale............................................. 10

II Exercices 12

1 Révisions de probabilités 1

2 Espérance 1

3 Variance 3

4 Couple de variables aléatoires 5

5 Lois usuelles 6

1

Première partie

Cours

1 Vocabulaire

Définition 1.1. Une variable aléatoire sur l’univers Ωest une application dont l’ensemble de départ est Ω.

Lorsque l’ensemble d’arrivée est inclus dans R, on dit que Xest une variable aléatoire réelle.

Exemple: On lance deux dés de 6. On choisit de modéliser l’expérience à l’aide de l’univers Ω = J1,6K×

J1,6Kmuni de la probabilité uniforme.

La somme des deux résultats obtenus sera alors modélisé par la variable aléatoire S:Ω→N

(a, b)7→ a+b.

On va suivre le vocabulaire de cette partie sur cet exemple.

Dans la suite, fixons Xune variable aléatoire et Eson ensemble d’arrivée.

Ainsi X(Ω), l’image de Xest l’ensemble des valeurs atteintes par X. Dans notre exemple, E=Net

S(Ω) = J2,12K.

Soit n∈E. L’ensemble des antécédents de npar Xse note normalement X<−1>({n}). Il s’agit de

l’ensemble des configurations de l’univers qui mène à ce que Xprenne la valeur n. Comme c’est une partie

de Ω, c’est un événement. Nous le noterons « X=n». Et donc sa probabilité sera notée P(X=n).

Dans notre exemple, l’événement S= 9 correspond à la partie de Ωsuivante : {(3,6),(4,5),(5,4),(6,3)}.

Et donc P(S= 9) = 4

36 =1

9.

Plus généralement, pour tout A∈ P(E),X<−1>(A) = ω∈Ω|X(ω)∈Acorrespond à l’événement

X∈A. Sa probabilité est notée P(X∈A).

Dans l’exemple, calculons P(S∈ {2,4,6,8,10,12}(qu’on peut noter P(Sest pair )).

Proposition 1.2. L’application P(E)→[0,1]

A7→ P(X∈A)est une mesure de probabilité sur E.

Définition 1.3. L’application P(E)→[0,1]

A7→ P(X∈A)s’appelle la loi de X, et se note PX.

N.B. Si on connaît PX, on peut déduire tout ce dont on a besoin sur X. L’univers Ωet sa mesure de

probabilité deviennent inutiles. On évite ainsi la partie fastidieuse de modélisation. C’est le point de vue de

nombreux exercices.

Dans notre exemple, on aurait pu aussi modéliser le lancer de deux dés par l’univers Ω0=J2,12Kavec

la mesure de probabilité P0adéquate. On obtiendrait une autre variable aléatoire Smais qui aura la même

loi de probabilité. Tous les calculs concernant cette somme des deux résultats des deux dés seront alors

identique, que l’on utilise Ωou Ω0.

Concrètement lorsqu’on demande de donner la loi de X, il faut :

1. Déterminer les valeurs prises par X(formellement X(Ω))

2. Et donner la probabilité pour chacune de ces valeurs.

Il est inutile de donner la probabilité de chaque événement P(X∈A), pour A∈ P(X(Ω)), car on a

toujours la formule :

P(X=A) = X

a∈A

P(X=a).

2

2 Caractéristiques d’une loi

Fixons une variable aléatoire X, sa loi est donc notée PX. On suppose que Xest à valeurs réelles, i.e.

X: Ω →R.

2.1 Espérance

Définition 2.1. On appelle l’espérance de X, et on note E(X)le nombre suivant :

E(X) = X

n∈X(Ω)

P(X=n)×n

Il s’agit de la valeur moyenne que peut prendre X. La formule est intuitive : on prend toutes les valeurs

possibles, et on pondère par la probabilité que Xprenne cette valeur : plus une valeur nest prise fréquemment,

plus elle sera comptée avec un fort coefficient.

Intuitivement, si on répète la même expérience aléatoire un grand nombre de fois, si on note X1, X2, X2, . . .

les résultats obtenus à chacune des expériences, on aura :

E(X) = lim

n→∞

X1+X2+. . . Xn

n

E(X)est bien la moyenne des résultats obtenus, lorsque le nombre d’expérience tend vers ∞.

La formalisation rigoureuse, et la preuve, de la formule ci-dessus ne sont pas au programme de la première

année.

cf exercice: 6

Proposition 2.2. Soit Yune autre VA sur Ω.

1. linéarité : soit λ∈R, alors E(X+λ.Y ) = E(X) + λE(y)

2. croissance : si X6Y(i.e. ∀ω∈Ω,X(ω)6Y(ω)), alors E(X)6E(Y).

Remarque : L’espérance a les mêmes propriétés que l’intégrale. Dans une théorie plus générale, on verrait

que l’espérance est une intégrale.

cf exercice: 14

La preuve est plus difficile qu’il n’y parait !

Lemme 2.3.

E(x) = X

ω∈Ω

P(ω)×X(ω)

N.B. Dans les exemples pratiques, on connaît rarement Ω, et donc ce lemme est peu utile. Il sert plutôt

pour des question théoriques.

Démonstration:

Soit k∈Net n1,...,nk∈Rktels que X(Ω) = {n1,...,nk}. (Les valeurs possibles pour Xsont n1,...nk.)

Notons encore pour tout i∈J1, kKAil’événement « X=ni».

N.B. En toute rigueur, cette notation est inutile, on pourrait rester avec la notation X=ni, et écrire des formules

du genre « ω∈(X=ni)». C’est tout de même un peu bizarre...

A1,...,Akforme alors un système complet d’événements pour Ω.

Le principe est maintenant simple : on découpe la somme X

ω∈Ω

en ksommes, une pour chacun des Ai:

X

ω∈Ω

P(ω)×X(ω) = X

ω∈A1

P(ω)×X(ω) + ··· +X

ω∈Ak

P(ω)×X(ω)

3

=X

ω∈A1

P(ω)×n1+··· +X

ω∈Ak

P(ω)×nk

=P(A1)×n1+··· +P(Ak)×nk

=E(X)

Une fois le lemme acquis, la proposition est facile.

Définition 2.4. Soit f:R→R. La variable aléatoire f◦Xest aussi notée f(X).

Proposition 2.5. (théorème du transfert)

Soit f:R→R. Alors :

E(f(X)) = X

n∈X(Ω)

f(n)×P(X=n)

Remarque : Plus généralement, ceci vaut dès que fest une fonction définie sur X(Ω).

Démonstration:

On reprend les notations du lemme :

E(f(X)) = X

ω∈Ω

f(X(ω)) ×P({ω})

=Xω∈A1f(n1)×P({ω}) + ··· +Xω∈Akf(nk)×P({ω})

=f(n1)×P(A1) + . . . f(nk)×P(Ak)

Exemple: Un jeu se joue entre deux joueurs Aet Bet consiste à lancer deux dés de 6. Notons Sla

somme des deux résultats, le joueur Adonne alors au joueur B(S−7)3euros. Préferez-vous être le joueur

Aou le joueur B?

2.2 Variance et écart-type

La variance permet de mesurer en moyenne de combien Xs’éloigne de sa moyenne E(X).

Définition 2.6. La variance de Xest :

X

n∈X(Ω)

(n−E(X))2

on la note V(X).

On appelle écart-type le nombre σ(X) = pV(X).

Remarque : La formule X

n∈X(Ω)

|n−E(X)|aurait été tout aussi plausible pour mesurer l’écart entre Xet sa

moyenne... On utilise cependant plus souvent la variance définie ci-dessus. Un argument est que cette formule

est semblable à celle utilisée en géométrie euclidienne pour ||X−E(X)||2. Et alors on σ(X) = ||X−E(X)||.

On peut écrire :

E(X) = E((X−E(X))2)

d’où :

E(X) = E(X2−2X.E(X) + E(X)2)

4

=E(X2)−2E(X).E(X) + E(X2)linéarité

=E(X2)−E(X)2

Cette dernière formule est souvent plus simple à calculer que celle de la définition.

Remarque : On sait que la variance est positive, donc E(X2)>E(X)2, ce qui n’était pas évident de prime

abord.

Remarque : Si on définit pour tout (X, Y )∈ F(Ω,R)2,X|Y=X

ω∈Ω

X(ω)Y(Ω)P({ω}), on obtient qua-

siment un produit scalaire (seule la séparation n’est pas complètement vraie : on obtient que X|X=

0⇒P(X= 0) = 1 : on dit que Xest presque sûrement nulle).

Et alors V(X) = ||X−E(X)||2, et σ(X) = ||X−E(X)|| : c’est la distance euclidienne entre Xet sa

moyenne.

Pour le lien vis-à-vis des opérations, nous avons facilement la propriété suivante. Par contre, la variance

d’une somme (et pire : d’un produit) n’est pas évidente...

Proposition 2.7. Soit Xune variable aléatoire réelle et (a, b)∈R2. Alors :

V(aX +b) = a2V(X)

et donc :

σ(aX +b) = |a|σ(X).

La formule suivante montre que la variance permet de savoir de combien en moyenne la variable aléatoire

s’éloigne de son espérance :

Proposition 2.8. (Bienaymé-Chebychev)

Soit Xune variable aléatoire réelle et δ∈R+∗. Alors :

P(|X−E(X)|>δ)61

δ2V(X)

Ainsi, plus la variance est petite, et plus la probabilité que Xsoit proche de son espérance est faible.

Remarque : et donc aussi, en passant à l’événement contraire :

P(|X−E(X)|< δ)>1−1

δ2V(X).

qui est souvent ce qui nous intéresse le plus.

Une remarque supplémentaire : cette inégalité est en fait très peu précise...

Démonstration:

Il s’agit de minorer la la variance, i.e. d’obtenir une inégalité de type « V(X)>... ». Nous allons naturellement

découper la somme qui définit la variance en la partie pour laquelle |X−E(X)|>δet la partie pour laquelle

|X−E(X)|< δ.

Par définition :

V(X) = X

n∈X(Ω)

(n−E(x))2.P (X=n)

Mais les éléments n∈X(Ω) se répartissent en deux parties disjointes : ceux pour lesquels |n−E(x)|6δet ceux

pour lesquels |n−E(x)|> δ. En termes précis : X(Ω) = nn∈X(Ω) |n−E(x)|6δotnn∈X(Ω) |n−E(x)|> δo

(union disjointe). On peut donc découper la somme en deux parties :

V(X) = X

n∈X(Ω) tq |n−E(x)|6δ

(n−E(x))2.P (X=n) + X

n∈X(Ω) tq |n−E(x)|>δ

(n−E(x))2.P (X=n)

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

1

/

25

100%