Notes de cours avec exercices corrigés

ii

F. BOYER - VERSION DU 14 OCTOBRE 2014

TABLE DES MATIÈRES iii

Table des matières

I Arithmétique de l’ordinateur. Erreurs numériques. Stabilité 1

1 L’ordinateuretlesnombres.......................................... 1

1.1 Lesentiers .............................................. 1

1.2 Lesréels ............................................... 1

1.3 De l’importance de la précision dans les calculs . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

1.4 Opérationssurlesflottants...................................... 3

2 Analyse de la propagation des erreurs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 5

2.1 Addition ............................................... 5

2.2 Multiplication............................................. 5

2.3 Formulesstablesetinstables..................................... 6

2.4 Evaluationd’unefonction ...................................... 7

2.5 Evaluationd’unpolynôme...................................... 8

3 Sommationdeséries ............................................. 9

3.1 Sommation des séries à termes positifs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

3.2 Théorèmedessériesalternées .................................... 11

II Méthodes itératives de résolution d’équations 13

1 Les théorèmes de base en analyse réelle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

2 Résolution d’une equation f(x) = 0,f:R→R.............................. 14

2.1 Existence et unicité de solutions . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

2.2 Laméthodegraphique ........................................ 14

2.3 La méthode de dichotomie ou de bissection . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

2.4 La méthode de la fausse position : regula falsi ............................ 15

2.5 Méthodesdepointfixe........................................ 16

2.6 MéthodedeNewton ......................................... 21

2.7 Méthode de Newton pour les polynômes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

2.8 Diversexemplesetremarques .................................... 23

3 Résolution de f(x) = 0 en dimension quelconque (finie) . . . . . . . . . . . . . . . . . . . . . . . . . . 24

3.1 Méthodedepoint-fixe ........................................ 24

3.2 MéthodedeNewton-Raphson .................................... 26

III Interpolation / Approximation 29

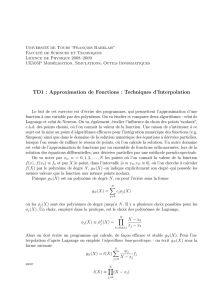

1 InterpolationdeLagrange........................................... 29

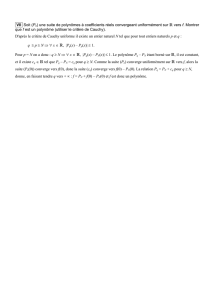

1.1 Existence et unicité du polynôme de Lagrange . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

1.2 CalculdupolynômedeLagrange .................................. 31

1.3 Estimation de l’erreur d’approximation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

1.4 L’opérateur d’interpolation. Choix des points d’interpolation . . . . . . . . . . . . . . . . . . . . 35

2 L’interpolationdeHermite .......................................... 36

3 Interpolation polynômiale par morceaux. Splines cubiques . . . . . . . . . . . . . . . . . . . . . . . . . 39

3.1 Interpolation constante par morceaux . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 40

3.2 Interpolation affine par morceaux . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 40

3.3 Lessplinescubiques ......................................... 40

4 Approximationpolynômiale ......................................... 44

4.1 Les fonctions développables en séries entières . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

4.2 Théorème de Weierstrass. Polynômes de Bernstein . . . . . . . . . . . . . . . . . . . . . . . . . 44

4.3 Le problème de la meilleure approximation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 48

4.4 Meilleure approximation L2au sens discret. Moindres carrés . . . . . . . . . . . . . . . . . . . . 55

5 Complémentsetremarques.......................................... 57

F. BOYER - VERSION DU 14 OCTOBRE 2014

iv TABLE DES MATIÈRES

IV Intégration numérique 59

1 Méthodes de quadrature élémentaires . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

1.1 Généralités .............................................. 59

1.2 Rectanglesàgaucheetàdroite.................................... 60

1.3 FormulesdeNewton-Cotes...................................... 61

1.4 FormulesdeGauss.......................................... 61

2 Formulescomposites ............................................. 63

2.1 Généralités .............................................. 63

2.2 Exemples............................................... 65

2.3 Cas particulier des fonctions périodiques ou à support compact dans ]a, b[. Formule d’Euler-

MacLaurin .............................................. 67

3 Quelques commentaires et compléments . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 69

3.1 Sur le calcul des points et des poids des méthodes de Gauss . . . . . . . . . . . . . . . . . . . . 69

3.2 Calcul approché d’intégrales généralisées . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

3.3 Intégrales2D/3D........................................... 71

V Exercices 73

Bibliographie 107

F. BOYER - VERSION DU 14 OCTOBRE 2014

TABLE DES MATIÈRES v

Avant-Propos

Ce document a pour vocation de rassembler les éléments d’analyse numérique qui peuvent être utiles pour préparer

les oraux de l’agrégation externe de Mathématiques. Les étudiants préparant l’option B sont les premiers concernés mais

pas seulement. Un certain nombre de chapitres font partie intégrante du programme général du concours et font l’objet de

leçons. Par ailleurs, les éléments contenus dans ces notes fournissent de nombreux exemples et potentiels développements

pour enrichir vos leçons (d’analyse ET d’algèbre).

Le premier chapitre est purement indicatif pour vous sensibiliser aux problèmes naturellement liés à toute méthode de

calcul sur un ordinateur en précision finie (arithmétique flottante).

Le chapitre 2 traite des méthodes de résolution d’équations non-linéaires du type f(x) = 0.

Les chapitres 3 et 4 traitent des problèmes de l’interpolation et de l’approximation polynomiale et de l’intégration

numérique.

N’hésitez surtout pas à me transmettre des commentaires, des questions ou la liste de toutes les coquilles, erreurs qui

émaillent certainement ce texte.

Les points fondamentaux à retenir

Points-fixes, résolution d’équations

– Bien maîtriser les résultats de L1/L2 en analyse réelle (Rolle, TVI, accroissements finis, formules de Taylor, ...)

– Connaitre (principe, mise en oeuvre, convergence) la méthode de dichotomie.

– Connaitre les conditions de convergence d’une suite définie par xn+1 =g(xn)vers un point fixe de g: Théorèmes

II.2.12 en dimension 1 et II.3.20 en dimension quelconque.

– Comprendre pourquoi le rayon spectral est le bon outil en dimension d > 1(i.e. la discussion de la section 3.1).

– Connaître les exemples de méthodes itératives pour résoudre un système linéaire construites à partir de cette idée

(Jacobi, Gauss-Seidel).

– Connaître la construction de la méthode de Newton (plutôt que de retenir par coeur la formule ...) et savoir que

la convergence locale quadratique est garantie dès lors que la racine cherchée est simple (Théorèmes II.2.14 en

dimension 1 et II.3.21 en dimension quelconque ainsi que son corollaire).

Bien comprendre que “racine simple” en dimension d > 1signifie que la différentielle de la fonction au point

considéré est inversible (et non pas : “est non nulle” ! !).

– Savoir que si la racine est multiple, tout peut arriver. La méthode peut diverger ou même converger mais pas de

façon quadratrique (exemple stupide : résoudre xm= 0 par Newton).

Interpolation/approximation

– Connaître le théorème d’existence et unicité du polynôme d’interpolation de Lagrange et savoir le calculer par les

deux méthodes (basique = Vandermonde, sophisitiquée = différences divisées).

– Connaitre le théorème d’estimation de l’erreur (Théorème III.1.9) et savoir le démontrer au moins pour n= 1,2ou

3par exemple.

– Connaître le théorème de Weiestrass (ou Stone-Weierstrass pour les plus courageux) et sa preuve par les polynômes

de Bernstein (au moins savoir qu’elle existe et connaitre un bouquin ou on peut la trouver).

– Savoir démontrer l’existence d’un polynôme de meilleure approximation. Svoir montrer l’unicité dans le cas de la

norme L2.

– Connaitre l’existence des polynômes orthogonaux et savoir montrer qu’il existe une relation de réccurence à deux

termes de la forme Pn+1 = (x−an)Pn−bnPn−1.

– Savoir utiliser la théorie usuelle des bases Hilbertiennes dans ce contexte (Théorème III.4.42 au moins pour des

poids réguliers et bornés auquel cas la difficile Proposition III.4.43 est inutile).

F. BOYER - VERSION DU 14 OCTOBRE 2014

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

1

/

115

100%