Variables aléatoires réelles

Chapitre 19

Variables aléatoires réelles

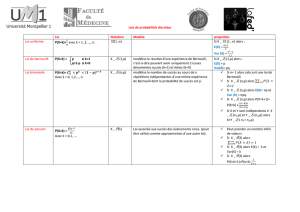

– Connaître les définitions, et savoir les utiliser, en particulier les notions de

variables aléatoires, univers images, loi de probabilité, système complet d’évé-

nements associé à une variable aléatoire, fonction de répartition,

– Connaître les lois usuelles, leur espérance et leur variance,

– La notion d’espérance et le théorème de transfert,

– la notion de moment et de variance,

– L’inégalité de Bienaymé-Tchebychev.

CC

BY:

$

\

=

I Introduction

I.1 Variables aléatoires

Une variable aléatoire modélise le gain d’une expérience aléatoire, c’est-à-dire qu’à chaque résultat

possible de l’expérience aléatoire, on asssocie un nombre.

Définition 1. Soit (Ω, P (Ω), p)un espace probabilisé. On appelle variable aléatoire réelle (VAR)

Xune fonction définie sur l’univers Ωet à valeurs dans R. L’ensemble des valeurs possibles de X

c’est-à-dire l’ensemble image X(Ω) est appellé univers image de la variable aléatoire X.

Lorsqu’on a une variable aléatoire X, et Bune partie de R, on peut calculer la probabilité Xsoit

dans B. Par exemple, Bpeut être un intervalle, ou juste un singleton. On considère alors l’événement :

X−1(B) = nw∈ΩX(w)∈Bo⊂Ω

C’est donc l’événement « le gain Xest dans l’ensemble B».

En général, on utilise la notation X∈B, pour désigner l’événement X−1(B). De même, on notera

les événements : X=a,X6a, etc qui désignent respectivement « le gain vaut a», « le gain est

inférieur ou égal à a, etc.

En particulier, on a p(X∈B), est la probabilité de l’événement « le gain Xest dans l’ensemble

B». De la même manière, on note p(X=a), p(X > a), p(X>B), p(a < X 6B).

On gardera en tête qu’on mesure des ensembles de Ω.

1

CHAPITRE 19. VARIABLES ALÉATOIRES RÉELLES 2

Exemple: Soit l’expérience aléatoire de lancer deux dés. L’univers est alors Ω = [[1,6]]2. On

considère la variable aléatoire Xqui a un résultat associe la somme.

X:([[1,6]]2→R

(i, j)7→ i+j

L’univers images est alors [[2,12]], c’est l’ensemble des sommes possibles. On peut calculer les valeurs

des événements X= 7, X > 9 etc. en utilisant la probabilité uniforme sur Ω.

Remarque:

– Lorsque l’on manipule des variables aléatoires, il est important de se demander quel est l’univers

image X(Ω).

– Il arrive parfois que l’on « ajoute » artificiellement des valeurs dans X(Ω) qui sont de proba-

bilités nulles de manière à avoir un univers image plus simple à exprimer (exemple d’une loi

hypergéométrique).

I.2 Loi de probabilité d’une variable aléatoire

Définition 2. Soit Xune variable aléatoire, on appelle loi de probabilité de X, l’application

fX:(X(Ω) →[0,1]

x7→ p(X=x).

Exemple: Toujours dans le cas de la somme de deux dés, on a :

–fX(2) = 1

36 , car c’est la pobabilité du couple (1,1),

–fX(3) = 2

36 , car c’est la probabilité des couples (1,2) et (2,1),

–fX(4) = 3

36 , car c’est la probabilité des couples (1,3), (2,2) et (3,1).etc..

On représente souvent la loi sous forme d’histogramme.

0.00

0.02

0.04

0.06

0.08

0.10

0.12

0.14

0.16

0.18

2 3 4 5 6 7 8 9 10 11 12

Figure 19.1 – histogramme associé à une somme de deux dés

CHAPITRE 19. VARIABLES ALÉATOIRES RÉELLES 3

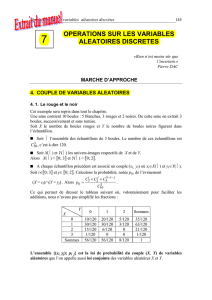

I.3 Système complet associé à une variable aléatoire

Soit Xune variable aléatoire sur un univers fini Ω, alors X: Ω →X(Ω) (application surjective

dans ce cas) , donc on a card(Ω) >card(X(Ω)). En particulier X(Ω) est fini. Cette remarque permet

de définir :

Proposition 1. Soit une variable aléatoire Xsur un univers fini Ω, on pose X(Ω) = {x1,...,xn}.

Alors les ensembles (X=xk)k=1...n sont un système complet d’événements de Ω:

Ω =

n

[

k=1

(X=xk)

Il s’agit du système complet d’événement associé à la variable aléatoire X.

Ce système complet est intéressant car il découpe l’univers Ω en région où Xest constante. En

fait il découpe Ω selon la valeur de X.

Démonstration. On a clairement (X=xi)∩(X=xj) = ∅, car une éventualité de (X=xi)∩(X=xj)

vérifieraient à la fois X(w) = xiet X(w) = xj. D’un autre côté, soit wun élément de Ω (i.e. une

éventualité) alors, X(w) est l’un des xk, en choisissant pour valeur de kcelle telle X(w) = xk, on a

bien x∈(X=xk).

En conséquence importante, on a :

Proposition 2. Pour toute VAR, on a la relation :

X

x∈X(Ω)

p(X=x) =

xn

X

k=1

p(X=xk) =

xn

X

k=1

fX(xk) = 1,

ce qui signifie que la somme des hauteurs d’un histogramme d’une VAR fait 1.

Démonstration. La démonstration est évidente en utilisant le système complet d’événement associé à

X: on a p(Ω) = X

x∈X(Ω)

p(X=x).

Cette relation est particulièrement utile dans le cas où la loi de la VAR Xdépend d’un paramètre,

l’équation obtenue permet alors de déterminer le paramètre.

I.4 Fonction de répartition

Définition 3. Soit Xune variable aléatoire sur Ω, on appelle fonction de répartition la fonction

FXde Rdans [0,1], définie par FX(x) = p(X6x).

Exemple: La somme de deux dés.

Déjà il est clair que FXest croissante (au sens large), car : si x6x′, on a clairement que

l’événement X6xest inclus dans X6x′donc FX(x)6FX(x′). En fait, on montre qu’elle est

constante par morceaux avec des saut égaux à p(X=xk) au points xk.

CHAPITRE 19. VARIABLES ALÉATOIRES RÉELLES 4

Proposition 3. Si on note de la même manière que précédemment : X(Ω) = {x1,...,xn}, en or-

donnant les xipar ordre croissant, i.e. x1< x2<···< xn.

On a alors :

FX(x) =

0si x < x1

i

X

k=1

p(X=xi)si x∈[xi, xi+1[

1si x>xn.

Démonstration. En effet, si x < x1il est clair que l’événement X < x est impossible, de même,

x>xn, l’événement X < x est certain. si x∈[xi, xi+1[, alors l’événement X6x, se découpe selon :

p(X6x) =

n

X

k=1

p(X6x)∩(X=xk)=

i

X

k=1

p(X=xk).

La démonstration montre l’importance du SCE associé à X.

En conséquence importante, on a :

– la loi de fXdéfinit la fonction de répartition FX,

– la fonction de répartition FXdéfinit la loi de fX.

En effet, on a :

fx(x1) = P(X=x1) = FX(x1),∀i∈[[2, n]] , fX(xi) = P(X=xi) = FX(xi)−FX(xi−1).

Ce qui permet de retrouver la fonction fXà partir de FX.

Proposition 4. On a pour tout réel a, b, avec a < b, la propriété : p(a < X 6b) = FX(b)−FX(a).

Démonstration. On a :

(X6b) = (a < X 6b)∪(X6a) union disjointe.

Ainsi : FX(b) = p(a < X 6b) + FX(a).

Remarque: Les fonctions de répartition sont particulièrement utile dans le cadre de loi du

maximum : on calcule la fonction répartition, on en déduit la loi.

Exemple: Maximum de deux dés.

Remarque: Pour un minimum on utilise p(X6k).

⋆Conséquence algorithmique : simulation d’une VAR sur un ensemble fini.

À écrire.

Application 1 Un joueur lance deux pièces non truquées, il gagne un euro par pile et perd deux

euros par face. On note Xle gain. Déterminer X(Ω), la loi de probabilité de Xet la fonction de

répartition FX.

CHAPITRE 19. VARIABLES ALÉATOIRES RÉELLES 5

II Espérance, variance moment

II.1 Espérance mathématique

L’espérance est une mesure de la « valeur moyenne » d’une variable aléatoire, les valeurs sont

pondérés par leur poids, i.e. leur probabilité.

Définition 4. Soit Xune variable aléatoire sur un espace probabilisé fini Ω, on appelle espérance

mathématiques de la v.a.r X, le nombre noté E(X), défini par :

E(X) =

n

X

i=1

xip(X=xi) = X

x∈X(Ω)

xp(X=x).

où X(Ω) = (xi)i=1...n. On dit que la var Xest centrée si E(X) = 0.

Note: Dans le cas (en deuxième année), où Ω n’est pas fini, il faudra remplacer la somme par une intégrale,

il faut vérifier que l’intégrale converge, donc toutes les var n’ont pas d’espérance. Dans le cas de la première

année, cette définition ne pose pas de difficultés : toutes les VAR considérées en première année admettent une

espérance.

On appelle cela espérance, car si Xreprésente le gain, alors l’espérance représente le gain moyen.

On dit ainsi qu’un jeu est équilibré si la variable aléatoire du gain est centrée.

Exemple: Pour le lancer de deux dés, et la var Xqui représente la somme des deux dés vérifie :

E(X) = 2×1

36 +3×2

364×3

36 +5×4

36 +6×5

36 +7×6

36 +8×5

36 +9×4

36 +10×3

36 +11×2

36 +12×1

36 = 7.

On peut aussi déterminer si un jeu est équitable.

Exemple: Un joueur lance 2 dés, si il sort 7, il touche 5 euros, sinon il perd un euro. La variable

aléatoire associe alors à un couple (i, j) la valeur 5 si i+j= 5, et la valeur -1 sinon. on espérance

est :

E(X) = 5 ×6

36 −130

36 = 0.

Ainsi, le jeu est équilibré.

Exemple: À la roulette, on gagne deux fois la mise si on choisit la bonne couleur, sachant qu’il

y a 18 rouges, 18 noirs et le vert (qu’on ne peut pas choisir). L’espérance est alors :

E(X) = 2 ×18

37 −1 = −1

37.

Puisque la mise est perdu de toute manière. Ainsi, le jeu est perdant.

Proposition 5. Soient Xet Ydes var, on a alors :

– Si X>0, c’est-à-dire : ∀ω∈Ω, X(ω)>0, alors E(X)>0.

– Si X>a(même sens), alors E(X)>a.

– Si X>Y(même sens), alors E(X)>E(Y).

– On peut généraliser aussi au cas où X>Y, sauf pour {ω1,...,ωn} ∈ Ω, avec ∀i∈[[1, n]] , p(ωi) =

0.

Application 1 Démontrer ces relations

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

1

/

46

100%