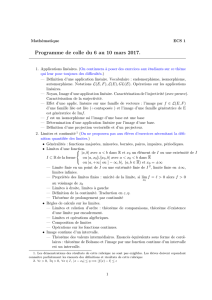

Convergences et approximations I Loi faible des grands nombres

(Ω,T, P )

X: Ω −→ R

∀ε > 0, P |X−E(X)|>ε6

X X µ

X

X(Ω) = {xi∈R|i∈N} ∀i∈N, pi=P([X=xi])

V(X) = E(X−µ)2=

+∞

X

i=0

pi(xi−µ)2µ=E(X)

ε > 0

P(|X−µ|>ε) = X

j∈J

pjJ={j∈I| |xj−µ|>ε}

V(X) = X

j∈J

pj(xj−µ)2+X

i/∈J

pi(xi−µ)2

V(X)>X

j∈J

pj(xj−µ)2∀j∈J, |xj−µ|2>ε2

V(X)>ε2X

j∈J

pj

V(X)>ε2P(|X−µ|>ε)

P(|X−E(X)|>ε)6V(X)

ε2

X

V(X) = Z+∞

−∞

(t−µ)2f(t)t

6

6

7

7

1

/

7

100%