TD Régression: Analyse Bivariée - Master 2 Ingénierie Mathématique

Telechargé par

Lahouel Noureddine

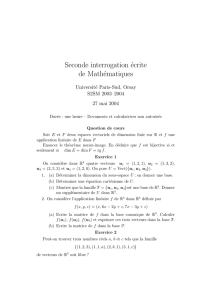

Universit´e de Nantes – UFR des Sciences et Techniques

D´epartement de Math´ematiques

Master 2 Ing´enierie math´ematique 2015-2016

TD de R´egression

Analyse bivari´ee

Ex 1. Lien entre 2 variables quantitatives : le coefficient de corr´elation lin´eaire

On consid`ere deux ´echantillons de nvariables (X1, . . . , Xn) et (Y1, . . . , Yn).

On rappelle les r´esultats suivants :

– la densit´e d’une loi de Student `a kdegr´es de libert´e T(k) vaut

f(x) = 1

√kπ

Γ(k+1

2)

Γ(k

2)1 + x2

k−k+1

2

, x ∈R.

– La fonction bˆeta B(x, y) est d´efinie pour tous x, y par B(x, y) = R1

0tx−1(1 −t)y−1dt.

On a B(x, y) = B(y, x) et B(x, y + 1) = y

x+yB(x, y).

1) Rappeler la d´efinition de la corr´elation lin´eaire empirique Rentre les deux ´echan-

tillons pr´ec´edents.

On suppose dans la suite de l’exercice que les couples (Xi, Yi), i= 1, . . . , n, sont i.i.d

suivant une loi normale, et on note ρla corr´elation th´eorique entre X1et Y1. On admet

que dans ce cas, et sous l’hypoth`ese H0:ρ= 0, √n−2R/√1−R2∼T(n−2).

2) En d´eduire que sous H0la densit´e de Rest f(r) = B(1

2,n−2

2)−1(1 −r2)n−4

2,r∈

[−1,1].

3) Montrer que sous H0,E(R) = 0 et V(R) = 1/(n−1).

4) En admettant que pour nsuffisamment grand, la loi de R peut ˆetre approch´ee

par une loi gaussienne, en d´eduire une r´egion critique pour tester H0:ρ= 0 au niveau

α∈]0,1[.

Ex 2. Lien entre 2 variables quantitatives : le coefficient de corr´elation de Spearman

On consid`ere deux ´echantillons de nvariables (X1, . . . , Xn) et (Y1, . . . , Yn). On note

(r1, . . . , rn) (resp. (s1, . . . , sn)) les rangs des variables Xi(resp. Yi) dans chaque ´echan-

tillon. On suppose qu’il n’y a pas d’ex-aeaquo, de telle sorte que les rangs vont de 1 `a n.

On rappelle que la corr´elation de Spearman RSentre les ´echantillons (X1, . . . , Xn) et

(Y1, . . . , Yn) correspond `a la corr´elation lin´eaire entre leurs rangs.

1) Donner la formule d´efinissant RS.

2) Montrer que la moyenne empirique de l’´echantillon (r1, . . . , rn) vaut (n+ 1)/2 et

que sa variance empirique vaut (n2−1)/12.

3) En d´eduire que RS=n−1Pn

i=1 risi−(n+1)2/4

(n2−1)/12 .

4) Soit di=ri−si. Montrer que Pn

i=1 risi=n(n+ 1)(2n+ 1)/6−1/2Pn

i=1 d2

i.

5) En d´eduire que

RS= 1 −6Pn

i=1 d2

i

n(n2−1).

Ex 3. Lien variable quantitative/variable qualitative : comparaison de kmoyennes

On consid`ere un ´echantillon de nvariables ind´ependantes (X1, . . . , Xn). On suppose que

cet ´echantillon est compos´e de ksous-populations (correspondant aux kclasses d’un fac-

teur).

Pour tout i= 1, . . . , k, on note nile nombre d’individus dans la sous-population i, et

(Xi

1, . . . , Xi

ni) les ´el´ements de (X1, . . . , Xn) associ´es `a la population i. Ainsi n=Pk

i=1 ni

et (X1, . . . , Xn) = ∪n

i=1(Xi

1, . . . , Xi

ni).

On suppose que pour i= 1, . . . , k, les variables(Xi

1, . . . , Xi

ni) sont identiquement distri-

bu´ees selon une loi normale d’esp´erance µiet de variance σ2inconnues (on suppose donc

que la variance est la mˆeme quelle que soit la sous-population i).

1) Pour k= 2, proposer une proc´edure pour tester H0:µ1=µ2contre H1:µ16=µ2

au niveau α∈]0,1[.

On suppose `a pr´esent kquelconque et on pourra utiliser le r´esultat suivant.

Rappel :

– Si Y1∼χ2(p),Y2∼χ2(q), et Y1et Y2sont ind´ependantes, alors Y1+Y2∼χ2(p+q)

– R´eciproquement, si Y=Y1+Y2et Y∼χ2(r),Y1∼χ2(p),p<r, alors Y2est

ind´ependante de Y1et Y2∼χ2(r−p).

2) Montrer que

S2

T=S2

inter +S2

intra,

o`u S2

T=1

nPn

l=1(Xl−X)2repr´esente la variance totale de l’´echantillon ;

S2

inter =1

nPk

i=1 ni(Xi−X)2la variance interclasses (entre les sous-populations) ;

S2

intra =1

nPk

i=1 niS2

i, o`u S2

i=1

niPni

j=1(Xi

j−Xi)2, la variance intraclasses (moyenne des

variances dans chaque sous-population).

3) Quelle est la loi de niS2

i/σ2? En d´eduire que nS2

intra/σ2∼χ2(n−k).

4) Sous l’hypoth`ese H0:µ1=··· =µk, quelle est la loi de nS2

T/σ2? En d´eduire la

loi de nS2

inter/σ2sous H0.

5) En d´eduire la loi de S2

inter /(k−1)

S2

intra /(n−k)sous H0et une r´egion critique pour tester H0au

niveau α∈]0,1[. Comparer avec la premi`ere question pour k= 2.

Pour quantifier le lien entre une variable quantitative Xet une variable qualitative Q

`a kmodalit´es, on calcule parfois ˆη2=S2

inter

S2

T, qui estime η2=V(E(X|Q))/V (X).

6) Montrer que 0 ≤η2≤1 et que 0 ≤ˆη2≤1. A quoi correspond les cas η2= 0 et

η2= 1 ? Formuler l’hypoth`ese H0ci-dessus en fonction de η2et exprimer la r´egion critique

du test en fonction de ˆη2.

Ex 4. Lien entre 2 variables qualitatives

On consid`ere deux variables qualitatives Q1et Q2ayant respectivement Iet Jmodalit´es.

On rel`eve sur un ´echantillon de nindividus le nombre d’individus appartenant `a chacune

des modalit´es crois´ees de (Q1, Q2), ce que l’on r´esume dans un tableau de contingence.

Comment tester l’ind´ependance de Q1et Q2`a l’aide de ce tableau au niveau α∈]0,1[ ?

2

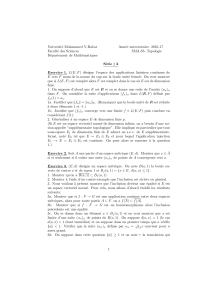

Universit´e de Nantes – UFR des Sciences et Techniques

D´epartement de Math´ematiques

Master 2 Ing´enierie math´ematique 2015-2016

TD de R´egression

Ex 5. Moyenne empirique

Soit z1, ..., zndes observations d’une variable Z.

1) D´eterminer la valeur de ˆmqui minimise la distance quadratique S(m) = Pn

i=1(zi−

m)2.

2) La quantit´e ˆmcorrespond `a l’estimation par moindres carr´es ordinaires dans un

mod`ele de r´egression lin´eaire : Y=Xβ +. Pr´eciser ce que valent Y,X,βet .

3) Retrouver le r´esultat de la premi`ere question `a partir de la formule g´en´erale de

l’estimateur des moindres carr´es : ˆ

β= [X0X]−1X0Y.

Ex 6. Reconnaˆıtre un mod`ele de r´egression lin´eaire

Les mod`eles suivants sont-ils des mod`eles de r´egression lin´eaire ? Si non, peut-on appliquer

une transformation pour s’y ramener ? Pour chaque mod`ele de r´egression lin´eaire du type

Y=Xβ +, on pr´ecisera ce que valent Y,X,βet .

1) On observe (xi, yi), i = 1, ..., n li´es th´eoriquement par la relation yi=a0+a1xi+

i, i = 1, ..., n. o`u les variables isont centr´ees, de variance σ2et non-corr´el´ees. On d´esire

estimer a0et a1.

2) On observe (xi, yi), i = 1, ..., n li´es th´eoriquement par la relation yi=a1xi+a2x2

i+

i, i = 1, ..., n. o`u les variables isont centr´ees, de variance σ2et non-corr´el´ees. On d´esire

estimer a1et a2.

3) On rel`eve pour diff´erents pays (i= 1, ..., n) leur production Pi, leur capital Ki,

leur facteur travail Tiqui sont th´eoriquement li´ees par la relation de Cobb-Douglas P=

α1Kα2Tα3. On d´esire v´erifier cette relation et estimer α1,α2et α3.

4) Le taux de produit actif ydans un m´edicament est suppos´e ´evoluer au cours du

temps tselon la relation y=β1e−β2t. On dispose des mesures de ntaux yieffectu´es `a n

instants ti. On d´esire v´erifier cette relation et estimer β1et β2.

5) Mˆeme probl`eme que pr´ecedemment mais le mod`ele th´eorique entre les observations

s’´ecrit yi=β1e−β2ti+ui,i= 1, . . . , n, o`u les variables uisont centr´ees, de variance σ2et

non-corr´el´ees.

Ex 7. R´egression simple

On consid`ere le mod`ele de r´egression lin´eaire simple o`u l’on observe nr´ealisations (xi, yi), i =

1, ..., n d’un couple de variables al´eatoires li´ees par la relation

yi=β0+β1xi+i, i = 1, ..., n.

On suppose les variables icentr´ees, de variance σ2et non-corr´el´ees.

1) Ecrire le mod`ele sous forme matricielle.

2) De quel probl`eme de minimisation l’estimateur des moindres carr´es ˆ

β= ( ˆ

β0,ˆ

β1)

est-il la solution ?

3) Calculer ˆ

βen r´esolvant directement le probl`eme de minimisation pr´ec´edent et

v´erifier la formule ˆ

β= [X0X]−1X0y.

4) Calculer var( ˆ

β) en utilisant la formule pr´ec´edente et en d´eduire var( ˆ

β0), var( ˆ

β1)

et cov( ˆ

β0,ˆ

β1).

5) Montrer que la moyenne empirique des r´esidus ˆiest nulle.

6) Calculer la matrice de variance-covariance du vecteur de r´esidus ˆet du vecteur

des valeurs estim´ees ˆy.

Ex 8. R´egression simple avec bruit gaussien

On se place dans le mˆeme mod`ele que pour l’exercice pr´ec´edent, mais on suppose main-

tenant que les isont iid de loi normale N(0, σ2) o`u σ2est inconnue.

1) Quelle est la vraisemblance de l’´echantillon (y1, . . . , yn) ?

2) Calculer les estimateurs du maximum de vraisemblance de β0, β1et σ2. Comparer

ces estimateurs avec les estimateurs des moindres carr´es.

3) Dans cette question, on suppose pour simplifier que β0et σ2sont connus. Montrer

que l’estimateur de β1pr´ec´edent est efficace.

4) D´eterminer la loi des estimateurs ˆ

β0,ˆ

β1.

5) Justifier l’´ecriture : ˆσ2=1

nk(I−X[X0X]−1X0)k2. En d´eduire la loi de ˆσ2.

6) En d´eduire des intervalles de confiance pour β0et β1de niveau α∈]0; 1[.

7) On observe un nouveau point xn+1 et on cherche `a pr´edire la valeur yn+1 =

β0+β1xn+1 +n+1. Donner la loi de l’erreur de pr´ediction e=yn+1 −ˆyn+1 bas´ee sur le

mod`ele de r´egression. En d´eduire un intervalle de confiance pour yn+1.

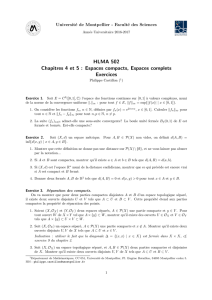

Ex 9. Convergence des estimateurs

On sait que si X=1,...,1

x1, . . . , xn0

, alors en notant xn=n−1Pn

i=1 xi,

(X0X)−1=1

Pn

i=1(xi−xn)21

nPn

i=1 x2

i−xn

−xn1

1) On a observ´e un ´echantillon i.i.d de couples (xi, yi), i= 1, . . . , n. On suppose le

lien suivant : yi=β0+β1xi+i, o`u les variables isont i.i.d, centr´ees, de variance σ2. Les

r´egresseurs xisont suppos´es ici al´eatoires et de carr´e int´egrable. On note = (1, . . . , n)0,

β= (β0, β1)0et ˆ

βl’estimateur de βpar MCO. On suppose que Xet sont ind´ependants.

a) Exprimer ˆ

β−βen fonction des vecteurs Xet .

b) En d´eduire que ˆ

βconverge presque sˆurement vers βlorsque n→ ∞.

2) Lors d’une exp´erience chimique, on observe la teneur d’un certain produit `a dif-

f´erents instants r´eguliers allant de 1 `a n. Le r´esultat `a l’instant iest not´e yi. On suppose

le lien temporel suivant : yi=β0+β1i+i,i= 1, . . . , n, o`u les variables irepr´esentent

les erreurs de mesures. Elles sont suppos´ees al´eatoires, centr´ees, de variance σ2et non

corr´el´ees. Soit ˆ

βl’estimateur de βpar MCO.

a) Calculer V ar(ˆ

β) et donner sa limite lorsque n→ ∞.

b) En d´eduire le comportement asymptotique en moyenne quadratique de ˆ

β0et ˆ

β1.

4

3) On se place sous les mˆemes hypoth`eses que la question pr´ec´edente mais on suppose

cette fois-ci que le lien temporel est : yi=β0+β1/i +i,i= 1, . . . , n.

a) Calculer V ar(ˆ

β) et donner sa limite lorsque n→ ∞.

b) En d´eduire le comportement asymptotique en moyenne quadratique de ˆ

β0et ˆ

β1.

Ex 10.

Nous souhaitons exprimer la hauteur yd’un arbre en fonction de son diam`etre x`a 1m30 du

sol. Pour cela, nous avons mesur´e 20 couples diam`etre-hauteur et les r´esultats ci-dessous

sont disponibles :

x= 34.9, y = 18.34,1

20

20

X

i=1

(xi−x)2= 28.29,

1

20

20

X

i=1

(yi−y)2= 2.85,1

20

20

X

i=1

(xi−x)(yi−y)=6.26

1) On note ˆy=ˆ

β0+Xˆ

βl’estimation de la droite de r´egression. Donner l’expression

de ˆ

β0et ˆ

β1en fonction des statistiques ´el´ementaires ci-dessus. Calculer ˆ

β0et ˆ

β1.

2) Donner une mesure de qualit´e d’ajustement des donn´ees au mod`ele. Exprimer

cette mesure `a l’aide des statistiques ´el´ementaires. Calculer et commenter.

3) Tester H0:βj= 0 contre H1:βj6= 0 pour j= 0,1. Commenter.

Ex 11. Th´eor`eme de Gauss-Markov

On consid`ere un mod`ele de r´egression lin´eaire multiple

y=Xβ +,

o`u β∈Rk,Xest une matrice de taille n×ket est un vecteur al´eatoire de taille n,

centr´e et de matrice de covariance σ2I(Iest la matrice identit´e). On veut montrer que

l’estimateur des moindres carr´es ˆ

βest l’estimateur lin´eaire sans biais de variance minimale,

c’est-`a-dire, pour tout estimateur lin´eaire sans biais ˜

β, var( ˜

β)−var( ˆ

β) est semi d´efinie

positive.

1) On pose ˜

β=My o`u Mest une matrice de taille k×n. Montrer que si ˜

βest sans

biais, alors XM =I.

2) Montrer que ˆ

βet ( ˜

β−ˆ

β) sont non-corr´el´es.

3) Calculer la variance de ˜

βen ´ecrivant ˜

β=ˆ

β+ ( ˜

β−ˆ

β). Conclure.

Ex 12. Estimateur de la variance r´esiduelle

On se place dans le mˆeme cadre que dans l’exercice pr´ec´edent. On cherche `a montrer que

l’estimateur de σ2

ˆσ2=1

n−kky−Xˆ

βk2

est sans biais.

1) Montrer que (n−k)ˆσ2= Tr(0(I−ΠX)) o`u Tr d´esigne la trace et ΠX=

X[X0X]−1X0est la matrice de projection orthogonale sur l’espace engendr´e par les co-

lonnes de X.

2) En utilisant la lin´earit´e de la trace et le fait que Tr(AB) = Tr(BA), montrer que

(n−k)E(ˆσ2) = Tr(E((I−ΠX)0)).

3) Conclure.

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%