2.5 Notion de mesure invariante 2.6 Notion de mesure réversible

PROCESSUS ALÉATOIRES - CHAÎNES DE MARKOV

Cours 4

2.5 Notion de mesure invariante

Nous avons déjà observé que dans certain cas, une chaîne de Markov pouvait se stabiliser i.e.

qu’après un assez grand nombre de transitions, la probabilité d’être dans un état donné devenait

constante. On donne la définition suivante :

Définition 10 – Soit une chaîne de Markov homogène sur un espace d’états fini, de matrice de

transition P. On appelle mesure invariante (ou probabilité invariante) pour cette chaîne, toute

mesure πtelle que :

∀i,X

i

πiPi,j=πj

Proposition 10 – Si πest une mesure invariante pour la chaîne de Markov homogène ©Xn,n>0ª

et si la loi de X0vaut π, alors la loi de Xnest égale à π, quelque soit l’instant n.

Preuve : P(X1=i)=X

j

P(X1=i|X0=j)P(X0=j). Si P(X0=j)=πj, le terme de droite est égal

àX

j

πjPj,i. Mais si la mesure est invariante, on a : X

j

πjPj,i=πidonc P(X1=i)=πi.

Par récurrence, on obtient : P(Xn=i)=πi,∀n.

2.6 Notion de mesure réversible

Définition 11 – Soit une chaîne de Markov homogène sur un espace d’états fini, de matrice de

transition P. On appelle mesure réversible (ou probabilité réversible) pour cette chaîne, toute

mesure πtelle que :

∀i,j,πiPi,j=πjPj,i.

Etant en i, la probabilité d’aller en jest la même que la probabilité d’aller de ivers jalors que

l’on était en i.

Proposition 11 – Toute mesure réversible est invariante.

Preuve : Si πest réversible, πiPi,j=πjPj,idonc X

i

πiPi,j=X

i

πjPj,i=πjX

i

Pj,i=πj

19

L3 MIS

2.7 Comportement asymptotique d’une chaîne de Markov

Théorème 2 – Soit une chaîne de Markov récurrente, apériodique et irréductible. Alors :

(i)

lim

n→∞ p(n)

ii =1

P∞

n=0n f (n)

ii

.

(ii)

lim

n→∞ p(n)

ji =lim

n→∞ p(n)

ii .

Ainsi donc, si la chaîne est récurrente, apériodique et irréductible, après un nombre suffisamment

de transitions, les probabilités d’atteindre l’état ipartant de n’importe quel état j, sont identiques.

Après un certain nombre de transitions, les probabilités que la chaîne soit dans les différents états

sont constantes.

La preuve du point (i) dépasse le cadre de ce cours. Nous allons prouver le point (ii).

On veut montrer que :

lim

n→+∞ p(n)

ji =lim

n→+∞ p(n)

ii .

On sait d’après la proposition (5) que : p(n)

ji =Pn

k=1f(k)

ji p(n−k)

ii , pour tout n>1.

On va donc s’intéresser à :

lim

n→+∞

n

X

k=1

f(k)

ji p(n−k)

ii .

Pour calculer cette limite, on va utiliser le résultat d’analyse suivant :

Théorème 3 – Soit yn=

n

X

k=0

an−kxkavec am>0,

+∞

X

m=0

am=1et lim

n→+∞ xn=c.

Alors lim

n→+∞ yn=c.

Preuve : Il s’agit de prouver que : lim

n→+∞ yn=ci.e. que :

∀ε>0,∃N(ε) tel que ∀n>N(ε),|yn−c| < ε.

On remarque que :

yn−c=

n

X

k=0

an−kxk−c

+∞

X

m=0

am=

n

X

k=0

an−k(xk−c)−c

+∞

X

m=n+1

am.

On a : lim

k→+∞ xk=cdonc ∀ξ>0,∃K(ξ) tel que ∀n>K(ξ),|xk−c| < ξ.

On décompose alors : yn−cen

K(ξ)

X

k=0

an−k(xk−c)+

n

X

k=K(ξ)

an−k(xk−c)−c

+∞

X

m=n+1

am.

20

PROCESSUS ALÉATOIRES - CHAÎNES DE MARKOV

On pose M=max

k>0|xk−c|et on prend ξ=ε/3.

On peut alors écrire :

|yn−c|6M

K(ξ)

X

k=0

an−k+ε

3

n

X

k=K(ξ)+1

an−k+ |c|

+∞

X

m=n+1

am.

La série de terme amconverge vers 1 donc n

X

k=K(ξ)+1

an−k<1 .

De plus, on peut toujours choisir un N(ε) tel que |c|

+∞

X

m=n+1

am<ε/3 et tel que :

K(ξ)

X

k=0

an−k=an+an−1+ · · · + an−K(ξ)=

n

X

k=n−K(ξ)

ak<ε/3M,pour tout n>N(ε).

On a alors

|yn−c| < ε

3+ε

3+ε

3=ε,pour tout n>N(ε),

Ce qui prouve le résultat.

En appliquant le résultat avec yn=p(n)

ji ,an=f(n)

i j et xn=p(n)

ii , on a :

lim

n→+∞ p(n)

ji =lim

n→+∞ p(n)

ii .

2.8 Calcul de la loi stationnaire pour une chaîne à espace d’états fini

Théorème 4 – Soit une chaîne de Markov homogène irréductible et apériodique sur un espace

d’états fini {0,1,· · · ,N}, de matrice de transition P.

Alors il existe une loi stationnaire unique π′=[π0π1... πN]; c’est la solution du système d’équa-

tions :

πi=

N

X

j=0

πjpi j ,i=0,1,· · · ,N.

N

X

j=0

πj=1

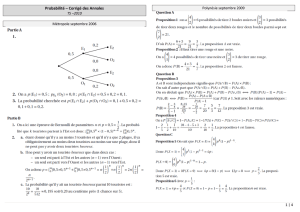

Exemple : Considérons la chaîne de Markov de matrice de transition Pdéfinie par :

P=

1/2 0 1/2

1/4 1/2 1/4

1/3 1/3 1/3

21

L3 MIS

Le graphe de cette chaîne est :

0

2 1

1/4

1/4

1/3

1/3

1/2

1/2

1/2 1/2

Tous les états communiquent : la chaîne est irréductible. Prenons l’état 0. Cet état est de

manière évidente de période 1. La périodicité étant une propriété de classe, tous les états sont de

période 1 et la chaîne est apériodique. D’après le théorème précédent, on peut donc dire qu’il

existe une loi stationnaire. C’est l’unique solution du système : π′P=π′et X

i

π=1, c’est-à-dire du

système :

π0+π1+π2=1

1

2π0+1

4π1+1

3π2=π0

1

2π1+1

3=π1

1

2π0+1

4π1+1

3π2=π2

Les solutions s’obtiennent sans difficultés et on a : π0=3/8 , π1=1/4 et π2=3/8 .

Ainsi donc lim

n→+∞ p(n)

j,0=lim

n→+∞ p(n)

j,2=3/8 et lim

n→+∞ p(n)

j,1=1/4.

lim

n→+∞ Pn=

3/8 1/4 3/8

3/8 1/4 3/8

3/8 1/4 3/8

.

Remarque : on sait que que P(n)=Pn. On peut donc approximer lim

n→+∞ P(n)par PMpour un Mtrès

grand (voir TP).

2.9 Calcul de lois limites

Les conditions du théorème (4) sont des conditions suffisantes mais non nécessaires. En effet,

on peut toujours chercher à calculer les lim

n→+∞ pi,j.

22

PROCESSUS ALÉATOIRES - CHAÎNES DE MARKOV

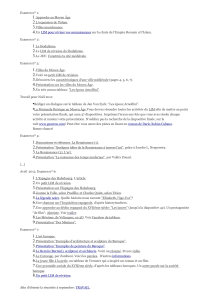

Exemple – Considérons la chaîne de Markov de matrice de transition

1/2 1/2 0 0

1/4 3/4 0 0

1/4 1/4 1/4 1/4

0 0 0 1

On a le graphe suivant :

C2

C3

C1

01

2

3

1/2

1/4

1/4

1/4

1/4

1/2

1/4

3/4

1

La chaîne n’est clairement pas irréductible : tous les états ne communiquent pas. On ne pourra

donc pas appliquer le théorème précédent.

Il y a 3 classes d’équivalences : C1={0,1},C2={2}et C3={3}.

Les classes C1et C3sont absorbantes ; une fois entré dans l’une ces classes, on ne peut en

sortir. La classe C2est elle transiente ; lorsqu’on est dans cette classe, on peut y rester un certain

temps mais on en sortira nécessairement après un certain nombre de transitions.

Tous les états sont de période 1 puisque pour tout i,p(n)

ii >0, quelque soit n∈N.

La chaîne est donc apériodique.

Nous ne sommes donc pas dans les conditions d’application du théorèmes. On peut cependant,

calculer les lois limites : lim

n→+∞ p(n)

i,j, pour tout i,jdans {0,1,2,3}.

Supposons que l’on soit initialement en l’état 3. Lorsqu’on est en 3, on y reste.

On a donc : lim

n→+∞ p(n)

33 =1 et lim

n→+∞ p(n)

3j=0,j=0,2,3.

Si on est en 2, on peut y rester un certain temps mais on entrera fatalement à un moment

dans l’une des classes C1ou C3.

On a donc : P(Xn∈C1|X0=2) +P(Xn∈C2|X0=2) =1 et lim

n→+∞ p(n)

22 =0, ¡n.b.:p(n)

22 =1

4n¢.

Calculons la probabilité d’être absorbé en C3. La probabilité d’atteindre 3 partant de 2 en n

transitions peut s’écrire :

p(n)

2,3=

n

X

k=0

p(k)

2,2p(1)

2,3p(n−k−1)

3,3=

n

X

k=0³1

4´k

×1

4×1n−k−1=1

4³1−(1/4)n+1

1−1/4 ´

23

6

6

1

/

6

100%