L’APPROCHE DES VALEURS EXTREMES EN STATISTIQUE DES SERIES FINANCIERES TOUBA SONIA

L’APPROCHE DES VALEURS

EXTREMES EN STATISTIQUE DES

SERIES FINANCIERES

TOUBA SONIA

2005 2006

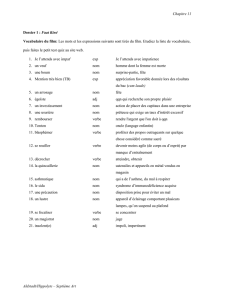

Table des matières

0.1 Introduction ........................... 5

0.2 Notations ............................. 7

1 Les lois stables 8

1.1 Préliminiaire............................ 8

1.2 Dé…nitions et caractéristiques de bases . . . . . . . . . . . . . 9

1.2.1 Lois indé…niment divisibles . . . . . . . . . . . . . . . . 9

1.2.2 La fonction caractéristique . . . . . . . . . . . . . . . . 11

1.2.3 La fonction de densité et la fonction de distribution . . 15

1.2.4 La stabilité . . . . . . . . . . . . . . . . . . . . . . . . 18

1.2.5 Calcul des moments . . . . . . . . . . . . . . . . . . . . 19

1.2.6 Propriétés arithmétiques . . . . . . . . . . . . . . . . . 22

1.3 Algorithme de simulation . . . . . . . . . . . . . . . . . . . . . 22

2 Estimation des paramètres du loi -stable 27

2.1 Méthode des moments . . . . . . . . . . . . . . . . . . . . . . 27

2.2 La méthode de régression . . . . . . . . . . . . . . . . . . . . . 29

2.2.1 Pour une loi stable alpha-symétrique . . . . . . . . . . 29

2.2.2 Pour une loi alpha-stable . . . . . . . . . . . . . . . . . 32

2.3 La méthode de McCulloch . . . . . . . . . . . . . . . . . . . . 36

2.4 La méthode de Maximum de vraissemblance . . . . . . . . . . 41

2.5 Aplication en …nance . . . . . . . . . . . . . . . . . . . . . . . 41

2.5.1 Application du modèle stable à l’indice du Nazdaq(Parie) 44

3 La théorie des valeurs extremes 47

3.1 Statistique d’ordre . . . . . . . . . . . . . . . . . . . . . . . . 47

3.1.1 Densité et loi des statistiques d’ordre . . . . . . . . . . 48

3.1.2 Domaines d’attractions . . . . . . . . . . . . . . . . . . 52

3.2 Lois stables et valeurs extrêmes . . . . . . . . . . . . . . . . . 57

3.2.1 Queues lourdes . . . . . . . . . . . . . . . . . . . . . . 57

3.2.2 Estimation des paramètres . . . . . . . . . . . . . . . . 58

1

4 Probabilité de ruine 63

4.1 Mouvement Brownien et le modèle de risque pour petites re-

vendications............................ 66

4.1.1 La convergence faible d’un processus de risque au Mou-

vementBrownien..................... 66

4.1.2 Probabilité de ruine pour le processus de limite . . . . 67

4.2 Lévy-stable et le modèle de risque pour grandes revendications 69

4.2.1 La convergence faible du processus de risque au Lévy-

stable ........................... 70

4.2.2 Le modèle de la probabilité de ruine pour le processus

limite de risque dans le cas de grandes revendications . 72

2

Table des Figures

1.1 Courbe de la densité pour 2 f1:75;1:5;1:25g,= 0,= 1

et = 0:13

1.2 Courbe de la densité pour = 2; = 0; = 1 et 2

f2;0;2;5g:13

1.3 Courbe de la densité pour = 2,= 0; = 0 et 2

f0:5;0:7;1;1:5g:14

1.4 Courbe de la densité pour 2 f1;0:5;0;0:5;1g; = 1:5; =

1et = 0:14

1.5 Comparaison graphique entre les deux parametrisations S et S0. 15

1.6 Les distributions de Cauchy, Lévy et Gauss. 17

1.7 Histogrammes normalisés des lois SS pour di¤érentes valeurs

de calculés sur 5000 réalisations. 26

1.8 Distribution d’une loi normale de paramètre = 2; = 0;

= 0,= 1 pour n= 60000. 27

1.9 Distribution d’une loi stable de paramètre = 1:5; = 0;

= 0; = 1 pour n= 10000. 27

2.1 Les prix des fermetures journaliers du Nazdaq. 46

2.2 Les rendements journaliers du Nazdaq hlog Pt

Pt1ipour la

periode allant 11/10/84 au 22/09/05. 47

2.3 Quantiles normaux contre quantiles empiriques du Nazdaq. 47

2.4 Histogramme des rendements du Nazdaq. 48

3.1 Fonction de probabilité Fi:5 (x)lorsque X est une variable aléa-

toire gaussienne. 50

3.2 Fonction de densité fi:5 (x)lorsque X est une variable aléatoire

gaussienne. 51

3.3 Fonction de probabilité Fn:n(x)lorsque X est une variable

aléatoire gaussienne. 52

3.4 Fonction de densité fi:5 (x)lorsque X est une v.a. gaussienne. 52

3.5 Les domaines d’attraction. 55

3

Liste des Tableaux

1.1 Moyenne et variance théorique d’une loi -stable. 20

1.2 Moyenne et variance empirique d’une loi -stable symétrique. 21

2.1 Estimation des paramètres ; ; et par la méthode des moments. 31

2.2 Valeurs optimales de ken fonction de net de . 33

2.3 Estimation de et du loi -stable symétrique par regression. 34

2.4 Estimation de et du loi -stable par regression. 35

2.5 Estimation des paramètres ; ; et par la méthode de regression. 38

2.6 Estimation de et par la méthde de McCulloch. 40

2.7 Estimation de et par la méthode de McCulloch. 42

2.8 Tab.(2.7).Paramètres estimés pour quelques indices. 45

2.9 Statistique de kurtosis pour di¤érentes indices. 46

2.10 Caractéristiques empiriques des rendements du Nazdaq(Parie). 49

2.11 Paramètres éstimés des rendements du Nazdaq(Parie). 49

3.1 Domaines d’attractions. 58

3.2 Exemples de ditributions Heavy Tailed. 60

4.1 Probabilité de ruine pour le modèle brownien. 71

4.2 Probabilité de ruine pour = 1:12 et = 20; = 10 et t= 10. 76

4.3 Probabilité de ruine pour = 1:5et = 20; = 10 et t= 10. 76

4

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

1

/

80

100%