Fiches de Biostatistique (UE4) - Tutorat Associatif Marseillais

Fiches de Biostatistique (UE4)

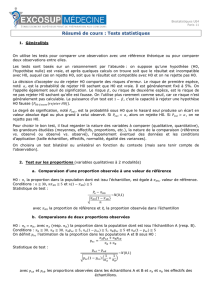

Chapitre 1

Les études en statistiques portent généralement sur des échantillons qui représentent une population cible.

│Le nombre d’éléments constituant l’échantillon est appelé l’effectif ou taille de l’échantillon.

interférence

ou généralisation

échantillon population

Les résultats d’une étude statistique sur un échantillon ne sont pas ceux de la population, mais d’une population

virtuelle car ils sont exposés aux interférences et aux généralisations.

On considère que notre étude porte sur un bon échantillon lorsque l'échantillon est « sans biais » (biais ≈ erreur)

et qu'il constitue une image réduite de l'ensemble de la population. Moins l’échantillon est biaisé, plus la

population virtuelle (=généralisation de l’échantillon) représente la population cible.

Si l’on sélectionne l’effectif par un « tirage au sort », on estime que l’échantillon et les résultats de notre étude

sont représentatifs.

Chapitre 2

│Le contour polygonal joignant les milieux des bases supérieurs des rectangles s’appelle le polygone des

fréquences.

ex : on part d’un histogramme qui lorsque les classes et l’effectif tend vers l’infini devient une courbe de

fréquence

1

Les paramètres de position ou de tendance :

-moyenne│Valeur centrale la plus utilisée est la moyenne arithmétique des mesures : x =

∑ xi

n

-médiane│Valeur qui laisse de part et d’autre un nombre égal d’observations ordinales quantitatives

-mode │Valeur de la variable dont la fréquence est maximale

-quantiles│Divisent l’échantillon ordonné en groupes d’effectifs égaux

│Tous les paramètres de tendance ont l’unité de la variable xi

Dans un exercice, il faut ordonner les mesures, c’est utile pour la médiane, les quantiles et les intervalles inter

quantiles.

Paramètre de dispersion :

-variance (unité xi2) Var(X) =

∑(xi−̄

x)²

n

-écart-type (unité de xi) σx =

√

Var(X)

quantitatives

-étendue (unité xi) │Différence entre la plus grande et la plus petite valeur de la série

-intervalle inter-quartile (unité xi) │50% des observations centrées sur la médiane ordinales

égale à Q3-Q1, représente la dispersion des données

nb : la variance et l’écart type calculés ne sont pas ceux de la population, ni l’estimation de la variance de la pop

mais bien d’un échantillon représentant plus ou moins bien la population.

Si une variable aléatoire est dépendante d’une autre : yi = axi + b : Var(Y) = a² Var(X)

Ecart type(Y) = |a| = |a| Ecart type(X)

ex : Je lance un dé, les valeurs de la variable aléatoire X sont : {1, 2, 3, 4, 5, 6} Le gain de ce jeu est représenté

par la variable aléatoire Y = 2X – 3

Paramètres de dispersion pour quantitative à 2 dimensions :

La covariance : Covar(X,Y) =

∑(xi−̄

x)( yi−̄

y)

n

Le point G est la moyenne des 2 séries d’observations ( trouver votre point G par les maths!)

Le coefficient de corrélation : r =

Covar(X ,Y )

√

Var(X).Var(Y)

r reflète la dispersion d'un couple sur la dispersion de chaque série, il n’a pas de dimension et est compris entre

[-1 ;1].

2

Chapitre 3

Un ensemble fondamentale (Ω) représente toutes les issus possibles d'une expérience

(=épreuve).

│2 événements disjoints sont incompatibles et ne sont jamais indépendant (si l’un se

produit, alors nécessairement l'autre ne peut pas se produire) : E1 ∩ E2 = ∅alors

P(E1 ∪E2) = P(E1) + P(E2)

Probabilité complémentaire : P(E) = 1 – P(nonE)

Probabilité d’additivité : P(A∪B) = P(A) + P(B) – P(A∩B)

│La probabilité conditionnelle de A par rapport à B ( la probabilité que l’événement A se produit sachant que B

est réalisé avec P(B)>0) est définie par : P(A/B) = P(A∩B) / P(B)

Ex : la probabilité que j'ai un enfant en faisant l'amour en sachant que j'ai mis une capote.

Probabilité composé:si P(A/B) = P(A∩B) / P(B) alors P(A∩B) = P(A/B) . P(B) = P(B/A) . P(A)

Il est important d'avoir cette relation en tête, si on nous demande la probabilité de décéder sachant qu'on est

fumeur et que les infos proposées sont : P(fumeur/décès), P(décès) et P(fumeur)

→ P(décès/fumeur) = [P(fumeur/décès).P(décès)] / P(fumeur)

│A et B sont indépendant si et seulement si : P(A∩B) = P(A) . P(B)

│Probabilité totale : P(B) = P(B∩A1) + P(B∩A2) … P(B∩Ak)

Dans cet exemple B comprend seulement une partie de A1, de A2, de A3

et A4 ; P(B) = P(B∩A1) + P(B∩A2) + P(B∩A3) + P(B∩A4)

Si A3 était complétement compris dans B, on peut remplacer P(B∩A3)

par P(A3)

│Le théorème de Bayes est : P(Ai / B) =

P(B/Ai).P(Ai)

P(B/A1).P(A1)+ …+P(B/Ak).P(Ak)

Le théorème de Bayes est une formule en intégrant plusieurs autres :

-1er étape, l'énoncé nous demande une probabilité conditionnelle :P(A/B) = P(A∩B) / P(B)

-2ème étape, si l'on a pas P(A∩B), on utilise les prob composés : P(A/B) = P(B/A) . P(A) / P(B)

-3ème étape, si l'on a pas P(B), on utilise les prob totales :P(B) = P(B∩A ) + … + P(B∩Z)

→ P(A/B) = [P(B/A).P(A)] / [P(B∩A) + … + P(B∩Z)]

-4ème étape, si l'on a aucune probabilité en intersection, on utilise les prob composés P(A∩B) = P(B/A) . P(A)

→

P(B/A).P(A)

P(B/A).P(A)+ …+P(B/Z).P(Z)

3

Chapitre 4

Variable aléatoire discrète :

│Espérance mathématique d’une v.a discrète E(X)=μ=Σ xi pi

nb : E(X) est une moyenne théorique puisqu’associer à des probabilités

│La variance de X, noté σ², est : σ²= (x1-μ)² p1 + (x2-μ)² p2+…+(xk -μ)² pk

│L’écart type de X est égal à la racine carrée de la variance de X, soit σ. C’est une

quantité positive.

Remarque : E(X), σ(x) et σ²(x) sont des constantes

Pour Y = a X + b (a et b des constantes) : -E(Y) = a.E(X) + b

-Var(Y) = a².Var(X)= a².σ²

-écart-type de Y = |a|.σ

Variable aléatoire continue :

│La probabilité pour qu'une réalisation au hasard de la v.a soit comprise entre deux valeurs x1 et x2 correspond

à la surface comprise entre la courbe de densité et l’axe des X limité par les 2 verticales passant par x1 et x2

Espérance mathématique E(X) = ∫-∞+∞ x . f(x) dx ← moyenne théorique

Variance : Var(X) = σ²

Sauf que pour une variable aléatoire continue, c’est la surface délimité par l’intervalle et la courbe qui

représente la probabilité donc :

-P(X=xi)=0

-∫-∞+∞ f(x)dx = 1 nb : on parle de densité de probabilité positive ou nul

P(6) = 0

∫23 de la fonction représentant la

variable aléatoire continue et on

obtient la probabilité qu'un événement

arrive entre 2 et 3

nb :en pratique cet exemple ne sert à rien pour le concour, mais c'est pour que vous comprenez !

Variables aléatoires conjointes : = association de deux v.a.

ex : le taux de cholestérol et le poids d’une même personne

Si X1 et X2 sont conjoints on peut écrire E(X1+X2) = E(X1) + E(X2)

Si X1 et X2 sont indépendants, alors : Var(X1 + X2) = Var(X1) + Var(X2)

Var(X1-X2) = Var(X1) + (-1)²Var(X2) = Var(X1) + Var(X2)

E(X1.X2) = E(X1).E(X2)

│X et Y sont indépendantes ssi :

rij = P(X=xi et Y=yj) = P(X=xi).(P(Y=yj)

Il suffit de faire le calcul pour une seule valeur pour voir

s’ils sont indépendants.

Si deux variables ne sont pas indépendantes, alors on parle de distribution conditionnelle, la distribution de Y

lorsque X=xi est : rij =

P(X=xi∩Y=yi)

P(X=xi)

4

│Covariance de X et Y : Covar(X,Y) = Σ(xi-μx).(yi-μy).rij

│Coefficient de corrélation : ρxy = Covar(X,Y) / (σx.σy)

-1 ≤ ρxy ≤ 1 sans dimension, si X et Y sont indépendant alors ρxy = 0 ( si ρxy = 0, X

et Y ne sont pas forcément indépendant) et si Y=aX+b, alors ρxy = ±1 (en fonction

du signe de a)

Loi normale :

-f(x) est totalement déterminée par sa moyenne et son écart-type

-la fonction de densité est : continue, symétrique par rapport à la moyenne μ, passe par un maximum pour x=

μ, a une médiane égale à μ

│Si X est N(μ, σ) alors Y=aX+b (a et b sont des constantes) est N(aμ+b, |a|.σ). Cette propriété permet d’établir

un cas particulièrement utile par la suite en définissant une nouvelle v.a Z telle que Z=(X-μ)/σ. Dans ce cas la

loi de distribution de Z est N(0,1), appelé loi Normale centrée réduite (la distribution est centrée sur 0 avec

un écart-type égal à 1).

La loi normale est un outil pratique car elle représente l’allure de beaucoup de caractère à l’échelle de la

population (si l’on trace la courbe du QI, de la taille, du poids… de la population, elle aura l’allure de la courbe

de la loi normale).

Le but est donner un intervalle de confiance pour une moyenne ou une proportion de la population en

s’appuyant sur la moyenne de l’échantillon et un risque d’erreur.

Si α1 > α2 alors Nα1 < Nα2

Si la loi normale est centrée réduite : N(0,1)

α est le risque que la moyenne de la population soit en dehors

de l’intervalle trouvé pour la moyenne du test, il correspond à

une valeur Nα inscrite dans la table de la loi normale (p151 de

votre poly)

1-α est la probabilité que la moyenne de la population

appartienne à [-Nα ;+Nα]

Si la loi normale est non centrée réduite : ex : N(μ,σ) donc avec μ≠0 et σ≠1

Dans ce cas, il faut prendre en compte μ et σ en plus de α et

Nα dans le calcul des bornes

Loi de Student :

│La loi de Student dépend d’un seul paramètre : son nombre de degré de liberté (ddl) (=nombre de données

indépendantes)

│Elle est symétrique par rapport à 0, passe par un maximum pour 0, d’autant plus aplatie que ν (nombre de

ddl) est petit et tend vers la loi normal N(0,1) lorsque ν tend vers l’infini.

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

1

/

14

100%