Analyse numérique

Université Claude Bernard, Lyon I Licence Sciences, Technologies & Santé

43, boulevard 11 novembre 1918 Spécialité Mathématiques

69622 Villeurbanne cedex, France L. Pujo-Menjouet

[email protected]v-lyon1.fr

Analyse numérique

Troisième année de licence

1

Préambule

L’analyse numérique a commencé bien avant la conception des ordinateurs et leur utilisation

quotidienne que nous connaissons aujourd’hui. Les premières méthodes ont été développées pour

essayer de trouver des moyens rapides et efficaces de s’attaquer à des problèmes soit fastidieux à ré-

soudre à cause de leur grande dimension (systèmes à plusieurs dizaines d’équations par exemple),

soit parce qu’il n’existe pas solutions explicites connues même pour certaines équations assez

simples en apparence.

Dès que les premiers ordinateurs sont apparus, ce domaine des mathématiques a pris son envol et

continue encore à se développer de façon très soutenue.

Les applications extraordinairement nombreuses sont entrées dans notre vie quotidienne directe-

ment ou indirectement. Nous les utilisons désormais sans nous en rendre compte mais surtout en

ignorant la plupart du temps toute la théorie, l’expertise, le développement des compétences et l’in-

géniosité des chercheurs pour en arriver là. Nous pouvons téléphoner, communiquer par satellite,

faire des recherches sur internet, regarder des films où plus rien n’est réel sur l’écran, amélio-

rer la sécurité des voitures, des trains, des avions, connaître le temps qu’il fera une semaine à

l’avance,...et ce n’est qu’une infime partie de ce que l’on peut faire.

Le but de ce cours et s’initier aux bases de l’analyse numérique en espérant qu’elles éveilleront de

l’intérêt, de la curiosité et pourquoi pas une vocation.

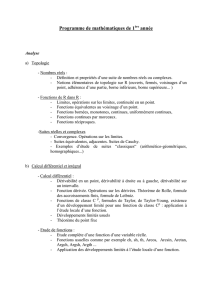

FIGURE 1–Entre le Tintin dessiné à la main dans les années 6 par Hergé et celui mis à l’écran

par Spielberg, un monde numérique les sépare. Un peu comme les premiers développements à la

main des pionniers du numérique et les effets dernier cri des plus puissants des ordinateurs.

2

Table des matières

1 Les systèmes linéaires 5

1.1 Introduction...................................... 5

1.1.1 Gestiondeserreurs.............................. 5

1.1.2 Exemple de problème menant à la résolution d’un système linéaire . . . . . 6

1.2 Quelques rappels sur les matrices . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

1.2.1 Notations................................... 9

1.2.2 Lien avec les applications linéaires . . . . . . . . . . . . . . . . . . . . . . 9

1.2.3 Opérations .................................. 11

1.2.4 Traceetdéterminant ............................. 13

1.2.5 Matrice et produit scalaire . . . . . . . . . . . . . . . . . . . . . . . . . . 14

1.2.6 Valeurs propres, vecteurs propres et réduction de matrices . . . . . . . . . 16

1.3 Normes vectorielles et matricielles . . . . . . . . . . . . . . . . . . . . . . . . . . 18

1.3.1 Rappels sur les normes vectorielles . . . . . . . . . . . . . . . . . . . . . 18

1.3.2 Boules .................................... 19

1.3.3 Normesmatricielles ............................. 20

1.3.4 Conditionnement............................... 21

1.4 Méthodes directes de résolution de systèmes linéaires . . . . . . . . . . . . . . . . 24

1.4.1 Principe des méthodes directes . . . . . . . . . . . . . . . . . . . . . . . . 25

1.4.2 Pivot de Gauss - Décomposition LU ..................... 25

1.4.3 Cas des matrices symétriques définies positives :la factorisation de Cholesky 28

1.4.4 Factorisation QR ............................... 28

1.5 Méthodes itératives de résolution de systèmes linéaires . . . . . . . . . . . . . . . 28

1.5.1 Principe des méthodes itératives . . . . . . . . . . . . . . . . . . . . . . . 29

1.5.2 Trois méthodes classiques . . . . . . . . . . . . . . . . . . . . . . . . . . 30

1.5.3 Critère général de convergence, étude des suites d’itérées de matrices . . . 31

1.5.4 Quelques cas particuliers de convergence . . . . . . . . . . . . . . . . . . 32

1.6 Méthodes numériques de calcul de valeurs propres et vecteurs propres . . . . . . . 33

1.6.1 Motivation : modes propres . . . . . . . . . . . . . . . . . . . . . . . . . 33

1.6.2 Difficultés................................... 34

1.6.3 Conditionnement spectral . . . . . . . . . . . . . . . . . . . . . . . . . . 34

1.6.4 Méthode de la puissance . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

1.6.5 Généralisation de la méthode de la puissance : la méthode QR ....... 37

3

TABLE DES MATIÈRES TABLE DES MATIÈRES

2 Résolution approchée d’équations non linaires 41

2.1 Introduction...................................... 41

2.2 Dichotomie ...................................... 42

2.3 Méthodedetypepointfixe .............................. 42

2.3.1 Théorème-énoncé général . . . . . . . . . . . . . . . . . . . . . . . . . . 42

2.3.2 Construction de méthodes pour f(x)=0 .................. 43

2.3.3 Vitesse de convergence . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

2.4 MéthodedeNewton.................................. 44

2.4.1 Principe.................................... 44

2.4.2 Théorème de convergence . . . . . . . . . . . . . . . . . . . . . . . . . . 45

2.5 Méthodedelasécante................................. 46

2.6 Ordre d’une méthode itérative . . . . . . . . . . . . . . . . . . . . . . . . . . . . 46

2.7 Systèmes d’équations non linéaires . . . . . . . . . . . . . . . . . . . . . . . . . . 47

2.7.1 Pointfixe ................................... 47

2.7.2 Méthode de Newton dans Rn......................... 48

2.7.3 Retour sur les systèmes linéaires et aux méthodes itératives . . . . . . . . . 48

3 Interpolation et approximation (polynomiales) 49

3.1 Introduction...................................... 49

3.2 Interpolation polynomiale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50

3.2.1 Interpolation de Lagrange . . . . . . . . . . . . . . . . . . . . . . . . . . 50

3.2.2 Interpolation d’Hermite . . . . . . . . . . . . . . . . . . . . . . . . . . . 53

3.3 Approximation polynomiale au sens des moindres carrés . . . . . . . . . . . . . . 54

4

Chapitre 1

Les systèmes linéaires

(a) Johann Carl Friedrich Gauss

(1777- 1855), mathématicien, as-

tronome et physicien allemand.

Considéré comme l’un des plus

grands mathématiciens de tous les

temps, nous utiliserons ici une mé-

thode numérique qui porte son

nom.

(b) Charles Gustave Jacob Ja-

cobi (1804-1851), un mathéma-

ticien allemand surtout connu

pour ses travaux sur les inté-

grales elliptiques, les équations

aux dérivées partielles et leur

application à la mécanique ana-

lytique. On lui doit une mé-

thode que l’on présentera ici

(c) André-Louis Cholesky (1875-

1918 ), polytechnicien et officier

français, ingénieur topographe et

géodésien. On lui doit une méthode

que l’on présentera ici

FIGURE 1.1 – Quelques mathématiciens célèbres liés à l’étude des nombres entiers, rationnels et

réels.

1.1 Introduction

1.1.1 Gestion des erreurs

Il arrive souvent lors de calcul que nous soyons obligés de donner une valeur approchée de la

solution (0,333 pour 1/3 par exemple), c’est ce que l’on appelle la représentation des nombres

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

1

/

48

100%