PROBA INFINI

1

Probabilité sur Ω infini

Modèle de Kolmogorov

I ) Modèle de Kolmogorov :

Utilité : Lorsque Ω est infini , il n'est plus possible de définir comme ensemble des événements : (Ω)

la règle

( )

∑

∈

∈

=

Ii i

Ii i

APAP

U

,si les A

i

sont disjoints , obligerait toutes les probabilités des événements

à être nulles ( Il y aurait trop d' événements ) . Il faut donc choisir ,comme ensemble des événements , un

sous ensemble de (Ω) ,mais ce sous ensemble doit vérifier certaines règles pour que la théorie soit

cohérente .

______________________________________

Définition 1 : Soit Ω un univers .

Tout sous ensemble T de (Ω) tel que :

_ Ω ∈

_ E ∈ ⇒

E

∈

_ ∀ ( E

1

, E

2 ,

......... , E

n

) ∈

n

,

U

n

1i i

E

=

∈

_ ∀ I ⊂ ,∀ (E

i

)

i

∈

I

d'éléments de T ,

U

Ii i

E

∈

∈ T

est appelé une tribu de Ω .

______________________________________

Remarque : l'union fini des algèbres est devenue une union dénombrable (infinie ⊂ )

______________________________________

Définition 2 : Tout univers Ω ,muni d'une tribu T est appelé espace probabilisable , notée ( Ω , T ) .

_____________________________________

Théorème 1 : Soit T une tribu .

_ ∈ .

_ ∀(E,F) ∈ , E∪F , E ∩F , E\F sont des éléments de

_ ∀ ( E

1

, E

2 ,

......... , E

n

) ∈

n

,

I

n

1i i

E

=

∈

∀ I ⊂ , ∀ (E

i

)

i∈I

d'éléments de T ,

I

Ii i

E

∈

∈

T

______________________________________

Exemple et Th 1:

_ {

,

Ω

} est une tribu appelé tribu triviale de

Ω

_

(

Ω

) est une tribu appelé tribu grossière de

Ω

_

∀

A

∈

(

Ω

) ,{

,A ,

A

,

Ω

} est une tribu de

Ω

______________________________________

Démonstration : à faire

2

______________________________________

Définition 4 : Soit I ⊂

(A

i

)

i∈I

est un système complet d'évènements de ( Ω , T )

c

Ω=

∅=∩≠∀ ∈∈∀

∈

U

Ii

i

ji

i

A

AAji

AIi T

______________________________________

II ) Probabilité sur ( W , T ) :

Définition 1 : Soit ( Ω , T ) un espace probabilisable .

On appelle probabilité sur ( Ω , T ) toute application P : T → lR

+

.

vérifiant a ) P ( Ω ) = 1

b ) ∀ (A

i

)

i∈

’

1,n

÷

d'éléments de T , tels que ∀ i ≠ j , A

i

∩A

j

= :

∑

=

=

=

n

1i i

n

1i i

)A(PAP

U

c ) ∀ (A

i

)

i∈lN

d'éléments de T , tels que ∀ i ≠ j , A

i

∩A

j

= :

∑

+∞

=

+∞

=

=

0i i

0i i

)A(PAP

U

______________________________________

Définition 2 : Tout univers Ω ,muni d'une tribu T et d'une probabilité P est appelé espace probabilisé ,

notée ( Ω , T , P ) .

______________________________________

Remarque : R1 :

∑

+∞

=0i i

)A(P est la somme d'une série convergente .

Démonstration: S

n

=

∑

=

n

0i i

)A(P =

=

U

n

1i i

AP

est une suite croissante majoré car

1)(PAP

n

1i i

=Ω≤

=

U

_____________________________________

R2 :

Toutes les propriétés ,théorèmes et définitions des probabilités finis restent valide

_____________________________________

Théorème 1 : Propriétés de continuité croissante et décroissante

Soit ( Ω , T , P ) un espace probabilisé , (A

n

)

n∈lN

une suite d'évènements (∈T ) .

1 . Si (A

n

)

n∈lN

est croissante c'est à dire ∀n∈lN A

n

⊂ A

n+1

alors la suite (P(A

n

))

n∈lN

converge

et

=

∈

+∞→

U

lNn nn

n

AP)A(Plim

2 . Si (A

n

)

n∈lN

est décroissante c'est à dire ∀n∈lN A

n+1

⊂ A

n

alors la suite (P(A

n

))

n∈lN

converge

et

=

∈

+∞→

I

lNn nn

n

AP)A(Plim

_____________________________________

3

Démonstration : 1. Soit (A

n

)

n∈lN

est croissante ,soit (B

n

)

n∈lN

définie par B

0

= A

0

et ∀n1 B

n

= A

n

\A

n-1

.

A

n

=

U

n

0i i

B

=

,et les B

i

sont disjoints deux à deux donc P(A

n

) =

∑

=

n

0i i

)B(P

donc

=

==

∈∈

+∞

=

+∞→

∑UU

lNn n

lNn n

0i in

n

APBP)B(P)A(Plim

2. Soit (A

n

)

n∈lN

est décroissante alors (

A

n

)

n∈lN

est croissante

donc

=

=

−=−=

∈∈∈

+∞→+∞→

IUU

lNn n

lNn

n

lNn

nn

n

n

n

APAPAP1)A(Plim1)A(Plim

_____________________________________

Corollaire : Soit ( Ω , T , P ) un espace probabilisé , (A

n

)

n∈lN

une suite d'évènements

=

∈=

+∞→

UU

lNn n

n

1i i

n

APAPlim

=

∈=

+∞→

II

lNn n

n

1i i

n

APAPlim

______________________________________

Définition 3 : Tout évènement E d'un espace probabilisé ( Ω , T , P ) tel que P(E) = 0 et E ≠ est dit

négligeable ou presque impossible ou quasi impossible.

Tout évènement de probabilité 1 et différent de Ω est dit presque certain ou quasi certain.

Toute propriété vérifiée sur un ensemble de probabilité 1 est dite presque sûrement vraie.

______________________________________

Exercice :

On effectue une suite de lancers à pile ou face avec une pièce équilibrée. Le jeu s’arrête lorsque on obtient pile.

1. ∀ n ∈ lN*. Calculez la probabilité p

n

qu’au cours des n premiers lancers, on n’ait obtenu que des "face".

2. Montrez que la probabilité que le jeu s’arrête après un nombre fini de lancers vaut 1 .

_____________________________________

Théorème 2 : Formule des probabilités totales 2.

Soit ( Ω , T , P ) un espace probabilisé , (A

n

)

n∈lN

un système complet d'évènements . tels que ∀n∈lN P(A

n

) ≠ 0

Alors ∀ B ∈ T , P( B ) =

∑

+∞

=

0n n

n

A

B

P)A(P =

( )

∑

+∞

=0n An

BP)A(P

n

_____________________________________

Remarque: R1: L' ancienne formule reste valide

R2:

∑

+∞

=

0n n

n

A

B

P)A(P est la somme d'une série convergente .

Démonstration: S

N

=

∑

=

N

0n n

n

A

B

P)A(P =

∑

=

∩

N

0n n

)BA(P =

( )

∩

=

U

N

0n n

BAP

est une suite croissante

majoré car

( )

1)(PBAP

N

0n i

=Ω≤

∩

=

U

4

R3: La notion de système complet d'événements peut être remplacée par la notion de système

quasi complet d'événements :

(A

i

)

i∈I

est un système quasi complet d'évènements de ( Ω , T )

c

=

∅=∩≠∀ ∈∈∀

∑

∈

1)A(P

AAji

AIi

Ii

i

ji

i

T

_____________________________________

Exercice : Dans une urne on place 9 boules blanches et 1 noire .

On tire dans cette urne des boules une à une ,avec remise de la boule tirée ,jusqu'à obtenir la boule

noire pour la première fois ,soit p le nombre de fois nécessaire ,on jette alors p pièces .

Quelle est la probabilité d'obtenir 2 piles .

____________________________________

III ) Indépendance :

Soit ( Ω , T , P ) un espace probabilisé

Définition 1 : Soient ( A , B ) ∈ T ²

A et B sont indépendants ⇔ P( A ∩ B ) = P (A ) P ( B )

_____________________________________

Définition 2 : Soient ( A

1

, A

2

, ... , A

n

) ∈ T

n

Les A

i

sont deux à deux indépendants ⇔ ∀ i ≠ j P( A

i

∩ A

j

) = P (A

i

) P ( A

j

)

_____________________________________

Remarque: Dans ce cas là A

1

∩ A

2

n'est peut être pas indépendant de A

3

, P( A

1

∩ A

2

∩ A

3

) n'est donc pas

calculable.

_____________________________________

Définition 3 : Soient ( A

1

, A

2

, ... , A

n

) ∈ T

n

Les A

i

sont mutuellement indépendants ⇔ ∀ I ⊂ ’1 , n ÷

∏

∈

∈

=

Ii i

Ii i

)A(PAP

I

_____________________________________

Remarque: Cette définition ,bien que compliqué , correspond à la notion intuitive d'indépendance pour plusieurs

évènements.

_____________________________________

IV ) Variables aléatoires :

Définition 1 : On appelle variable aléatoire réelle sur ( Ω , T , P ) toute application X : Ω → lR

telle que ∀x∈lR , X

-1

( ] - , x ] ) ∈ T

_____________________________________

5

Théorème 1 : Soit X une variable aléatoire réelle sur ( Ω , T , P ) alors ∀(a,b) ∈ lR²

X

-1

( [a,b] ), X

-1

(]a,b[), X

-1

( [a,b[), X

-1

(]a,b] ), X

-1

( [a,+[ ), X

-1

( {b}) sont tous des éléments de T

_____________________________________

Démonstration : exercice

a ) Démontrez que ∀ (A,B) ⊂ lR X

-1

( A∪B ) = X

-1

( A)∪ X

-1

( B ) ; X

-1

( A∩B ) = X

-1

( A)∩ X

-1

( B )

X

-1

(

A

) = A) ( X

1-

; X

-1

( A\B ) = X

-1

( A)\ X

-1

( B )

b ) Démontrez que ∀(A

i

)

i

∈

I

⊂ lR

( )

II

Ii i

1

Ii i

1

AXAX

∈

−

∈

−

=

et

( )

UU

Ii i

1

Ii i

1

AXAX

∈

−

∈

−

=

c ) Démontrez que X

-1

(]a,b] ) ∈ T .

d ) Démontrez que X

-1

( {b}) ∈ T .

e ) Démontrez le Th .

_____________________________________

Théorème 2 : Soient X et Y deux variables aléatoires réelles sur ( Ω , T , P ) , λ∈lR , f continue sur lR

X + Y , λX , XY , f ( X ) , max ( X , Y ) , min ( X , Y ) sont des variables aléatoires réelles .

____________________________________

Remarque: max(X,Y) est la var tel que ∀ω∈Ω max ( X , Y )(ω) = max ( X(ω) , Y(ω))

attention max(X,Y) n'est ni égale à X ni à Y

X(ω)1 5 2 8 7 -2 5 6 3

Y(ω)-1 5 3 6 6 6 8 1 3

max ( X , Y )(ω)1 53876 863

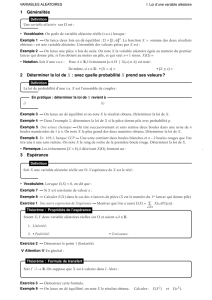

Variables aléatoires discrètes

I ) Définitions :

Soit ( Ω , T , P ) un espace probabilisé.

Définition 1 : Une variable aléatoire X est discrète ⇔ X( Ω ) est dénombrable ou fini .

________________________________

Théorème 2 : Soit X une variable aléatoire discrète alors

X( Ω ) = { x

1

, x

2

, .........,x

n

} = { x

i

tel que i∈’1,n÷ }

ou X( Ω ) = { x

1

, x

2

, .........,x

n

, ...... } = { x

i

tel que i∈lN* }

Par convention on considérera que i<j ⇒ x

i

< x

j

.

_______________________________

Remarque : Soit X une variable aléatoire discrète alors X

-1

( {x

i

}) ∈ T .

_______________________________

Définition 3 : La loi d'une variable aléatoire discrète X est

a ) X (Ω )

b ) ∀x

i

∈ X ( Ω ) P( X = x

i

) = P( X

-1

( {x

i

})

________________________________

6

6

7

7

8

8

1

/

8

100%