Probabilités Table des matières - Ceremade

Université Paris–Dauphine Année 2014/2015

DEMI2E

Probabilités

Partie III

Joseph Lehec

Table des matières

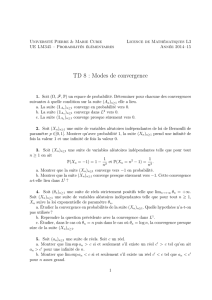

8 Variables indépendantes 2

8.1 Définition ......................................... 2

8.2 Covariance ........................................ 3

8.3 Exercices ......................................... 3

9 Théorèmes limites 5

9.1 Loidesgrandsnombres ................................. 5

9.2 Convergenceenloi .................................... 7

9.3 Théorème de la limite centrale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

9.4 Loidel’arcsinus ..................................... 10

9.5 Exercices ......................................... 11

8 Variables indépendantes

8.1 Définition

Définition 8.1. Soient X, Y des variables aléatoires. On dit que Xet Ysont indépendantes si

pour tous A, B ∈ B(R)

P(X∈A, Y ∈B) = P(X∈A)P(X∈B).

Proposition 8.2. Soient Xet Ydes variables discrètes, Xet Ysont indépendantes si et seulement

si

P(X=x, Y =y) = P(X=x)P(Y=y),∀x, y ∈R.(1)

Remarque. Attention ceci ne marche que pour les variables discrètes. Par exemple si Xet Ysont

continues, on a toujours

P(X=x, Y =y) = 0 = P(X=x)P(Y=y).

Démonstration. On suppose qu’on a (1) et que Xet Ysont à valeurs dans N(par exemple). Soient

A, B des Boréliens de R, on a

P(X∈A, Y ∈B) = X

i∈A,j∈B

P(X=i, Y =j)

=X

i∈A,j∈B

P(X=i)P(Y=j)

=X

i∈A

P(X=i)X

j∈B

P(Y=j)

=P(X∈A)P(X∈B),

ce qui montre que Xet Ysont indépendantes. La réciproque est évidente.

Exemple 8.3. On lance deux dés, on appelle Xet Yles résultats respectifs du premier et deuxième

dé. On a

P(X= 2, Y = 3) = 1

36 =P(X= 2)P(Y= 3).

Donc {X= 2}est indépendant de {Y= 3}et de même pour les autres valeurs de Xet Y. Ainsi

Xest indépendant de Y.

Proposition 8.4. Si Xet Ysont indépendantes alors

E[f(X)g(Y)] = E[f(X)] E[g(Y)],

pour toutes fonctions fet g(telles que les espérances précédentes soient bien définies).

Démonstration. C’est toujours la même histoire : on a la propriété pour les fonctions indicatrices,

par linéarité on l’obtient pour les fonctions étagées, puis pour les fonctions positives par convergence

monotone, etc. . .

Proposition 8.5. Soient X, Y des variables aléatoires indépendantes. On a MX+Y=MXMY.

Démonstration. On utilise la proposition précédente :

MX+Y(t) = E(et(X+Y)) = E(etX etY ) = E(etX )E(etY ) = MX(t)MY(t).

Exemple 8.6. Soit X, Y des variables indépendantes suivant des lois de Poisson de paramètres λ

et µ, respectivement. On calcule la fonction génératrice des moments de X+Y:

MX+Y(t) = MX(t)MY(t)

= exp λ(et−1)exp µ(et−1)

= exp (λ+µ)(et−1).

On reconnaît la fonction génératrice des moments de la loi de Poisson de paramètre λ+µ. Comme

la fonction génératrice des moments caractérise la loi, la variable X+Ysuit la loi de Poisson de

paramètre λ+µ.

2

Définition 8.7. On dit que (Xn)n∈Nest une suite de variables aléatoires indépendantes si pour

toute suite finie d’indices 0≤i1< i2<··· < inet de Boréliens B1, . . . , Bnon a

P(Xi1∈B1, . . . , Xin∈Bn) = P(Xi1∈B1)× ··· × P(Xin∈Bn).

Si on a seulement

P(Xi∈A, Xj∈B) = P(Xi∈A)P(Xj∈B)

pour tout i6=jon dit que les variables (Xi)i≥1sont deux à deux indépendantes.

8.2 Covariance

Définition 8.8. On appelle covariance de deux variables de carré intégrable la quantité

cov(X, Y ) = E(XY )−E(X)E(Y).

Remarque. Comme 2|XY | ≤ X2+Y2, la covariance de Xet Yest définie dès que Xet Ysont de

carré intégrable.

La covariance sert à calculer la variance de la somme :

var(X+Y) = E[(X+Y)2]−[E(X+Y)]2

=E(X2)+2E(XY ) + E(Y2)−(EX)2−2(EX)(EY)

=var(X) + var(Y)+2cov(X, Y ).

Plus généralement on a

var n

X

i=1

Xi!=

n

X

i=1

var(Xi)+2 X

1≤i<j≤n

cov(Xi, Xj)

pour toute famille X1, . . . , Xnde variables de carré intégrable.

Lemme 8.9. Si X, Y sont indépendantes et de carré intégrable alors cov(X, Y )=0.

Démonstration. Il suffit d’appliquer la Proposition 8.4 : on a E(XY ) = E(X)E(Y).

Remarque. La réciproque n’est pas vraie, on peut avoir cov(X, Y ) = 0 sans que Xet Ysoient

indépendantes.

Par conséquent si Xet Ysont indépendantes on a var(X+Y) = var(X) + var(Y). Plus géné-

ralement, si X1, X2, . . . , Xnsont indépendantes

var(X1+··· +Xn) = var(X1) + ··· +var(Xn).

Exemple 8.10. On peut retrouver la variance de la binomiale ainsi. Soient X1, . . . , Xndes va-

riables indépendantes suivant toutes la loi de Bernoulli de paramètre p. Alors X=PiXisuit une

binomiale de paramètres net pet

var(X) = var(X1) + ··· +var(Xn) = np(1 −p).

Des variables qui, comme dans l’exemple précédent, sont indépendantes et de même loi sont

dites i.i.d. (pour “indépendantes identiquement distribuées”).

8.3 Exercices

Exercice 8.1. On considère une main de poker, le nombre d’as est–il indépendant du nombre de

rois ? du nombre de trèfles ?

Exercice 8.2. Soit Xet Ydes variables aléatoires indépendantes, prenant toutes les deux les

valeurs 1et −1avec probabilité 1/2. Montrer que X,Yet XY sont deux à deux indépendantes.

Sont–elles mutuellement indépendantes ?

3

Exercice 8.3 (loi faible des grands nombres).Soit (Xi)i≥1une suite de variables i.i.d. de carré

intégrable. On pose m=E(X1)et σ=var(X1).

1. Exprimer la variance de (X1+··· +Xn)/n en fonction de net σ.

2. Montrer que pour tout > 0on a

lim

n→+∞

P

X1+··· +Xn

n−m≥= 0.

On dit que (X1+··· +Xn)/n converge vers men probabilité.

Exercice 8.4. Soient X, Y des variables indépendantes.

1. Exprimer la fonction de répartition de max(X, Y )en fonction des répartitions de Xet Y.

Même question avec min(X, Y ).

2. On suppose maintenant que Xet Ysont uniformes sur [0,1], déterminer la loi de max(X, Y ).

Exercice 8.5. Soient n, m des entiers, et p∈[0,1]. Soient Xet Ydes variables indépendantes et

binomiales de paramètres n, p et m, p, respectivement.

1. Calculer les fonctions génératrices des moments de Xet Y.

2. Déterminer la fonction génératrice des moments de X+Y.

3. En déduire la loi de X+Y.

Exercice 8.6. Soient X, Y des variables aléatoires indépendantes et de même loi géométrique de

paramètre p.

1. Déterminer la loi de min(X, Y ).

2. Calculer la fonction de masse de X−Y.

3. Montrer que min(X, Y )est indépendante de X−Y.

Exercice 8.7. Soient X1, X2des variables indépendantes de lois respectives Γ(n1, λ)et Γ(n2, λ).

1. Calculer la fonction génératrice des moments de X1+X2et en déduire sa loi.

2. Quelle est la loi de Y1+··· +Ynsi les Yisont i.i.d de loi exponentielle ?

Exercice 8.8. On considère nlancers de dés successifs. On appelle Aij l’événement “les résultats

des i–ème et j–ème lancers sont égaux” et on pose

X=X

1≤i<j≤n

1Aij .

1. Calculer l’espérance de X.

2. Montrer que les événements (Aij )1≤i<j≤nsont deux à deux indépendants. Sont–ils mutuel-

lement indépendants ?

3. Déterminer la variance de X.

Exercice 8.9. On modélise les durées qui s’écoulent entre deux passages successifs de bus à un

arrêt par une suite (τi)i≥1de variables i.i.d. de loi exponentielle de paramètre λ > 0: le premier

bus met un temps τ1à arriver, puis il s’écoule un temps τ2avant le passage du deuxième, etc. . .

Pour tout entier n≥1on appelle

Tn=

n

X

i=1

τi

le temps de passage du n-ième bus.

1. Soit n≥1. Déterminer la loi de Tn.

Indication : On pourra calculer sa fonction génératrice des moments.

2. Montrer que pour tout entier n≥1et pour tout t > 0, on a

P(Tn≤t) = (λt)ne−λt

n!+P(Tn+1 ≤t).

Indication : On pourra intégrer par parties.

3. On fixe t > 0. Déduire de la question précédente la loi du nombre N(t)de bus déjà passés à

l’instant t.

4

9 Théorèmes limites

9.1 Loi des grands nombres

Soit (Xn)une suite de variables aléatoires i.i.d. de loi donnée par

P(Xi= 1) = P(Xi=−1) = 1

2

et soit

Sn=

n

X

k=1

Xi

la marche aléatoire simple symétrique sur Z. On a déjà vu précédemment que pour tout > 0et

tout n≥1.

P

Sn

n≥≤1

n2

Lemme 9.1. Soit > 0. Il existe une constante Ctelle que

P

Sn

n≥≤C

4n2.

Par conséquent

X

n≥1

P

Sn

n≥<+∞.

Démonstration. D’après l’inégalité de Markov

P(|Sn|> n) = P(|Sn|4> n44)≤1

n44E[S4

n].(2)

Rappelons que Sn=X1+···+Xn, on a en développant et en utilisant la linéarité de l’espérance

E[S4

n] = X

i

E[X4

i] + 12 X

i6=j

E[X3

iXj] + 12 X

i<j

E[X2

iX2

j]

+ 24 X

i<j,k6=i,j

E[XiXjX2

k] + 24 X

i<j<k<l

E[XiXjXkXl],

Comme les Xisont d’espérance nulle et indépendantes on a

E[X3

iXj] = E[X3

i]E[Xj] = 0.

De même

E[XiXjX2

k] = E[Xi]E[Xj]E[X2

k]=0

et E[XiXjXkXl] = 0. De plus comme E[X2

i] = 1

E[X2

iX2

j] = E[X2

i]E[X2

j]=1.

On a aussi E[X4

i]=1, et donc

E[S4

n] = X

i

E[X4

i] + 12 X

i<j

E[X2

iX2

j]≤C n2

pour une certaine constante C. En reportant ceci dans (2) on obtient le résultat.

Lemme 9.2 (lemme de Borel–Cantelli).Soit (An)une suite d’événements vérifiant

X

n≥1

P(An)<+∞,

alors presque surement l’événement Anne se produit que pour un nombre fini d’entiers n.

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%