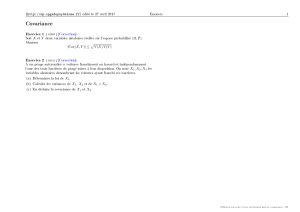

R appels de probabilité

1

Rappels de probabilité

1. Une variable aléatoire Y est une variable qui peut prendre

plusieurs valeurs (réalisations) à une date future, en fonction

d’événements plus ou moins probables (ex défaut).

2. La distribution de probabilités est l’ensemble de

probabilités associé à l’ensemble des réalisations.

3. Pour une VA discrète Y :

A l’ensemble des k réalisations possibles de Y :

{y1, y2, y3, …, yk} est associé un ensemble de

probabilités : { p1, p2, p3, …, pk} dont la somme =1.

Avec P(Y= yi) = pi

∀

i= 1 ,….k

4. La fonction de densité de probabilité f(y)

relie les probabilités aux réalisations.

Pour une VA discrète elle prend la forme :

f(yi)=pipour i=1,2, …k. Où piest un nombre entre 0 et 1

(avec somme des pi=1).

2

Ex de VA discrète : VA de Bernoulli avec P(Y=1) = p et P(Y=0) = 1-p

Ex: VA Y définie comme le résultat du lancer d’une pièce de monnaie

équilibrée. Si le résultat est face Y=1, si le résultat est pile Y=0.

Ici P(Y=1) =0,5 =P(Y=0) =0,5

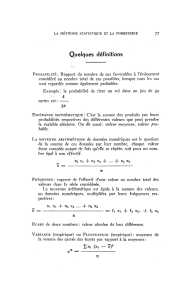

5. Les moments d’une VA Y:

•Moment d’ordre 1, l’espérance mathématique (moyenne théorique) :

Rq : E(a+bY) = a+bE(Y)

• Pour 1 VA discrète :

Exce : Vérifiez que E(Y) = p pour une VA de Bernoulli.

•Moment d’ordre 2, la variance : mesure théorique de la dispersion des

réalisations autour de l’espérance. m2=V(Y) = E[(Y-µ)²]=E(Y²)-µ² =

σ

²

Rq : V(a+bY+cX) = 0+b² V(Y)+c² V(X)+2bc COV(Y,X)

Avec COV(Y,X)= COV(X,Y) = E[(X-E(X))(Y-E(Y)]= E(XY)-E(X)E(Y)

Pour une VA discrète :

Exce: Vérifiez que V(Y) = p (1-p) pour une VA de Bernoulli.

( )

∑

=

=

k

i

ii

pyYE

1

( )

( )

∑

=

−=

k

i

ii

pyYV

1

2

µ

3

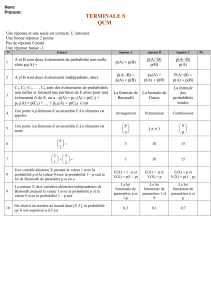

•Moment d’ordre 3, le coefficient de dissymétrie (skewness):

•

• Pour les rentabilités boursières les krachs peuvent induire m3 <0.

• Pour 1 VA symétrique (distribuée par ex selon 1 loi normale) m3 =0.

•Moment d’ordre 4, le coefficient d’aplatissement (le kurtosis) :

•

• Vaut 3 si Ysuit 1 loi normale : souvent les logiciels d’économétrie calculent

m4-3 , l’excès de kurtosis par rapport à 1 loi normale.

• Si m4-3 < 0, la distribution est platykurtique.

• Si m4-3 > 0, la distribution est leptokurtique. Par rapport à 1 loi normale la

fréquence des observations centrales et extrêmes ↑. Cas de la plupart des

séries de rentabilités fi dont les réalisations extrêmes sont anormalement

fréquentes. Svt associé à 1 forme de variabilité de

σ

²(hétéroscédasticité).

m3 <0 m3 >0

4

Uniforme (min=−√3, max=√3)

kurtosis = 1,8 ; excès = −1,2

Normale (μ=0, σ=1)

kurtosis = 3 ; excès = 0

Logistique (α=0, β=0,55153)

kurtosis = 4,2 ; excès = 1,2

Illustration des 3 cas d’excès de kurtosis:

1) négatif, 2) nul, 3) positif

5

6. VA continue Y

L’ensemble des réalisations de Y est indénombrable, de la forme

d’un intervalle [a,b] avec a<b ou de la forme [-∞,+ ∞].

La probabilité d’une réalisation en particulier est négligeable .

L’ensemble des probabilités est indénombrable.

La fonction de densité de probabilité f(y) est une fonction de y,

définie sur l’ensemble des réalisations. On la calcule ici toujours

sur un intervalle de l’ensemble des réalisations.

Par ailleurs on a bien sûr :

Fonction de répartition : F(y) = P(Y

≤

≤≤

≤

y) et ici

Rqs : P(c

≤

≤≤

≤

Y

≤

≤≤

≤

d)= P(Y

≤

≤≤

≤

d) - P(Y

≤

≤≤

≤

c) =F(d)-F(c)

1-F(y) = P(Y > y). Pour une VA continue P(Y

≤

≤≤

≤

y)

≈

≈≈

≈

P(Y <y)

Espérance :

Variance :

( )

1=

∫

+∞

∞−

dyyf

( ) ( )

∫

∞−

=

y

duufyF

( ) ( )

µ

==

∫

+∞

∞−

dyyfyYE

( )

( )

( ) ( )

22

2

2

µ

−

=−= ∫

+∞

∞−

dyyfyYEYEYV

6

Exemples courants de VA continues : VA normale, Chi-2, Student,

Fisher.

VA normale: Si Y~> N(Ym,

σ

²) alors :

Où Ymest un paramètre constant et σest une constante positive.

On peut aussi vérifier que E(Y) = Ymet V(Y) =

σ

²

Connaître ces deux paramètres suffit à calculer f(y) en tout point (réalisation)

y, cad à connaître la distribution de probabilités normale (gaussienne).

La distribution normale est symétrique : P(Y<-y)= P(Y>y)

Rqs: Ycentré réduit : Z = (Y- Ym)/

σ

~> N(0, 1).

Avec donc E(Z) = 0 et V(Z) = 1. Dans une table statistique de la loi normale

centrée réduite on peut lire :

P(Z < 2,58) = 0,995 = 99,5%

P(Z < -2,58) = P(Z > 2,58) = 1 - P(Z < 2,58) = 1- 99,5% = 0,5%

P (|Z| > 2,58) = P(Z < -2,58) + P(Z > 2,58) = 0,5% + 0,5% = 1%

P(|Z| > 1,96) = P(Z < -1,96) + P(Z > 1,96) = 2 P(Z > 1,96)

= 2 (1- P(Z < 1,96)) = 2 (1 - 97,5%) = 2 (2,5%) = 5%

( ) ( )

−

−=

2

2/1

2

1

exp

2

1

σ

πσ

m

Yy

yf

7

VA Chi-deux : Si

où les Xisont des VA normales centrées réduites iid ,

alors : Y ~> χn² et E(Y) =n et V(Y) =2n.

Une VA distribuée selon un Chi-deux ne prend (réalisations) que des valeurs

positives ou nulles.

VA Student : Si X~> N(0,1) , Y ~> χn² et

Alors Z ~> Tn

Avec E(Z)=0 (si X est centré) et V(Z)=n / (n-2) pour n>2

Quand le nbe de degrés de libertés n tend vers + ∞, la distribution de Student

converge vers la distribution normale.

VA Fisher : Si Y1~> χn1² , Y2~> χn2² et F= (Y1/ n1)/ (Y1/ n2)

alors F ~>F(n1, n2)

Rq : F est le rapport de 2 VA toujours positives, il est donc toujours positif.

∑

=

=

n

i

i

XY

1

2

n

Y

X

Z=

8

7. Distributions jointes, indépendance, distributions conditionnelles,

covariance et corrélation.

•La distribution jointe de deux VA X et Y est décrite par leur fonction de

densité jointe : fX,Y(x,y)

Dans le cas discret : fX,Y (x,y) = P(X = x,Y = y) = P(X =x ET Y = y)

•X et Y sont dites indépendantes ssi :

fX,Y(x,y)= fX(x) fY(y)

Soit, dans le cas discret : P(X = x,Y = y) = P(X =x) P(Y = y)

Rq : si X et Y sont indépendantes, alors E(X Y) = E(X) E(Y).

9

L’intérêt d’avoir des VA indépendantes :

Théorème central limite

Soient Z1, Z2,… Znune suite de VA iid avec E(Zi)=m et V(Zi) =

σ

²

Illustration : Soit X= Z1+ Z2 +… Znoù les Zisont iid et suivent une loi de

Bernoulli => X suit une loi binomiale: X~>B(n,p) ; E(X)=np, V(X) =np(1-p).

Montrez que d’après le théorème central limite

Ex : Calcul de la probabilité de devoir dédommager des passagers en cas de sur-

réservation. Soit Zi=1 si le passager i se présente, Zi=0 sinon. On suppose les Ziiid

et p(Zi=1) = 0,79046 . Nbre total rés° : n =600. Nbre max places dans l’avion :

500. X~>B(n, 0,79046) où n est le nombre de réservations vendues.

Calculez la probabilité que le nombre X de passagers qui se présentent dépasse 500.

(Réponse : 0,5% … à confirmer avec vos calculs)

10

•Distributions conditionnelles :

L’information qu’une VA X peut apporter sur une VA Y est donnée par la

distribution conditionnelle de Y, étant donné X. Cette information est résumée par la

fonction de densité de probabilité conditionnelle :

Dans le cas discret elle peut s’écrire :

Dans le cas où Y et X sont indépendantes :

L’espérance conditionnelle : Supposons que Y= a +b X +u avec

E(u |X)=0. Alors E(Y |X) = a+b E(X |X) +0= a+b X

L’espérance inconditionnelle : Supposons que Y= a +b X +u avec

E(u)=0. Alors E(Y) = a+b E(X)+0= a+b E(X)

Propriétés de la covariance :

1) L’indépendance entre X et Y => cov(X,Y) =0. Mais la réciproque est

fausse. La covariance ne mesure que la dépendance linéaire.

2) Cov(a+bX, c+dY) = b d Cov(X,Y)

3) |Cov(X,Y)| ≤ σXσY(inégalité de Cauchy-Schwartz)

6

6

1

/

6

100%