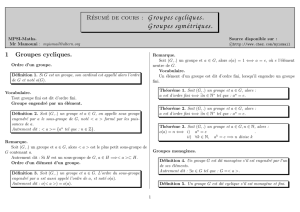

Chapitre 1 Groupes

Chapitre 1

Groupes

1.1 D´efinitions et exemples

1.1.1 Groupes :

Gensemble non vide muni d’une loi de composition interne not´ee ∗

g, g0∈G, g ∗g0est d´efini comme un ´el´ement de G

(G, ∗) est un groupe si et seulement si ∗est associative, poss`ede un ´el´ement neutre e, tout

´el´ement admet un sym´etrique.

Si de plus ∗est commutative, (G, ∗) est un groupe commutatif.

Si Gest un ensemble fini, card Gs’appelle l’ordre du groupe.

Remarque : l’´el´ement neutre est unique.

1.1.2 Morphisme :

(G, ∗),(G0,4) deux groupes, f:G→G0

fest un morphisme de groupe si et seulement si

∀(x, y)∈G,

f(x∗y) = f(x)4f(y)

Remarque : e´el´ement neutre de G, e0de G0

On a f(e) = e0

si on note x−1le sym´etrique de x

f(x−1) = f(x)−1

Proposition 1.1.1 : Si fest bijective et morphisme de groupe alors f−1est un mor-

phisme de G0sur G.

On dit alors que fest un isomorphisme de Gsur G0.

Remarque : f:G→Gisomorphisme, on dit que fest un automorphisme.

1

1.2 Sous groupes

1.2.1 D´efinition-Propri´et´es

H⊂G, (H, ×) groupe pour la loi induite par celle de G.

Th´eor`eme 1.2.1 (G, ×)un groupe d’´el´ement neutre e.

Les propositions suivantes sont ´equivalentes :

1)Hest un sous groupe de G

2)Hest stable, e∈Het ∀x∈H, x−1∈H

3)Hest stable, H6=φet ∀x∈H, x−1∈H

4)H6=φet ∀(x, y)∈H2, xy−1∈H

Remarque : Hsous groupe de G, K sous groupe de Halors Ksous groupe de G

Proposition 1.2.2 G, G0deux groupes f:G→G0morphisme

1) f(G)est un sous groupe de G0

2) si H0sous groupe de G0alors f−1(H0)est un sous groupe de G.

3) finjective ⇔f−1({e0}) = {e}.

On note Kerfcet ensemble.

Proposition 1.2.3 (G, +) un groupe, Het H0des sous groupes de Galors H∩H0est

un sous groupe.

Remarque : On peut g´en´eraliser `a une intersection quelconque de sous groupes.

H∪H0n’est pas un sous groupe en g´en´eral

Proposition 1.2.4 Tous les sous groupes de (Z,+) sont de la forme nZ, n ∈N

1.2.2 Sous groupe engendr´e

Gun groupe, A⊂G, existe-t-il un plus petit sous groupe de Gcontenant A?

C’est `a dire si A={sous groupe de Gcontenant A}, ordonn´e par ⊂,Aposs`ede-t-il un

plus petit ´el´ement ? \

H∈A

Hest un sous groupe.

A⊂Hpour tout H∈ A donc A⊂\

H∈A

Het c’est le plus petit ´el´ement de A

On l’appelle le sous groupe engendr´e par A. On le note [A]

Exemple : (G, ×) un groupe, a∈G, [a] = {an, n ∈Z}

D´efinition 1.2.5 ordre d’un ´el´ement

Th´eor`eme 1.2.6 Ggroupe fini, a∈G

L’ordre de adivise l’ordre de G.

Th´eor`eme 1.2.7 Soit(G, ×)groupe fini d’ordre n,

alors ∀a∈G, an=e

Remarque : notation additive [a] = {na, n ∈Z}.

2

1.3 Groupe sym´etrique de {1, . . . , n}:Sn

1.3.1 Sn:

Proposition 1.3.1 Sn={bijections de {1, . . . , n}sur lui mˆeme}. On pose I={1, . . . , n}.

Sngroupe fini d’ordre n! Les ´el´ements de Sns’appellent des permutations.

Sngroupe fini d’ordre n!

notation : σ:1 2 . . . . . . n

σ(1) σ(2) σ(n)

exemple : σ=123

321

D´efinition 1.3.2 :t∈Snest une transposition s’il existe i, j dans Itq i6=j , t(i) = j ,

t(j) = i

et ∀k∈I\{i, j}, t(k) = k.

Proposition 1.3.3 tune transposition de Sn.

On a t◦t=IdI

t−1=t

D´efinition 1.3.4 1≤i1, i2, . . . , ir≤n, r ≥2

le cycle associ´e `a i1, . . . , irest la permutation γde Sntq

γ(i1) = i2, . . . , γ(ir−1) = ir, γ(ir) = i1

γ(k) = k si k ∈I\{i1, . . . , ir}

On note γ= (i1, . . . , ir)

r=longueur du cycle γ

Remarque : L’ordre d’un cycle de longueur ret r.

si γ= (i1, . . . , ir)

γ−1= (ir, ir−1, . . . , i1)

D´efinition 1.3.5 γ= (i1, . . . , ip)et γ0= (j1, . . . , jq)sont disjoints si et seulement si

{i1, . . . , ip}∩{j1, . . . , jq}=φ.

remarque : 2 cycles disjoints commutent.

1.3.2 Th´eor`eme de d´ecomposition :

Th´eor`eme 1.3.6 Toute permutation de Sn, n ≥2est un produit pour ◦de transpositions.

L’ensemble des transpositions de Snengendrent Sn.

1.3.3 Signature d’une permutation :

Th´eor`eme 1.3.7 Il existe un unique morphisme de (Sn,◦)dans le groupe multiplicatif

{1,−1}tq

1) (t) = −1pour toute transposition t.

2) si σ∈Snest produit de stranspositions alors (σ) = (−1)s.

3

D´efinition 1.3.8 (σ) = signature de σ.

Remarque :

(IdI) = 1

(σ1σ2) = (σ1)(σ2)

(σ−1=(σ)

Calcul pratique d’une signature :

a) On d´ecompose σen produit de transpositions.

b) (σ) = Y

i<j

σ(j)−σ(i)

j−i

c) si γest un cycle de longueur r, (γ) = (−1)r+1

4

Chapitre 2

Anneaux et Corps

2.1 Anneau :

2.1.1 D´efinitions :

Aensemble muni de 2 lois de composition interne not´ees par exemple + et ×.

(A, +,×) est un anneau si et seulement si

•(A, +) groupe commutatif

• • × associative

• • • × distributive par rapport `a +

• • • • × poss`ede un ´el´ement neutre not´e 1

L’anneau est commutatif si la multipication est commutative.

On a les r`egles de calculs suivantes :

1) 0x=x0 = 0

2) (−x)y=−(xy) o`u −x= sym´etrique de x

3) (−x)(−y) = xy

Dans un anneau, xy = 0 n’implique pas x= 0 ou y= 0.

D´efinition 2.1.1 a∈A , a est un diviseur de 0 si et seulement si a∈A\{0}et il

existe b∈A\{0}tq ab =ba = 0.

On pose A∗=A\{0}.

Aest un anneau int`egre si et seulement si A6={0}, A commutatif et An’admet pas de

diviseur de 0.

D´efinition 2.1.2 ´el´ement inversible d’un anneau A6={0}.

a∈A, a est inversible si et seulement si il existe b∈Atq ab =ba = 1, b est alors unique.

On le note a−1

Proposition 2.1.3 L’ensemble des ´el´ements inversibles de Aest un groupe multiplicatif.

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

1

/

26

100%