(W) + - Deptinfo

APPRENTISSAGE 2

Mais la fonction F(x,W*)ne minimise pas nécessairement

l’erreur en généralisation qui est définie par :

On suppose que :

• Les données sont des réalisations d’un vecteur aléatoire Xdans Rn qui est

défini par la densité de probabilité p(x).

•A chaque observation xest associée un vecteur Ydans Rpqui se réalise

suivant la densité de probabilité conditionnelle p(y/x).

• L’apprentissage consiste à ajuster les paramètres W, pour une famille de

fonctions F(x,W)

w, en minimisant l’erreur d’apprentissage calculée sur

un ensemble de Nexemples : D = (x1, y1), (x2, y2), …, (xN, yN)

N

iiiD WxFy

N

WE 1

2

,

1

)(

dxdyxypxpWxFyWEgene 2

,)(

Définition

On démontre le résultat suivant :

dxxpWxFxMinWEMin géné 2

,)(

Remarque. La meilleure fonction en généralisation est celle qui

approxime au mieux (x)

xyEdyxyypx//)(

Soit :

Résultat 1

(x) représente la moyenne des réponses associées à x

Egéné et (x) sont inconnus. Dans la pratique, on cherche à estimer

(x) à partir d ’un ensemble d’apprentissage D en minimisant ED.

La solution obtenue, par l’algorithme d’apprentissage, dépend alors de

l’ensemble d ’apprentissage D, elle sera notée F(x, wD).

Problème de la régression

- Déterminer F(x,WD)à partie de l’ensemble d’apprentissage D

(de taille N).

- Pour un xdonné, la valeur de F(x,WD)est une variable

aléatoire, on peut calculer sa moyenne et sa variance.

-L’expression représente la précision de

l’approximation au point xet pour un ensemble

d’apprentissage Ddonné.

L’expression :

2

)/(),( xYEWxF D

dDDpxYEWxFxMSE D)()/(),()( 2

Représente la précision moyenne de l’approximation au point x,

lorsque l’on réalise un apprentissage sur un ensemble de taille N.

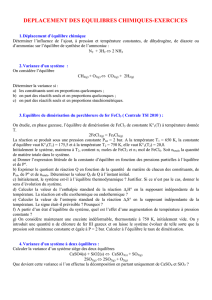

Décomposition Biais Variance

Résultat 2. On démontre la relation suivante :

22 ),((),()/()],([)( DDDDDD WxFEWxFExYEWxFExMSE

BIAIS VARIANCES

Remarque. Le biais et la variance ont tendance à évoluer d’une

manière opposée :

- Quand le Biais diminue la variance augmente,

- Quand la Variance diminue le biais augmente.

Un bon compromis entre le Biais et la Variance permet de

minimiser MSE(x).

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

1

/

18

100%