Table des matières - Pages personnelles Université Rennes 2

Table des matières

1 Espérance conditionnelle 1

1.1 Casdiscret .............................................. 1

1.2 Casabsolumentcontinu ....................................... 7

1.3 Applications.............................................. 14

1.3.1 Probabilités conditionnelles . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

1.3.2 Larégression ......................................... 15

1.4 Interprétation géométrique de l’espérance conditionnelle . . . . . . . . . . . . . . . . . . . . . 19

2 Vecteurs gaussiens et conditionnement 23

2.1 Rappels sur les vecteurs gaussiens . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

2.1.1 variablesgaussiennes..................................... 23

2.1.2 Vecteursgaussiens ...................................... 24

2.2 Conditionnement des vecteurs gaussiens . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 32

2.2.1 Conditionnement pour un couple gaussien . . . . . . . . . . . . . . . . . . . . . . . . . 32

2.2.2 Hyperplanderégression ................................... 34

2.2.3 Espérance conditionnelle gaussienne . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

i

ii

Chapitre 1

Espérance conditionnelle

1.1 Cas discret

On considère un couple aléatoire discret (X, Y ), c’est-à-dire une application mesurable

(X, Y )(Ω,F,P)→×

ω7→ (X(ω), Y (ω))

où = (xi)i∈Iet = (yj)j∈Jsont deux ensembles finis ou dénombrables.

La probabilité de tomber sur un couple (xi, yj)est :

pij =P(X=xi, Y =yj).

La suite double (pij )i∈I,j∈Jest appelée loi jointe du couple (X, Y )et on a :

0≤pij ≤1

Pi∈I,j∈Jpij = 1

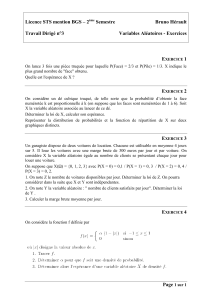

Exemple 1. On tire deux chiffres au hasard, indépendamment et de façon équiprobable entre 1 et 3. On

note Xle maximum des chiffres obtenus et Yla somme des chiffres obtenus. On peut représenter la loi jointe

dans un tableau :

Y= 2 Y= 3 Y= 4 Y= 5 Y= 6

X= 1 1/9 0 0 0 0

X= 2 0 2/9 1/9 0 0

X= 3 0 0 2/9 1/9 1/9

Tab. 1.1 – Loi de (X, Y ).

Définition 1.1 (Lois marginales)

Soit (X, Y )un couple aléatoire. Les variables Xet Ysont appelées variables marginales. La loi de Xest

appelée loi marginale. Elle entièrement déterminée par les probabilités pi•de tomber sur les points xi:

pi•=P(X=xi) = X

j∈J

P(X=xi, Y =yj) = X

j∈J

pij .

1

2 Chapitre 1. Espérance conditionnelle

De même la loi marginale de Yest déterminée par :

p•j=P(Y=yj) = X

i∈I

P(X=xi, Y =yj) = X

i∈I

pij .

Exemple 1. Pour l’exemple précédent, il suffit de sommer sur les lignes (resp. sur les colonnes) pour obtenir

la loi marginale de X(resp. de Y) :

Y= 2 Y= 3 Y= 4 Y= 5 Y= 6

X= 1 1/9 0 0 0 0 p1•= 1/9

X= 2 0 2/9 1/9 0 0 p2•= 3/9

X= 3 0 0 2/9 2/9 1/9 p3•= 5/9

p•1= 1/9p•2= 2/9p•3= 3/9p•4= 2/9p•5= 1/9

Tab. 1.2 – Lois jointe et marginales.

On peut aussi représenter la situation dans la figure 1.1, représentation spaciale dont on s’inspirera pour

interpréter le cas continu.

1

2

2

3

3 5 64

1

9

2

9

3

9

4

9

5

9

X

Y

Fig. 1.1 – Loi jointe (en traits pleins) et lois marginales (en pointillés).

Remarque

En général, la connaissance des lois marginales ne suffit pas reconstituer la loi jointe.

Probabilités et conditionnement - MASS 3 Nicolas JEGOU - Rennes 2

1.1. Cas discret 3

Exemple 2. En guise d’illustration, considérons une urne contenant deux boules blanches et une boule

noire. On tire deux boules de cette urne.

1er cas : tirage avec remise

On note, pour i= 1,2:Xi= 1 si la ieme boule est blanche et Xi= 0 si la ieme boule est noire. Les lois

marginales et jointe sont données dans le tableau suivant :

X1= 1 X1= 0

X2= 1 4/9 2/9 2/3

X2= 0 2/6 1/9 1/3

2/3 1/3

2nd cas : tirage sans remise

Cette fois, on note, pour i= 1,2:Yi= 1 si la ieme boule est blanche et Yi= 0 si la ieme boule est noire. Le

tableau est alors :

Y1= 1 Y1= 0

Y2= 1 2/6 2/6 2/3

Y2= 0 2/6 0 1/3

2/3 1/3

On constate que les lois marginales sont les mêmes alors que ce n’est pas le cas des lois jointes.

Nous pouvons obtenir facilement la loi jointe à partir des lois marginales dans un cas particulier : celui de

l’indépendance des deux variables.

Définition 1.2 (Indépendance)

Les variables aléatoires Xet Ysont dites indépendantes lorsque :

∀(i, j)∈I×JP(X=xi, Y =yj) = P(X=xi)P(Y=yj),

soit avec nos notations : pij =pi•p•j.

Exemple 2. Les variables X1et X2définies dans l’expérience précédente sont indépendantes mais ce n’est

pas le cas des variables Y1et Y2.

Définition 1.3 (Probabilités conditionnelles)

Soit xi∈, la loi conditionnelle de Ysachant X=xiest la loi discrète prenant les valeurs yjavec les

probabilités :

pj|i=P(Y=yj|X=xi) = P(X=xi, Y =yj)

P(X=xi)=pij

pi•

.

Remarques

– La définition suppose que P(X=xi)6= 0 ce qui est le cas sinon xin’a rien à faire dans .

– La suite pj|ij∈Jdéfinit bien une probabilité car :

∀j∈J0≤pj|i≤1et X

j∈J

pj|i=X

j∈J

P(X=xi, Y =yj)

P(X=xi)= 1.

Nicolas JEGOU - Rennes 2 Probabilités et conditionnement - MASS 3

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

1

/

24

100%