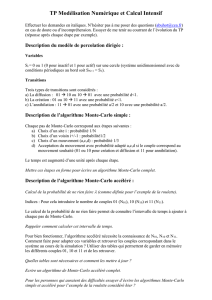

1 Apprentissage par renforcement : le bandit à 2 bras

{A, B}

A B pA

pBpA, pB

Xi= 1 i0Ei∈ {A, B}

i

Xi∼Bernoulli(pEi).

Eii(E1, X1),...,(Ei−1, Xi−1)

X1+· · · +Xn

n

n→+∞

→max {pA, pB}

E[X1+· · · +Xn]

ε

E1=A, E2=B

i≥3Mi

1−ε Ei=Mi

ε Ei= non(Mi)

ε1−ε

(X1+· · · +Xn)/n

ε

n= 1000 pA= 0.4pB= 0.6ε

i∈ {1, . . . , n} 7→ 1

iE[X1+· · · +Xi].

ε

c∈(0,1) pi

A i

p1= 1/2

i≥2

Ei=A pi

A Xi= 1 pi+1 =pi+c

i(1 −pi).

B pi+1 = (1 −c

i)pi.

pi+1 =pi

n= 1000 pA= 0.4pB= 0.6c= 0.4

i∈ {1, . . . , n} 7→ 1

iE[X1+· · · +Xi].

c

c

iA, B

1

/

2

100%