Mémoire - ENS Rennes

Mémoire de M2 Agreg

Endomorphismes diagonalisables en dimension finie

Salim Rostam

Année 2013–2014

Table des matières

Introduction 2

1 Définitions 2

1.1 Élémentspropres .................................. 2

1.2 Diagonalisabilité .................................. 3

2 Critères de diagonalisabilité 3

2.1 Polynômecaractéristique.............................. 3

2.2 Caractérisations avec les éléments propres . . . . . . . . . . . . . . . . . . . . 5

2.3 Caractérisations avec des polynômes annulateurs . . . . . . . . . . . . . . . . . 5

3 Familles d’endomorphismes diagonalisables 7

3.1 Topologie des matrices diagonalisables . . . . . . . . . . . . . . . . . . . . . . 7

3.2 Endomorphismesnormaux............................. 8

3.3 Codiagonalisabilité ................................. 9

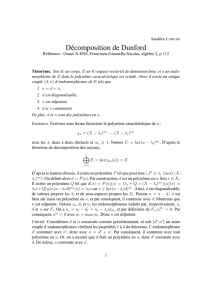

4 Décomposition de Dunford 10

A Nombre de matrices diagonalisables dans Mn(Fq)14

B Toute sous-algèbre réduite de Mn(C)est codiagonalisable 16

C La décomposition de Dunford avec la méthode de Newton 18

1

Introduction

Motivations. Les matrices les plus simples à étudier sont les matrices diagonales ; en effet,

la k-algèbre des matrices diagonales de taille nsur un corps kest canoniquement isomorphe à

la k-algèbre commutative kn. Ainsi, un endomorphisme qui admet dans une base une matrice

diagonale sera plus simple à étudier, en particulier on pourra plus facilement comprendre son

action sur les vecteurs.

Quelques notations et conventions. Dans la suite, on considère un espace vectoriel Ede

dimension finie n∈N∗sur un corps kquelconque ; on procède à l’identification Mn(k)' L(kn)

via la base canonique de kn, en particulier les définitions données pour des éléments de L(E)

se transposent pour des éléments de Mn(k).

Pour M∈ Mn(k), on note MTla transposée de la matrice M. Enfin, si rien n’est précisé

udésigne un élément de L(E).

1 Définitions

1.1 Éléments propres

Définition 1.1. On dit que λ∈kest une valeur propre de us’il existe x∈E\ {0}tel que

u(x) = λx ; on dit que xest un vecteur propre de uassocié à la valeur propre λ.

Remarque 1.2.On insiste sur le fait que par définition, un vecteur propre est non nul.

Exemple 1.3.Soit M:= ( 1 1

1 1 )∈ M2(Q); on a M(1

1) = ( 2

2)donc (1

1)est un vecteur propre

de Massocié à la valeur propre 2.

Définition 1.4. Le spectre de u, noté Sp(u), est l’ensemble de ses valeurs propres.

Remarque 1.5.Pour un élément M∈ Mn(k), la notation Sp(M)désigne donc les valeurs

propres de Mdans le corps k. Si Kest un sur-corps de k, on notera SpK(M)l’ensemble

des valeurs propres de Mvu comme élément de Mn(K),i.e. SpK(M) := {λ∈K:∃x∈

Kn\ {0}, Mx =λx}.

Définition 1.6. Pour λ∈Sp(u), on dit que Eλ(u) := {x∈E:u(x) = λx}est le sous-espace

propre de uassocié à la valeur propre λ.

Remarque 1.7.Les éléments de Eλ(u)sont exactement les vecteurs propres de uassociés à la

valeur propre λainsi que le vecteur nul.

Propriété 1.8. Si λ∈Sp(u)alors Eλ(u) = ker(u−λidE), en particulier Eλ(u)est un

sous-espace vectoriel de Estable par u.

Proposition 1.9. Les sous-espaces propres de usont en somme directe.

À propos de la démonstration. Remarquons que l’on ne sait pas encore qu’il n’y a qu’un

nombre fini de sous-espaces propres. En fait, par définition de la somme directe il suffit de

montrer que toute somme finie de sous-espaces propres est directe, ce que l’on montre par

exemple par récurrence sur le nombre de sous-espaces propres intervenant dans la somme.

Corollaire 1.10. L’endomorphisme upossède au plus nvaleurs propres.

2

1.2 Diagonalisabilité

Définition 1.11. On dit que l’endomorphisme uest diagonalisable s’il existe une base de E

formée de vecteurs propres de u.

Remarque 1.12.Dans une telle base, la matrice de uest diagonale. En particulier, une matrice

M∈ Mn(k)est diagonalisable ssi il existe D∈ Mn(k)diagonale et P∈GLn(k)telles que

M=P DP −1.

Exemple 1.13.Reprenons notre matrice M:= ( 1 1

1 1 )∈ M2(Q)de l’exemple 1.3 : on sait

déjà que v2:= ( 1

1)est un vecteur propre de M, associé à la valeur propre 2. On remarque

également que v0:= ( 1

−1)est un vecteur propre de Massocié à la valeur propre 0. Les sous-

espaces E2(M)et E0(M)étant en somme directe, la famille (v2, v0)est une base de Q2; comme

v2et v0sont des vecteurs propres de M, la matrice Mest diagonalisable et avec P:= ( 1 1

1−1)

on a P∈GL2(Q)et M=P(1 0

0 0 )P−1.

On voit que montrer qu’un endomorphisme est diagonalisable est assez laborieux. Dans la

section suivante, on va donner des méthodes pour déterminer (plus ou moins rapidement) si

un endomorphisme est diagonalisable ou non.

2 Critères de diagonalisabilité

Remarquons que, d’après la proposition 1.9, on a déjà ce résultat.

Proposition 2.1. Si upossède nvaleurs propres distinctes alors uest diagonalisable.

Cette situation n’étant bien entendu pas générale, on va dans ce qui suit trouver d’autres

critères de diagonalisabilité, en introduisant tout d’abord un outil aussi pratique que puissant :

le polynôme caractéristique.

2.1 Polynôme caractéristique

Définition 2.2. Soit M∈ Mn(k). Le polynôme caractéristique de Mest défini par

χM(X) := det(M−XIn).

Le polynôme caractéristique est le déterminant d’un élément de Mn(k[X]). Ainsi, si P∈

GLn(k), alors P∈GLn(k[X]) donc det(M−XIn) = det(P MP −1−XIn). On peut donc

énoncer la définition suivante.

Définition 2.3. Le polynôme caractéristique de uest défini comme étant le polynôme carac-

téristique de la matrice de udans une base (quelconque) de E.

Voici maintenant la proposition fondamentale qui lie le polynôme caractéristique aux va-

leurs propres, suivie de ses conséquences.

Proposition 2.4. Soit λ∈k; alors λ∈Sp(u) ssi χu(λ) = 0.

Démonstration. On a λ∈Sp(u) ssi u−λidEnon injectif ssi χu(λ) = 0.

Remarque 2.5.On retrouve le fait que Sp(u)possède au plus deg χu=néléments.

3

Proposition 2.6. Si M∈ Mn(k)alors SpK(M) = {λ∈K:χM(λ) = 0}pour tout sur-corps

Kde k.

Exemple 2.7.Toujours avec la matrice M:= ( 1 1

1 1 )∈ M2(Q), on a χM(X) = X2−tr(M)X+

det(M) = X2−2X=X(X−2) donc Sp(M) = {0,2}. Remarquons que dans l’exemple 1.13,

on pouvait dans un premier temps seulement conclure que Sp(M)⊇ {0,2}(on pouvait en fait

déjà en déduire l’égalité d’après le corollaire 1.10).

Application 2.8 (calcul de la puissance p-ième d’une matrice).Soit M:= ( 3−2

1 0 )∈ M2(Q); on

aχM=X2−3X+ 2 = (X−1)(X−2) donc Sp(M) = {1,2}. On remarque que le vecteur

v1:= ( 1

1)est un vecteur propre associé à la valeur propre 1et que le vecteur v2:= ( 2

1)est

un vecteur propre associé à la valeur propre 2(note 1). D’après la proposition 1.9 les vecteurs

v1et v2forment une base de Q2donc Mest diagonalisable ; avec D:= ( 1 0

0 2 )et P:= ( 1 2

1 1 )

on a M=P DP −1. Pour p∈N, la puissance p-ième de Ms’obtient alors simplement par

Mp=P DpP−1(et même pour p∈Zcar Mest inversible) ; comme Dp= ( 1 0

0 2p)on a

Mp=2p+1−1 2−2p+1

2p−1 2−2p.

Remarque 2.9.On pouvait aussi procéder par interpolation : si Qp∈Q[X]désigne un polynôme

envoyant 1sur 1et 2sur 2p(par exemple Qp(X) := X−2

1−2+2pX−1

2−1) on a Dp=Qp(D)donc Mp=

P DpP−1=P Qp(D)P−1=Qp(M). Cette méthode a l’avantage de ne pas nécessiter le calcul de

la matrice de passage Pet de son inverse, mais elle peut engendrer plus de multiplications de

matrices (considérer une matrice avec nvaleurs propres distinctes) ; finalement, cette méthode

s’applique a priori uniquement quand la matrice Mest diagonalisable.

Dans cette application, on a bien atteint l’objectif énoncé dans les motivations : on exploite

le fait que les calculs sur les matrices diagonales sont plus faciles !

Proposition 2.10. Si kest algébriquement clos alors Sp(u)6=∅.

Exemple 2.11.Avec M:= ( 0−1

1 0 )∈ M2(R), on a χM(X) = X2+ 1 donc SpR(M) = ∅mais

SpC(M) = {−i, +i} 6=∅.

Définition 2.12. Pour λ∈Sp(u), on note mλsa multiplicité en tant que racine de χu.

Proposition 2.13. Pour λ∈Sp(u)on a 16dim Eλ(u)6mλ.

Idée de démonstration. Tout d’abord, on a bien dim Eλ(u)>1car Eλ(u)!{0}(on a en fait

déjà utilisé ce résultat dans le corollaire 1.10). On a vu que l’espace Eλ(u)est stable par u;

soit ˜ul’endomorphisme induit. On a ˜u=λidEλ(u)donc χ˜u= (λ−X)dim Eλ(u). En écrivant

la matrice de udans une base adaptée à une décomposition E=Eλ(u)⊕F, on trouve que

χ˜u|χu; on conclut par définition de mλ.

Exemple 2.14.Avec les notations de l’exemple 1.13 on a donc E2(M) = vect(v2)et E0(M) =

vect(v0). Encore une fois, on pouvait bien sûr retrouver ces résultats en résolvant les systèmes

linéaires Mx = 2xet Mx = 0.

Application 2.15.Si uest de rang ralors par le théorème du rang on a dim ker u=n−rdonc

0est valeur propre de uet m0>n−r. En particulier, si r= 1 alors χu= (−1)n(X−λ)Xn−1

pour un λ∈k(éventuellement nul).

1. On peut bien sûr résoudre les systèmes linéaires Mx =xet Mx = 2xen la variable x∈Q2.

4

2.2 Caractérisations avec les éléments propres

Fort des résultats du paragraphe précédent, on peut désormais énoncer un théorème très

important.

Proposition 2.16. Les propositions suivantes sont équivalentes :

(i)uest diagonalisable ;

(ii)E=⊕λ∈Sp(u)Eλ(u);

(iii)n=Pλ∈Sp(u)dim Eλ(u);

(iv)χuest scindé sur ket ∀λ∈Sp(u),dim Eλ(u) = mλ.

Idée de démonstration. On montre les implications en remontant.

(iv)⇒(iii)χuest scindé sur kdonc d’après la proposition 2.4 les racines de χusont exacte-

ment les éléments de Sp(u). Ainsi, χu=Qλ∈Sp(u)(λ−X)mλdonc comme χuest de degré n

on a Pλ∈Sp(u)mλ=n. D’après la deuxième hypothèse on a donc Pλ∈Sp(u)dim Eλ(u) = n.

(iii)⇒(ii)On sait déjà par la proposition 1.9 que les Eλ(u)pour λ∈Sp(u)sont en somme

directe. Ainsi, E⊇ ⊕λ∈Sp(u)Eλ(u)et on conclut par égalité des dimensions.

(ii)⇒(i)On peut trouver une base de Econstituée de vecteurs propres de u.

(i)⇒(iv)Il existe une base de Eformée de vecteurs propres de u. En écrivant la matrice

de udans une telle base, on trouve que χuest scindé sur ket que dim Eλ(u)>mλ

∀λ∈Sp(u). On conclut par la proposition 2.13.

Voici deux corollaires très utiles.

Corollaire 2.17 (déja vu).Si upossède nvaleurs propres distinctes alors uest diagonalisable.

Corollaire 2.18. Si χuest scindé sur kà racines simples alors uest diagonalisable.

Remarque 2.19.Bien que ces deux corollaires soient équivalents, le deuxième va être généralisé

par le théorème 2.22 et le corollaire 3.4.

2.3 Caractérisations avec des polynômes annulateurs

Lemme 2.20 (lemme de décomposition des noyaux).Si Pet Qsont deux polynômes de k[X]

premiers entre eux, on a ker(P Q)(u) = ker P(u)⊕ker Q(u).

Remarque 2.21.Par une récurrence immédiate, le lemme s’étend à Npolynômes deux à deux

premiers entre eux.

Vient alors un théorème très important et très utile.

Théorème 2.22. L’endomorphisme uest diagonalisable ssi uest annulé par un polynôme

(non nul) de k[X]scindé sur kà racines simples.

Idée de démonstration. On applique le fait que (i)⇔(ii)dans la proposition 2.16 ainsi que

le lemme des noyaux.

On en déduit un résultat non trivial si l’on part de la définition de la diagonalisabilité.

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

1

/

20

100%