Acrobat

M. Ingenbleek

1997-1998

M. Ingenbleek

1997-1998

1 Introduction..............................................................................................................1-1

Un peu d'histoire............................................................................................................1-1

Survol méthodologique.................................................................................................1-2

Les étapes d'une analyse statistique...............................................................................1-2

Collecte des données..................................................................................................1-3

Analyse des données..................................................................................................1-3

Inférence et conclusion..............................................................................................1-3

Remarque...................................................................................................................1-3

Rappels mathématiques.............................................................................................1-4

2 Distribution des fréquences et diagrammes ..........................................................2-1

Distribution des fréquences...........................................................................................2-1

Fonction de répartition ..................................................................................................2-6

Autres représentations...................................................................................................2-7

3 Quantiles...................................................................................................................3-1

Introduction...................................................................................................................3-1

Définition ......................................................................................................................3-3

Quartiles et déciles ........................................................................................................3-3

4 Mesures de tendance centrale.................................................................................4-1

Introduction...................................................................................................................4-1

Quelques mesures de tendance centrale........................................................................4-1

La moyenne arithmétique ..........................................................................................4-1

La moyenne harmonique............................................................................................4-2

La moyenne géométrique...........................................................................................4-2

La médiane.................................................................................................................4-2

Le mode .....................................................................................................................4-2

Propriétés.......................................................................................................................4-3

Propriété caractéristique de la moyenne arithmétique...............................................4-3

Première propriété commune à toutes les mesures....................................................4-3

Deuxième propriété commune...................................................................................4-3

Relation entre la moyenne et la médiane...................................................................4-4

5 Mesures de dispersion .............................................................................................5-1

Introduction...................................................................................................................5-1

Quelques mesures de dispersion....................................................................................5-1

L'étendue....................................................................................................................5-1

L'intervalle inter-quartile ...........................................................................................5-1

L'écart moyen absolu .................................................................................................5-2

La variance.................................................................................................................5-2

L'écart-type ................................................................................................................5-2

M. Ingenbleek

1997-1998

Propriétés.......................................................................................................................5-2

Propriété de la variance..............................................................................................5-2

Première propriété commune aux mesures de dispersion..........................................5-3

Deuxième propriété commune...................................................................................5-3

6 Tableaux de contingence et mesures de dépendance............................................6-1

Introduction...................................................................................................................6-1

Tableau de contingence.................................................................................................6-1

Première mesure de dépendance ................................................................................6-3

Calcul pratique...........................................................................................................6-4

Deuxième mesure de dépendance ...............................................................................6-5

Calcul pratique...........................................................................................................6-6

Remarques ...............................................................................................................6-10

Mesure de dépendance entre deux variables ordinales ou cardinales: Rs...................6-10

7 Diagramme de Pareto et indice de concentration.................................................7-1

Diagramme de Pareto....................................................................................................7-1

Indice de concentration de Gini.....................................................................................7-2

8 Principales distributions .........................................................................................8-1

Introduction...................................................................................................................8-1

Lois de probabilité servant à la modélisation................................................................8-1

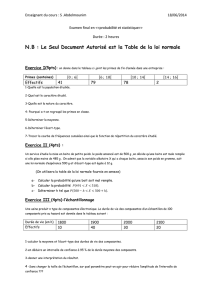

Loi binomiale - B(n,p)...............................................................................................8-2

Binomiale négative....................................................................................................8-3

Loi de Poisson - ().................................................................................................8-4

Loi normale - N(m,) ................................................................................................8-4

Loi log-normale .........................................................................................................8-5

Loi de Pareto..............................................................................................................8-6

Loi exponentielle .......................................................................................................8-6

Lois utilisées dans les calculs statistiques.....................................................................8-7

Loi normale................................................................................................................8-7

Loi Chi-carrée à n degrés de liberté...........................................................................8-7

Loi t de Student à n degrés de liberté.........................................................................8-8

Loi de F de Fisher à nl et n2 degrés de liberté............................................................8-8

Distribution du coefficient de corrélation de Spearmann..........................................8-9

9 Estimation: principes...............................................................................................9-1

Introduction...................................................................................................................9-1

Propriété d'un estimateur...............................................................................................9-1

Estimation convergente..............................................................................................9-1

Estimation sans biais..................................................................................................9-2

Estimation efficace ....................................................................................................9-2

Principe de maximum de vraisemblance.......................................................................9-3

Première étape............................................................................................................9-3

Deuxième étape .........................................................................................................9-3

M. Ingenbleek

1997-1998

Exemple.........................................................................................................................9-4

La fréquence des catastrophes ...................................................................................9-4

Le montant des dommages ........................................................................................9-6

Méthode des moindres carrés........................................................................................9-9

Intervalle de confiance ..................................................................................................9-9

10Estimations d'une population normale................................................................10-1

Premier cas: m inconnu, connu................................................................................10-1

Estimation................................................................................................................10-1

Propriétés.................................................................................................................10-2

Intervalle de confiance au niveau .........................................................................10-3

Exemple chiffré .......................................................................................................10-4

Deuxième cas: m inconnu, inconnu.........................................................................10-4

Estimations ..............................................................................................................10-5

Propriétés.................................................................................................................10-5

Intervalle de confiance au niveau pour m.............................................................10-7

Intervalle de confiance au niveau pour ² ............................................................10-9

Exemple chiffré .......................................................................................................10-9

11Estimation d'une proportion ................................................................................11-1

Introduction.................................................................................................................11-1

Estimation....................................................................................................................11-1

Etape 1.....................................................................................................................11-1

Etape 2.....................................................................................................................11-1

Propriété ......................................................................................................................11-2

Intervalle de confiance au niveau a .............................................................................11-2

Exemple chiffré...........................................................................................................11-3

Remarques...................................................................................................................11-4

12Estimation de la différence entre 2 moyennes.....................................................12-1

Introduction.................................................................................................................12-1

Propriété ......................................................................................................................12-1

Intervalle de confiance au niveau pour m1-m2.........................................................12-2

Exemple chiffré...........................................................................................................12-2

13Test d'hypothèses: principes.................................................................................13-1

Introduction.................................................................................................................13-1

Hypothèse nulle, contre-hypothèse et test...................................................................13-1

Risque de première et de deuxième espèce.................................................................13-2

14Test sur une proportion.........................................................................................14-1

Test d'hypothèse ..........................................................................................................14-1

Puissance du test sur une proportion...........................................................................14-2

15Test d'égalité de 2 moyennes.................................................................................15-1

Echantillons indépendants...........................................................................................15-1

M. Ingenbleek

1997-1998

Conditions d'application..........................................................................................15-1

Exemple...................................................................................................................15-1

Distribution de U sous Ho .......................................................................................15-3

Exemple numérique.................................................................................................15-4

Echantillons appariés...................................................................................................15-4

Conditions d'application..........................................................................................15-4

Statistique de Wilcoxon...........................................................................................15-5

Distribution de T sous Ho........................................................................................15-5

Exemple numérique.................................................................................................15-6

16Test d'ajustement...................................................................................................16-1

Introduction.................................................................................................................16-1

Distribution discrète et complètement spécifiée .........................................................16-1

Exemple chiffré .......................................................................................................16-2

Distribution continue et complètement spécifiée........................................................16-2

Exemple chiffré .......................................................................................................16-3

Cas général..................................................................................................................16-3

Exemple chiffré .......................................................................................................16-4

17Test d'indépendance entre 2 variables nominales ..............................................17-1

Introduction.................................................................................................................17-1

CHI-CARRE ...............................................................................................................17-1

Test au niveau ..........................................................................................................17-2

Exemple chiffré...........................................................................................................17-2

18Test d'indépendance entre 2 variables ordinales................................................18-1

Rappel..........................................................................................................................18-1

Distribution exacte de RS sous H0..............................................................................18-2

Distribution asymptotique...........................................................................................18-3

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

1

/

105

100%