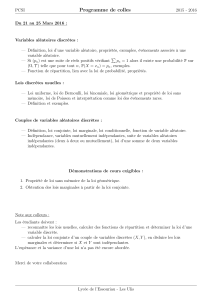

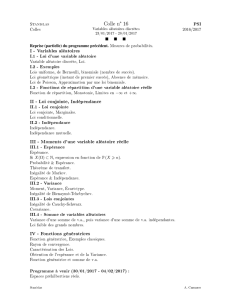

Compléments sur variables aléatoires réelles Probabilités chapitre 1

Compléments sur variables aléatoires réelles Probabilités chapitre 1

Dans ce chapitre (

,

A

) désigne un espace probabilisable.

Le but de ce chapitre est de généraliser les notions de variables aléatoires étudiées en cours de 1ère année dans le cas discret et

d’obtenir d’autres façons de calculer l’espérance ou la variance d’une variable aléatoire réelle discrète.

Rappeler la définition d’une

-algèbre ( ou tribu )

I Généralités sur les variables aléatoires réelles :

1. Tribu des Boréliens :

a. Définition :

La tribu B des Boréliens est la plus petite tribu de IR contenant les intervalles ouverts de IR.

b. Exercice :

Montrer que B contient tous les intervalles de IR. N’y a-t-il que ces ensembles dans la tribu borélienne ?

2. Variables aléatoires réelles :

a. Définition :

On appelle variable aléatoire réelle sur ( , A ) toute application X de dans IR telle que pour tout intervalle I de IR,

X-1(I) = { / X() I } = [ X I ] est élément de la tribu A.

b. Théorème (admis ) :

Soit X une variable aléatoire réelle sur ( , A). Pour tout borélien B, [ X B ] A

c. -algèbre associée à une variable aléatoire X

Soit X une variable aléatoire réelle sur ( , A , P ) . On appelle -algèbre associée à X la plus petite tribu contenant tous les

événements [ X ≤ x ] lorsque x parcourt ℝ. Elle représente l’information fournie par X.

Exemple : Donner la -algèbre associée à une loi de Bernoulli.

d. Opérations ( résultat admis ) :

La somme, les combinaisons linéaires et les produits de variables aléatoires sur ( , A ) sont des variables aléatoires réelles sur

(,A ).

Si X et Y sont deux variables aléatoires sur ( ,A) alors min(X,Y) et max(X,Y) sont des variables aléatoires réelles.

II Espérance et conditionnement pour les variables discrètes

1. Existence d’une espérance par domination

a. Rappel : existence et calcul de l’espérance d’une variable aléatoire réelle discrète

Une variable aléatoire réelle discrète X admet une espérance si et seulement si la série de terme général (k P[X=k])k X()

converge absolument et dans ce cas E(X) =

b. Existence par domination

Si X et Y sont deux variables aléatoires réelles discrètes vérifiant : 0 ≤ |X| ≤ Y presque sûrement et si Y admet une espérance

alors X admet une espérance et | E(X) | ≤ E(Y)

Résultat admis

Que signifie 0 ≤ |X| ≤ Y presque sûrement ?

c. Croissance de l’espérance

Si X et Y sont deux variables aléatoires discrètes sur ( , A , P ) telles que X ≤ Y et admettant une espérance alors E(X) ≤ E(Y)

Résultat admis

2. Espérance conditionnelle :

a. Définition :

Soit X une variable aléatoire réelle discrète sur ( , A , P ) et A un événement de probabilité non nulle. On dit que X admet

une espérance conditionnée par A si et seulement si X admet une espérance pour la probabilité conditionnelle PA.

Dans ce cas l’espérance de X conditionnée par A est E( X | A ) =

k X()

k PA( X = k ) = 1

P(A)

k X()

k P( [X=k] A )

b. Théorème :

Si une variable aléatoire réelle X discrète admet une espérance alors |X| admet une espérance et X admet une espérance

conditionnée par tout événement A de probabilité non nulle . De plus : | E( X | A ) | E(|X|)

P(A)

3. Formule de l’espérance totale :

Soit N une partie de IN. Soit X une variable aléatoire réelle discrète sur ( , A , P ) et ( An)nN un système complet ou presque

complet d’événements de probabilités non nulles.

X admet une espérance pour la probabilité P si et seulement si la série double de terme général ( k PAn[X=k] P(An) )k X(), n N

converge absolument.

Dans ce cas, E(X) =

Mise en application du théorème :

On note N une partie de IN et ( An )n

N un système complet ou presque complet d’événements de probabilités non nulles.

1er cas : si on sait que X admet une espérance

(Ce sera les cas où X() est fini ou aussi les cas où l’on connaît k P[X=k] terme général d’une série absolument convergente.)

Si X admet une espérance alors pour tout n N, X admet une espérance conditionnelle sachant An , la série de terme général

converge et : E(X) =

2ème cas : si on veut utiliser ce théorème sans connaître l’existence de E(X)

Il faudra raisonner en 2 temps :

1. Montrer pour tout n N, la convergence absolue de la série de terme général (k PAn[X=k])k X() et calculer E(X | An )

2. Montrer la convergence absolue de la série de terme général E(X | An ) P(An) et calculer E(X) =

4. Exercice :

On lance indéfiniment une pièce donnant pile avec la probabilité p ] 0 , 1 [ et face avec la probabilité q = ( 1-p).

On note r IN*.

On considère la variable aléatoire X égale au nombre de lancers nécessaires à l’obtention pour la première fois de r piles

consécutifs et Y la variable aléatoire égale au rang d’apparition du premier face. On suppose que X admet une espérance.

1.a . Montrer que X admet une espérance conditionnelle E( X | [Y>r] ) pour tout r IN* et la calculer.

b. Pour tout i 1 , r , exprimer E( X | [Y=i] ) en fonction de E(X).

2. Montrer que P(Y > r ) = pr.

3. En déduire l’expression de E(X) en fonction de p et de r.

Réponse :

1.a. On cherche la loi de X sachant [ Y > r ].

Si [ Y > r ] est réalisé alors on a obtenu r piles consécutifs dès les r premiers jets donc X est constante égale à r et E(X | [ Y > r ]) = r

b. On cherche la loi de X sachant [ Y = i ] , i

1 , r

:

Si [ Y = i ] est réalisé alors [X

i+r] est réalisé. Notons Ai,r : « obtenir à partir du (i+1)ème jet , le rème pile consécutif au kème jet pour la première fois »

k

i+r , +

, P[Y=i][X=k] = P(X=k-i) car la réalisation de Fi fait que l’expérience se retrouve dans les conditions du départ après le ième j avec i jets

de moins à effectuer pour réaliser [X=k] donc la loi conditionnelle de X sachant [ Y = i ] est la loi de ( X + i )

E( X | [Y=i] ) = E(X+i) = i + E(X) ( linéarité de l’espérance )

2. [ Y > r ] = F1

…

Fr et par indépendance des jets, P(Y>r) = P( F1 )… P( Fr ) = p r

3. X admet une espérance par hypothèse donc d’après la formule de l’espérance totale avec le système complet d’événements { [Y=i]1

i

r , [Y>r]} :

E(X)= E(X | [Y>r]) P(Y>r) +

i=1

r

E(X | [Y=i] ) P(Y=i) = r pr +

i=1

r

(i + E(X) ) pi-1 q ( avec q = 1-p)

E(X) = r pr + q

i=1

r

i pi-1 + E(X) ( 1 – pr ) = r pr + q d( (1 - pr+1) / (1-p) )

dp + E(X) ( 1-pr) = r pr + - (r+1)pr q + 1 - pr+1

q + E(X) ( 1- pr)

Donc E(X) = 1 - pr+1

q pr - 1 = 1 - pr

(1-p) pr

III Couples de variables aléatoires :

1. Définition

Soient X et Y deux variables aléatoires réelles sur un espace probabilisé ( , A , P ) .

On appelle loi du couple (X,Y), la fonction F(X,Y) : ℝ² [ 0 , 1 ] , (x,y) P[ (X ≤ x ) (Y ≤ y ) ]

2. Cas de l’indépendance

a. Définition

Deux variables aléatoires X et Y sur ( , A ,P ) sont indépendantes si et seulement si pour tous intervalles I et J de ℝ,

P[ (X I ) (Y J ) ] = P[X I ] P[ Y J ]

b. Exemple :

Soient X et Y deux variables aléatoires indépendantes de même loi géométrique de paramètre p

p ]0 ,1[ . Donner la loi de Z = max(X,Y)

Z(

) = IN*

k

IN*, P(Z=k) = P([X=k]

[Y

k]) + P([X<k]

[Y=k]) = pqk-1 p

i=1

k

qi-1 + p qk-1 p

i=1

k-1

qi-1 = p²qk-1 2 - qk - qk-1

1-q = p qk-1 ( 2 – qk-1 + qk )

3. Loi d’un couple de variables aléatoires indépendantes

Si X et Y sont deux variables indépendantes alors la loi du couple (X,Y) vérifie :

x,y ℝ, F(X,Y) (x,y) = FX(x) FY(y) = P[ ( X ≤ x ) ( Y ≤ y ) ] = P[ X ≤ x ] . P [ Y ≤ y ]

IV Couples de variables aléatoires discrètes

1. Caractérisation de la loi

a. Théorème

Soit ( X , Y ) un couple discret de variables aléatoires réelles

La loi de probabilité du couple ( X , Y ) ou loi conjointe de X et Y est caractérisée par la donnée de l’application :

X() X Y() [ 0 , 1 ] ; ( x , y ) P [( X =x ) ( Y =y )]

b. Exemples

Ex1 : On considère deux urnes U1 et U2 contenant chacune trois jetons numérotés de 1 à 3.On tire au hasard un jeton de chaque urne.

On note X le plus petit des deux numéros tirés , Y le plus grand et Xi le numéro du jeton tiré dans l’urne Ui

Définir par des tableaux la loi du couple ( X , Y ) et la loi du couple ( X1 , X2 )

Ex2 : On lance un dé non truqué indéfiniment.

X est égal au rang d’apparition du premier six , Y est égal au rang d’apparition du second six

Définir la loi de probabilité du couple ( X , Y )

2. Cas de l’indépendance

a. Caractérisation dans le cas discret

Deux variables aléatoires discrètes X et Y sont indépendantes si et seulement si :

x X() , y Y() , P[ ( X=x) (Y=y) ] = P[ X = x ] . P [ Y = y ].

b. Exemple

Etudier l’indépendance des variables aléatoires (X,Y) et (X1,X2) de l’exemple 1 du § IV1b

3. Fonction d’un couple aléatoire : loi

a. Loi de g(X,Y) :

Soient (X,Y) un couple aléatoire discret et g une fonction de IR² dans IR définie sur X() x Y().

La loi de Z = g(X,Y) est définie par : k Z() , P[ Z = k ] =

i X(), j Y(), g(i,j) = k

P([X=i] [Y=j] )

b. Loi d’une somme :

On pose Z = X + Y

k Z ( ) , P ( X + Y = k ) =

i X ( ) , k-i Y()

P [ ( X = i) (Y = k-i) ]

c. Loi d’une somme de deux variables aléatoires indépendantes :

Si X et Y sont indépendantes alors la loi de Z = X + Y est donnée par la formule :

k Z(), P[ Z = k ] =

i X ( ) , k-i Y()

P [ X = i ] P [ Y = k-i ]

Cette somme s’appelle le produit de convolution des lois de X et Y.

Appliquer la formule dans le cas particulier où X(

) = Y(

) = IN

d. Exercice classique :

Soit X et Y deux variables aléatoires réelles à valeurs dans 0 , n où n IN*.

On appelle fonction génératrice de X la fonction polynomiale GX telle que : t IR, GX(t) =

i=0

n

P[X=i] ti

Calculer GX(1) . Exprimer E(X) en fonction de GX’.

Montrer que GX+Y = GX GY .

e. Stabilité de la somme des lois binomiales indépendantes :

Si X et Y sont deux variables aléatoires indépendantes de lois respectives B(n,p) et B(m,p) où p ] 0,1[ et m , n IN* alors

X+Y suit la loi binomiale B(n+m,p)

f. Stabilité de la somme des lois de Poisson indépendantes :

Si X et Y sont deux variables aléatoires indépendantes de lois de Poisson P() et P() respectivement alors X+Y suit la loi de

Poisson P(+).

g. Exercice :

Etudier la loi d’une somme de deux variables indépendantes de lois géométriques de même paramètre p.

Etudier la loi d’une somme de deux variables indépendantes de loi uniforme sur 1,n et sur 1,m.

4. Fonction d’un couple aléatoire : espérance

a. Théorème de transfert :

Soient ( X , Y ) un couple de variables aléatoires discrètes

g une fonction définie sur X ( ) x Y ( ) à valeurs dans IR et Z = g ( X , Y )

Z admet une espérance si et seulement si la série double de terme général g(i,j) P([X=i] [Y=j]) converge

absolument. Dans ce cas : E ( Z ) =

(i,j) X ( ) x Y ( )

g(i,j) P( [X=i] [Y=j] )

Exercice :

Montrer que la série double de terme général ( (i+j) pi+j )i IN, j IN converge pour tout p [ 0 , 1 [ et calculer

Montrer que la relation : P[ (X=i) (Y=j) ] = 8

définit une loi de probabilité.

Montrer que Z =

admet une espérance et la calculer.

b. Linéarité de l’espérance :

Si X et Y sont deux variables aléatoires discrètes admettant une espérance

alors pour tout couple de réels (a , b) , a X + b Y admet une espérance et : E (a X + b Y) = a E (X) + b E (Y)

5. Fonction d’un couple aléatoire : variance

a. Variance d’une somme de deux variables aléatoires :

Si X et Y sont deux variables aléatoires discrètes admettant une variance

Alors X + Y admet une variance , XY admet une espérance et : V ( X + Y ) = V ( X ) + V ( Y ) + 2 [ E ( XY) – E (X) E(Y) ]

b. Cas des variables aléatoires indépendantes :

Si X et Y sont deux variables aléatoires indépendantes admettant une variance alors E ( XY ) = E(X) E(Y)

6. Covariance :

a. Définition

Soient X et Y deux variables aléatoires discrètes sur ( , T , P ) , admettant une variance

On appelle covariance du couple ( X , Y ) le réel : Cov ( X , Y ) = E[ (X-E(X)) ( Y-E(Y)) ]

b. Formule de Huygens

Si X et Y sont deux variables aléatoires discrètes admettant une variance alors Cov( X , Y ) = E(XY) – E(X) E(Y)

Exemple : Calculer après avoir prouvé son existence, cov(X,Y) dans le cas des variables X,Y définies dans l’exercice du paragraphe 4a.

c. Remarques

R1. Si X et Y sont des variables aléatoires discrètes indépendantes admettant une variance alors Cov ( X , Y ) = 0

La réciproque est fausse

R2. Si X , Y sont deux variables aléatoires discrètes admettant une variance alors V ( X + Y ) = V ( X ) + V ( Y ) + 2 Cov (X,Y)

6

6

1

/

6

100%