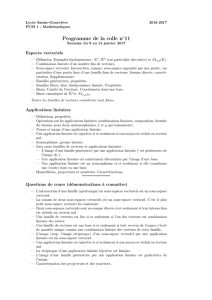

Algèbre linéaire de PCSI

Algèbre linéaire de PCSI

II - Structure d’espace vectoriel

Kdésigne Rou C.

1) Définition

On appelle K-espace vectoriel tout triplet (E, +, .)où :

1) Eest un ensemble dont les éléments sont appelés vecteurs.

2) +est une loi de composition interne sur Etelle que (E, +) soit un groupe abélien.

L’élément neutre 0est appelé vecteur nul.

3) .:K×E→E

(λ, x)→ λ.x

est une loi de composition externe vérifiant :

∗ ∀(λ, µ)∈K

2

∀x∈E(λ+µ).x =λ.x +µ.x ;

∗ ∀λ∈K∀(x, y)∈E λ.(x+y) = λ.x +λ.y ;

∗ ∀(λ, µ)∈K

2

∀x∈E λ.(µ.x) = (λµ).x ;

∗ ∀x∈E1.x =x.

Exemples : 1) (K,+, .)où . est la multiplication dans K.

2) L’ensemble E

D

des applications d’un ensemble Ddans un espace vectoriel E(les opéra-

tions dans E

D

étant définies grâce à celles de E:f+g:x→ f(x)+g(x);λ.f :x→ λ.f(x)).

2) Propriétés élémentaires

• ∀x∈E0.x = 0.

• ∀λ∈Kλ.0 = 0.

• ∀(λ, x)∈K×E λ.x = 0 ⇔(λ= 0 ou x= 0).

• ∀(λ, x)∈K×E(−λ).x =−(λ.x) = λ.(−x).

3) Espace vectoriel produit

Soit (E

k

,+, .)

1≤k≤n

une famille de K-espaces vectoriels.

L’ensemble E

1

× · · · × E

n

muni des lois +et .définies par :

•(x

1

, . . . , x

n

) + (y

1

, . . . , y

n

) = (x

1

+y

1

, . . . , x

n

+y

n

)

•λ.(x

1

, . . . , x

n

) = (λ.x

1

, . . . , λ.x

n

)

est un K-espace vectoriel, appelé espace vectoriel produit de E

1

, . . . , E

n

.

Exemples : 1) L’exemple canonique est K

n

.

2) Cs’identifie à R

2

en tant que R-espace vectoriel.

IIII - Sous-espaces vectoriels

Edésigne un K-espace vectoriel.

1) Définition

Soit Fune partie de E. On dit que Fest un sous-espace vectoriel de Esi et seulement si la restriction

de la loi +àF×Fet la restriction de la loi .àK×Finduisent sur Fune structure de K-espace

vectoriel.

Algèbre linéaire de PCSI Page 2

2) Caractérisations

Une partie Fde Eest un sous-espace vectoriel de Esi et seulement si

•0∈Fet

∀(x, y)∈F

2

x+y∈Fet

∀(λ, x)∈K×F λ.x ∈F;

ou bien

•0∈Fet

∀λ∈K∀(x, y)∈F

2

λ.x +y∈F.

3) Intersection de sous-espaces vectoriels

Théorème : l’intersection d’une famille quelconque de sous-espaces vectoriels de Eest un sous-espace

vectoriel de E.

Attention ! En général, l’union de deux sous-espaces vectoriels de En’est pas un sous-espace vectoriel

de E(c’en est un si et seulement si l’un des deux sous-espaces considérés est inclus dans

l’autre...).

4) Sous-espace engendré par une partie ou une famille

Soit Aune partie de E. On appelle sous-espace vectoriel engendré par Al’intersection de tous les

sous-espaces vectoriels de Econtenant A, notée Vect A.

Vect Aest le plus petit (au sens de l’inclusion) des sous-espaces de Econtenant A.

Vect Aest l’ensemble formé du vecteur nul et des vecteurs de la forme

p

k=1

λ

k

.a

k

, où les λ

k

sont des

scalaires et les a

k

des vecteurs de A(Vect ∅={0}).

Si (x

i

)

i∈I

est une famille de vecteurs de E, on note Vect (x

i

)

i∈I

les sous-espace engendré par la partie

{x

i

, i ∈I}.

5) Somme de deux sous-espaces vectoriels

Définition : soient Fet Gdeux sous-espaces vectoriels de E, on appelle somme de Fet Gla partie

de Enotée F+Gdéfinie par : F+G={x∈E / ∃(y, z)∈F×G x =y+z}.

Théorème : F+Gest un sous-espace vectoriel de E. C’est le plus petit sous-espace vectoriel de E

contenant Fet G(autrement dit F+G= Vect (F∪G)).

6) Sous-espaces vectoriels supplémentaires

Définition : deux sous-espaces vectoriels Fet Gde Esont dits supplémentaires dans Esi et seulement

si tout vecteur de Ese décompose de façon unique comme somme d’un vecteur de Fet

d’un vecteur de G, c’est-à-dire si et seulement si :

∀x∈E∃!(y, z)∈F×G x =y+z .

Théorème : les assertions suivantes sont équivalentes :

a) Fet Gsont supplémentaires dans E.

b) E⊂F+Get F∩G={0}.

Attention ! Ne pas confondre un supplémentaire et le complémentaire. Si xest un vecteur de Equi

n’appartient pas à F,xn’est pas pour autant nécessairement dans G! On peut seulement

affirmer a priori que xs’écrit y+z, avec (y, z)∈F×Get z= 0. . .

Algèbre linéaire de PCSI Page 3

IIIIII - Translations, sous-espaces affines (hors programme en PCSI)

Soit Eun K-espace vectoriel.

1) Translations

Définition : pour tout vecteur ade E, on appelle translation de vecteur al’application τ

a

:v→ a+v,

de Edans E.

Propriétés : 1) τ

0

= Id

E

et ∀(a, b)∈E

2

τ

a

◦τ

b

=τ

a+b

.

2) Pour tout ade E,τ

a

est bijective et τ

−1

a

=τ

−a

.

2) Sous-espaces affines

Définition : on appelle sous-espace affine de Etoute partie Wde Ede la forme a+F, où Fest un

sous-espace vectoriel de Eet où l’on note :

a+F=τ

a

(F) = {a+v, v ∈F}

Exemples : 1) Pour tout ade E,a+{0}={a}.

2) Pour vvecteur non nul de E, et a∈E,a+ Vect vest la droite affine passant par a

dirigée par v.

Théorème et définition : soit W=a+Fun sous-espace affine de E; alors pour tout bde W, on a

W=b+F; par contre, le sous-espace vectoriel Fest unique, on l’appelle

la direction de W.

NB : dans un contexte géométrique, les éléments de Esont aussi appelés points.

Aet Bétant deux points de E,−−→

AB =B−Aest appelé vecteur d’origine Aet d’extrémité B.

Ainsi, vétant un vecteur de E,B=A+v=τ

v

(A)équivaut à −−→

AB =v.

IVIV - Applications linéaires

1) Définition

Soient Eet Fdeux K-espaces vectoriels et uune application de Edans F.

On dit que uest linéaire (ou encore un morphisme d’espaces vectoriels) si et seulement si :

∀(x, y)∈E

2

u(x+y) = u(x) + u(y)

∀λ∈K∀x∈E u(λ.x) = λ.u(x)

(ou bien :∀λ∈K∀(x, y)∈E

2

u(λ.x +y) = λ.u(x) + u(y))

Si, de plus :

•uest bijective, on dit que uest un isomorphisme (Eet Fsont dits isomorphes) ;

•E=F, on dit que uest un endomorphisme de E;

•E=Fet ubijective, on dit que uest un automorphisme de E;

•F=K, on dit que uest une forme linéaire sur E.

Notations : on désigne par

• L(E, F )l’ensemble des applications linéaires de Edans F;

• L(E)l’ensemble des endomorphismes de E(Id

E

∈ L (E)).

Propriétés : soit u∈ L(E, F ).

1) u(0

E

) = 0

F

.

2) Si E

′

est un sous-espace vectoriel de E, alors u(E

′

)est un sous-espace vectoriel de F.

3) Si F

′

est un sous-espace vectoriel de F, alors u

−1

(F

′

)est un sous-espace vectoriel de E.

Algèbre linéaire de PCSI Page 4

2) Image

Définition : soit u∈ L(E, F ). On appelle image de ule sous-espace u(E)de Fnoté Im u:

Im u={y∈F / ∃x∈E u(x) = y}={u(x), x ∈E}.

Propriété : uest surjective si et seulement si Im u=F.

3) Noyau

Définition : soit u∈ L(E, F ). On appelle noyau de ule sous-espace u

−1

({0

F

})de Enoté Ker u:

Ker u={x∈E / u(x) = 0

F

}.

Propriété : uest injective si et seulement si Ker u={0

E

}

(ou encore si et seulement si : ∀x∈E u(x) = 0

F

⇒x= 0

E

).

4) Équations linéaires

Étant donnés udans L(E, F )et bdans F, la résolution de l’équation linéaire u(x) = best la recherche

de l’ensemble Sdes vecteurs xde Etels que u(x) = b.

Sest vide si et seulement si bn’appartient pas à Im u.

Lorsque best dans Im u,Sest non vide et pour tout x

0

dans S,Sest l’ensemble des vecteurs de Ede

la forme x

0

+z,zdécrivant Ker u:

S=x

0

+ Ker u={x

0

+z, z ∈Ker u}.

5) Exemples fondamentaux d’isomorphismes

•Tous les supplémentaires dans Ed’un même sous-espace vectoriel de Esont isomorphes.

•Soit u∈ L(E, F ). Tout supplémentaire de Ker udans Eest isomorphe à Im u.

•Soient Fet Gdeux sous-espaces vectoriels de E. L’application ϕ:F×G−→ F+G

(y, z)−→ y+z

est

linéaire surjective. C’est un isomorphisme si et seulement si F∩G={0}.

6) Opérations sur les applications linéaires

a) Structure de L(E, F )

Si Eet Fsont deux K-espaces vectoriels, alors (L(E, F ),+, .)est un K-espace vectoriel.

b) Composition des applications linéaires

Si E, F, G sont des K-espaces vectoriels et si u∈ L (E, F ),v∈ L (F, G), alors v◦u∈ L (E, G).

Pour φfixé dans L(E, F ), l’application v→ v◦φest une application linéaire de L(F, G)dans L(E, G).

Pour ψfixé dans L(F, G), l’application u→ ψ◦uest une application linéaire de L(E, F )dans L(E, G).

Théorème : si uest un isomorphisme de Edans F, alors u

−1

est linéaire (donc un isomorphisme) de

Fdans E.

c) Structure de L(E)

Si Eest un K-espace vectoriel, alors (L(E),+, ., ◦)est une K-algèbre.

Théorème et définition : soit GL(E)l’ensemble des automorphismes de E.(GL(E),◦)est un groupe

(non abélien en général), appelé groupe linéaire de E.

Algèbre linéaire de PCSI Page 5

VV - Projecteurs et symétries

1) Projecteurs

Définition : soient Fet Gdeux sous-espaces supplémentaires de E; l’application pde Edans Equi

à tout vecteur xde Eassocie le vecteur yde Ftel que x=y+zavec (y, z)∈F×Gest

appelée projecteur (ou projection vectorielle) de Esur Fparallèlement à G.

Propriétés : soit ple projecteur de Esur Fparallèlement à G.

a) pest un endomorphisme de E.

b) Ker p=Get Im p=F;Fest l’ensemble des vecteurs invariants par p.

c) Id

E

−pest le projecteur de Esur Gparallèlement à F.

Caractérisation : soit p∈ L(E).pest un projecteur si et seulement si p◦p=p.

Dans ce cas, pest le projecteur de Esur Im pparallèlement à Ker p.

2) Symétries vectorielles

Définition : soient Fet Gdeux sous-espaces supplémentaires de E; l’application sde Edans Equi

à tout vecteur xde Eassocie le vecteur y−zde Eoù (y, z)est le couple de F×Gtel

que x=y+zest appelée symétrie vectorielle par rapport à Fparallèlement à G.

Propriétés : soit sla symétrie vectorielle par rapport à Fparallèlement à G.

a) sest un automorphisme involutif de E.

b) L’ensemble des vecteurs invariants par sest F; l’ensemble des vecteurs transformés

en leur opposé est G.

c) −sest la symétrie vectorielle par rapport à Gparallèlement à F.

d) Si pest le projecteur de Esur Fparallèlement à G, on a les relations :

s= 2p−Id

E

, p =1

2·(Id

E

+s).

Caractérisation : soit s∈ L(E).sest une symétrie vectorielle si et seulement si s◦s= Id

E

.

Alors sest la symétrie par rapport à F={x∈E / s(x) = x}= Ker (s−Id

E

)

parallèlement à G={x∈E / s(x) = −x}= Ker (s+ Id

E

).

VIVI - Familles libres, génératrices ; bases

1) Familles génératrices

Définition : soit F= (x

i

)

i∈I

une famille finie de vecteurs de E. On dit qu’un vecteur xde Eest

combinaison linéaire des vecteurs de Fsi et seulement s’il existe une famille (λ

i

)

i∈I

∈K

I

telle que x=

i∈I

λ

i

.x

i

.

Définition : soit Fune famille finie de vecteurs de E. On dit que Fest une famille génératrice de

Esi et seulement si tout vecteur de Eest combinaison linéaire des vecteurs de F(i.e.

Vect F=E).

Propriétés : 1) Toute sur-famille d’une famille génératrice est génératrice.

2) Soit (x

i

)

i∈I

une famille finie, génératrice de Eet June partie de I.(x

i

)

i∈J

est aussi

une famille génératrice de Esi et seulement si, pour tout kde I\J,x

k

est combinaison

linéaire des vecteurs de (x

i

)

i∈J

.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

1

/

15

100%