Ensemble fondamental et événements Probabilité Probabilités

Plan

Ensemble fondamental et événements

Probabilité

Probabilités conditionnelles

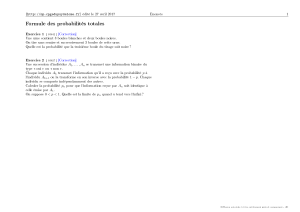

Formules des probabilités totales

Loi de Bayes

Sources :

Initiation aux probabilit´

es,Sheldon Ross, édité aux Presses

Polytechniques et universitaires romanes, 1994

All of Statistics, Larry Wasserman, Springer, 2004

Probabilit´

es – p. 1/49

Ensemble fondamental

On considère une expérience dont l’issue n’est pas prévisible

mais dont l’ensemble des résultats possibles (on dit aussi

issues) est connu et appelé ensemble fondamental, noté Ω.

Exemples :

si le résultat de l’expérience équivaut à la détermination

du sexe d’un nouveau né, alors :

Ω = {g, f}

si le résultat est l’ordre d’arrivée d’une course entre 7

chevaux numérotés de 1à7, alors :

Ω = {toutes les permutations de 1 ... 7}

Probabilit´

es – p. 2/49

Evénement

Tout sous-ensemble Ede Ωest appelé un ´

ev´

enement.

Si le résultat de l’expérience est compris dans E, alors on dit

que Eest r´

ealis´

e.

Exemples :

Dans le premier exemple, si E={g}alors Eest

l’événement l’enfant est un garc¸on.

Dans le second exemple, si

E={tous les résultats de Ωcommençant par 3}alors E

correspond à l’événement le cheval 3 remporte la course.

Probabilit´

es – p. 3/49

Epreuve de Bernouilli

une épreuve de Bernoulli de paramètre 0≥p≥1est une

expérience aléatoire (c’est-à-dire soumise au hasard)

comportant deux issues : le succès ou l’échec

Le réel preprésente la probabilité d’un succès et le réel

1−preprésente la probabilité d’un échec.

La définition du succ`

es et de l’´

echec est conventionnelle et

est fonction des conditions de l’expérience.

Exemple Le lancer d’une pièce équilibrée est une

expérience de Bernoulli de paramètre 0,5. Si le succ`

es est

l’obtention de pile, l’´

echec sera l’obtention de face.

Probabilit´

es – p. 4/49

Opérations sur les événements

Un événement étant un ensemble, on peut combiner des

événements grâce aux opérateurs ensemblistes :

Union

intersection

complémentation

Probabilit´

es – p. 5/49

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

1

/

49

100%