Espaces collaboratifs, métaphores graphiques et exploration visuelle

RENCONTRES RIC’2006

Intelligence collective

Nîmes, 22-24 mai 2006

Site EERIE de l’Ecole des mines d’Alès

Dans le prolongement des conférences

NîmesTIC’2000

,

NîmesTIC’2001

, et des

Journées

IC’2004

, les rencontres

RIC’2006

ont été organisées à Nîmes par le

centre de recherche

LGI2P

de l’Ecole des Mines d’Alès en collaboration avec les

centres de recherche

CERIC

et

LIRMM

de l’Université de Montpellier et avec la

participation de la

FING

- Fondation Internet Nouvelle Génération.

Le thème des rencontres est la coopération intellectuelle entre acteurs humains

dans un environnement techniquement augmenté.

Comité scientifique : Bruno

BACHIMONT

, Godefroy

BEAUVALLET

, Yann

BERTACCHINI

, Olivier

BOISSIER

, Pierre

BOMMEL

, Paul

BOURGINE

, Robert

BOURRE

, Vincent

CHEVRIER

, Philippe

DURANCE

, André

DEMAILLY

, Rose

DIENG

,

Jean-

François

DORTIER

, Serge

GARLATTI

, Norbert

GIAMBIASI

, Pierre-Léonard

HARVEY

, Francis

LAPIQUE

, Matthieu

LATAPY

, Dominique

LESTEL

, Pierre

LEVY

,

Anne

MAYERE

, Guy

MELANCON

, Michel

MOATTI

, Alex

MUCCHIELLI

, Jean-Pierre

MÜLLER

, Hélène

PIGOT

, Serge

PROULX

, Louis

QUERE

, Pascal

ROBERT

, Yves

ROUCHALEAU

, Dany

TROM

.

Comité de programme : Eric

AUZIOL

, Monique

COMMANDRE

, Jean-michel

CORNU

, Michel

CRAMPES

, Daniel

DIEP

, Emmanuelle

JACQUES

, Arnaud

KLEIN

,

Serge-André

MAHE

, Eunika

MERCIER

-

LAURENT

, Jean Michel

PENALVA

, Joël

QUINQUETON

, Pierre-Michel

RICCIO

.

Comité de rédaction : Jean Michel

PENALVA

, Pierre-Michel

RICCIO

, Silvia

DEKORSY

.

Organisation et communication : Françoise

ARMAND

, Sylvie

CRUVELLIER

,

Pierre

JEAN

, Patricia

RONDEAU

, Azucena

SANCHEZ

, Elisabeth

SANSOT

.

2 Intelligence collective : Rencontres 2006

L’intelligence collective peut être considérée comme une hypothèse relative à la

capacité d’un groupe d’acteurs humains et d’agents artificiels à atteindre dans

une action commune une performance supérieure à l’addition des performances

individuelles.

C’est sur cette conjecture que les chercheurs du groupe

CYCLONE

ont décidé

d’unir leurs compétences et leurs expériences, afin d’explorer un champ de

recherche qui s’est vite révélé multi-disciplinaire.

Sciences cognitives, sciences de l’information et de la communication, sciences

humaines et sociales trouvent ici l’occasion de fructueuses confrontations et

transpositions, alors même que le débat s’enrichit de points de vue radicalement

différents : l’intelligence collective est considérée par certains comme un enjeu

stratégique, pour les organisations, les entreprises, les territoires, alors que

d’autres y voient une idée séduisante, mais relevant plus du mythe que de la

réalité.

L’idée de l’intelligence collective trouve des fondements dans le monde animal,

où par exemple, les insectes démontrent l’efficacité de comportements collectifs.

Ces observations sont d’ailleurs une source d’inspiration féconde en intelligence

artificielle, qui a trouvé ici, non seulement des solutions originales à des

problèmes difficiles, mais également des modèles pour des univers multi-agents,

simulés ou mis en pratique en robotique.

Mais l’idée de l’intelligence collective tiendra-t-elle ses promesses dans les

organisations humaines, en profitant du support des technologies du web et des

réseaux ? Les expériences de terrain permettent-elles aujourd’hui de dégager

des modèles opérationnels ? Une approche inter-disciplinaire apparaît comme la

seule voie réaliste pour répondre à ces questions essentielles.

C’est cette interrogation qui a convaincu les chercheurs du groupe

CYCLONE

d’organiser un rendez-vous pour les chercheurs intéressés par ces questions.

Les rencontres RIC’2006 sont ainsi nées de cette volonté d’échange entre

individus de disciplines différentes.

Cet ouvrage a pour ambition de rendre compte de cette diversité en cinq

chapitres. Carte blanche a été donnée aux membres du comité scientifiques qui

ont souhaité apporter un point de vue personnel sur le sujet ; sept conférenciers

de renom ont répondu à notre invitation pour apporter leurs éclairages et initier

les échanges. Huit communications ont été sélectionnées par le comité

scientifique afin de présenter des approches et des expériences concrètes.

Enfin, deux derniers chapitres restituent des réflexions et des résultats élaborés

ces dernières années par le groupe Intelligence collective de la Fondation

Internet Nouvelle Génération, et le projet de recherche

CYCLONE

.

Jean Michel Penalva

Coordonnateur de l’ouvrage

INTELLIGENCE COLLECTIVE

Rencontres 2006

Ouvrage coordonné par Jean Michel Penalva

SOMMAIRE

I - Cartes blanches au comite scientifique RIC’2006

Yann Bertacchini

Intelligence territoriale Posture théorique, hypothèses, définition................... 9

André Demailly

L’intelligence collective, entre « crochets célestes » et « grues terrestres » .. 17

Francis Lapique

Pour un observatoire-pilote............................................................................. 27

Anne Mayere

L’intelligence collective : une notion en chantier............................................. 31

Guy Melançon

Espaces collaboratifs, métaphores graphiques et exploration visuelle........... 37

Michel Moatti

Acteurs sociaux, pensée commune et croyances collectives sur les domaines

virtuels............................................................................................................. 43

Pascal Robert

Les technologies intellectuelles entre théorie et politique............................... 47

4 Intelligence collective : Rencontres 2006

II - Conférences RIC’2006

Bruno Bachimont

Support de connaissance et intelligence collective

héritage et individuation technique.................................................................. 55

Jean-François Dortier

Des fourmis à Internet Le mythe de l’intelligence collective............................ 69

Pierre-Leonard Harvey

Design communautique et coopération organisationnelle .............................. 81

Dominique Lestel

Remarques sur l’Evolution de la Bêtise........................................................... 109

Pierre Levy

IEML : finalités et structure fondamentale....................................................... 117

Serge Proulx

Pratiques de coopération et éthique du partage............................................. 137

Louis Quere

Confiance et intelligence collective................................................................. 153

III – Communications RIC’2006

Evelyne Biausser

Le projet en environnement complexe comme émergence d’intelligence

collective ......................................................................................................... 163

Daniel Chamberland-Tremblay

La médiation par l'espace intelligent, collaboration et communauté de soins à

l'intérieur du domicile....................................................................................... 175

Michèle Dreschler

Quels changements induits par les TIC pour la formation professionnelle des

enseignants face au paradigme du KM et des communautés de pratiques ? .189

Catherine Fekrane

SMTIE, une opération d’intelligence collective à destination des PME :

application au pôle de compétitivité MER PACA............................................. 207

Sommaire 5

Yvan Renou

Sous-traitance d’intelligence et instrumentation socio-technique

vers une théorie de « l’espace de coordination »............................................ 221

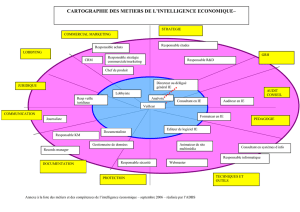

David Salvetat

Les pratiques d’intelligence économique dans les entreprises européennes de

hautes technologies........................................................................................ 239

Jean-Marie Simonnet

La forme organisationnelle : Réseaux informels

cadre de l’échange d’information et gestion du risque.................................... 253

Olfa Zaibet

Collectifs de travail et intelligence collective ................................................... 267

IV - Atelier FING RIC’2006

Godefroy Beauvallée

Le groupe « Intelligence Collective » de la FING............................................ 293

Jean-Michel Cornu

Les thèmes de travail du groupe Intelligence Collective de la FING............... 295

Philippe Durance

Auto-organisation et réflexivité des organisations comme fondements de

l’intelligence collective..................................................................................... 301

Arnaud Klein

Séminaire Internet et nouvelles technologies

Master Sciences de l’Information et des Médias............................................. 311

V - Atelier CYCLONE RIC’2006

Emmanuelle Jacques

La conception numérique, entre espace intime et monstration

A la recherche des intelligences collectives.................................................... 321

Serge-André Mahé

Phénoménologie de l'intelligence collective le projet CYCLONE.................... 335

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

1

/

75

100%