Test d`hypothèse

Test d'hypothèse 1

Test d'hypothèse

En statistiques, un test d'hypothèse est une démarche consistant à rejeter (ou plus rarement à accepter) une

hypothèse statistique, appelée hypothèse nulle, en fonction d'un jeu de données (échantillon).

On cherche par exemple à tester si un certain paramètre , qui peut par exemple être la valeur moyenne d'une

grandeur, prend une certaine valeur . L'hypothèse nulle dans ce cas est «…la moyenne vaut …» et l'hypothèse

contraire sera «…la moyenne est différente de …».

Risque de première espèce et de deuxième espèce

Une notion fondamentale concernant les tests est la probabilité que l'on a de se tromper. Dans l'idéal on souhaiterait

avoir un test qui renvoie toujours le "bon" résultat. Par exemple on aimerait avoir un test qui choisisse toujours

l'hypothèse nulle lorsque celle-ci est vérifiée et qui rejette tout le temps l'hypothèse nulle lorsque celle-ci est fausse.

Il y a deux façons de se tromper lors d'un test statistique:

• la possibilité de rejeter à tort l'hypothèse nulle lorsqu'elle est vraie. On appelle ce risque le risque de première

espèce et en général on note la probabilité de se tromper dans ce sens. est alors la probabilité d'avoir un

faux positif : de rejeter une hypothèse alors qu'en fait elle était vraie.

• la possibilité d'accepter à tort l'hypothèse nulle lorsqu'elle est fausse. On appelle ce risque le risque de

deuxième espèce et en général on note la probabilité de se tromper dans ce sens. est alors la probabilité

d'avoir un faux négatif : d'accepter une hypothèse alors qu'en fait elle était fausse.

Dans l'idéal on aimerait bien que ces deux erreurs soient nulles, malheureusement ce n'est pas possible, en tout cas

lorsque l'on ne dispose que d'un nombre fini d'observations, et il faut alors faire un choix.

Tests classiques et tests bayésiens

Pour les tests classiques qui constituent l'essentiel des tests statistiques, ces deux erreurs jouent un rôle asymétrique.

On contrôle uniquement le risque de première espèce à un niveau (principe de Neyman); cela revient à considérer

que le risque de rejeter l'hypothèse nulle alors que cette hypothèse est vraie est beaucoup plus coûteux que celui de la

conserver à tort (ce dernier risque n'étant pas maîtrisé).

Pour les tests bayésiens on peut parfois pondérer ces deux risques grâce à la connaissance d'une probabilité a priori.

La connaissance de cette probabilité a priori est l'un des fondements de la statistiques bayésienne et constitue l'une de

ses difficultés majeures. Si on cherche par exemple à tester le fait qu'un certain paramètre vaut une certaine valeur

cette probabilité a priori sera une loi de probabilité sur qui donne la probabilité que l'on a d'observer . Cette

loi a priori est également appelée croyance a priori ou croyance bayésienne. Ces tests sont souvent d'une mise en

œuvre plus complexe que les tests statistiques la raison principale est qu'ils nécessitent de "trouver" une bonne loi a

priori puis de la réviser grâce à la révision des croyances.

Test d'hypothèse 2

Classification

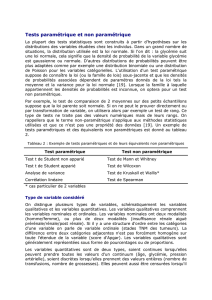

D'ordinaire on range les tests dans deux catégories les tests paramétriques et les tests non paramétriques. Les

premiers testent la valeur d'un certain paramètre. Ces tests sont généralement les tests les plus simples. Les tests non

paramétriques quant à eux ne font pas intervenir de paramètre. C'est par exemple le cas des tests d'adéquation à une

loi ou des Test du χ².

On peut également distinguer les tests d'homogénéité et les tests d'adéquations:

• Dans le cas d'un test d'homogénéité, on veut comparer deux échantillons entre eux. L'hypothèse nulle H0

supposera l'homogénéité des deux échantillons. Par exemple on comparera deux moyennes.

• Dans le cas d'un test d'adéquation, on veut déterminer si un échantillon suit une loi statistique connue.

L'hypothèse nulle H0 supposera l'adéquation de l'échantillon à cette loi.

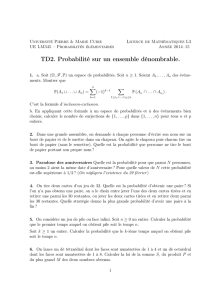

Déroulement d'un test

Pour le cas spécifique d'un test unilatéral, le test suit une succession d'étapes définies:

1. Énoncé de l'hypothèse nulle H0 et de l'hypothèse alternative H1.

2. Calcul d'une variable de décision correspondant à une mesure de la distance entre les deux échantillons dans le

cas de l'homogénéité, ou entre l'échantillon et la loi statistique dans le cas de la conformité. Plus cette distance

sera grande et moins l'hypothèse nulle H0 sera probable. En règle générale, cette variable de décision se base sur

une statistique qui se calcule à partir des observations. Par exemple, la variable de décision pour un test unilatéral

correspond à rejeter l'hypothèse nulle si la statistique dépasse une certaine valeur fixée en fonction du risque de

première espèce.

3. Calcul de la probabilité, en supposant que H0 est vraie, d'obtenir une valeur de la variable de décision au moins

aussi grande que la valeur de la statistique que l'on a obtenue avec notre échantillon. Cette probabilité est appelée

la valeur p (p-value).

4. Conclusion du test, en fonction d'un risque seuil αseuil, en dessous duquel on est prêt à rejeter H0. Souvent, un

risque de 5% est considéré comme acceptable (c'est-à-dire que dans 5% des cas quand H0 est vraie,

l'expérimentateur se trompera et la rejettera). Mais le choix du seuil à employer dépendra de la certitude désirée et

de la vraisemblance des alternatives.

5. Si la valeur p est plus grande que on accepte l'hypothèse H0. Si la p-value est plus petite que on la rejette.

La probabilité pour que H0 soit acceptée alors qu'elle est fausse est β, le risque de deuxième espèce. C'est le risque de

ne pas rejeter H0 quand on devrait la rejeter. Sa valeur dépend du contexte, et est très difficilement évaluable (voire

impossible à évaluer), c'est pourquoi seul le risque α est utilisé comme critère de décision.

Tests classiques

Il existe de nombreux tests statistiques classiques parmi lesquels on peut citer :

• le test de Student, qui sert à la comparaison d'une moyenne observée avec une valeur « attendue ».

• le test de Fisher, aussi appelé test de Fisher-Snédécor, qui sert à la comparaison de deux variances observées.

• l'Analyse de la variance ou Anova, permet de comparer entre elles plusieurs moyennes observées (pour les

groupes étudiés), selon un plan expérimental prédéterminé. Elle se base sur une décomposition de la variance en

une partie « explicable » (variance inter-groupes) et une partie « erreur » (variance globale intragroupe - ou

variance résiduelle), supposée distribuée selon une loi normale. Ce test est particulièrement utilisé en sciences

humaines, sciences sociales, sciences cognitives, en médecine et en biologie.

• le test du χ², également appelé test du de Pearson, qui sert notamment à la comparaison d'un couple d'effectifs

observés, ou à la comparaison globale de plusieurs couples d'effectifs observés, et plus généralement à la

comparaison de deux distributions observées.

Test d'hypothèse 3

• le test de Kolmogorov-Smirnov, qui comme le test du constitue un test d'adéquation entre des échantillons

observés et une distribution de probabilité. Il compare la fonction de répartition observée et la fonction de

répartition attendue. Il est particulièrement utilisé pour les variables aléatoires continues.

En méthodes bayésiennes, on utilise le psi-test (mesure de distance dans l'espace des possibles) dont on démontre

que le test du représente une excellente approximation asymptotique lorsqu'il existe un grand nombre

d'observations.

Voir aussi

Articles connexes

• Plan d'expérience

• Test (statistique)

• Test de Jarque Bera

• Statistique mathématique

Liens externes

• R. Ramousse, M. Le Berre, L. Le Guelte, Inroduction aux statistiques [1], chapitres 1 à 5 (des mêmes auteurs, voir

aussi Une approche pragmatique de l'Analyse des données [2])

• R. Rakotomalala, Comparaison de populations - Tests paramétriques [3] et Comparaison de populations - Tests

non paramétriques [4]

• Tests non paramétriques sous Microsoft Excel [5]

• INRIA Rhône-Alpes SMEL - Statistique médicale en ligne [6], en particulier Tests Statistiques [7]

• D. Mouchiroud, Probabilité - Statistique [8], voir "Probabilités - Statistiques"

• J. Begin, Analyse quantitative en psychologie [9], voir "Notes de Cours"

Logiciels

• The R Project for Statistical Computing [10]

• Free Statistics [11], Logiciels gratuits de statistique

• Free Statistical Software [12]

• IMSL

Références

[1] http:/ / www. cons-dev. org/ elearning/ stat/ index. html

[2] http:/ / www. cons-dev. org/ elearning/ ando/ index. html

[3] http:/ / eric. univ-lyon2. fr/ ~ricco/ cours/ supports_data_mining. html#tests_parametriques

[4] http:/ / eric. univ-lyon2. fr/ ~ricco/ cours/ supports_data_mining. html#tests_non_parametriques

[5] http:/ / hdelboy. club. fr/ Nonparam. htm

[6] http:/ / www. math-info. univ-paris5. fr/ smel/

[7] http:/ / www. math-info. univ-paris5. fr/ smel/ cours/ ts/ ts. html

[8] http:/ / spiral. univ-lyon1. fr/ mathsv/

[9] http:/ / www. er. uqam. ca/ nobel/ r30574/ PSY1300/

[10] http:/ / www. r-project. org/

[11] http:/ / www. freestatistics. info/ fr/ stat. php

[12] http:/ / statpages. org/ javasta2. html

Sources et contributeurs de l'article 4

Sources et contributeurs de l'article

Test d'hypothèse …Source: http://fr.wikipedia.org/w/index.php?oldid=51925954 …Contributeurs: Akabob, Alkarex, Arnaudus, Badmood, Calimo, Cessna150, Courtiol, Cyril guilloud, Dodabe,

Ediacara, Eric Kvaalen, Frédéric Mahé, GL, Gbdivers, Godix, HB, Jct, Jerome66, Laddo, Lehalle, MichaelBlondin, Orphée, Pap, Pbouge, Rajive, Sam Hocevar, SebGR, Titzel, Valvino, Xic667,

50 modifications anonymes

Licence

Creative Commons Attribution-Share Alike 3.0 Unported

http:/ / creativecommons. org/ licenses/ by-sa/ 3. 0/

1

/

4

100%