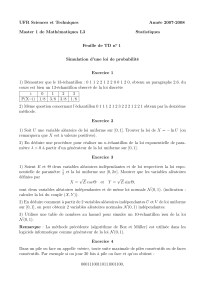

Oral 2015 Probabilités 1 1. On lance un dé non pipé

Oral 2015 Probabilités 1

1. On lance un dé non pipé autant de fois que nécessaire pour obtenir un 6.

Quelle est la loi du nombre Nde lancers nécessaires ? Quel est le nombre

moyen de lancers nécessaires (c’est-à-dire l’espérance de N) ?

2. On lance un dé non pipé autant de fois que nécessaire pour obtenir suc-

cessivement un 1 au 2n+1-ième lancer puis un 6 au 2n+2-ième lancer

(pour un certain n∈N∗). Quel est le nombre moyen de lancers néces-

saires ?

3. Soit Yune variable aléatoire à valeurs dans N. Montrer :

E(Y)=

+∞

X

n=1

P(Y≥n)

4. On lance un dé non pipé autant de fois que nécessaire pour obtenir suc-

cessivement un 1 puis un 6, puis on s’arrête. On note X1,X2,... les va-

riables aléatoires modélisant les résultats des lancers. On note Tle nombre

de lancers effectués.

(a) Montrer que Test d’espérance finie.

(b) On note, si t∈N∗,x(t)=P(T≥t) et y(t)=PX1=1(T≥t). Trouver des

réels a,b,c,dtels que

∀t≥3(x(t)=ax(t−1) +by(t)

y(t)=cx(t−2) +d y(t−1)

En déduire E(T).

5. Quel est le nombre moyen de lancers nécessaires pour obtenir successi-

vement deux 3 ?

1. On sait (cours, savoir le redémontrer) que Nsuit une loi géométrique G(1/6).

Donc son espérance est (cours, savoir le redémontrer.. .) 6.

2. On regroupe les lancers par deux : la probabilité d’obtenir (6,6) aux lancers

(2k+1,2k+2) (k≥0) est 1/36. On a donc encore affaire à une variable géomé-

trique de paramètre 1/36. Il faudra en moyenne 36 ”couples de lancers” pour

obtenir un (1,6). Donc 72 lancers.

3. Un grand classique. . .Partons de la sigma-additivité :

P(Y≥n)=

+∞

X

k=n

P(Y=k)=

+∞

X

k=1

un,k

où l’on note un,k=0 si k<n,un,k=P(Y=k) si k≥n(on restreint (k,n) à

N∗×N∗). Alors

(i) pour tout n,X

k

un,kconverge, et sa somme vaut P(Y≥n).

(ii) pour tout k,X

n

un,kconverge, et sa somme vaut kP(Y=k).

La caractérisation de la sommabilité par paquets (familles positives) montre

alors le résultat.

4. Le calcul du 2. montre que Test presque sûrement finie, et que son espé-

rance est finie (inférieure à 72). De plus, si t≥3,

P(T≥t)=P(X1=1)PX1=1(T≥t)+P(X16= 1)PX16=1(T≥t) relation qui s’inter-

prète comme

x(t)=5

6x(t−1) +1

6y(t)

et de même

PX1=1(T≥t)=P(X2=1)P(X1=1,X2=1)(T≥t)+P(X26∈ {1,6})P(X1=1,X26∈{1,6})(T≥t)

s’interprète comme

y(t)=1

6y(t−1) +2

3x(t−2)

Les familles xet ysont sommables ; on somme donc, on obtient

E(T)−1−1=5

6(E(T)−1)+1

6

+∞

X

t=3

y(t)

et +∞

X

t=3

y(t)=1

6

+∞

X

t=3

y(t)+1

6y(2) +2

3E(T)

Mais y(2) =1, on obtient donc l’équation

E(T)−2=5

6E(T)−5

6+1

5µ1

6+2

3E(T)¶

et finalement E(T)=36.

5. On reprend les calculs précédents, en changeant les notations : on note, si

t∈N∗,x(t)=P(T≥t) et y(t)=PX1=3(T≥t). La relation

x(t)=5

6x(t−1) +1

6y(t)

reste vraie, mais on a cette fois

y(t)=5

6x(t−2)

(avec toujours t≥3). Les calculs, analogues mais plus faciles, donnent E(T)=

42.

2

Oral 2015 Probabilités 2

1. On effectue des lancers successifs d’un dé (non pipé). On note bnla pro-

babilité pour que les lancers n−1 et ndonnent successivement un 1 puis

un 6. On note anla probabilité pour que les lancers n−1 et nsoient les

premiers lancers où l’on obtient successivement un 1 puis un 6. Définir

b0,a1,b1pour que

bn=

n

X

k=1

akbn−k

En utilisant les séries Panxnet Pbnxn, en déduire l’espérance du nombre

de lancers nécessaires pour obtenir successivement un 1 puis un 6.

2. Quelle est l’espérance nombre de lancers nécessaires pour obtenir suc-

cessivement deux 3 ?

Soit n=2 ; on a alors an=bn(la valeur commune étant 1/36), on prendra donc

b0=1. Si n=3, on a aussi an=bn, donc pour avoir

b3=a1b2+a2b1+a3b0

avec b0=1, on prendra a1=b1=0. On note alors Bnl’événement « les lancers

n−1 et ndonnent successivement 1 puis 6 » et Anl’événement « les lancers n−1

et nsont les premiers qui donnent successivement 1 puis 6 ». Alors, par formule

des probabilités totales (on a clairement Bn⊂A2∪A3. .. ∪Anet la réunion est

disjointe),

P(Bn)=

n

X

k=2

P(Ak)PAk(Bn)

or, par indépendance (implicitement supposée) des lancers, PAk(Bn)=bn−k

(k≤n), d’où

bn=

n

X

k=2

akbn−k=

n

X

k=0

akbn−k

en posant de plus a0=0.

Mais attention, la formule est fausse pour n=0 : b06= a0b0; elle est en revanche

vraie pour n=1 (0 =0). Par produit de Cauchy, on a donc

Ã+∞

X

k=0

bkxk−1!=Ã+∞

X

k=0

bkxk!Ã+∞

X

k=0

akxk!

Mais dès lors que n≥2, bn=1

36. Donc

+∞

X

k=0

akxk=x2

x2+36 ×(1 −x)

L’espérance cherchée est la dérivée de cette expression en 1. La dérivée vaut

2x(x2+36(1 −x)) −x2(2x−36)

(x2+36(1 −x))2

ce qui, pour x=1, donne la valeur 36.

Pour deux 3 consécutifs, le même genre de considérations fonctionne, mais on

prend b0=1 et b1=1/6, a0=a1=0 (on commence par explorer : b2=a2,b3=

a2×1/6 +a3,b4=a4+a3/6 +a2b2...). On obtient

+∞

X

n=0

anxn=

1

36

x2

1−x

1

36

x2

1−x+1+x

6

Et la dérivée en 1 vaut 42.

4

Oral 2015 Probabilités 3

Soit n≥2 et (Uk)k≥1une suite de variables aléatoires indépendantes et de loi

uniforme sur l’ensemble {1,...,n}. Ces variables modélisent, par exemple, les

résultats successifs d’un tirage au hasard et avec remise d’une boule parmi n

boules numérotées de 1 à n. Pour tout m≥1 et i∈{1,...,n} on note

X(m)

i=Card({k∈{1,... , m} ; Uk=i})=

m

X

k=1

1{Uk=i}

le nombre d’occurrences de la boule iobtenues dans les mpremiers tirages.

1. Quelle est la loi de X(m)

ipour i∈{1,...,n} et m≥1 fixés ?

2. Soit m≥1 et i,j∈{1,. . . , n} fixés, i6= j. Calculer la covariance des va-

riables aléatoires X(m)

iet X(m)

j. Sont-elles indépendantes ?

3. On suppose désormais qu’on effectue au total un nombre aléatoire Nde

tirages successifs avec remise, où Nsuit une loi de Poisson de paramètre

λ>0 et est indépendante de (Uk)k≥1. On pose

∀i∈{1,...,n}Yi=X(N)

i

avec par convention X(0)

i=0. Déterminer, en fonction de λet de n, la loi

de Yipour tout i∈{1,...,n}.

4. Déterminer la loi conjointe de (Y1,...,Yn)

La loi de X(m)

iest une loi B(m,1/n).

Calculons

E³X(m)

iX(m)

j´=EÃX

(k,`)∈1,m2

1{Uk=i}1{U`=j}!

=X

(k,`)∈1,m2

E¡1{Uk=i}∩{U`=j}¢

=X

(k,`)∈1,m2

P¡{Uk=i}∩{U`=j}¢

=X

(k,`)∈1,m2,k6=`

P(Uk=i)P(U`=j)

=(m2−m)×1

n2

Mais E(X(m)

i)E(X(m)

j)=³m

n´2. On en déduit

Cov(X(m)

i,X(n)

j)= − m

n2

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

1

/

21

100%