Laboratoire d`Analyse – Recherche en Economie Quantitative

26

Laréq

Jean – Paul Tsasa/ Chercheur co – accompli

Laboratoire

d’

Analyse

–

Recherche

en

Economie Quantitative

One pager

Août 2012

Vol. 3 – Num. 003

http://www.lareq.com

Paradigme Bayésien et Principe de Révision Bayésienne

Jean – Paul Tsasa V. Kimbambu

*

La controverse philosophique école classique versus école bayésienne

est finalement peu intéressante. Il faut faire un choix et le nôtre

est clair : c’est le paradigme bayésien.

Boreux – Parent – Bernier, 2010

Introduction

dynamique stochastique (DSGE) de la RD. Congo. Il présente dans un langage approprié les principaux

A ce titre, il faut noter que l

bayésienne a considérablem

de prévision de la politique macroéconomique. Elle propose un cadre rigoureux pour formaliser les

croyances a priori (paradigme bayésien) et déterminer comment celles ci doivent être mises à jour

une fois que les données sont observées (révision bayésienne). Aussi, il convient de préciser que cette

approche est généralement opposée à une autre dite classique

Dans la dernière section, nous allons rappeler, par un exemple, le processus de révision bayésienne.

I. Paradigme classique

reprenons dans les deux premières sections les caractéristiques qui marquent la différence entre les

deux grandes écoles.

Considérons une observable Y, di

la seule inconnue est

le paramètre

. Ce paramètre appartient à un espace (ensemble des états de la nature) de

est la distribution de la variable aléatoire Y conditionnellement à ses

paramètres à

(fonction des données ou estimateur) dont les paramètres dépendent de

moyenne arithmétique n variables aléatoires indépendantes et

identiquement distribuées (iid) :

*

Master en cours Economie NPTCI 2010 2012 ; Assistant CCAM UPC et Chercheur co accompli au Laboratoire

Recherche en Economie Quantitative [LAREQ] ; jeanpaultsasa@lareq.com BP 16 626 Kinshasa I.

Un paramètre est souvent multidimensionnel,

27

Laréq

Jean – Paul Tsasa/ Chercheur co – accompli

Pour n assez grand (théorème central limite

a une distribution normale, de moyenne et

de variance

sachant . En considérant un

risque il devient aisé de calculer les valeurs critiques :

intervalle de tolérance que si et

sont connus. Or en réalité, ces paramètres sont inconnus. Ainsi, le statisticien classique, en refusant de

considérer comme une variable aléatoire, procède en trois temps et comme suit :

- En un premier temps et de ce fait, renverse la perspective en

écrivant un intervalle de confiance

*

:

contrairement au paramètre qui est inconnu mais certain

les données réellement observées sont aléatoires

jugement probabiliste sur

statistique, autrement la probabilité

de recouvrement de par un intervalle aléatoire

;

- type inconnu type

estimé :

z, , par le

percentile de Student t. Ainsi, il obtient :

- Sachant que rien ne garantit que le paramètre

entourloupette en réalisant un véritable tout de passe passe : (i) il imagine une collection

ii) pour chaque échantillon généré, il obtient

*

Nous verrons plus loin que contrairement au statisticien classique qui considère la probabilité comme une fréquence

entendu

statisticien bayésien conçoit la probabilité comme le

28

Laréq

Jean – Paul Tsasa/ Chercheur co – accompli

quasi inévitablement un nouvel intervalle de confiance et (iii) il conclut que pour cent

de ces intervalles contiendraient dans ce cas, la valeur inconnue et certaine

que le paramètre du modèle statistique paramétrique

est incertain. Dès lors, la préoccupation

change ; on cherchera plutôt à quantifier cette incertitude en mobilisant toutes les informations

disponibles.

II. Paradigme bayésien

Le statisticien bayésien, contraire au classique, confère au paramètre le statut de variable aléatoire.

Ainsi, il lui attribue une distribution de probabilité a priori (prior

paramètre en cause. On la note :

Le prior

éré. Comme le notent Boreux, Parent et Bernier (2010),

distribution

de probabilité.

Considérons la règle de Bayès :

Pour passer des informations a priori aux lois (distribution) a priori, la théorie bayésienne de la décision

statistique affecte des indices de crédibilité (élicitationmble des valeurs possibles

du paramètrea priori (Robert,

2006 ; Parent et Bernier, 2007 ; Boreux, Parent et Bernier, 2010).

a) Prendre un prior non informatif

Le prior non informatif, appelé également prior vague ou prior peu informatif

s de lier les paramètres :

29

Laréq

Jean – Paul Tsasa/ Chercheur co – accompli

que toutes les plages de valeurs sont, à ses yeux, équiprobables

*

pariera pas davantage sur une valeur que sur une autre.

néchantillon iid :

Cette matrice intervient dans la construction de priors non informatifs

raisonnement mathématique, Jeffrey (1939 prior vague à partir du

déterminant de :

Ce prior impropre a comme propriété de fournir une référence insensible à une reparamétrisation du

modèle de vraisemblance.

b) Choisir un prior conjugué à la vraisemblance

prior. Ainsi, on obtient de modèles en

juxtaposant le nom du modèle de prior hantillonnage (Par exemple, gamma

normalnormal ; gammaPoisson ; bêtabinomial).

En considérant respectivement un modèle gammanormalnormal

:

où les paramètres du prior (hyperparamètres) sont connus,

ainsi, on a :

Pour tendant vers zéro, on a :

§

Les priors non informatifs peuvent être obtenu en donnant des valeurs extrêmes aux hyperparamètres

du prior conjugué.

*

Le modèle

et le prior conjugé est un mélange gamma

normal.

§

30

Laréq

Jean – Paul Tsasa/ Chercheur co – accompli

c) Procéder par analogie

provenant des observations.

d) Mobiliser la méthode par introspections successives

qui ont un sens à ses yeux. Ensuite, il tente de caler une

phares

prior conjugué à partir de la connaissance de certains quantiles ou de leurs écarts.

(composante objective) et sur les idées du chercheur (composante subjective). Elle vise à déterminer les

causes à partir des effets. Les causes sont réduites aux paramètres du mécanisme probabiliste

disponibles. Ainsi, les observations apparaissent comme une série des tirages dans une loi statistique

contrôlée par le paramètre inconnu.

:

- il applique une méthode statistique afin de déduire des observations une inférence sur ;

- il quantifie, incertitude sur (connaissance de la cause) ;

- il recourt au mécanisme générateur de données conditionnellement à

observations futures.

ayésienne, la règle de Bayès peut être dérivée en

considérant le théorème des probabilités conditionnelles :

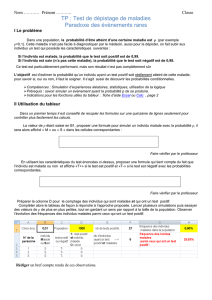

Figure 1. : Principe de l’analyse statistique bayésienne

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%