Rudiments pratiques d`alg`ebre linéaire

Rudiments pratiques d’alg`ebre lin´eaire

IUP GSI 1`ere ann´ee et DEUG STPI 2`eme ann´ee

Fran¸cois Dumas

2

Table des mati`eres

1 Espaces vectoriels Rnet Cn9

1.1 Structure d’espace vectoriel sur Kn............................ 9

1.1.1 Ensemble Kn.................................... 9

1.1.2 Addition dans Kn................................. 9

1.1.3 Produit externe d’un vecteur de Knpar un nombre de K........... 10

1.1.4 Calcul dans l’espace vectoriel Kn......................... 11

1.1.5 Commentaire : notion g´en´erale d’espace vectoriel . . . . . . . . . . . . . . . . 12

1.2 Sous-espaces vectoriels de Kn............................... 12

1.2.1 Exemples pr´eliminaires . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

1.2.2 Notion de sous-espace vectoriel . . . . . . . . . . . . . . . . . . . . . . . . . . 13

1.2.3 Intersection de sous-espaces vectoriels . . . . . . . . . . . . . . . . . . . . . . 14

1.2.4 Somme de sous-espaces vectoriels . . . . . . . . . . . . . . . . . . . . . . . . . 15

1.2.5 Somme directe et sous-espaces vectoriels suppl´ementaires . . . . . . . . . . . 15

1.3 Engendrement et familles g´en´eratrices . . . . . . . . . . . . . . . . . . . . . . . . . . 16

1.3.1 Exemples pr´eliminaires . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 16

1.3.2 Combinaisons lin´eaires et sous-espace vectoriel engendr´e . . . . . . . . . . . . 16

1.3.3 Famille g´en´eratrice . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

1.4 D´ependance lin´eaire, familles li´ees, familles libres . . . . . . . . . . . . . . . . . . . . 17

1.4.1 Exemples pr´eliminaires . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

1.4.2 Famille li´ee, famille libre . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

1.5 Bases et dimension . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 18

1.5.1 Bases et dimension de Kn............................. 19

1.5.2 Bases et dimension des sous-espaces vectoriels . . . . . . . . . . . . . . . . . . 20

1.5.3 Bases et somme directe . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 21

1.5.4 Th´eor`eme dit de la base incompl`ete . . . . . . . . . . . . . . . . . . . . . . . 22

1.6 Exercices sur le chapitre 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

2 Applications lin´eaires 25

2.1 Endomorphismes de Kn.................................. 25

2.1.1 Exemples pr´eliminaires . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

2.1.2 Notion d’endomorphisme . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 26

2.1.3 Injectivit´e, noyau . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

2.1.4 Surjectivit´e, image, rang . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 28

2.1.5 Bijectivit´e, action sur les bases . . . . . . . . . . . . . . . . . . . . . . . . . . 28

2.1.6 Alg`ebre des endomorphismes, groupe lin´eaire . . . . . . . . . . . . . . . . . . 30

2.2 Applications lin´eaires de Kndans Kp........................... 31

2.2.1 Notion d’application lin´eaire . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

2.2.2 Image directe ou r´eciproque d’un sous-espace vectoriel . . . . . . . . . . . . . 32

2.3 Formes lin´eaires et ´equations des sous-espaces vectoriels . . . . . . . . . . . . . . . . 33

2.3.1 Formes lin´eaires et hyperplans . . . . . . . . . . . . . . . . . . . . . . . . . . 33

3

2.3.2 Equations lin´eaires homog`enes . . . . . . . . . . . . . . . . . . . . . . . . . . 34

2.3.3 Syst`emes homog`enes d’´equations lin´eaires . . . . . . . . . . . . . . . . . . . . 35

2.4 Exercices sur le chapitre 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 37

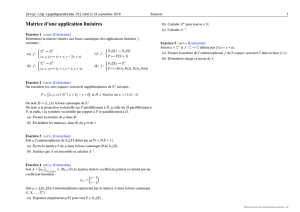

3 Matrices 39

3.1 Calcul matriciel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

3.1.1 Notion de matrice . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

3.1.2 Addition et produit externe . . . . . . . . . . . . . . . . . . . . . . . . . . . 40

3.1.3 Produit matriciel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 40

3.1.4 Alg`ebre des matrices carr´ees . . . . . . . . . . . . . . . . . . . . . . . . . . . 41

3.1.5 Matrices carr´ees inversibles, groupe lin´eaire . . . . . . . . . . . . . . . . . . . 43

3.1.6 Matrices ´equivalentes, matrices carr´ees semblables . . . . . . . . . . . . . . . 43

3.1.7 Transposition . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 44

3.1.8 Quelques types particuliers de matrices carr´ees . . . . . . . . . . . . . . . . . 44

3.1.9 Trace d’une matrice carr´e . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 45

3.2 Matrices et applications lin´eaires . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 45

3.2.1 Matrice d’une application lin´eaire par rapport `a des bases . . . . . . . . . . . 45

3.2.2 Propri´et´es de la correspondance entre matrices et applications lin´eaires . . . 47

3.2.3 Cas particulier des matrices carr´ees et des endomorphismes . . . . . . . . . . 48

3.2.4 Application au calcul de l’inverse d’une matrice carr´ee inversible . . . . . . . 49

3.3 Changements de base . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50

3.3.1 Matrice d’une famille finie de vecteurs dans une base . . . . . . . . . . . . . . 50

3.3.2 Matrice de passage . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50

3.3.3 Premi`ere formule de changement de bases . . . . . . . . . . . . . . . . . . . . 51

3.3.4 Seconde formule de changement de bases . . . . . . . . . . . . . . . . . . . . 51

3.4 Exercices sur le chapitre 3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 53

4 Rang 55

4.1 Divers points de vue sur la notion de rang . . . . . . . . . . . . . . . . . . . . . . . . 55

4.1.1 Rang d’une famille finie de vecteurs . . . . . . . . . . . . . . . . . . . . . . . 55

4.1.2 Rang d’une application lin´eaire . . . . . . . . . . . . . . . . . . . . . . . . . . 55

4.1.3 Rang d’un syst`eme d’´equations lin´eaires homog`enes . . . . . . . . . . . . . . 55

4.1.4 Rang d’une matrice . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

4.1.5 Un exemple num´erique . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56

4.1.6 Matrices carr´ees de rang maximal . . . . . . . . . . . . . . . . . . . . . . . . 58

4.1.7 Deux propri´et´es du rang . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

4.2 Une m´ethode de calcul . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

4.2.1 Rang et transformations ´el´ementaires . . . . . . . . . . . . . . . . . . . . . . 59

4.2.2 Un exemple num´erique. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

4.3 Exercices sur le chapitre 4 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 60

5 D´eterminant 63

5.1 Cas particulier des matrices 2 ×2............................. 63

5.2 Cas g´en´eral des matrices n×n.............................. 64

5.2.1 D´efinition du d´eterminant . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

5.2.2 Op´erations sur les lignes . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 65

5.2.3 Transposition (Op´erations sur les colonnes) . . . . . . . . . . . . . . . . . . . 66

5.2.4 Exemples de calculs . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 66

5.2.5 Multiplicativit´e et inversibilit´e . . . . . . . . . . . . . . . . . . . . . . . . . . 67

5.3 Applications . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 68

5.3.1 D´eterminant d’un endomorphisme ; application `a la bijectivit´e . . . . . . . . . 68

4

5.3.2 Application `a l’ind´ependance lin´eaire d’une famille de nvecteurs . . . . . . . 68

5.3.3 Application `a certains syst`emes lin´eaires : formules de Cramer . . . . . . . . 68

5.4 Exercices sur le chapitre 5 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

6 R´eduction des endomorphismes (1) 73

6.1 Notions g´en´erales sur les valeurs propres . . . . . . . . . . . . . . . . . . . . . . . . . 73

6.1.1 Remarques pr´eliminaires et notations . . . . . . . . . . . . . . . . . . . . . . 73

6.1.2 Valeurs propres, vecteurs propres, sous-espaces propres . . . . . . . . . . . . . 74

6.1.3 Polynˆome caract´eristique . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 74

6.1.4 Multiplicit´e d’une valeur propre . . . . . . . . . . . . . . . . . . . . . . . . . . 75

6.1.5 Quelques exemples de calculs . . . . . . . . . . . . . . . . . . . . . . . . . . . 76

6.2 Diagonalisation et trigonalisation . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

6.2.1 Endomorphisme diagonalisable, matrice diagonalisable . . . . . . . . . . . . . 77

6.2.2 Endomorphisme trigonalisable, matrice trigonalisable . . . . . . . . . . . . . . 80

6.2.3 Application `a la r´esolution de syst`emes diff´erentiels lin´eaires . . . . . . . . . . 82

6.2.4 Application au calcul des puissances d’une matrice . . . . . . . . . . . . . . . 85

6.3 Exercices sur le chapitre 6 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 85

7 R´eduction des endomorphismes (2) 87

7.1 Polynˆome minimal . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 87

7.1.1 Th´eor`eme de Cayley-Hamilton . . . . . . . . . . . . . . . . . . . . . . . . . . 87

7.1.2 Notion de polynˆome minimal . . . . . . . . . . . . . . . . . . . . . . . . . . . 87

7.2 Sous-espaces caract´eristiques . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 89

7.2.1 Notion de sous-espace caract´eristique . . . . . . . . . . . . . . . . . . . . . . . 89

7.2.2 Suite des noyaux . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 90

7.2.3 Exemples . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 90

7.3 R´eduction de Jordan . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 91

7.3.1 Synth`ese sur la m´ethode de r´eduction de Jordan . . . . . . . . . . . . . . . . 91

7.3.2 Exemples . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 93

7.3.3 Exemples . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 94

7.4 Exercices sur le chapitre 7 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 96

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

1

/

98

100%