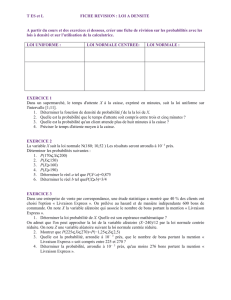

Théorie des probabilités

Th€orie des probabilit€s 1

Théorie des probabilités

Courbes de probabilit€.

La Théorie des probabilités est l'€tude

math€matique des ph€nom•nes

caract€ris€s par le hasard et l'incertitude.

Les objets centraux de la th€orie des

probabilit€s sont les variables al€atoires,

les processus stochastiques, et les

€v€nements: ils traduisent de mani•re

abstraite des €v€nements non

d€terministes ou des quantit€s mesur€es

qui peuvent parfois €voluer dans le

temps d'une mani•re apparemment

al€atoire. En tant que fondement

math€matique des statistiques, la th€orie

des probabilit€s est essentielle ‚ la

plupart des activit€s humaines qui

n€cessitent une analyse quantitative d'un

grand nombre de mesures. Les m€thodes

de la th€orie des probabilit€s s'appliquent

€galement ‚ la description de syst•mes

complexes dont on ne connait qu'en

partie l'€tat, comme en m€canique

statistique. Une grande d€couverte de la

physique du vingti•me si•cle fut la

nature probabiliste de ph€nom•nes

physiques ‚ une €chelle microscopique,

d€crite par la m€canique quantique.

Historique

La th€orie math€matique des probabilit€s trouve ses origines dans l'analyse de jeux de hasard par Gerolamo Cardano

au seizi•me si•cle, et par Pierre de Fermat et Blaise Pascal au dix-septi•me si•cle. Bien qu'un simple pile ou face ou

un lancer de d•s soit un €v€nement al€atoire, en les r€p€tant de nombreuses fois on obtient une s€rie de r€sultats qui

va poss€der certaines propri€t€s statistiques, que l'on peut €tudier et pr€voir. Deux r€sultats math€matiques

fondamentaux ‚ ce propos sont la loi des grands nombres et le th€or•me de la limite centrale.

Initialement, la th€orie des probabilit€s consid€rait surtout les €v€nements discrets, et ses m€thodes €taient

principalement combinatoires. Mais des consid€rations analytiques ont forc€ l'introduction de variables al€atoires

continues dans la th€orie. Cette id€e prend tout son essor dans la th€orie moderne des probabilit€s, dont les

fondations ont €t€ pos€es par Andreƒ Nikolaevich Kolmogorov. Kolmogorov combina la notion d'univers, introduite

par Richard von Mises et la th€orie de la mesure pour pr€senter son syst•me d'axiomes pour la th€orie des

probabilit€s en 1933. Tr•s vite, son approche devint la base incontest€e des probabilit€s modernes.

Th€orie des probabilit€s 2

Théorie des probabilités discrète

La théorie discrète des probabilités s'occupe d'€v€nements dans le cadre d'un univers fini ou d€nombrable.

Exemples: lancer de d€s, exp€riences avec des paquets de cartes, et marche al€atoire.

Définition classique: Initialement, la probabilit€ d'un €v€nement €tait d€finie comme le nombre de cas favorables

pour l'€v€nement, divis€ par le nombre total d'issues possibles ‚ l'exp€rience al€atoire.

Par exemple, si l'€v€nement est obtenir un nombre pair en lançant le dé, sa probabilit€ est donn€e par ,

puisque trois faces sur six ont un nombre pair.

Définition moderne : La d€finition moderne commence par un ensemble appel€ univers, qui correspond ‚

l'ensemble des issues possibles ‚ l'exp€rience dans la d€finition classique. Il est not€ . Ensuite,

on a besoin d'une fonction d€finie sur , qui va associer ‚ chaque €l€ment de sa probabilit€, satisfaisant donc

les propri€t€s suivantes :

1.

2.

On d€finit ensuite un €v€nement comme un ensemble d'issues, c'est-‚-dire un sous-ensemble de . La probabilit€

d'un €v•nement est alors d€finie de mani•re naturelle par :

Ainsi, la probabilit€ de l'univers est 1, et la probabilit€ de l'€v€nement impossible (l'ensemble vide) est 0.

Pour revenir ‚ l'exemple du lancer de d€s, on peut mod€liser cette exp€rience en se donnant un univers

correspondant aux valeurs possibles du d€, et une fonction qui ‚ chaque associe

.

Théorie des probabilités continue

La théorie des probabilités continue s'occupe des €v€nements qui se produisent dans un univers continu (par

exemple la droite r€elle).

Définition classique: La d€finition classique est mise en €chec lorsqu'elle est confront€e au cas continu (cf. paradoxe

de Bertrand).

Définition moderne Si l'univers est la droite r€elle , alors on admet l'existence d'une fonction appel€e fonction

de r€partition , qui donne pour une variable al€atoire . Autrement dit, retourne

la probabilit€ que soit inf€rieur ou €gal ‚ .

La fonction de r€partition doit satisfaire les propri€t€s suivantes :

1. est une fonction croissante et continue ‚ droite.

2.

3.

Si est d€rivable, alors on dit que la variable al€atoire a une densit€ de probabilit€ .

Pour un ensemble , la probabilit€ que la variable al€atoire soit dans est d€finie comme :

Si la densit€ de probabilit€ existe, on peut alors la r€€crire :

Th€orie des probabilit€s 3

Tandis que la densit€ de probabilit€ n'existe que pour les variables al€atoires continues, la fonction de r€partition

existe pour toute variable al€atoire (y compris les variables discr•tes) ‚ valeurs dans .

Ces concepts peuvent „tre g€n€ralis€s dans les cas multidimensionnel sur et d'autres univers continus.

Principes fondamentaux

La probabilit€ d'un €v€nement donn€ A, , est repr€sent€e par un nombre compris entre 0 et 1. L'€v€nement

impossible a une probabilit€ de 0 et l'€v€nement certain a une probabilit€ de 1. Il faut savoir que la r€ciproque n'est

pas vraie. Un €v€nement qui a une probabilit€ 0 peut tr•s bien se produire dans le cas o… un nombre infini

d'€v€nements diff€rents peut se produire. Ceci est d€taill€ dans l'article Ensemble n€gligeable.

Quelques notions ou propriétés fondamentales

Évènement Probabilité

probabilit€ de A

probabilit€ de ne pas avoir A

probabilit€ d'avoir A ou B

probabilit€ conditionnelle de

A,

sachant B

probabilit€ d'avoir A et B

est la r€union de A et B. est l'intersection de A et de B. est appel€ la probabilit€

conditionnelle de A sachant B. C'est la probabilit€ d'avoir A quand on sait que l'on a B. Par exemple, pour un d€ ‚ 6

faces la probabilit€ d'avoir un 2 (A) quand on sait que le r€sultat est pair (B) est €gal ‚ car la probabilit€

d'avoir ‚ la fois un 2 et un nombre pair est €gal ‚ 1/6 et la probabilit€ d'avoir un nombre pair est €gal ‚ 1/2. Ici on

remarque que car on a toujours un nombre pair quand on a 2.

La théorie des probabilités aujourd'hui

Certaines distributions peuvent „tre un m€lange de distributions discrètes et continues, et donc n'avoir ni densit€ de

probabilit€ ni fonction de masse. La distribution de Cantor constitue un tel exemple. L'approche moderne des

probabilit€s r€sout ces probl•mes par l'utilisation de la th€orie de la mesure pour d€finir un espace probabilis€ et

aboutir aux axiomes des probabilit€s d€velopp€s par Kolmogorov

Un espace probabilis€ comporte trois parties:

† un univers : L'univers est l'ensemble de tous les r€sultats possibles de l'€venement al€atoire. Par exemple pour

un d€ a 6 faces l'univers est ‡ ≡ {1, 2, 3, 4, 5, 6}.

† un ensemble d'€v€nements : C'est une tribu sur les €v€nements ‡. Cet ensemble contient tous les r€sultats

possibles de l'€v€nement au sens large. Par exemple pour un d€ ‚ 6 faces il contient la possibilit€ d'avoir un 1 ou

un 2: {1, 2}, la possibilit€ de ne rien sortir comme r€sultat: l'ensemble vide , la possibilit€ de sortir n'importe

quel face du d€ {1, 2, 3, 4, 5, 6}. En g€n€ral en probabilit€ on se contente de prendre la tribu bor€lienne. ˆ titre

d'exemple la tribu bor€lienne pour le r€sultat d'un d€ ‚ 4 faces est donn€ (celle pour le d€ ‚ 6 faces est encore plus

grande mais suit le m„me principe):

{‰, {1}, {2}, {3}, {4}, {1,2}, {1,3}, {1,4}, {2,3}, {2,4}, {3,4}, {1,2,3}, {1,2,4}, {1,3,4}, {2,3,4}, {1,2,3,4}}.

On remarque que cette tribu contient l'ensemble vide ‰ et ‡={1,2,3,4}. Ceci est le cas pour toutes les tribus.

Th€orie des probabilit€s 4

† une mesure : Cette mesure ou probabilit€ est la probabilit€ de r€aliser l'un des €l€ments de . Cette

probabilit€ est comprise entre 0 et 1 pour tous les €l€ments de , c'est le premier axiome des probabilit€s. Par

exemple pour un d€ a 6 faces: la probabilit€ d'avoir {1} est 1/6, la probabilit€ de ‡={1, 2, 3, 4, 5, 6}, tirer

n'importe laquelle des 6 faces, est 1 (ceci est aussi toujours le cas, c'est le deuxième axiome des probabilit€s), la

probabilit€ de l'ensemble vide ‰ est 0. Ceci est toujours le cas, c'est €galement une cons€quence des axiomes des

probabilit€s.

Dans cette optique, pour des €v€nements deux ‚ deux disjoints (c'est-‚-dire, d'intersection deux ‚ deux vide) A1, A2,

A3…, la probabilit€ de leur union apparaŠt comme la somme de leurs probabilit€s, ou, avec les notations

math€matiques,

C'est le troisième et dernier axiome des probabilit€s. Par exemple, et toujours pour un d€ ‚ 6 faces, la probabilit€ de

tirer un 1 ou un 2

En plus de permettre une meilleure compr€hension et une unification des th€ories discr•tes et continues des

probabilit€s, l'approche de la th€orie de la mesure nous permet aussi de parler de probabilit€s en dehors de ,

notamment dans la th€orie des processus stochastiques. Par exemple pour l'€tude du mouvement brownien, la

probabilit€ est d€finie sur un espace de fonctions.

Lois de probabilité

Certaines variables al€atoires sont fr€quemment rencontr€es en th€orie des probabilit€s car on les retrouve dans de

nombreux processus naturels ; leur loi a donc une importance particuli•re. Les lois discr•tes les plus fr€quentes sont

la loi uniforme discr•te, la loi de Bernoulli, ainsi que les lois binomiale, de Poisson et g€om€trique. Les lois

uniforme continue, normale, exponentielle et gamma sont parmi les plus importantes lois continues.

Convergence de variables aléatoires

En th€orie des probabilit€s, il y a plusieurs notions de convergence pour les variables al€atoires. En voici une liste:

Convergence en loi: une suite de variables al€atoires converge en loi vers la variable al€atoire

si et seulement si la suite des mesures images converge €troitement vers la mesure image

. En particulier dans le cas r€el, il faut et il suffit que les fonctions de r€partition convergent simplement vers la

fonction de r€partition de X en tout point de continuit€ de cette derni•re.

Convergence en probabilité: converge en probabilit€ vers ssi ,

. Cette convergence implique la convergence en loi.

Convergence presque sûre: converge presque s‹rement vers ssi

. Elle implique la convergence en probabilit€, donc la convergence

en loi.

Convergence dans : converge dans vers ssi . Elle

implique aussi la convergence en probabilit€.

Le calcul stochastique

Un processus stochastique est un processus al€atoire qui d€pend du temps. Un processus stochastique est donc une

fonction de deux variables : le temps et la r€alisation Œ d'une certaine exp€rience al€atoire. Quelques exemples

d'utilisation des processus stochastiques incluent le mouvement brownien, les fluctuations du march€ boursier, ou la

reconnaissance vocale. En temps discret, ces processus sont aussi connus sous le nom de S€ries temporelles et

servent entre autres en €conom€trie.

Parmi les processus stochastiques, les chaŠnes de Markov constituent l'exemple le plus simple et sans doute celui qui

a le plus d'applications pratiques.

Th€orie des probabilit€s 5

Chaîne de Markov

Une chaŠne de Markov est un processus stochastique poss€dant la propri€t€ markovienne. Dans un tel processus, la

pr€diction du futur ‚ partir du pr€sent ne n€cessite pas la connaissance du pass€. Il suffit alors de connaŠtre l'€tat de la

chaŠne ‚ un instant t pour savoir comme elle €voluera au temps t+1, il n'est pas n€cessaire de connaŠtre tout le pass€

entre 0 et t pour pr€voir l'€volution de la chaŠne.

Une chaŠne en temps discret est une s€quence X1, X2, X3, ... de variables al€atoires. La valeur Xn €tant l'€tat du

processus au moment n. Si la distribution de probabilit€ conditionnelle de Xn+1 sur les €tats pass€s est une fonction

de Xn seulement, alors de fa•on math€matique:

o… x est un €tat quelconque du processus, est la probabilit€ d'avoir A quand on sait que l'on a B par

exemple ici la probabilit€ d'avoir une certaine valeur pour quand on connaŠt la valeur de . L'identit€

ci-dessus est la propri€t€ de Markov pour le cas particulier d'une chaŠne en temps discret. La probabilit€

est appel€e la probabilit€ de transition de x ‚ y ; c'est la probabilit€ d'aller de x ‚ y au

temps n et a une importance particuli•re pour l'€tude de ces chaŠnes. Nous consid€rons ici uniquement des chaŠnes de

Markov en temps discret mais il faut savoir qu'il existe une g€n€ralisation en temps continu.

Cette propri€t€ de Markov s'oppose ‚ la notion d'hyst€r€sis o… l'€tat actuel d€pend de l'histoire et non seulement de

l'€tat actuel. Ces chaŠnes de Markov ou des mod•les de Markov cach€s interviennent dans l'€tude de la marche

al€atoire et ont de nombreux champs d'application: filtre anti-spam, mouvement brownien, hypoth•se ergodique,

th€orie de l'information, reconnaissance des formes, algorithme de Viterbi utilis€ en t€l€phonie mobile, etc...

Trois marches al€atoires (ind€pendantes) isotropes sur le r€seau ; 10 000 pas.

Citons entre autres comme cas particuliers de chaŠnes de Markov la marche al€atoire qui sert en particulier ‚ l'€tude

de la diffusion ou du jeu de pile ou face. Une marche al€atoire est une chaŠne de Markov o… la probabilit€ de

transition ne d€pend que de x-y. Autrement dit une chaŠne de Markov o… l'on a:

.

Un jeu de pile ou face o… l'on jouerait 1 ‚ chaque lancer est un exemple de marche al€atoire. Si on a y apr•s n

lancers, si (x-y)=+1 ou -1 et 0 sinon. (on a une chance sur deux de gagner 1 et

une chance sur deux de perdre 1)

6

6

7

7

1

/

7

100%