Hasard, probabilités, incertitude, déterminisme, chaos…

Hasard, probabilités, incertitude,

déterminisme, chaos…

Roger Balian*

« ‒ Est-ce la physique que vous voulez apprendre ?

‒ Qu’est-ce qu’elle chante cette physique ?

‒ La physique est celle qui explique les principes des choses naturelles et les propriétés du corps ; qui discourt

de la nature des éléments, des métaux, des minéraux, des pierres, des plantes et des animaux, et nous enseigne

les causes de tous les météores, l’arc-en-ciel, les feux volants, les comètes, les éclairs, le tonnerre, la foudre, la

pluie, la neige, la grêle, les vents, et les tourbillons.

‒ Il y a trop de tintamarre là-dedans, trop de brouillamini. »

Molière, Le Bourgeois Gentilhomme.

La physique, science exacte ?

Depuis ses origines, la physique a progressé en s’appuyant sur

une mathématisation de plus en plus poussée. Cette « déraisonnable

efficacité des mathématiques », selon la célèbre phrase de Wigner, a

suscité de nombreuses discussions philosophiques. Une explication

plausible de la remarquable adéquation entre physique et

mathématiques pourrait être le développement en symbiose des deux

disciplines : chacune stimule des innovations chez l’autre, tout en

bénéficiant de ses progrès.

L’efficacité de l’arithmétique, de la géométrie, de l’algèbre et de

l’analyse a renforcé jusque vers la fin du XIXe siècle une conception

déterministe pure et dure de la physique. Dans ce cadre de pensée, les

propriétés d’un objet sont entièrement caractérisées par des grandeurs

physiques, qui prennent à chaque instant des valeurs numériques bien

définies régies par des équations fondamentales. Par exemple, le

mouvement d’un point matériel est décrit par sa position et sa vitesse

gouvernées par la loi de Newton ; les valeurs en chaque point d’un

champ électromagnétique sont gouvernées par les équations de

Maxwell. Ces valeurs des grandeurs physiques ne sont pas forcément

* Institut de Physique Théorique, Saclay. Académie des Sciences.

accessibles à l’expérience ; mais on admet qu’elles peuvent

théoriquement être définies avec une précision arbitrairement grande.

Le caractère mathématique rigoureux, d’apparence définitive,

des équations de la physique est probablement à la source d’une

illusion récurrente : celle de l’achèvement de cette science. Ainsi, en

1823, Jean-Baptiste Biot conclut-il la préface de son Précis

élémentaire de physique en notant que c’est « une science faite,

fondée sur les rapports directs et numériques des résultats entre eux »,

et que « la progression rapide avec laquelle elle se complète tous les

jours peut faire regarder l’époque de sa stabilité entière comme peu

éloignée de nous ». Or, dès l’année suivante, Sadi Carnot fondera dans

ses Réflexions sur la puissance motrice du feu une nouvelle grande

branche de la physique : la thermodynamique. De même, on pensait

couramment vers 1900 qu’il ne restait plus guère qu’un problème

ouvert en physique, celui du rayonnement du corps noir ; sa solution

devait peu après donner naissance à la mécanique quantique !

La conception de la physique comme science exacte a peut-être

aussi contribué aux excès du scientisme, caricature du rationalisme

selon laquelle la science pourrait régler au mieux tous les problèmes

de l’humanité. Au XXe siècle, cette confiance aveugle en une

efficacité universelle des sciences a disparu, en dépit de leurs succès

dans l’explication de phénomènes de plus en plus variés, et de leurs

innombrables applications bénéfiques ; il nous faut malheureusement

lutter désormais contre la montée de l’irrationnel et contre le préjugé

inverse, la défiance envers la science…

Enfin, la perfection et la beauté des mathématiques utilisées pour

expliquer la réalité physique ont pu contribuer à favoriser une

conception quelque peu prométhéenne de la science : elle serait un

moyen de découvrir ce que sont les choses en soi. Einstein a défendu

cette position dans une célèbre controverse avec Niels Bohr ; selon ce

dernier, la science porterait seulement sur ce que nous pouvons dire de

la réalité, sur les images (en particulier mathématiques) nous

permettant d’approcher la nature de façon de moins en moins

incertaine. Comme nous allons le voir, la notion d’incertitude est au

cœur de plusieurs domaines de physique développés au cours du XXe

siècle, ce qui doit nous rendre modestes face au réel.

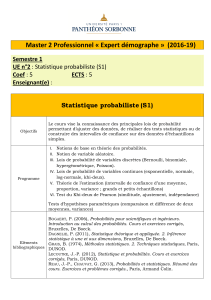

Les probabilités, ou la rigueur dans l’incertain.

Avant de pénétrer la théorie, l’incertitude a préoccupé depuis

longtemps les expérimentateurs. Afin de déterminer une grandeur

physique y, ils procèdent à des mesures répétées ; les résultats yk

obtenus ne sont pas exactement les mêmes, de sorte qu’on ne peut

concrètement attribuer une valeur numérique précise à la grandeur y.

Celle-ci n’est définie expérimentalement qu’avec une certaine marge,

et on utilise la théorie des probabilités pour manipuler l’ensemble des

résultats obtenus : en particulier, la valeur moyenne des yk observés

fournit une estimation de la grandeur mesurée, et la fluctuation

statistique ∆y, qui caractérise les écarts entre les yk, donne une idée de

l’incertitude.

De nombreuses théories physiques modernes présentent, elles

aussi, un caractère partiellement incertain, aléatoire. Les probabilités

sont donc devenues un outil majeur en physique théorique,

parallèlement aux autres branches des mathématiques (portant sur des

grandeurs parfaitement définies). Elles permettent d’effectuer, à partir

d’informations incomplètes, des prévisions aussi fiables que possible

et d’estimer leur qualité.

Cet emploi des probabilités va de pair avec l’idée que la théorie

ne porte pas sur des objets particuliers mais sur des phénomènes

génériques ; elle décrit non un objet unique mais un ensemble

statistique d’échantillons similaires. Si l’on s’intéresse à un objet

individuel, on doit imaginer qu’il est extrait d’un ensemble

probabiliste, soit réel (comme pour des expériences répétées en

physique), soit virtuel (comme pour des prévisions parmi le champ

des possibles en météorologie).

Les probabilités ont alors une double interprétation. Lorsqu’un

processus a été répété dans les mêmes conditions un très grand

nombre de fois, mais qu’il était susceptible de conduire à plusieurs

résultats différents pour une raison hasardeuse, la probabilité de

chacun de ces résultats s’identifie à la fréquence relative de son

obtention. Ainsi, lorsqu’un dé parfaitement symétrique est lancé une

infinité de fois, la face 4 apparaît en moyenne une fois sur six, et sa

probabilité est 1/6.

La seconde interprétation se réfère à la situation avant réalisation

de l’un des événements susceptibles de se produire ; leurs probabilités,

estimées à l’aide des informations dont nous disposons, servent alors à

effectuer des prévisions. Lorsque tous les événements possibles sont

sur le même plan et que rien ne favorise plus les uns que les autres, le

principe d’indifférence (ou de « raison insuffisante ») de Laplace

conduit à leur attribuer la même probabilité. Après brassage d’un jeu

de bridge, les 52 cartes peuvent être rangées de 52! façons, et il est

raisonnable d’assigner a priori la probabilité 1/52! à chacune d’entre

elles. Après avoir découvert ses propres cartes, puis pris connaissance

des annonces, enfin vu les cartes du mort, on est conduit à estimer une

nouvelle distribution de probabilité, afin d’établir une ligne de jeu en

évaluant par exemple les chances de réussite d’une impasse. En

physique, lorsque les lois, ou bien les données, présentent des

incertitudes, la prévision d’un phénomène suit une démarche similaire

et sa fiabilité peut être estimée grâce au calcul des probabilités. Le

hasard, c’est-à-dire ce que nous connaissons mal, entre ainsi dans la

science.

Les notions de probabilité et d’information sont liées : ne

disposant pas de la même information, le lecteur de revues hippiques

et le profane n’attribueront pas les mêmes probabilités aux résultats

possibles d’une course. La théorie de l’information est née de celle des

probabilités. On veut d’abord chiffrer la quantité d’information In

acquise en apprenant qu’événement aléatoire n, auquel on avait

attribué la probabilité Pn, est survenu. Plus Pn est faible, plus on a

gagné d’information. Par ailleurs, les quantités d’information acquises

lorsqu’on prend connaissance de deux événements indépendants

doivent s’ajouter, alors que leurs probabilités se multiplient. Il en

résulte que In doit avoir la forme logarithmique In = ‒ k ln Pn, où k est

une constante définissant l’unité d’information. Ensuite, on cherche à

mesurer l’incertitude, ou la « perplexité », d’un observateur qui, face à

diverses possibilités n non encore réalisées, n’en connaît a priori que

les probabilités Pn ; cette incertitude est la moyenne de l’information

qui serait acquise si l’on prenait connaissance a posteriori de l’une ou

l’autre de ces possibilités. L’expression résultante, l’« entropie

statistique » S = ∑ Pn In = ‒ k ∑ Pn ln Pn , introduite en 1948 par

Shannon lorsqu’il a fondé la théorie des communications, sert en

physique à estimer la quantité d’information qui manque du fait qu’on

ne connaît un système qu’à travers une loi de probabilité.

La physique quantique, triomphante malgré les incertitudes.

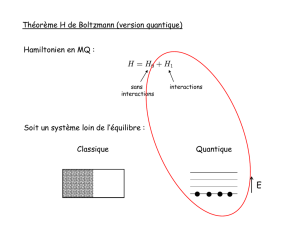

Notre théorie la plus fondamentale est aujourd’hui la mécanique

quantique, élaborée dans la première moitié du XXe siècle. Elle n’a

jamais été mise en défaut ; d’autres sciences comme l’électronique, la

physique des particules ou la chimie reposent sur elle, son efficacité

est démontrée par ses applications. Et pourtant, paradoxalement, elle

fait conceptuellement intervenir des incertitudes incontournables.

Celles-ci portent sur la notion même de grandeurs physiques, qui a

pris une forme nouvelle nécessitant l’emploi de probabilités.

Considérons par exemple une particule de masse m pouvant se

déplacer sur une droite. En physique pré-quantique, il était permis de

penser que son état pouvait être caractérisé par deux grandeurs, sa

position x sur la droite et sa vitesse v, prenant toutes deux à chaque

instant des valeurs bien définies (même si en pratique ces nombres ne

peuvent être déterminés exactement). La physique quantique a

profondément modifié cette conception intuitive, issue de la physique

à notre échelle. Dans un état quantique, les deux grandeurs physiques

x et v ont quelque chose de « flou » : il est interdit d’imaginer qu’elles

puissent prendre des valeurs précises ; les valeurs de x et v sont

aléatoires, et ne peuvent être définies qu’avec une certaine marge,

mesurée par les fluctuations statistiques ∆x et ∆v. Cet état quantique a

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

1

/

16

100%