Variable aléatoire, espérance, écart

Variable(aléatoire,(espérance,(écart!type,!le#cas#discret

Définitions

1) Soit une expérience aléatoire

ε

et l’ensemble de ses issues (fini ou dénombrable) dénoté par U,

son univers associé. Une variable aléatoire réelle X est une application de U dans

!

qui associe

un nombre réel xi à une issue donnée. La notation X = xi correspond à l’événement de

!(U)

admettant pour image xi. Ainsi, si une probabilité est définie sur

!(U)

alors on notera la

probabilité de l’événement admettant xi pour image par P(X = xi) ou plus simplement (s’il n’y a

pas de confusion possible) par

pi

.

On appelle loi de probabilité (ou distribution) l’ensemble des couples

(xi;pi)

.

Exemple.

ε

est « lancer deux dés non pipés », U = {(i ; j) où

1!i!6

et

1!j!6

}.

X: (i;j)!("1)i+j(i+j)

. On gagne cette somme si l’image est > 0 sinon on la perd !

P(X=12) =1 / 36 =P(X=2)

;

P(X=!11) =1/ 18

etc.

Question. Ce jeu est-il équitable ? Pour y répondre déterminons le « gain moyen ».

2) L’espérance mathématique d’une variable aléatoire X est la somme des images xi

pondérées par leur probabilité P(X = xi). En somme c’est une sorte de valeur moyenne

obtenue après n itérations de l’expérience aléatoire

ε

.

Elle se note et se calcule par :

E(X)=xi!P(X=xi)

1"i"n

#=xi!pi

1"i"n

#

ou encore

µ

X

Exercice. Montrer que pour le jeu précédent E(X) = 0 et donc qu’il est équitable.

3) Pour mesurer la dispersion autour de la moyenne on introduit la notion de variance et

d’écart type des concepts à la base issus des sciences statistiques.

Par définition la variance se note et s’obtient ainsi :

V(X)=E(X!

µ

X)2

"

#$

%=(xi

i

&!

µ

X)2'pi

Au verso figure une preuve (élémentaire) de la formule de König :

V(X)=E(X2)!(E(X))2

Preuve de la formule de König.

V(X)=E(X!

µ

X)2

"

#$

%=(xi

i

&!

µ

X)2'pi=x2

i

i

&'pi!2

µ

Xxi

i

&'pi+

µ

2

Xpi

i

&=

=E(X2)!2

µ

2

X+

µ

2

X=E(X2)!(E(X))2=

µ

X2!

µ

2

X

On appelle écart type le nombre

!

=V(X)

. Ce nombre correspond encore mieux à une

mesure de dispersion autour de

µ

puisqu’il admet les mêmes unités que

µ

.

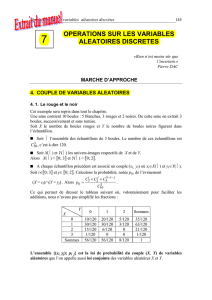

4) Si X et Y sont deux variables aléatoires discrètes alors on définit

pij =P(X=xi,Y=yj)

,

la probabilité conjointe. On dit que X et Y sont indépendantes si

!i et j

on a

P(X=xi,Y=yj)=P(X=xi)P(Y=yj)

ou plus simplement

pij =pi!pj

.

Par définition on pose :

E(X+Y)=pij (xi+yj)

i,j

!

et

E(X!Y)=pij (xiyj)

i,j

"

Preuves.

1)

E(X+Y)=(xi+yj)pij =

i,j

!(xipij +yjpij )=

i,j

!xipij +

j

!

i

!yjpij =

i

!

j

!xipi+yjpj

j

!=

i

!E(X)+E(Y)

Remarque. Ci-dessus nous avons utilisé le fait que :

E(X)=xipi=

i

!xipij

i,j

!

où i et j

parcourent toutes les valeurs possibles des variables aléatoires X et Y.

2)

E(XY )=xiyjpij

i,j

!=xiyjP(x=xi,y=yj)

i,j

!=

indep.

var.

xiyjP(x=xi)P(y=yj)

i,j

!

=xiP(x=xi)

i

!"yjP(y=yj)

j

!=E(X)"E(Y)

3)

V(X+Y)=

König

par

(xi+yj)2pij !

µ

2

X+Y=

i,j

"(x2

i+2xiyj+y2

j)pij !(E(X+Y))2

i,j

"

=

esper.

linéar.

x2

ipij

i,j

"+2xiyjpij

i,j

"+y2

jpij

i,j

"!(E(X)+E(Y))2

=x2

ipij

i,j

"+2xiyjpij

i,j

"+y2

jpij

i,j

"!

µ

X

2!2

µ

X

µ

Y!

µ

Y

2

=

Remar

par

x2

ipi

i

"+2xiyjpij

i,j

"+y2

jpj

j

"!

µ

X

2!2

µ

X

µ

Y!

µ

Y

2

=

indep

par

x2

ipi

i

"+2xiyjpipj

i,j

"+y2

jpj

j

"!

µ

X

2!2

µ

X

µ

Y!

µ

Y

2

=x2

ipi

i

"+2xipiyjpj

j

"

i

"+y2

jpj

j

"!

µ

X

2!2

µ

X

µ

Y!

µ

Y

2

=

µ

X2+2

µ

X

µ

Y+

µ

Y2!

µ

X

2!2

µ

X

µ

Y!

µ

Y

2

=

µ

X2!

µ

X

2+

µ

Y2!

µ

Y

2

=

König

par

V(X)+V(Y)

Soit une épreuve « genre binaire » (réussie ou ratée) répétée n-fois (épreuves identiques).

On note Xi la variable aléatoire prenant la valeur 1 si ‘réussi’, 0 sinon, au i-ième essai.

Une telle variable aléatoire s’appelle de Bernoulli (1685).

Supposons

P(Xi=1) =p

(un nombre compris entre 0 et 1) et donc

P(Xi=0) =1!p

.

Posons

X=X1+X2+X3+!+Xn

la variable aléatoire qui somme le nombre de réussites.

Alors

E(X)=E(X1+X2+X3+!+Xn)=E(X1)+!+E(Xn)=np

et

V(X)=V(X1+!+Xn)=V(X1)+!+V(Xn)=

µ

X1

2!

µ

X1

2

( )

n=(p!p2)n=(1!p)pn

La variable aléatoire qui compte le nombre k de réussites sur n épreuves s’appelle une loi

binomiale (de paramètre n et p). On la note et elle s’obtient par :

P(X=k)=n

k

!

"

#$

%

&pk(1'p)n'k

Exercice. Montrer que 1)

P(X=k)

k=0

n

!=1

2)

µ

=np

3)

!

2=V(X)=np(1"p)

Théorème. Soit X et Y des variables aléatoires discrètes relatives à une épreuve

ε

. Alors

1)

E(X+Y)=E(X)+E(Y)

2) Si X et Y sont indépendantes alors

E(X!Y)=E(X)!E(Y)

3) Si X et Y sont indépendantes alors

V(X+Y)=V(X)+V(Y)

1

/

2

100%