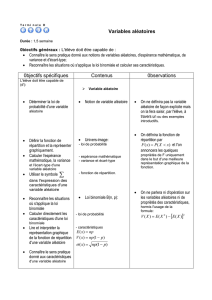

Chapitre IV : Les lois de probabilité usuelles

Chapitre IV : Les lois de probabilité usuelles ___________________________________________________ 2

IV.1 : Les lois discrètes __________________________________________________________________ 2

IV.1.1 : Loi de Dirac ___________________________________________________________________ 2

IV.1.2 : Loi indicatrice (ou loi de Bernoulli) ________________________________________________ 2

IV.1.3 : Loi de Poisson _________________________________________________________________ 2

IV.1.4 : Loi Binomiale _________________________________________________________________ 3

IV.1.5 : Loi multinomiale _______________________________________________________________ 3

IV.1.6 : Loi hypergéométrique ___________________________________________________________ 3

IV.2 : Lois continues ____________________________________________________________________ 4

IV.2.1 : Loi uniforme __________________________________________________________________ 4

IV.2.2 : Loi gamma ____________________________________________________________________ 4

IV.2.3 : Loi normale unidimensionnelle ____________________________________________________ 5

IV.2.4 : Loi normale multidimensionnelle __________________________________________________ 5

IV.2.5 : Loi Log-normale _______________________________________________________________ 5

IV.2.6 : Loi de Khi-deux (Χ²) ____________________________________________________________ 6

IV.2.7 : Loi de student__________________________________________________________________ 6

IV.2.8 : Loi de Fisher-Snedecor : _________________________________________________________ 6

1

Chapitre IV : Les lois de probabilité usuelles

IV.1 : Les lois discrètes

IV.1.1 : Loi de Dirac

Définition :

Soit a ∈—, un point fixé. On appelle loi de Dirac au point a la probabilité δa définie sur — par :

δa(x) = 1 si x = a

δa(x) = 0 si x ≠ a

Moments :

Si X O δa (X est une variable aléatoire qui suit la loi de δa).

Soit X une variable aléatoire tel que ∀w∈Ω X(w) = a E(X) = a

Si X est discret : Ω⊂Õ E[X] = P(X=a).a = δa(a).a = a

Si X est continue : Ω⊂— E[X] = P(X=a).a = a

IV.1.2 : Loi indicatrice (ou loi de Bernoulli)

Définition :

On appelle variable indicatrice X la variable à valeurs dans {0, 1} telle que

PX{1} = p et PX{0} = q avec

p∈[0, 1] et q = 1-p

et on la note par B(p).

XOB(p)

E[X] = 0*P(X=0) + 1*P(X=1) = p

V(X) = E[X²] – E²[x] = 0*P(X=0) + 1*P(X=1) – p² = p – p² = p(1-p) = pq.

IV.1.3 : Loi de Poisson

La variable aléatoire X suit la loi de Poisson de paramètre λ (λ>0) si X = Õ et ∀x∈Õ PX{x} = !x

x

λ

λ

−

e

On note XOP(λ).

Les moments :

()

λλλλ

λλ

λ

λ

λλ

λ

λ

λ

λ

λ

λ

λ

λ

λλ

ϕϕ

ϕϕ

λλ

λ

λ

λ

λ

λ

λλλλλ

λλ

λλλλλ

λ

=−+=

+=

+==+

−

=+=+=

=

−

====

==

=

=

−=

===

−

==

∑∑∑∑∑

∑∑∑

∑

∫

∑∑∑

∞+

=

−

∞+

=

−

−

∞+

=

−

∞+

=

−

∞+

=

−

∞+

=

−

∞+

=

−

∞+

=

−

+∞

=

−

+∞

=

−

−

+∞

=

−

22

22

0

2

1

1

2

000

110

2

2

22

00

1

0

)(

][

!)!1(!!!

)1(

)!1(!

²)(²][

)()()]([

)()()]([

?][

][][)(

.

!)!1(!

][

XV

XE

x

e

x

e

x

e

x

xe

x

xe

x

xe

x

exxXPxXE

xXPxXE

dxxfxXE

XE

XEXEXV

ee

y

e

x

e

x

xeXE

x

x

x

x

x

x

x

x

x

x

x

x

x

x

x

x

e

y

y

x

x

x

x

321

2

IV.1.4 : Loi Binomiale

On considère n tirages équiprobables indépendants dans une population composée de deux types d’éléments.

Le premier (I) en proportion p.

Le second (II) en proportion q = 1-p.

Soit X le nombre d’éléments du type (I) présent dans l’échantillon de taille n.

X est une variable aléatoire à valeur dans {0, 1, …, n}.

La loi de X est appelée loi binomiale de paramètre (n, p) et est notée B(n, p).

Supposons qu’à l’individu n)i de l’échantillon (i=1 à n) on associe la variable aléatoire Yi tel que

P(Yi=1) = p si i∈(I)

P(Yi=0) = 1-p si i∈(II)

Alors .

∑

=

=n

i

i

YX

1

Comme YiOB(p), on peut écrire que la loi binomiale B(n, p) est la somme de n lois de Bernoulli indépendantes.

npqpqYVXVnppYEXE

n

i

n

i

i

n

i

n

i

i====== ∑∑∑∑ ==== 1111

][][][][

Définition :

Une variable aléatoire X suit une loi binomiale de paramètre (n , p) si :

{}()

xnxx

n

XqpCxP −

= pour x∈{0, 1, …, n}.

IV.1.5 : Loi multinomiale

C’est la généralisation de la loi binomiale. On considère m types dont chaque type j est en proportion pj avec

. 1

1

=

∑

=

m

j

j

p

On tire de façon équiprobable et indépendante, un échantillon de taille n, et on définit la variable aléatoire Nj

(1≤j≤m) à valeur dans {0, 1, …, n}, représentant le nombre d’éléments de type j.

On dit que le vecteur (N1, …, Nm) suit une loi multinomiale de paramètre (n, p1, …, pm), notée M(n, p1, …, pm).

Définition :

Le vecteur aléatoire X = (N1,…, Nm) suit une loi multinomiale de paramètres (n, p1, …, pm) ; pj>0 et 1

1

=

∑

=

m

j

j

p

Si PX{(n1, …, nm)}= m

n

m

n

m

PP

nn

n...

!!...

!1

1

1

IV.1.6 : Loi hypergéométrique

On considère un tirage équiprobable sans remise de n éléments dans une population de taille N (n≤N), on

s’intéresse à un type donné (I), d’éléments de la population, que l’on supposera être de proportion p.

Soit X le nombre d’éléments de type (I). La loi de X est appelée : loi hypergéométrique de paramètre N, n, p et

est notée H(N, n, p).

Définition :

X suit une loi hypergéométrique de paramètres N, n, p si :

{}

n

N

xn

NQ

x

Np

X

C

CC

xP

−

= avec q=1-p et Max(0, n-Nq) ≤x≤Min(n, Np)

Remarque :

Np est un entier.

Moments :

E[X] = np npq

N

nN

X1

)( −

−

=V

3

IV.2 : Lois continues

IV.2.1 : Loi uniforme

Définition :

X suit une loi uniforme sur [a, b], si sa densité est donnée par : )(1.

1

)( ],[ x

ab

xf ba

−

=

On note par XOU[a, b].

La fonction de répartition est ab

ax

xF −

−

=)( pour x∈[a, b]

ab

ax

dx

ab

dxdxx

ab

dxxfxXPxF aax

ba

x

−

−

=

−

+=

−

==≤= ∫∫∫∫ ∞−∞−∞−∞−

1

0)(1.

1

)()()( ],[

Moments :

XOU[a, b]

()

2

)(

2

][

2

ab

xV

ba

XE −

=

+

=

IV.2.2 : Loi gamma

Définition :

X suit la loi gamma de paramètre p et ϑ ; p>0 ; ϑ>0, notée γ(p, ϑ) si sa densité est :

∫∞+ −−−− =Γ

Γ

=+0

11 )()(1.

)(

)( dxxepoùxxe

p

xf px

R

px

p

ϑ

ϑ

Remarques :

a) Si le paramètre d’échelle ϑ est égale à 1 on écrira γ(p, 1) ou γ(p).

Si ϑ≠1 la variable aléatoire Y = ϑX suit γ(p).

b) Si p = 1, la loi gamma γ(1, ϑ) porte le nom de loi exponentielle de paramètre ϑ et sa fonction de

répartition est F(x) = 1-e -ϑx.

Propriétés de Γ :

Γ(p) = (p-1) Γ(p-1) ; ∀p>0

Γ(p) = (p-1)! ∀p∈Õ*

π

=Γ )

2

1

(.

Moments :

Si X suit une loi γ(p, ϑ) on a : ²

)(;][

)(

)(

][

ϑϑ

ϑ

p

XV

p

XE

p

rp

XE r

r==

Γ

+Γ

=

4

IV.2.3 : Loi normale unidimensionnelle

Définition :

X suit une loi normale de paramètres m, Γ (Γ>0) si la densité est donnée par ²2

)²(

2

1

)( Γ

−

−

Γ

=

mx

exf

π

x∈—.

On note par XON(m, Γ).

Moments : E[X] = m ; V(X) = Γ²

Loi normale centrée réduite :

La variable aléatoire Γ

−

=mX

u suit une loi normale de moyenne nulle et de variance égale à 1 notée N(0, 1)

et 2

²

2

1

)(

u

ueuf −

=

π

X centrée ⇔ E[X] = 0

X réduite ⇔ V(X) = 1

IV.2.4 : Loi normale multidimensionnelle

Soit X un vecteur aléatoire de —p de coordonnées Xi.

Définition :

Soit u un vecteur quelconque de —

=

n

u

u

..

1

p.

X est un vecteur normal ( au gaussien) si ∀u ; tuX est une variable aléatoire normale.

Définition :

Soit m∈ —p et Σ une matrice (p, p) réelle symétrique positive.

X est un vecteur normal de dimension p si sa densité est donnée par :

()

)()(2/1

2/

1

det2

1

)( mxmx

p

t

exf −Σ−− −

Σ

=

π

Propriété :

E[X] est le vecteur espérance m et Σ est la matrice de variance-covariance et on note la loi X par N(m, Σ).

Définition :

La loi N(0, Ip) est appelée loi normale centrée et réduite de densité

()

∑

==

−

p

i

i

x

p

pexxf 1

2

2/1

2/

12

1

),..,(

π

IV.2.5 : Loi Log-normale

Soit Y une variable aléatoire ON(m, Γ).

La variable aléatoire X définie par X = exp Y suit une loi Log-normale.

La densité de X est :

()

)(1.

²2

log

exp

2

1

)(

2

x

mx

xf R+

Γ

−

−

Γ

=

π

5

6

6

1

/

6

100%