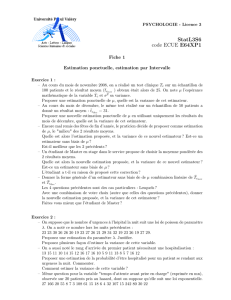

Estimation ponctuelle - Mathématiques en ECE 2

\

X

PXX(Pθ)θ∈R

θ

B(n, p)pP(λ)λ . . .

θ

p

X=(0

1

X → B(p)p

X Y

I J R

P([X∈I]∩[Y∈J]) = P(X∈I)P(Y∈J)

(Xn)n∈N

A={i1;. . . ;in} ⊂ NI1, . . . , InR

P n

\

k=1

Xik∈Ik!=

n

Y

k=1

P(Xik∈Ik).

\

(X1, X2, . . . , Xn)

X1,...XpXp+1, . . . , Xn

(X1, X2, X3, X4, X5, X6)Y1=X1+X4Y2=X2+X5Y3=X3+X6

X λ

λX

E(λX) = λE(X).

X1, . . . , Xn

n

P

i=1

Xi

E n

X

i=1

Xi!=

n

X

i=1

E(Xi).

X Y X ≤Y

E(X)≤E(Y).

X Y

XY

E(XY ) = E(X)E(Y).

X Y

X+Y

V(X+Y) = V(X) + V(Y).

n

\

n PXX n X

X

X1, . . . , Xn

x1, . . . , xn

θ Tn=ϕ(X1, X2, . . . , Xn)ϕ

θ n

tn=ϕ(x1, . . . , xn)Tnθ

(x1, . . . , xn)

Tnθ θ

θ

Tnθ

Tnn

N∗

(Tn)n≥1n

n

Tnbθ(Tn) = E(Tn)−θ

(Tn)θ θ

bθ(Tn)=0 E(Tn) = θ Tn

θ

Tnn+∞

θ Tn

TnRθ(Tn) = V(Tn−θ)2

Tnθ θ

TnTn

Rθ(Tn) = bθ(Tn)2+V(Tn)

\

Tn

Rθ=E(Tn−θ)2=E([Tn−E(Tn)] + [E(Tn)−θ])2

Rθ=E[Tn−E(Tn)]2+ [E(Tn)−θ]2+ 2[Tn−E(Tn)][E(Tn)−θ]

Rθ=EV(Tn)+[bθ(Tn)]2+ 2bθ(Tn)[Tn−E(Tn)]

Rθ=V(Tn)+[bθ(Tn)]2+ 2bθ(Tn)E[Tn−E(Tn)]

Rθ=V(Tn)+[bθ(Tn)]2+ 2bθ(Tn)[E(Tn)−E(Tn)]

Rθ=V(Tn)+[bθ(Tn)]2

θ

(Tn)n≥1θ θ

ε > 0

lim

n→+∞P|Tn−θ|> ε= 0.

Tn

(Tn)n≥1θ θ lim

n→+∞Rθ(Tn)=0

(Tn)n≥1

\

p

Tn=1

n

n

P

i=1

Xip

n

P

i=1

Xin p np

np(1 −p)

bp(Tn) = E1

n

n

P

i=1

Xi−p=1

n×np −p= 0

Rp(Tn) = 1

n2Vn

P

i=1

Xi=np(1−p)

n2=p(1−p)

n−−−−−→

n→+∞0

Tn

λ

X → P(λ)

Tn=1

n

n

P

i=1

Xiλ

n

P

i=1

Xinλ nλ

nλ

bλ(Tn) = E1

n

n

P

i=1

Xi−λ=1

n×nλ −λ= 0

Rλ(Tn) = 1

n2Vn

P

i=1

Xi=nλ

n2=λ

n−−−−−→

n→+∞0

Tn

X

m

Tn=1

n

n

P

i=1

Xim

bm(Tn) = E1

n

n

P

i=1

Xi−m=1

n

n

P

i=1

E(Xi)−m=1

n

n

P

i=1

m−m=1

n×nm −m= 0

V(X)

n2

X

X

6

6

1

/

6

100%