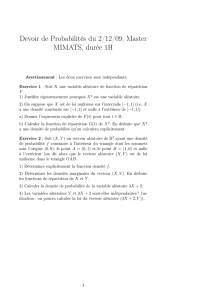

Probabilités Avancées : Chaînes de Markov et Martingales

Probabilités avancées

Cours de Master Avancé 1, ENS Lyon

Cours de Christophe Garban

septembre-décembre 2014

Ces notes sont celles d’un cours de deuxième année donné à l’ENS Lyon en 2014. Elles ont été rédigées

par P. UMBER (conditionnement et chaînes de Markov) et M. DUSSAULE (martingales). Les erreurs

qui s’y trouvent ne sont aucunement du fait de C. Garban. D’autre part, même s’il s’agit essentiellement

du cours de C. Garban, on pourra trouver des notes prises à partir d’autres cours, typiquement pour

la démonstration de certains résultats que C. Garban n’a pas eu le temps de prouver. Ces autres notes

proviennent principalement de [3]. D’ailleurs, selon les mots de l’enseignant, ce cours est très proche de

[3]. Il en diffère cependant par les exemples et par quelques digressions.

Ce cours, sobrement intitulé probabilités avancées, développe la théorie des chaînes de Markov et des

martingales. Il s’agit donc plus spécifiquement d’un cours sur les processus aléatoires à temps discrets.

On commencera par quelques rappels en théorie générale des probabilités, notamment sur les questions

de conditionnement, qui interviendront tout au long du cours.

Table des matières

1 Espérance conditionnelle 2

1.1 Préambule............................................. 2

1.2 Espéranceconditionnelle..................................... 2

1.3 Propriétés plus spécifiques de l’espérance conditionnelle . . . . . . . . . . . . . . . . . . . 4

2 Chaînes de Markov 4

2.1 Définition et premières propriétés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.2 Chaîne de Markov canonique et propriétés de Markov . . . . . . . . . . . . . . . . . . . . 8

2.3 Classificationdesétats...................................... 11

2.4 Chaînes de Markov et mesures invariantes . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

3 Martingales 22

3.1 Martingales, sur-martingales, sous-martingales . . . . . . . . . . . . . . . . . . . . . . . . 22

3.2 Convergence(s) des martingales . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

3.3 Quelques résultats sur les temps d’arrêts . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

3.4 Martingalesrétrogrades ..................................... 32

Intoduction

Commençons ce cours par un exemple simple. Considérons la marche aléatoire d’un cavalier sur un

échiquier, partant de la case en bas à gauche x0, et notons Xnla variable aléatoire qui prend en compte

la position du cavalier au temps n. Notons enfin Tle premier temps de retour du cavalier en xo. Le but

de l’excercice est de calculer l’espérance E[T]. On peut montrer que cette espérance est finie et même

calculer sa valeur :

E[T] = X

n≥1

P(T=n)n=X

npair

P(T=n)n= 21

6+.. = 168.

Nous verrons plus loin dans ce cours comment y arriver une fois les bons outils développés. L’idée est,

comme en théorie ergodique, de considérer une moyenne temporelle que l’on veut réexprimer en moyenne

spatiale, considérer une suite de mesures µnet de considérer sa "limite" µ∞. L’objet de ce cours est plus

1

1 ESPÉRANCE CONDITIONNELLE 2

généralement l’étude de processus aléatoires, indéxés sur un ensemble dénombrable à valeur dans un

espace mesurable (E, E).

Exemple. On a quelques exmples issus de la vie courante, comme le CAC (mais impossible à modéliser),

le relevé d’un sismographe, le casino, qui peut être modélisé via une sur-martingale (que nous verrons

dans la troisième partie de ce cours), le relevé d’une bouteille à la mer, les pages web internet, ou encore

le mélange d’un jeu de cartes.

Exemple. On a aussi des exemples plus mathématiques, comme l’étude d’une suite de varaiables aléa-

toires indépendantes, à veleur dans Ret considérer la suite des sommes partielles, une marche aléatoire

dans un graphe, dans un groupe, ou encore l’étude du processus de branchement de type Galton-Watson.

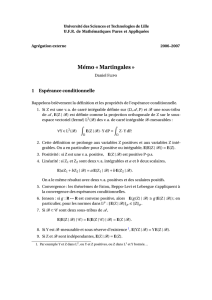

1 Espérance conditionnelle

1.1 Préambule

Définition 1.1.1. Soit (E, E)un espace mesurable. Une filtration de (E, E)est une suite croissante

(Fn)de sous-tribus de E. L’espace (E, E,(Fn)) est appelé espace mesurable filtré et si Pest une

probabilité sur Ω, on dit que (Ω,E,(Fn),P)est une espace de probabilité filtré.

Exemple. On considère l’espace mesurable (E, E) = ([0,1],B([0,1])) que l’on muni de la filtration

dyadique donnée par F0={∅,[0,1]},F1={∅,[0,1

2],[1

2,1],[0,1]}...

1.2 Espérance conditionnelle

On fixe (Ω,F,P)un espace de probabilité.

Théorème 1.2.1. Soient Xune variable aléatoire dans L1(Ω,F,P)et Gune sous-tribu de F. Alors il

existe une uique variable aléatoire Zdans L0(Ω,G,P), telle que Zest dans L1(Ω,G,P)et :

∀B∈ G,E[X1B] = E[Z1B].

Zest appelée espérance conditionnelle de Xsachant Get on la note E[X|G].

Remarque. De manière équivalente, E[X|G]est l’unique variable aléatoire dans L1(Ω,G,P)telle que, pour

tout Yvariable aléatoire G-mesurable bornée, E[XY ] = E[E[X|G]Y].

Cette propriété est appelée propriété caractéristique de l’espérance conditionnelle. On notera

que l’espérance conditionnelle est une variable aléatoire, et que si Xest déjà G-mesurable, alors on a la

relation E[X|G] = X.

Définition 1.2.1. Avec les mêmes notations, si (Yi)est une famille de variables alétoires, on pose

E[X|(Yi)] := E[X|σ((Yi))] .

On peut interpréter E[X|Y]de la manière suivante : Si ωest un point de Ω, choisi au hasard, dont

la seule information que l’on dispose est la valeur Y(ω), alors E[X|Y](ω)est la valeur moyenne de Xen

prenant compte de l’information Y(ω), comme déterminer la température moyenne d’un lieu en prenant

compte de son altitude.

Définition 1.2.2. Soit A∈ F, on pose P(A|G) := E[1A|G]que l’on appelle probabilité conditionnelle

de Asachant G.

Exemple. Si Ωest la population Française et Gest la tribu engendrée par l’ensemble B1des personnes

qui vivent en Île de France et B2l’ensemble de celles qui vivent dans le Rhône, en notant Tle temps

moyen de transport par jour, alors E[T|G] = 1B12h+1B21h+1Ω−B1∪B215min.

Exemple. Si fest une fonction L1sur ]0,1],Gnest la filtration dyadique, et si l’on pose In,i :=] 1−i

2n,i

2n],

alors E[f|Gn] =

2n

X

i=1

2nZIn,i

f1In,i . Cela approxime la fonction f par des rectangles.

Pour pouvoir démontrer ce théorème, nous allons dans un premier temps démontrer une version L2

du théorème de l’espérance conditionnelle.

1 ESPÉRANCE CONDITIONNELLE 3

Théorème 1.2.2. Soient Xune variable aléatoire dans L2(Ω,F,P)et Gune sous-tribu de F. Alors il

existe une unique variable aléatoire Zdans L2(Ω,G,P)et qui vérifie

∀Y∈L2(Ω,G,P),E[XY ] = E[ZY ].

On notera encore E[X|G]la variable Z. Si de plus Xest positive, alors Zl’est aussi.

Démonstration. Commençons par montrer l’unicité. Si Zet Z0sont deux variables qui vérifient le théo-

rème, alors, on pose B:= {Z > Z0}∈G. On a E[X1B] = E[Z1B] = E[Z01B]donc E[(Z−Z0)1Z>Z0] = 0.

Ainsi on a Z≤Z0presque sûrement. De même, Z0≤Z, donc Z=Z0presque sûrement. Pour l’exis-

tence, on sait que L2est un espace d’Hilbert, et L2(Ω,G,P)est un sous-espace fermé de L2(Ω,F,P)car

complet. Ainsi, on a la décomposition L2(Ω,F,P) = L2(Ω,G,P)⊕L2(Ω,G,P)⊥. On note πla projection

orthogonale sur L2(Ω,G,P), et l’on pose Z:= π(X). Soit Y∈L2(Ω,G,P), on a alors :

E[XY ] = hX, Y i

=hπ(X)+(X−π(X)), Y i

=hπ(X), Y i

=E[ZY ]

Ceci montre l’existence. Démontrons la dernière proposition : Si P(E[Z|G]<0) >0, alors il existe

> 0tel que P(E[Z|G]<−)>0. On pose alors B:= {E[Z|G]<−}qui est un élément de G. Alors

0<E[E[Z|G]1B] = E[Z1B]≥0ce qui est absurde, d’où le résultat.

On peut noter deux conséquences de ce théorème :

— Si X∈L2(Ω,G,P), alors on a E[X|G] = X.

— Si G1⊂ G2sont deux sous-tribus de F, alors E[E[X|G2]|G1] = E[X|G1].

Passons à présent à la preuve de la première version du théorème :

Démonstration. On prouve de la même manière que dans le cas L2l’unicité de l’espérance conditionnelle.

Intéressons-nous à l’existence : On suppose donc X∈L1(Ω,F,P). Supposons de plus que X≥0. On

pose Xn:= X1{X≤n}. La suite (Xn)est croissante et chaque Xnest dans L2car bornée et positive,

donc E[Xn|G]est positive. On pose alors E[X|G] := lim

n

E[Xn|G]. La variable E[X|G]est bien dans L1car

(E[E[Xn|G]]) converge vers E[E[X|G]] par théorème de convergence monotone et E[E[Xn|G]] = E[Xn],

avec (E[Xn]) qui converge vers E[X]par théorème de convergence monotone. De plus, Si B∈ G , on

pose Y:= 1B, alors la suite (XnY)est croissante et converge vers XY . De même, la suite (E[Xn|G]Y)

est croissante et converge vers E[X|G]Y, on conclu donc en passant par l’espérance et en utilisant le

théorème de convergence monotone. Dans le cas général, lorsque Xest non positif, on décompose Xen

sa partie positive et négative et on conclu par linéarité.

Proposition 1.2.3. L’espérance conditionnelle vérifie les propriété suivantes :

— L’espérance conditionnelle est positive

— L’espérance conditionnelle est linéaire

—E[E[X|G]] = E[X]

—|E[X|G]| ≤ E[|X||G]

— Convergence monotone conditionnelle : Si (Xn)est une suite croissante de variables aléatoires

positives qui converge vers X, alors (E[Xn|G]) converge vers E[X|G].

— Fatou conditionnelle : Si (Xn)est une suite de variables aléatoires positives, alors on a l’inégalité

E[lim inf Xn|G]≤lim inf E[Xn|G].

— Jensen conditionnelle : Si φest une fonction convexe positive, alors E[φ(X)|G]≥φ(E[X|G]).

Démonstration. Démontrons le quatrième point. On a :

|E[X|G]|=|E[X+|G]−E[X−|G]|

≤E[X+|G] + E[X−|G]

=E[|X||G].

2 CHAÎNES DE MARKOV 4

Démontrons le dernier point. On pose Eφ:= {(a, b)∈R2,∀x∈R, φ(x)≥ax +b}. Alors :

E[φ(X)|G] = E[ sup

(a,b)∈Eφ∩Q

aX +b|G]

≥sup

(a,b)∈Eφ∩Q

E[aX +b|G]

= sup

(a,b)∈Eφ∩Q

aE[X|G] + b

=φ(E[X|G]).

On considère la borne supérieure sur un ensemble dénombrable pour pouvoir sortir le sup de l’espé-

rance conditionnelle.

1.3 Propriétés plus spécifiques de l’espérance conditionnelle

Proposition 1.3.1. — Soient Xet Ydeux variables aléatoires réelles telles que Xet XY sont dans

L1et Yest G-mesurable. Alors on a la propriété de factorisation suivante : E[XY |G] = YE[X|G].

— Si G1⊂ G2sont deux sous-tribus de F, alors E[E[X|G2]|G1] = E[X|G1].

Démonstration. Pour le premier point, on peut supposer Xet Ypositive, et soit Zune variable aléatoire

positive G-mesurable. On a E[(E[X|G]Y)Z] = E[(E[X|G])Y Z] = E[XY Z] = E[E[XY |G]Z]. On a donc le

résultat. Le deuxième point se traite de manière analogue.

Proposition 1.3.2. Soit G1et G2deux sous-tribus de F. Alors : G1et G2sont indépendantes si et

seulement si pour tout Xvariable aléatoire positive G1-mesurable, on a E[X|G2] = E[X].

Démonstration. On suppose G1et G2indépendantes. Soient B∈ G1,A∈ G2. On a

E[1B1A] = E[1A∩B] = E[1A]E[1B] = E[E[1A]1B],

donc E[1B|G2] = E[1B], puis l’égalité est encore vraie pour toute variable aléatoire positive.

Réciproquement, si pour tout Xvariable aléatoire positive G1-mesurable, on a E[X|G2] = E[X],

considérons B∈ G2,A∈ G1. Par hyposthèse, on a P(A) = E[1A|G2], donc

P(A∩B) = E[1A1B] = E[E[1A|G2]1B] = P(A)P(B).

Corollaire 1.3.3. Si Xet Ysont deux variables aléatoires positives ou dans L1alors Xet Ysont

indépendantes si et seulement si, pour toute fonction numérique hpositive, on a E[h(X)|Y] = E[h(X)].

Ainsi, si Xet Ysont indépendantes, avec Xpositive ou dans L1, alors E[X|Y] = E[X]. Cette dernière

proposition n’est cependant pas une équivalence.

Notons pour terminer une expression de l’espérance conditionnelle dans le cas où Yest une variable

aléatoire à valeur dans un ensemble Edénombrable et Xune variable aléatoire dans L1. Alors on a

E[X|Y] = φ(Y)où φest une fonction de Edans Rtelle que, pour y∈E,φ(y) = 1

P(Y=y)E[X1{Y=y}]si

P(Y=y)>0et prend une valeur quelconque sinon, E[X|Y]étant de toute façon définie à un ensemble

de mesure nulle près.

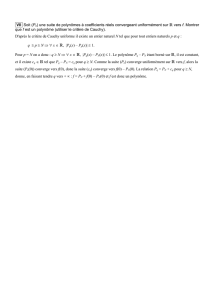

2 Chaînes de Markov

Dans tout ce chapitre, Esera un ensemble fini ou dénombrable, dit espace d’états.

2.1 Définition et premières propriétés

Définition 2.1.1. Une matrice de transition ou matrice stochastique est une matrice Qindexée

sur Etelle que : ∀x, y ∈E, Q(x, y)∈[0,1] et ∀x∈E, X

y∈E

Q(x, y) = 1.

2 CHAÎNES DE MARKOV 5

Définition 2.1.2. Soient Qune matrice de transition et (Xn)un processus aléatoire. La suite (Xn)est

une chaîne de Markov de matrice de transition Qsi pour tout net pour tous x0, .., xn∈E, si

P(X0=x0, .., Xn=xn)>0, alors

∀y∈E, P(Xn+1 =y|X0=x0, .., Xn=xn) = Q(xn, y).

Cette propriété est dite propriété de Markov. On parle aussi d’absence de mémoire. On montre

facilement que cette propriété est équivalente à la suivante :

pour tout net pour tous x0, .., xn∈E,

P(X0=x0, .., Xn=xn) = P(X0=x0)Q(x0, x1)..Q(xn−1, xn).

Avec la seconde forme de la propriété de Markov, on voit qu’une chaîne de Markov de matrice de

transition Qest entièrement déterminée par sa condition initiale, c’est-à-dire la donnée des P(X0=x0).

Définition 2.1.3. Soit (Xn)une chaîne de Markov. On définit la loi initiale de la chaîne de Markov

par µ0:x07−→ P(X0=x0). Le couple (Q, µ0)est appelé mécanisme de transition. On pose aussi

µn:= PXn.

Exemple. Soit (Xn)une chaîne de Markov de matrice de transition Q. Si p≥1est un entier et si l’on

pose Yn:= Xnp, alors (Yn)définie une chaîne de Markov de matrice de transition Qp.

Remarque. On verra plus tard une manière canonique de construire une chaîne de Markov en se donnant

un mécanisme de transition.

On considère à présent (Xn)une chaîne de Markov de matrice de transition Qsur l’espace E.

Proposition 2.1.1. —µn=µ0Qn

— Pour toute fonction positive bornée de Edans R, on a µn(f) = Eµ0[f(Xn)] = µ0Qnf.

Remarque. On a utilisé dans la dernière proposition la notation naturelle matricielle où les mesures sont

des vecteurs lignes et les fonctions sont des vecteurs colonnes.

Démonstration. Démontrons par exemple la première proposition : soit y∈E. On a

µn(y) = X

x0∈E

P(X0=x0, Xn=y)

=X

x0,...,xn∈E

xn=y

P(X0=x0, .., Xn=xn=y)

=X

x0,...,xn∈E

xn=y

µ0(xo)Q(x0, x1)..Q(xn−1, y)

=µ0Qn(y).

Exemple. Considérons la chaîne de Markov à deux états aet bde matrice de transition définie par

Q=Å1−

1− ã, avec ∈]0,1[. On pose µ0:= δa. On a alors µ1=δa+ (1 −)δb. En itérant,

on peut montrer que (µn)converge en loi vers 1

2µa+1

2µb. On remarque que pour = 0 il n’y a pas

convergence de la mesure.

Définition 2.1.4. Soit µune mesure positive non nulle sur E, finie en chaque point. La mesure µest

dite invariante pour Qsi µQ =µ.

Proposition 2.1.2. Soit (Q, µ0)un mécanisme de transition. On suppose qu’il existe une mesure de

probabilité πtelle que la suite (µn)converge en loi vers π, alors πest une mesure invariante pour Q.

Démonstration. Soit fune fonction réelle bornée définie sur E, alors comme la suite (µn)converge en loi

vers π,µn(f)converge vers π(f). Par ailleurs, µn(f) = µ0Qnfet µn+1(f) = µ0QnQf et Qf est bornée

car Qest une matrice stochastique, donc π(f) = π(Qf), donc π=πQ.

Remarque. Il se peut que Qadmette une mesure invariante mais que le système ne converge pas vers

cette mesure.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

1

/

34

100%