Algèbre Linéaire : Espaces Vectoriels et Sous-Espaces

1

MATHEMATIQUES GENERALES 2

Algebre linaire

Chapitre 1

Espace vectoriel

1 Premières définitions

Définition 1.on appelle espace vectoriel sur Rou R-espace vectoriel un en-

semble Esur lequel on a défini deux lois de composition :

– Une loi interne dite addition, notée + (i.e. une application + : E∗E→E)

vérifiant :

–(x+y) + z=x+ (y+z)pour tout x, y, z ∈E

–x+y=y+xpour tout x, y ∈E

– il existe un élément de E, noté 0E, dit neutre, tel que pour tout x∈E x+0E=x

– soit x∈E; il existe (−x)élément de E dit opposé de x tel que x+ (−x) = 0E

– une loi externe de domaine R(i.e. une application .:R∗E→E,(λ, x)→λx)

vérifiant :

–λ(µx)=(λµ)xpour tout λ, µ ∈Ret x∈E

–(λ+µ)x=λx +µx

–λ(x+y) = λx +λy

–1.x =x

Les éléments de E sont appelés vecteurs et ceux de Rscalaire.

Remarque : On peut remplacer dans la définition Rpar un corps quelconque. Dans

ce cours on notera Kun tel corps et on pensera à K=R,C.

Exemple 1 : Modèle fondamental :

E=Rn=R×... ×R

3

4Calcul matriciel

Exemple : n= 2. Alors E=R×R={(x, y) : x∈Ry∈R}est un R-espace

vectoriel :

on prend les applications :

E×E−→ E

((x1, y1),(x2, y2)) −→ (x1+x2, y1+y2)

comme addition et

R×E−→ E

(λ, (x, y)) −→ (λx, λy)

come multiplication par un scalaire.

On a alors (0,0) comme neutre et −(x, y)=(−x, −y).

Ici les 2-uplets sont les vecteurs et les réels les scalaires.

Exercice : vérifier les axiomes de la définition.

Interprétation géométrique :

Soit P={vecteursdansleplan}:

Définition 2.•Une flèche dans le plan est un segment entre deux points Aet B

orientés.

•Deux flèches sont équivalentes si elles ont mêmes direction, sens et longueurs.

•Les vecteurs du plan sont les classes d’équivalences des flèches.

Addition de vecteurs :

Multiplication par un scalaire :λ~

AB =~

AD où ~

AD a le même sens et la même

direction que AB et la longueur multipliée par λ(si λest positif).

Exemple 2 :

Soit E=Rn[X] = {fonctionspolynomescoefficientdansRdedegr 6n}={P(X) =

a0+a1X+... +anxnai∈R}est un espace vectoriel sur Rmuni des lois :

(a0+a1X+... +anxn)+(b0+b1X+... +bnxn) := ((a0+b0)+(a1+b1)X+... + (an+bn)xn)

λ.(a0+a1X+... +anxn) := (λa0+λa1X+... +λanxn)

Chapitre 1. Espace vectoriel 5

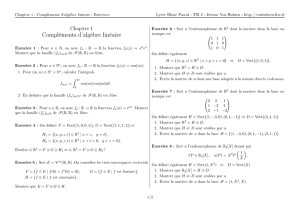

Fig. 1 – Addition de deux vecteurs

Plus généralement E=R[X]qui est l’ensemble des polynomes de tout degré à

coefficient dans Rest un espace vectoriel sur Ravec les lois :

X

k

akxk+X

k

bkxk:= X

k

(ak+bk)xk

λX

k

akxk:= X

k

λakxk

(Les sommes sont finies.)

Exemple 3 :

Soit F(R,R)ensemble des fonctions de Rdans R. On munit cet ensembles des lois

suivantes :

–(f+g)(x) := f(x) + g(x)

–λ(f(x)) := λf(x)

Proposition 1.1. Soit E un espace vectoriel. Alors :

1. 0.x = 0Epour tout x∈E

2. λ.0E= 0E

3. λ.x = 0Eimplique λ= 0 ou x= 0E

4. (−1).x =−xpour tout x∈E

Démonstration. (1)

0.x = 0.x + 0E0Eest le neutre de +

= 0.x+x+(-x) définition de l’opposé

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

1

/

134

100%