Probabilités et statistiques avec Scilab

Université Joseph Fourier (Grenoble I) Année 2010-2011

Préparation à l’agrégation de mathématiques Épreuve de modélisation

Probabilités et statistiques

avec Scilab

version du 6 septembre 2013

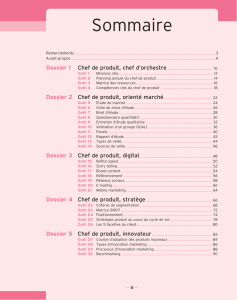

Table des matières

1 Introduction à Scilab 1

1.1 Unpremiercontact................................... 1

1.2 Algèbreélémentaire................................... 3

1.2.1 Vecteursetmatrices .............................. 3

1.2.2 Extraction.................................... 5

1.2.3 Modification, insertion, suppression . . . . . . . . . . . . . . . . . . . . . . 6

1.3 Opérationsmatricielles................................. 6

1.4 Programmation..................................... 9

1.4.1 Utilisation des fichiers . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 9

1.4.2 Fonctions .................................... 9

1.4.3 Opérateurslogiques .............................. 12

1.4.4 Boucle for ................................... 12

1.4.5 Boucle while .................................. 12

1.4.6 Instructions conditionnelles . . . . . . . . . . . . . . . . . . . . . . . . . . 13

1.5 Compléments ...................................... 13

1.5.1 Systèmeslinéaires ............................... 13

1.5.2 Résolution d’équations non linéaires . . . . . . . . . . . . . . . . . . . . . 14

1.5.3 Équations différentielles . . . . . . . . . . . . . . . . . . . . . . . . . . . . 14

1.5.4 Polynômes.................................... 14

1.6 Commandes graphiques de base . . . . . . . . . . . . . . . . . . . . . . . . . . . . 15

1.6.1 Courbes planes et nuages de points . . . . . . . . . . . . . . . . . . . . . . 15

1.6.2 Courbes paramétrées et surfaces en dimension 3 . . . . . . . . . . . . . . . 16

1.6.3 Fenêtres et sous-fenêtres graphiques . . . . . . . . . . . . . . . . . . . . . 16

1.7 Quelquesconseils.................................... 17

1.8 Exercices ........................................ 17

2 Fonctions de base pour les probabilités et les statistiques 19

2.1 Générateursaléatoires ................................. 19

2.1.1 Le générateur rand ............................... 19

2.1.2 La fonction grand ............................... 19

2.1.3 Simulation de lois quelconques . . . . . . . . . . . . . . . . . . . . . . . . 20

2.2 Représentationdelois ................................. 23

2.2.1 Représentation de lois discrètes . . . . . . . . . . . . . . . . . . . . . . . . 23

2.2.2 Représentation de lois à densité . . . . . . . . . . . . . . . . . . . . . . . . 23

2.2.3 Quantiles .................................... 25

2.3 Echantillons....................................... 25

2.3.1 Moyenne, variance, covariance empiriques . . . . . . . . . . . . . . . . . . 25

2.3.2 Répartition en classes : les fonctions dsearch et tabul ........... 25

2.3.3 Représentations graphiques . . . . . . . . . . . . . . . . . . . . . . . . . . 26

i

2.4 Exercices ........................................ 30

3 Loi des grands nombres, méthode de Monte-Carlo 35

3.1 Loidesgrandsnombres ................................ 35

3.1.1 Vérification graphique . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

3.1.2 Vitesse de convergence . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 36

3.1.3 Comparaison des bornes dans l’inégalité de Bienaymé-Tchebychev et dans

l’approximationnormale............................ 36

3.2 Convergence des histogrammes et des fonctions de répartition empiriques . . . . . 37

3.2.1 Théorème de Glivenko-Cantelli . . . . . . . . . . . . . . . . . . . . . . . . 37

3.2.2 Convergence des histogrammes . . . . . . . . . . . . . . . . . . . . . . . . 39

3.3 MéthodedeMonte-Carlo................................ 39

3.3.1 L’aiguilledeBuffon............................... 39

3.3.2 Calculd’intégrales ............................... 40

3.4 Exercices ........................................ 42

4 Variables aléatoires gaussiennes, théorème limite central 45

4.1 Loimultinormale.................................... 45

4.2 Échantillons gaussiens, loi du χ2et lois associées . . . . . . . . . . . . . . . . . . 47

4.2.1 Loi du χ2.................................... 47

4.2.2 LoideStudent ................................. 48

4.2.3 Loi de Fisher-Snedecor . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 48

4.2.4 Échantillons gaussiens . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 49

4.3 Théorème limite central . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50

4.3.1 Le cas unidimensionnel . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 50

4.3.2 Le cas multidimensionnel . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

4.3.3 Application à la loi multinomiale . . . . . . . . . . . . . . . . . . . . . . . 51

4.4 Mouvementbrownien.................................. 52

4.4.1 Mouvement brownien standard . . . . . . . . . . . . . . . . . . . . . . . . 52

4.4.2 Mouvement brownien dans Rd......................... 53

4.4.3 Pontbrownien ................................. 54

4.5 Processus gaussiens stationnaires . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

4.5.1 Un peu de terminologie . . . . . . . . . . . . . . . . . . . . . . . . . . . . 55

4.5.2 Moyennesmobiles ............................... 55

4.5.3 Processus auto-régressifs . . . . . . . . . . . . . . . . . . . . . . . . . . . . 58

5 Chaînes de Markov à temps discret 61

5.1 Simulation de chaînes de Markov . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

5.1.1 Commandesdebase .............................. 61

5.1.2 Chaînesabsorbantes .............................. 62

5.1.3 Estimation de la probabilité de transition . . . . . . . . . . . . . . . . . . 63

5.2 Exemples ........................................ 64

5.2.1 Le modèle d’urne d’Ehrenfest . . . . . . . . . . . . . . . . . . . . . . . . . 64

5.2.2 Le modèle de Wright-Fisher . . . . . . . . . . . . . . . . . . . . . . . . . . 67

5.2.3 Le processus de Galton-Watson . . . . . . . . . . . . . . . . . . . . . . . . 69

5.2.4 L’urnedePolya................................. 71

ii

6 Processus à temps continu 73

6.1 LeprocessusdePoisson ................................ 73

6.1.1 Âge et durée de vie résiduelle . . . . . . . . . . . . . . . . . . . . . . . . . 74

6.1.2 Loi conditionnelle des instants d’arrivées . . . . . . . . . . . . . . . . . . . 74

6.1.3 Superposition et décomposition de processus de Poisson . . . . . . . . . . 75

6.1.4 Processus de Poisson composé . . . . . . . . . . . . . . . . . . . . . . . . . 75

6.1.5 Processus de Poisson non homogène . . . . . . . . . . . . . . . . . . . . . 75

6.1.6 Processus de Poisson dans le plan : . . . . . . . . . . . . . . . . . . . . . . 76

6.2 Processus markoviens de sauts . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

6.2.1 Définition et propriétés . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 77

6.2.2 Loisstationnaires................................ 77

6.2.3 Simulation par variables exponentielles . . . . . . . . . . . . . . . . . . . . 78

6.2.4 Simulation par la chaîne incluse . . . . . . . . . . . . . . . . . . . . . . . . 78

6.2.5 Simulation par la chaîne harmonisée . . . . . . . . . . . . . . . . . . . . . 79

6.3 Filesd’attente...................................... 80

6.3.1 La file d’attente G/G/1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . 80

6.3.2 Lecasmarkovien................................ 81

6.3.3 Files d’attente à plusieurs serveurs . . . . . . . . . . . . . . . . . . . . . . 82

6.4 Exercices ........................................ 83

7 Statistique 85

7.1 Régions et intervalles de confiance . . . . . . . . . . . . . . . . . . . . . . . . . . 85

7.1.1 Régions et intervalles de confiance exacts . . . . . . . . . . . . . . . . . . 85

7.1.2 Régions et intervalles de confiance approchés . . . . . . . . . . . . . . . . 86

7.2 Testsd’adéquation ................................... 88

7.2.1 Test du χ2.................................... 88

7.2.2 Test de Kolmogorov-Smirnov . . . . . . . . . . . . . . . . . . . . . . . . . 91

7.3 Comparaison de deux échantillons . . . . . . . . . . . . . . . . . . . . . . . . . . . 91

7.3.1 Test de Wilcoxon-Mann-Whitney . . . . . . . . . . . . . . . . . . . . . . . 91

7.3.2 TestdeSmirnov ................................ 91

7.4 Régression........................................ 92

7.4.1 Ajustement affine par la méthode des moindres carrés . . . . . . . . . . . 92

7.4.2 Régression linéaire simple . . . . . . . . . . . . . . . . . . . . . . . . . . . 94

7.4.3 Lemodèlelinéaire ............................... 94

7.4.4 Régression linéaire multiple . . . . . . . . . . . . . . . . . . . . . . . . . . 95

8 Indications de solutions 97

8.1 Chapitre1........................................ 97

8.2 Chapitre2........................................ 99

8.3 Chapitre3........................................ 104

8.4 Chapitre4........................................ 106

8.5 Chapitre5........................................ 108

8.6 Chapitre6........................................ 111

8.7 Chapitre7........................................ 119

iii

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

1

/

129

100%