télécharger

Filtrage de Kalman

et aperçu probabiliste

2

L’idée

•Faire coïncider deux modèles

–Modifier le moins possible de paramètres

–Problème : Paramètres très nombreux

• Effet d’un bouton sur le modèle

•Ajustement des autres boutons

Problème exponentiel

• Deux angles d’attaque possibles

–Méthodes logiques

•Logiques qualitatives et non-monotones

–Méthodes numériques

•Filtrage de Kalman

•Réseaux bayésiens

3

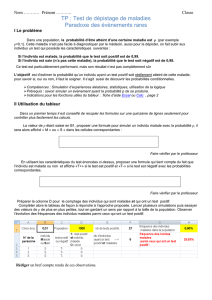

Filtre Kalman

ERREURS DU

SYSTÈME

ERREURS DE

MESURES

SYSTÈME

DYNAMIQUE

TRANSDUCTEUR DE

MESURES

SYSTÈME

DYNAMIQUE

VRAI MODÈLE

CONTRÔLES

FILTRE DE

KALMAN

MESURES

OBSERVÉES ÉTAT

ESTIMÉ

OPTIMAL

x

ˆ

w

u

z

v

4

Utilisation « classique »

•Estimation de systèmes dynamiques

(trajectoires par exemple)

•Domaines

–Fusion de données multi-capteurs

–Aérospatiale

–Aéronautique (calcul de position de cibles)

–Océanographie

–Météorologie

–Hydrologie

–Identification du langage

–...

5

Caractéristiques

•Algorithme de traitement de données

–Filtre : opérations sur un signal

–Récursif

–Linéaire*

–Optimal

–Temps réel

• Estimation d’états de systèmes dynamiques

dans un environnement bruité

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

1

/

32

100%