estimation et les intervalles de confiance

La confiance et l'importance:

Concepts clés de la statistique

inférentielle

février 2009

University of Reading

Statistical Services Centre

Biometrics Advisory and

Support Service to DFID

Contents

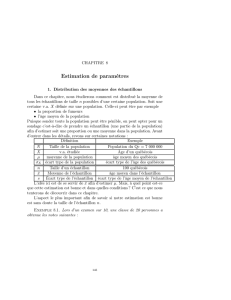

1.Introduction ............................................................................................................................. 3

2.L'application d'idées Estimation ............................................................................................. 4

3.Les erreurs-types ..................................................................................................................... 6

4.Les intervalles de confiance .................................................................................................... 8

5.Hypothèse d'essai .................................................................................................................... 9

5.1 Un exemple simple .......................................................................................................... 9

5.2 comprendre la signification ............................................................................................ 11

5,3 idées générales ............................................................................................................... 13

5.4 Structure Reconnaissant ................................................................................................. 14

6. Taille de l'échantillon nécessaire, ........................................................................................ 15

7.Des méthodes non paramétriques ......................................................................................... 16

8. L'analyse de variance ........................................................................................................... 18

8.1 Introduction .......................................................................................................... 18

8.2 One-Way ANOVA ............................................................................................... 18

8.3 Tests de comparaisons multiples ......................................................................... 20

9.Un cadre général ................................................................................................................... 21

1.Introduction

Dans ce guide, nous passons en revue les concepts de base de l'estimation et

l'hypothèse ou l'importance, les essais. Notre objectif est de discuter les idées clés de

l'inférence statistique d'une façon qui est facile à comprendre. Ces idées sont souvent

mal compris et ce manque de compréhension contribue à la méfiance par certains

membres du personnel de l'ole r des statistiques dans leur travail.Vous pouvez utiliser

les trois questions suivantes pour décider si vous avez besoin d'en lire davantage.

Vraie

Faux

Je ne

sais pas

1. L'écart-type et l'erreur-type sont à la fois utilisé

pour résumer la propagation des données

❐

❐

❐

1. L'intervalle de confiance à 95% pour la moyenne

est l'intervalle qui couvre environ 95% des

observations.

❐

❐

❐

1. Si la différence entre les effets de deux pratiques

de gestion agricole n'est pas statistiquement

significative, la conclusion est qu'il n'y a aucune

différence entre eux.

❐

❐

❐

Si vous avez répondu faux confiance aux trois questions ci-dessus vous pouvez avoir

besoin de peu de lire ce guide.Question 1 est discuté à la section 3, Question 2 de la

section 4 et la question 3 dans les sections 5 et 6.

Par souci de simplicité, nous utilisons des "petits problèmes artificiellement" pour

illustrer les idées.Les articles 2 à 5 de couvrir les idées de base de l'estimation, à

savoir les erreurs-types, intervalles de confiance, et les procédures de tests

d'hypothèses. Les idées sont appliquées dans les sections suivantes. Nous donnons

également notre point de vue sur le rôle des méthodes non-paramétriques et

l'implication de l'exécution de nombreux essais sur l'interprétation de p-valeurs.Ces

deux questions parfois dévier des cours de formation et des discussions sur d'autres

sujets, en raison des opinions bien arrêtées.

Le concept général de la modélisation statistique est introduit dans la dernière section

de ce guide.Ceci fournit un lien vers d'autres guides sur l'analyse, et en particulier à

l'un appelé les méthodes modernes d'analyse.

2.L'application d'idées Estimation

Estimation des caractéristiques d'une population d'intérêt, à partir d'un échantillon est

un objectif fondamental des travaux statistiques, si l'activité est une étude

observationnelle ou de surveillance, une enquête ou d'une expérience.

Estimation ponctuelle survient quand une quantité, calculée à partir de l'échantillon,

est utilisé pour estimer la valeur de la population. Les estimations de l'échantillon de

la population moyenne (

) Et l'écart type (

) Sont le plus souvent considérée

comme la moyenne de l'échantillon,

x

, Et l'écart-type de l'échantillon, s, où

/x x n

et

2/1s x x n

respectivement.

Par exemple, considérons l'estimation de la production moyenne de maïs par les

agriculteurs entre (la population de) petits agriculteurs dans une région sélectionnée

agro-écologiques. Pour ce faire, supposons un échantillon de 25 agriculteurs choisis

au hasard et leurs rendements du maïs sont enregistrées. La moyenne des 25 résultant

rendements sont calculés, donnant dire 278 kg / ha. Cette valeur est alors considérée

comme l'estimation de la production de maïs en moyenne par agriculteur dans la

région sélectionnée. Elle estime ce que l'on attendrait d'une exploitation agricole

individuelle.De même, l'écart type d'échantillon est une estimation du montant de la

variabilité dans les rendements de ferme en ferme.

D'autres estimations de la moyenne de population sont possibles. Par exemple, dans

de nombreuses enquêtes les observations ne sont pas échantillonnés avec une

probabilité égale. Dans ce cas, une moyenne pondérée

ˆ/x wx w

pourraient être

utilisés, au lieu de

x

, Avec des poids, w, qui compensent les probabilités inégales.

Proportions peut également être estimée, par exemple on peut souhaiter pour estimer

la proportion des années où les pluies commencent avant mai ou la proportion de

familles qui possèdent leurs propres terres, ou la proportion de répondants qui

indiquent un soutien pour la co-gestion de la communauté zones forestières au cours

d'une entrevue semi-structurée.Alors p = m / n, peut être utilisé comme l'estimation,

où m est le nombre de personnes qui présentent une réponse positive de la n qui ont

été interrogés.Par exemple, si m = 30, de n = 150 entretiens, puis d'estimer la

proportion que p = 30/150 = 0,2, ou 20%

Comme point de cette estimation est la même que la mesure, x, où x = 1 si une co-

gestion a été pris en charge et à zéro autrement.L'estimation, p est alors la même

x

,

Donné plus tôt, malgré les «données» à l'origine étant "non-numérique".Une grande

partie du matériel qualitatif peut être codée de cette façon.

S'il ya une question contingente, un suivi seulement pour ceux qui «qualifier» en

soutenant la co-gestion, nous pourrions trouver, par exemple, k = 12 des = 30 m qui

sont prêts à jouer un rôle actif dans la coopération -la gestion des réserves

forestières.Arithmétique,

r = k / m = 12/30 = 0,4 a la forme d'une proportion, mais il est en fait le rapport de

deux quantités qui peuvent à la fois changer si un autre échantillon de taille n est pris

de la même manière de la même population.Si la question de suivi est important, il est

important que l'échantillon original est assez grand pour qu'il existe un nombre

suffisant de répondants qui se qualifient (ici il y avait 30) pour la précision requise de

l'étude.

Parfois, notre objectif principal est de ne pas estimer la moyenne. Par exemple, en

recommandant une nouvelle variété de maïs aux agriculteurs, nous souhaitera peut-

être veiller à ce que cela donne un meilleur rendement, par rapport à la variété

existante pendant au moins 90% des agriculteurs. Une façon de procéder est d'abord

pour calculer la différence de rendement pour chaque agriculteur. Si, de l'expérience,

ou à partir de notre échantillon, nous pouvons accepter un modèle normal, c'est à dire

que la population des différences de rendement a approximativement une distribution

normale, alors le point de pourcentage requis se trouve (à partir de tableaux

statistiques standard) à

1.28

, Où

est la différence moyenne et

est l'écart type

des différences.

Dans ce cas, les estimations de

et

sont encore utilisés pour estimer le point de

pourcentage requis, ou tout autre bien.En général, les inconnus) les quantités (

et

sont appelés les paramètres du modèle.Si un modèle de probabilité différente est

supposé pour la distribution des rendements, les paramètres différents qui serait

estimé. Les formules de changer, mais les idées restent les mêmes.

Si, dans l'exemple ci-dessus, nous n'étions pas préparés à assumer toute la distribution,

l'analyse pourrait encore procéder par simple commande les différences de

rendements pour chaque agriculteur et de trouver la valeur dépassée par 90% des

agriculteurs. Il s'agit d'une solution non-paramétrique à ce problème et nous revenons

à cette approche dans la section 7. En règle générale, cette approche exige des

observations plus qu'un "paramétrique" ou "basé sur un modèle" approche, telle que

celle dans les paragraphes précédents.

Pour référence ultérieure nous expliquer le terme degrés de liberté.C'est à peu près

"des éléments d'information". Par exemple, avec l'échantillon de 25 agriculteurs, a

discuté plus tôt, il ya 25 pièces de l'information. Dans toute étude, il est généralement

important d'avoir de suffisamment d'informations restantes pour estimer la

propagation (résiduelle) de la population. Dans cet exemple simple de la propagation

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

1

/

24

100%