Sujets corrigés de probabilités voie ECE en accès libre

ECE2

R −É Page 1/68

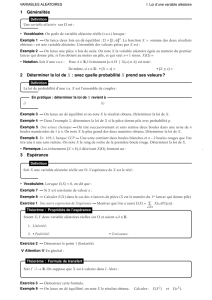

Table des matières

I Enoncés 1

1 EML III 2007 2

2 EML III 2006 3

3 EML III 1997 4

4 ESCP III 2003 5

5 ESCP III 2001 7

6 ESCP III 1999 8

7 ESCP III 1998 9

8 ESCP III 1997 10

9 HEC III 2002 11

10 HEC III 1996 13

11 HEC III 1992 14

12 EDHEC 1997 15

II Correction 17

13 EML III 2007 17

14 EML III 2006 22

15 EML III 1997 25

16 ESCP III 2003 28

17 ESCP III 2001 32

18 ESCP III 1999 36

19 ESCP III 1998 39

20 ESCP III 1997 44

21 HEC III 2002 49

22 HEC III 1996 55

23 HEC III 1992 59

24 EDHEC 1997 63

spicesagros.fr

P

Christian Skiada

ECE2

R −É Page 2/68

Première partie

Enoncés

1 EML III 2007

Partie entière et partie décimale d’une variable exponentielle, loi géométrique sur

IN, loi de Bernoulli, loi d’un produit de variables discrètes, espérance, variance.

1. On considère l’application f:IR →IR définie pour tout nombre réel xpar :

f(x) = e

−x

si x > 0

0si x≤0

Montrer que fest une densité de probabilité.

On considère une variable aléatoire Xadmettant fpour densité.

2. On définit la variable aléatoire discrète Yà valeurs dans IN de la façon suivante :

— l’événement [Y= 0] est égal l’événement [X < 1] ;

— pour tout nombre entier strictement positif n, l’événement [Y=n]est égal à l’événement [n≤X < n + 1].

(a) Montrer, pour tout entier naturel n:P([Y=n]) = 1−1

ee

−n

.

(b) Montrer que la variable aléatoire Y+1 suit une loi géométrique dont on précisera le paramètre.

(c) En déduire l’espérance et la variance de Y.

3. Soit Uune variable de Bernoulli telle que :

P([U= 1]) = P([U= 0]) = 1

2

On suppose que les variables aléatoires Uet Ysont indépendantes.

Soit la variable aléatoire T= (2U−1) Y, produit des variables aléatoires 2U−1et Y.

Ainsi, Test une variable aléatoire discrète à valeurs dans Z, l’ensemble des entiers relatifs.

(a) Montrer que la variable aléatoire Tadmet une espérance E(T)et calculer E(T).

(b) Vérifier que T

2

=Y

2

.En déduire que la variable aléatoire Tadmet une variance V(T)et

calculer V(T).

(c) Pour tout nombre entier relatif n, calculer la probabilité P([T=n]).

4. Soit la variable aléatoire D=X−Y. On note F

D

la fonction de répartition de D.

(a) Justifier :

∀t∈]−∞,0[ , F

D

(t) = 0 et ∀t∈[1,+∞[, F

D

(t) = 1

(b) Soit t∈[0,1[. Exprimer l’événement [D≤t]à l’aide des événements [n≤X≤n+t],n∈IN.

(c) Pour tout nombre réel t∈[0,1[ et pour tout nombre entier naturel n, calculer la probabilité

P([n≤X≤n+t]) .

(d) Montrer :

∀t∈[0,1[ , F

D

(t) = 1−e

−t

1−e

−1

(e) Montrer que Dest une variable aléatoire à densité. Déterminer une densité de D.

spicesagros.fr

P

Christian Skiada

ECE2

R −É Page 3/68

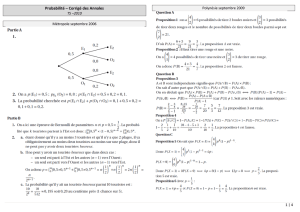

2 EML III 2006

Loi normale, fonction de répartition d’une variable à densité, changement de

variable à densité quadratique, espérance, variance, loi exponentielle, loi

géométrique, moyenne de nvariables géomériques, théorème de la limite centrée.

Partie A

1. Soit Uune variable aléatoire à densité suivant une loi normale d’espérance nulle et de variance 1

2.

(a) Rappeler une densité de U.

(b) En utilisant la définition de la variance de U, montrer que l’intégrale

+∞

0

x

2

e

−x

2

dx est conver-

gente et que

+∞

0

x

2

e

−x

2

dx =√π

4.

2. Soit Fla fonction définie sur IR par :

∀x≤0, F (x) = 0

∀x > 0, F (x) = 1 −e

−x

2

Montrer que la fonction Fdéfinit une fonction de répartition de variable aléatoire dont on déter-

minera une densité f.

3. Soit Xune variable aléatoire admettant fpour densité.

(a) Montrer que Xadmet une espérance E(X)et que E(X) = √π

2.

(b) Déterminer, pour tout réel y, la probabilité PX

2

≤y.On distinguera les cas y≤0et

y > 0.

(c) Montrer que la variable aléatoire X

2

suit une loi exponentielle dont on précisera le paramètre.

En déduire que Xadmet une variance V(X)et calculer V(X).

Partie B

1. Soit Zune variable aléatoire suivant une loi géométrique de paramètre p. Ainsi, pour tout k∈IN

∗

,

P([Z=k]) = p(1 −p)

k−1

.

Rappeler la valeur de l’espérance E(Z)et celle de la variance V(Z)de la variable aléatoire Z.

2. Soient un entier nsupérieur ou égal à 2,et nvariables aléatoires indépendantes Z

1

, Z

2

, ..., Z

n

, suivant

toutes le loi géométrique de paramètre p. On considère la variable aléatoire M

n

=1

n(Z

1

+Z

2

+··· +Z

n

).

(a) Déterminer l’espérance met l’écart-type σ

n

de M

n

.

(b) Montrer que lim

n→+∞

P([0 ≤M

n

−m≤σ

n

]) existe et exprimer sa valeur à l’aide de

1

0

e

−x

2

2

dx.

spicesagros.fr

P

Christian Skiada

ECE2

R −É Page 4/68

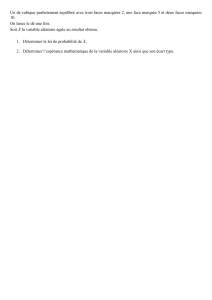

3 EML III 1997

Lancers d’un dé équilibré, loi d’une variable discrète (dimension 1), espérance,

variance, loi conditionnelle, loi d’un couple, indépendance.

On dispose d’un dé équilibré à 6faces et d’une pièce truquée telle que la probabilité d’apparition de

“pile” soit égale à p, p ∈]0,1[ .On pourra noter q= 1 −p.

Soit Nun entier naturel non nul fixé. On effectue Nlancers du dé ; si nest le nombre de “6” obtenus,

on lance alors nfois la pièce.

On définit trois variables aléatoires X,Y,Zde la manière suivante :

—Zindique le nombre de “6” obtenus aux lancers du dé ;

—Xindique le nombre de “piles” obtenus aux lancers de la pièce ;

—Yindique le nombre de “faces” obtenus aux lancers de la pièce.

Ainsi X+Y=Zet, si Zprend la valeur 0, alors Xet Yprennent la valeur 0.

1. Préciser la loi de Z, son espérance et sa variance.

2. Pour k∈IN, n∈IN, déterminer la probabilité conditionnelle P

[Z=n]

([X=k]) .On distinguera les

cas k≤net k > n.

3. Montrer, pour tout couple d’entiers naturels (k, n) :

Si 0≤k≤n≤Nalors P([X=k]∩[Z=n]) = n

kN

np

k

(1 −p)

n−k

5

6

N−n

1

6

n

Si n > N ou k > n alors P([X=k]∩[Z=n]) = 0

4. Calculer la probabilité P([X= 0]) .

5. Montrer pour tout couple d’entiers naturels (k, n)tel que 0≤k≤n≤N:

n

kN

n=N

kN−k

n−k

En déduire la loi de X.

6. Montrer que la variable Xsuit une loi binomiale de paramètres N, p

6.

Quelle est la loi de la variable Y?

7. Est-ce que les variables aléatoires Xet Ysont indépendantes ? Déterminer la loi du couple (X, Y ).

spicesagros.fr

P

Christian Skiada

ECE2

R −É Page 5/68

4 ESCP III 2003

Suite infinie de tirages dans une urne à contenu variable, suite géométrique,

probabilité conditionnelle, suite récurrente d’ordre deux à coefficients

variables.

Soit a, b deux entiers naturels non nuls et sleur somme.

Une urne contient initialement aboules noires et bboules blanches indiscernables au toucher.

On effectue dans cette urne une suite infinie de tirages au hasard d’une boule selon le protocole suivant :

— Si la boule tirée est blanche, elle est remise dans l’urne ;

— Si la boule tirée est noire, elle est remplacée dans l’urne par une boule blanche prise dans une réserve

annexe.

Avant chaque tirage, l’urne contient donc toujours sboules.

On désigne par (Ω,B,P)un espace probabilisé qui modélise cette expérience et, pour tout entier

naturel nnon nul, on note :

—B

n

l’événement “la n-ième boule tirée est blanche” ;

—X

n

la variable aléatoire désignant le nombre de boules blanches tirées au cours des npremiers

tirages ;

—u

n

l’espérance de la variable aléatoire X

n

, c’est-à-dire u

n

=E(X

n

).

1. Étude d’un ensemble de suites

Soit Al’ensemble des suites (x

n

)

n≥1

de réels qui vérifient :

∀n∈IN

∗

, s x

n+1

= (s−1) x

n

+b+n

(a) Soit αet βdeux réels et (v

n

)

n≥1

la suite définie par :

∀n∈IN

∗

, v

n

=α n +β

Déterminer en fonction de bet de sles valeurs de αet βpour que la suite (v

n

)

n≥1

appartienne

àA.

(b) Soit (x

n

)

n≥1

une suite appartenant à A,(v

n

)

n≥1

la suite déterminée à la question précédente

et (y

n

)

n≥1

la suite définie par :

∀n∈IN

∗

, y

n

=x

n

−v

n

Montrer que la suite (y

n

)

n≥1

est une suite géométrique et expliciter, pour tout entier naturel

nnon nul, y

n

puis x

n

en fonction de x

1

, b, s et n.

2. Expression de la probabilité P(B

n+1

)à l’aide de u

n

(a) Donner, en fonction de bet de s, les valeurs respectives de la probabilité P(B

1

)et du nombre

u

1

.

(b) Calculer la probabilité P(B

2

)et vérifier l’égalité P(B

2

) = b+ 1 −u

1

s.

(c) Soit nun entier naturel vérifiant 1≤n≤a. Montrer que, pour tout entier kde l’intervalle

[[0, n]], la probabilité conditionnelle P

[X

n

=k]

(B

n+1

)est égale à b+n−k

s.

En déduire l’égalité P(B

n+1

) = b+n−u

n

s.

(d) Soit nun entier naturel vérifiant n > a.

Si kest un entier de l’intervalle [[0, n −a−1]], quel est l’événement [X

n

=k]?

Si kest un entier de l’intervalle [[n−a, n]], justifier l’égalité P

[X

n

=k]

(B

n+1

) = b+n−k

s.

Montrer enfin que l’égalité P(B

n+1

) = b+n−u

n

sest encore vérifiée.

3. Calcul des nombres u

n

et P(B

n

)

spicesagros.fr

P

Christian Skiada

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

1

/

68

100%