Convergence des variables aléatoires

Convergence des variables aléatoires

I) L’inégalité de Bienaymé – Tchebychev

1.1) L’inégalité de Markov dans le cas discret

On considère une variable discrète non négative, d’espérance strictement positive.

Soit λ un réel strictement positif.

Puisque est non négative, on a

Appelons et les sous-ensembles de définis par

On a

Comme

on a et donc

D’autre part,

Donc

Donc

Soit en divisant par

Or

On en déduit l’inégalité de Markov :

Exemple

Si

on a

L’inégalité de Markov donne par exemple :

Donc si dans une urne il y a trois boules, deux noires et une blanche, indiscernables au toucher, la

probabilité de devoir attendre plus de 60 tirages avec remise pour obtenir pour la première fois la

boule blanche est inférieure ou égale à 5%.

Ce résultat est en fait assez imprécis, car

Et donc

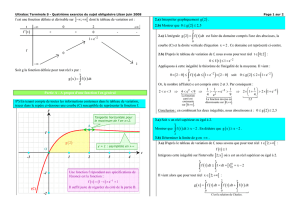

1.2) L’inégalité de Markov dans le cas continu

Soit une variable de densité nulle sur

admettant une espérance strictement positive.

Soit λ un nombre réel strictement positif.

On a

On peut écrire alors

La fonction est positive sur

Comme on a

Donc

Sur l’intervalle on a et donc

Les bornes étant dans le bon ordre, on a

Et donc

Ce qui donne en définitive :

En divisant par on obtient :

Or

On retrouve l’inégalité de Markov :

Exemple

La durée d’une communication téléphonique en minutes est une variable aléatoire continue dont on

supposera qu’elle suit une loi exponentielle de paramètre 1.

On a donc

On a

Dans ce modèle, la probabilité qu’une communication dure plus de 10 minutes est inférieure à 0,1. Ce

qui revient à dire qu’il y a moins de 10% des communications dont la durée dure plus de 10 minutes.

Là encore le résultat est très imprécis :

Il y a donc en réalité moins de 5 chances sur 100000 qu’une communication dure plus de 10 minutes

(ce qui en fait montre que ce modèle n’est pas très réaliste)

1.3) L’inégalité de Bienaymé – Tchebychev dans le cas discret

On considère une variable discrète admettant une espérance mathématique et une variance

non nulle.

Soit un nombre réel strictement positif.

On a

Soit la variable aléatoire définie par

On a donc

Donc dans le cas discret en appliquant l’inégalité de Markov en prenant :

On obtient

Ce qui donne

Or

On en déduit que

1.4) L’inégalité de Bienaymé – Tchebychev dans le cas continu

On considère une variable continue admettant une espérance mathématique et une variance

non nulle.

Soit une densité de probabilité de

On a

Considérons pour l’ensemble défini par

Ce qui revient à dire que

L’ensemble peut se décrire de la façon suivante :

De même

On a

On a donc par incompatibilité

On a

On a évidemment

Comme alors

Donc

Pour , on a Ce nombre étant négatif, on a

Donc

Les bornes étant dans le bon ordre, on a :

De même, on a pour

Donc

Et donc

Les bornes étant dans le bon ordre

On a donc

Donc

Donc

Donc

Ce qui donne enfin

On a

On en déduit l’inégalité dite de Bienaymé – Tchebychev :

Applications :

Si on a et

On aura par exemple

Or d’après l’inégalité de Bienaymé – Tchebychev, on a

Donc

Donc

Ou encore

Deuxième exemple :

Soit la variable aléatoire donnant la note en math au concours Ecricome. On sait que par

construction

On aura

Or

Donc

On en déduit que

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%