Dimension d`un espace vectoriel. Rang. Exemples et applications

Dimension d’un espace vectoriel. Rang. Exemples et applications

pr´erequis : les notions de base sur les espaces vectoriels, matrices ´equivalentes, semblables.

Remarques d’ordre g´en´eral : il est clair qu’il faut commencer par un premier paragraphe

sur la th´eorie de la dimension : il faudra veiller `a le r´ediger avec soin afin de respecter un

ordre logique parmi les ´enonc´es. Parmi les passages oblig´es, il faut bien entendu donner des

exemples et des applications sur les applications lin´eaires. Il parait difficile de ne pas ´evoquer

la signature, la multiplicativit´e des degr´es dans les extensions de corps, la g´eom´etrie affine. Il

peut ˆetre int´eressant de se lancer sur les codes correcteurs d’erreurs.

Table des mati`eres

1. Th´eorie de la dimension................................................... 1

1.1. Familles libres, g´en´eratrices et bases. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 1

1.2. Th´eor`eme de la base incompl`ete. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 2

1.3. Sous espace vectoriel, espace quotient, dual. . . . . . . . . . . . . . . . . . . . . . . . . . . 2

1.4. Un mot sur la dimension infinie. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 3

2. Premiers exemples. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.1. Noyaux emboit´es et invariants de similitude. . . . . . . . . . . . . . . . . . . . . . . . . . 4

2.2. Formes quadratiques.................................................. 6

2.3. Quelques sous-espaces de matrices. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 8

2.4. Trigonalisation simultan´ee. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 10

3. Applications.............................................................. 11

3.1. Polynˆomes de Lagrange. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

3.2. Algorithme de Berlekamp. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

3.3. Points de Gauss...................................................... 13

3.4. Codes correcteurs..................................................... 16

3.5. En analyse............................................................ 19

4. D´eveloppements........................................................... 19

5. Questions. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 20

6. Solutions.................................................................. 20

R´ef´erences................................................................... 20

1. Th´eorie de la dimension

1.1. Familles libres, g´en´eratrices et bases. —

D´efinition 1.1. — Une famille {(ei)i∈I}de vecteurs d’un espace vectoriel Eest dit libre si

pour tout famille (λi)i∈I∈K(I)`a support fini

X

i∈I

λiei= 0 ⇒ ∀i∈I, λi= 0.

Elle est dite g´en´eratrice si <{ei:i∈I}>=E, i.e. si tout vecteur de Epeut s’´ecrire comme

une combinaison lin´eaire `a support fini des ei.

Remarque : la famille (Xi)i∈N∈K[X] est libre et g´en´eratrice. En revanche elle n’est pas

g´en´eratrice dans K[[X]].

1

2

Remarque : la famille (ei)i∈Iest dite li´ee si elle n’est pas libre, i.e. s’il existe une famille

(λi)i∈I∈K(I)non nulle telle que Pi∈Iλiei= 0.

D´efinition 1.2. — Une famille (ei)i∈Ide vecteurs de Eest une base si elle est libre et

g´en´eratrice.

1.2. Th´eor`eme de la base incompl`ete. —

Th´eor`eme 1.3. — Soient {f1,··· , fp}une famille libre de vecteurs et {g1,··· , gq}une fa-

mille g´en´eratrice de E. Il existe alors un entier n≥pet une base {e1,··· , en}de Etelle que

ei=fipour 1≤i≤pet ej∈ {g1,··· , gq}pour p+ 1 ≤j≤n.

Remarque : ainsi tout espace contenant une famille g´en´eratrice finie admet une base.

Corollaire 1.4. — Soit Eun espace vectoriel muni d’une base de cardinal n. Alors toute

famille de cardinal strictement sup´erieur `a nest li´ee.

Remarque : on en d´eduit alors que le cardinal de toute base de Eest toujours le mˆeme ; on

l’appelle la dimension de E.

Application : en g´eom´etrie affine, une droite (resp. un plan...) est un espace vectoriel de

dimension 1 (resp. 2, ...) ayant perdu son origine.

1.3. Sous espace vectoriel, espace quotient, dual. —

Proposition 1.5. — Tout sous-espace vectoriel Fde Eest de dimension inf´erieure ou ´egale

`a celle de Eavec ´egalit´e si et seulement si F=E.

D´efinition 1.6. — On appelle hyperplan d’un espace vectoriel Ede dimension finie, tout

sous-espace de dimension n−1.

Remarque : en dimension infinie, un hyperplan est un sous-espace tel que E/F est de dimen-

sion 1. La dimension de l’espace quotient E/F s’appelle la codimension de Fdans E.

Remarque : la dimension de E×Fest le produit des dimensions de Eet F.

Remarque : toute famille libre est de cardinal ≤navec ´egalit´e si et seulement si c’est une

base.

Proposition 1.7. — Soient Eun espace vectoriel de dimension finie et Fun sous-espace

de E. Alors Fet E/F sont de dimension finie et dimKE= dimKF+ dimKE/F .

Application : soit u:E−→ Fune application lin´eaire avec F(resp. E) de dimension finie.

Alors Im u(resp. Ker u) est de dimension finie appel´ee le rang de u. Si Eet Fsont de

dimension finie alors rg(u) + dimKKer(u) = dimKE.

Corollaire 1.8. — Les classes d’´equivalences des u:E−→ Fsont param´etr´ees par le rang.

Aspect algorithmique : le rang d’une famille donn´ee se calcule matriciellement en pivotant `a

droite sur la matrice dont les vecteurs colonnes sont ceux de la famille ´ecrits dans une base

fix´ee.

Proposition 1.9. — Soient Fet Gdeux sous-espaces vectoriels d’un espace de dimension

finie E. Alors dimK(F+G) = dimKF+ dimKG−dimK(F∩G).

3

Application : deux droites distinctes du plan projectif s’intersectent toujours en un point.

Remarque : le produit tensoriel de deux espaces de dimension finie est de dimension finie ´egale

au produit des dimensions.

Corollaire 1.10. — Soient k⊂K⊂Eune extension de corps. Les degr´es sont reli´es par

la formule [E:k] = [E:K].[K:k].

Lemme 1.11. — Un espace vectoriel Vsur un corps infini kn’est pas r´eunion finie de sous-

espaces stricts V1,··· , Vt.

Preuve : C’est clair pour t= 1 et on suppose, par hypoth`ese de r´ecurrence, que t≥2 et le

r´esultat ´etabli pour t−1. Ainsi il existe u, v ∈Vtels que u6∈ Vtet v6∈ V1∪ · · · ∪ Vt−1. Si on

avait V=V1∪ · · · ∪ Vtalors v∈Vtet comme l’ensemble des xλ:= u+λv pour λ∈kest

infini, il existe λ6=µtels que xλet xµappartiennent au mˆeme Vj. On ne peut avoir j=tcar

sinon on aurait u∈Vt; donc j < t et Vjcontient xλ−xµ= (λ−µ)vet donc vaussi ce qui

n’est pas.

Application au th´eor`eme de l’´el´ement primitif : il s’agit de montrer que si K/k est une

extension s´eparable de degr´e fini, alors Kadmet un ´el´ement primitif ζsur k, i.e. K=k[ζ].

1) Si kest un corps fini alors K×est cyclique et K=k[ζ] pour tout g´en´erateur ζde K×.

2) Supposons `a pr´esent que kest infini et notons n= [K:k]. Pour Ω une clˆoture alg´ebrique

de K,K/k ´etant s´eparable, il existe des k-isomorphismes K→Ω deux `a deux distincts

τ1,··· , τnde sorte que pour tous i6=j, Ker(τi−τj) est un sous-espace strict de K. D’apr`es

le lemme il existe x∈Kn’appartenant `a aucun des Ker(τi−τj) de sorte que les τi(x) sont

deux `a deux distincts. Comme ce sont des racines dans Ω de µx,k de sorte que

n≤[k[x] : k]≤[K:k] = n

et donc K=k[x].

Pour Ede dimension finie n, son espace dual E∗= homK(E, K) est aussi de dimension n.

Pour (ei)i=1,··· ,n une base de E, on peut d´efinir sa base duale (e∗

i)i=1,··· ,n d´efinie par e∗

j(ei) =

δi,j .

D´efinition 1.12. — Soit Fun sous-espace vectoriel de Ealors F⊥={ψ∈E∗:∀f∈

F, ψ(f) = 0}.

Proposition 1.13. — Si Fest de dimension ralors F⊥est de dimension n−r.

Aspect algorithmique : on ´ecrit la matrice form´ee des vecteurs colonnes, dans une base fix´ee

de E, d’une famille g´en´eratrice de Fauxquels on rajoute le vecteur colonne t(x1,··· , xn). On

pivote alors `a droite jusqu’a faire apparaitre les ´equations lin´eaires.

1.4. Un mot sur la dimension infinie. —

Proposition 1.14. — Soit Eun K-espace vectoriel et V, W1, W2des sous-espaces tels que

V∩W1={0}et V+W2=E. Il existe alors un suppl´ementaire Wde Vcontenu dans W2et

contenant W1.

Preuve : Consid´erons l’ensemble Edes sous-espaces de Econtenant W1et contenus dans W2;

En’est pas vide car W1∈ E. En outre Eest partiellement ordonn´e par la relation d’inclusion

et est inductif. Rappelons que cela signifie que toute chaine totalement ordonn´ee admet un

majorant : ici pour une telle chaine, un majorant est simplement donn´e par la r´eunion qui est

clairement un sous-espace.

4

D’apr`es le lemme de Zorn, Eadmet un ´el´ement maximal, notons le W. Par d´efinition on a

donc W∩V={0}et W1⊂W⊂W2. Il reste alors `a prouver que V+W=E; tout ´el´ement

x∈Es’´ecrit x=v+w2avec v∈Vet w2∈W2. Si w2∈Walors c’est gagn´e, sinon on

consid`ere le sous-espace engendr´e Xpar Wet w2. Par maximalit´e de W,X6 E de sorte qu’il

existe 0 6=y∈X∩V; ainsi y=w+λw2∈Vet donc y∈W∩Vce qui n’est pas.

Remarque : le lecteur notera bien l’utilisation essentielle du lemme de Zorn qui rappelons le

est ´equivalent `a l’axiome du choix. Ainsi notre preuve n’est pas du tout constructive.

Corollaire 1.15. — Tout sous-espace Vde Eadmet un suppl´ementaire.

Corollaire 1.16. — Tout espace vectoriel non nul admet une base.

Preuve : Consid´erons l’ensemble Ades familles libres de E; c’est clairement un ensemble non

vide, partiellement ordonn´e par l’inclusion et inductif. D’apr`es le lemme de Zorn, il poss`ede

un ´el´ement maximal qui est donc une famille libre maximal c’est donc n´ecessairement une

famille g´en´eratrice et donc une base.

Remarque : le lecteur pourra s’exercer sur KNen v´erifiant que toute base est n´ecessairement

non d´enombrable.

Corollaire 1.17. — (Th´eor`eme de la base incompl`ete)

Soit (ei)i∈Iune partie g´en´eratrice de E. Soit J⊂Itel que (ei)i∈Jest libre, il existe alors

J⊂K⊂Itel que (ei)i∈Ksoit une base.

Preuve : On consid`ere l’ensemble Ades familles libres (ei)i∈Apour A⊂I. C’est un ensemble

non vide partiellement ordonn´e par l’inclusion et clairement inductif. D’apr`es le lemme de

Zorn, Aposs`ede une ´el´ement maximal K; comme pr´ec´edement (ei)i∈Kest libre et g´en´eratrice

par maximalit´e de K.

Remarque : citons enfin le cas des espaces de Hilbert, i.e. des espaces hermitiens, au sens du

paragraphe sur l’alg`ebre bilin´eaire, qui sont complets, i.e. toutes les suites de Cauchy sont

convergentes.

D´efinition 1.18. — On dit que (ei)i∈Iest une base de Hilbert d’un espace de Hilbert Hsi

et seulement si :

— c’est une base orthonorm´ee, i.e. < ei, ej>=δi,j ;

— la famille est compl`ete au sens que pour tout x∈Hil existe (λi)i∈Itelle que Pi∈Iλiei=

x, i.e. la s´erie correspondante dans Hest convergente de limite x.

Remarque : le lecteur v´erifiera ais´ement qu’une base au sens de Hilbert n’est pas une base au

sens classique, cf. par exemple les espaces L2.

2. Premiers exemples

2.1. Noyaux emboit´es et invariants de similitude. — Soient Eun K-espace vectoriel

de dimension finie net u∈ L(E). Pour tout λ∈Ket r≥1, on note

Kr(λ) := Ker(u−λId)ret Ir(λ) := Im(u−λId)r,

et on note dKr(λ) := dimKKr(λ) et dIr(λ) := dimKIr(λ). On pose aussi dK0(λ) = 0 et

dI0(λ) = n.

5

Proposition 2.1. — La suite dKr(λ)(resp. dIr(λ)) est tout d’abord strictement croissante

(resp. d´ecroissante) puis stationnaire `a partir d’un indice r0(resp. le mˆeme indice r0). Par

ailleurs la suite

δr(λ) := dKr(λ)−dKr−1(λ)

pour r≥1est d´ecroissante jusqu’au rang r0puis stationnaire ´egale `a 0.

Preuve : La croissance de dKr(λ) (resp. la d´ecroissance de dIr(λ)) est claire puisque

Kr−1(λ)⊂Kr(λ) (resp. Ir(λ)⊂Ir−1(λ)). Par ailleurs si Kr(λ) = Kr+1(λ) alors pour

x∈Kr+2(λ) on a u(x)∈Kr+1(λ) = Kr(λ) et donc ur+1(x) = 0 i.e. x∈Kr+1(λ). Le

th´eor`eme du rang donne enfin que l’indice o`u dIr(λ) stationne est le mˆeme que celui de

dKr(λ). On remarque ensuite que uinduit une injection

Kr+1(λ)/Kr(λ)֒→Kr(λ)/Kr−1(λ)

ce qui implique la d´ecroissance de la suite δr(λ) jusque 0.

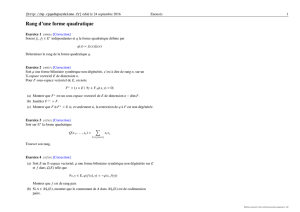

La suite δr(λ) d´efinit une partition du sous-espace caract´eristique Eλ(u) que l’on peut

repr´esenter sous la forme d’un tableau de Young. Ainsi pour λ= 0 et dr:= dKr(0 =, le

tableau de Young associ´e `a uest tel que ses colonnes sont de taille di−di−1; ses lignes

d´efinissent alors une partition (n1≥n2≥ · · · ≥ ns) de n=n1+···+nsqui correspond `a la

forme de Jordan de u.

d1

d2−d1

d3−d2dr−dr−1

n1

n2

n3

ns

e1

e2

e3

e4

e5

e6

0

e7

e8

e9

e10

e11

0

e12

e13

e14

e15

e16

0

e17

e18

0

e19

0

Figure 1. Tableau de Young associ´e `a un endomorphisme

Une fa¸con de construire ce tableau de Young est la suivante : on prend un vecteur e1de

Kr−Kr−1et on note pour i= 1,··· , r −1, ei+1 =ui(e1). Si dim Kr/Kr−1>1 on choisit

un vecteur er+1 ∈Krtel que les images de e1, er+1 dans Nr/Nr−1soient libres et on pose

pour i= 1,··· , r −1, er+1+i=ui(er+1). On continue le proc´ed´e jusqu’a obtenir une base

e1, er+1,··· , ekr+1 de Kr/Kr−1. On choisit alors un vecteur e(k+1)r+1 de Kr−1tel que les

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

1

/

20

100%