NOTIONS ELEMENTAIRES DE STATISTIQUE PROBABILISTE

Chapitre 1

NOTIONS ELEMENTAIRES

DE STATISTIQUE

PROBABILISTE

Les statistiques sont une modélisation de la part aléatoire des phénomènes.

Dans le cadre de ce cours, cet aléatoire concerne la variabilité des mesures quan-

titatives qui peuvent être entreprise en chimie ou en chimie-physique. Les bases

mathématiques de cette modélisation sont les probabilités. Ici, on se conten-

tera de définitions proposées par l’ISO 3534[8]. Ce cours transcrira souvent des

normes éditées dans les séries ISO, en particulier [8], [9] et [10].

1.1 Défintions

1.1.1 Définition déterministe de la probabilité

Lors de la réalisation d’un événement Adont le nombre d’issues favorables

peut être calculé au moyen de l’analyse combinatoire (compte tenu de l’hypo-

thèse d’équiprobabilité des issues), on définit la probabilité P(A)de cet évé-

nement par le rapport du nombre d’issues favorables (nA) au nombre d’issues

possibles (n) :

P(A) = nA

n(1.1)

C’est la définition classique que l’on utilise pour évaluer les issues d’un jeu

de hasard depuis les travaux de B. Pascal au sujet des problèmes du Chevalier

de Méré [3] et développés par Huigens [7] et Bernouilli [1].

Exemple : La probabilité pour obtenir "pile" après un lancé d’une pièce

parfaitement symétrique est de 0,5.

1.1.2 Définition empirique de la probabilité

Si après un grand nombre de réalisations d’une expérience (nréalisations)

on observe nAfois l’issue souhaitée, la probabilité de cet événement est la limite

de la fréquence des observations de l’issue souhaitée :

1

2CHAPITRE 1. NOTIONS ELEMENTAIRES DE STATISTIQUE PROBABILISTE

P(A) = lim

n→∞

nA

n(1.2)

En réalité, la fréquence observée en fonction de noscille autour de sa valeur

théorique et s’en rapproche indéfiniment lorsque lim

n→∞ conformément à la "loi

des grands nombres" [1, 13].

1.1.3 Variables aléatoires

Considérons un événement comportant un certain nombre d’issues. Si on

associe un nombre à chaque issue, ou à chaque ensemble d’issues, ce nombre est

appelé variable aléatoire ou aléa numérique. On la note par une lettre majuscule

X, par contre les valeurs particulières de la variable aléatoire sont notées par

une minuscule x. On additionne parfois un indice pour faire référence à une

réalisation particulière au sein d’une série de réalisation d’une même variable

aléatoire xi.

Exemple : jeu de pile ou face : Les issues du jeu sont pile ou face. On peut

associer à pile X = 1 et à face X = -1 ou encore 0 et 1 ou tout autre nombre.

X est alors une variable aléatoire.

Exemple détaillé :

Expérience aléatoire : lancer deux dés, un rouge et un bleu.

Evénements : le dé rouge fait 2 et le dé bleu fait 3

Variables aléatoires :Xla valeur obtenue au tirage du dé rouge,

Ycelle obtenue pour le dé bleu,

Z=X+Y,

Tqui vaut 1si X=Yet 0sinon.

Remarquons que les événement {“On tire un double”}et {T= 1}sont

identiques.

1.1.4 Continuité et discontinuité d’une variable aléatoire,

notion de densité de probabilité

Variable discontinue ou discrète : C’est une variable qui ne peut prendre que

des valeurs isolées séparées par un intervalle fini, c’est-à-dire non infinitésimal.

Elle est généralement représentée par un entier. On peut associer une probabilité

à chaque valeur possible d’une variable aléatoire discrète.

Variable continue : C’est une variable qui peut prendre toutes les valeurs

d’un intervalle fini ou infini. Cela signifie que la différence entre deux valeurs

voisines peut être aussi petite que l’on peut l’imaginer. C’est un nombre réel.

On ne peut pas associer une probabilité à une valeur particulière d’une va-

riable aléatoire continue. La probabilité pour que Xprenne une valeur particu-

lière xdans R(l’ensemble des nombres réels) est toujours nulle. Par contre on

peut associer à xune densité de probabilité f(x)et on peut associer à un inter-

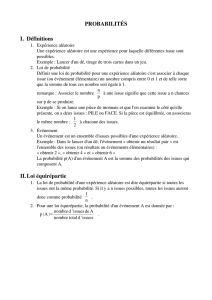

valle [x, x +δx]une probabilité non nulle (figure 1.1). La densité de probabilité

est définie de la même manière que la densité d’un milieu continu [11, 12].

Si l’intervalle est assez petit pour qu’on puisse y considérer f(x)comme

constant :

P(X∈[x, x +δx]) = f(x)δx (1.3)

1.1. DÉFINTIONS 3

Figure 1.1 – Seule l’aire sous la courbe représentative d’une distribution d’une

fonction de probabilité est, en pratique, une probabilité.

4CHAPITRE 1. NOTIONS ELEMENTAIRES DE STATISTIQUE PROBABILISTE

On constate bien que cette probabilité tend vers 0 lorsque δx tend vers 0.

Remarque : Une probabilité est une grandeur sans dimensions. En re-

vanche, la densité de probabilité a une dimension : c’est l’inverse de la dimension

de la variable aléatoire concernée. Par exemple, si la variable aléatoire est une

mesure de distance exprimée en mètres, alors la densité de probabilité de cette

variable aléatoire s’exprime en mètres−1.

Exemple : On s’intéresse à la taille des personnes d’un certain âge. Si la

taille est considérée comme une variable aléatoire continue, donc un nombre réel

(un nombre réel est un nombre infiniment précis), rien n’empêche d’examiner la

probabilité pour rencontrer un individu de taille 1,7500 m ou même 1,7543 m. La

probabilité de rencontrer dans la population une valeur numérique aussi précise

est nulle. Il est d’ailleurs impossible de mesurer la taille d’une personne avec une

telle précision. Par contre il existe un certain nombre d’individus ayant une taille

comprise entre 1,75 et 1,76 m si l’échantillon est suffisamment grand. L’opération

qui consiste à définir des classes correspondant à des intervalles de valeur que

peut prendre une variable aléatoire est appelée discrétisation. Usuellement, ces

classes sont ne se recouvrent pas les unes les autres mais couvrent en revanche

la totalité du domaine de définition de la variable aléatoire.

1.2 Généralités sur les lois de probabilités

1.2.1 Définition

Une loi de probabilité est une relation permettant d’associer une probabilité

ou une densité de probabilité à chaque valeur d’une variable aléatoire.

Pour une variable aléatoire discrète, c’est la donnée de la probabilité que

soient prises chacunes des valeurs de la variable aléatoire.

Exemple détaillé : En reprenant l’exemple précédent, la loi de Xest

P(X= 1) = 1

6P(X= 2) = 1

6. . . P (X= 6) = 1

6

de même pour Y. Pour Z

P(Z= 2) = 1

36 P(Z= 3) = 2

36 . . . P (Z= 7) = 6

36 . . . P (Z= 12) = 1

36

Enfin, la loi de Test

P(T= 0) = 5

6P(T= 1) = 1

6

Pour une variable aléatoire continue, on ne peut pas procéder de cette ma-

nière, puisque dans ce cas P(X=x0) = 0 pour tout x0. On pourrait considérer

que la loi d’une variable aléatoire continue est la donnée de P(X∈[a, b]) pour

tout aet pour tout b. Mais c’est assez lourd et nous allons voir dans un instant

que ça revient à donner la fonction de répartition de la variable aléatoire.

1.2.2 Représentation d’une loi de probabilité

Si la variable est discrète : représentation comme un diagramme en bâtons

(figure 1.2).

Pour une variable continue on représente la fonction densité de probabilité

(voir 1.1)

1.2. GÉNÉRALITÉS SUR LES LOIS DE PROBABILITÉS 5

Figure 1.2 – Représentation en bâton d’une distribution de probabilité discrète.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

1

/

31

100%