ENS 2009-2010 2 année

ENS 2009-2010

2eme année

Dr. Aicha. Lazraq Khlass

Chapitre II

Probabilités

Section II (suite)

II. II. 2. viii. Dé…nition. (Indépendance de deux variables aléa-

toires).

Soient Xet Ydeux variables aléatoires dé…nies sur un univers telles que

X() et Y() soient …nis. On note x1; :::; xnet y1; :::; yples valeurs de Xet Y:

On dit que Xet Ysont des variables aléatoires indépendantes lorsque :

pour tout i2[1; n]et tout j2[1; p], les événements "X=xi"et "Y=yj"sont

indépendants.

.

II. II. 2. ix. Exemple.

On lance deux dés bien équilibrés. On note Sla somme des résultats obtenus

et Ple produit. Donner, sous forme de tableau la loi de probabilité du couple

(S; P ):Les variables aléatoires Set Pdé…nies sur = f(i;j)=i 2[1; 6] et j2[1; 6]g:sont-

elles indépendantes ?

On dresse deux tableaux donnant les di¤érentes possibilités de sommes et

de produits :

S1 2 3 4 5 6

1 2 3 4 5 6 7

2 3 4 5 6 7 8

3 4 5 6 7 8 9

4 5 6 7 8 9 10

5 6 7 8 9 10 11

6 7 8 9 10 11 12

P123456

1123456

2 2 4 6 8 10 12

3 3 6 9 12 15 18

4 4 8 12 16 20 24

5 5 10 15 20 25 30

6 6 12 18 24 30 36

S=P 1 2 3 4 5 6 8 9 10 12 15 16 18 20 24 25 30 36 Loi de S

21

36 00000000000000000 1

36

3 0 2

36 0000000000000000 2

36

4 0 0 2

36

1

36 00000000000000 3

36

5 0 0 0 2

36 02

36 000000000000 4

36

6 0 0 0 0 2

36 02

36

1

36 0000000000 5

36

7 0 0 0 0 0 2

36 0 0 2

36

2

36 00000000 6

36

8 0000000002

36

2

36

1

36 000000 5

36

9 0000000000002

36

2

36 0000 4

36

10 000000000000002

36

1

36 0 0 3

36

11 00000000000000002

36 02

36

12 000000000000000001

36

1

36

Loi de P1

36

2

36

2

36

3

36

2

36

4

36

2

36

1

36

2

36

4

36

2

36

1

36

2

36

2

36

2

36

1

36

2

36

1

36 1

Les variables aléatoires Set Pne sont pas indépendantes. En e¤et :

P("S= 2" \"P= 2") = 0

1

P(S= 2)P(P= 2) = 1

36 2

36 =2

3626= 0

.

II. II. 2. x. Modélisation d’expériences. Répétition d’expériences

indépendantes.

Voici trois règles pratiques pour calculer des probabilités directement sur des

arbres.

* Exemple de situation où l’on réitère deux fois une expérience compor-

tant deux issues Aet Bcontraires l’une de l’autre. On note A1(resp. A2)

l’événement "Ase réalise à la première (resp. deuxième) expérience". Mêmes

notations pour B. L’univers associé à cette situation comporte 4 issues : =

fA1A2;A1B2;B1A2;B1B2g

R1 : la somme des probabilités des branches partant d’une même racine est

toujours égale à 1:P(A1) + P(B1) = 1 (ceci provient du fait que Aet Bsont

contraires)

R2 : la probabilité d’un chemin est égale au produit des probabilités des

branches de ce chemin : la probabilité du chemin A1A2est : P(A1\A2) =

P(A2jA1)P(A1) (formule de probabilité conditionnelle)

R3 : la probabilité d’un événement est la somme des probabilités des chemins

correspondant à cet événement : La probabilité de l’événement "obtenir exacte-

ment une fois A" est : P(A1\B2) + P(B1\A2)

.

* Si on suppose que les deux expériences se déroulent de manière indépen-

dante. On a alors l’arbre suivant :

La probabilité du chemin A1A2sera donc P(A1)P(A2)

.

* Cas particulier : si on répète nfois, de manière indépendante une expéri-

ence. La probabilité pqu’un événement Ade cette expérience se réalise nfois

sera : p= (P(A))n:

.

Exemple.

On lance un dé nfois . Comment choisir npour que la probabilité pn

d’obtenir au moins un 6, au cours des nlancers, soit supérieure ou égale à 0;95?

On note : A="on obtient au moins un 6au cours des nlancers"

On a : A="on obtient aucun 6au cours des nlancers"

L’événement Ase réalise, si et seulement si, pour chacun des nlancers, on

n’obtient pas de 6. D’après le cas particulier vu ci-dessus, on a :

P(A) = 5

6n

D’où : pn=P(A) = 1 5

6n

On cherche maintenant ntel que : pn0;95

15

6n0;95

5

6n0;05

La fonction ln étant croissante sur ]0;+1[, cette dernière inéquation équiv-

aut à :

nln 5

6ln0;05

Et puisque ln 5

6<0, on a : nln0;05

ln 5

6

2

La calculatrice donne : ln0;05

ln 5

6

= 16;4à101près

Et comme nest un entier : n17

On doit donc lancer le dés au moins 17 fois pour être sûr à 95% d’obtenir

au moins un 6.

.

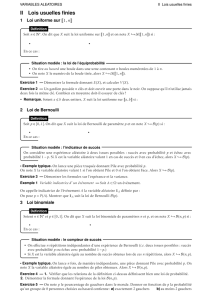

II. III. Les lois usuelles.

II. III. 1. Loi de Bernoulli.

II. III. 1. i) Dé…nition. (Épreuve de Bernoulli).

Une épreuve de Bernoulli est une épreuve à deux issues, souvent appelées

succès et échec = fs; eg. On suppose que la probabilité de l’événement : un

succès a été obtenu vaut p; et donc, la probabilité de l’événement contraire :

un échec a été obtenu vaut q= 1 p. Soit Xla variable aléatoire qui associe

la valeur 1à un succès a été obtenu et la valeur 0à un échec a été obtenu :

X: ! R;s7! 1et e7! 0. La variable aléatoire X suit alors la loi de

Bernoulli de paramètre p. Cette loi est notée B(p).

.

II. III. 1. ii) Théorème. (Espérance).

Soit Xune variable aléatoire suivant la loi de Bernoulli B(p). Alors, E(X) =

p:

En e¤et :

Valeur xide lavariable

aléatoire Xx1= 0 x2= 1

Probabilité pide

l0événement "X=xi"p1= 1 p p2=p

E(X) = p1x1p2x2=p

.

II. III. 1. iii) Théorème. (Variance).

Soit Xune variable aléatoire suivant la loi de Bernoulli B(p). On a : V(X) =

p(1 p) = pq.

En e¤et :

V(X) = p1x2

1+p2x2

2E(X)2=pp2=p(1 p) = pq.

.

II. III. 2. Loi binomiale.

II. III. 2. i) Dé…nition. (Schéma de Bernoulli).

On considère une épreuve de Bernoulli. On e¤ectue, dans les mêmes condi-

tions, nfois de suite cette épreuve, n2N. Les nrépétitions de l’épreuve sont

indépendantes les unes des autres. L’univers est un ensemble de nuplets.

.

II. III. 2. ii) Exemple.

On suppose que l’expérience soit répétée trois fois. Succès est représenté par

set échec par e. Dans ce cas, = f(s;s;s); (s;s;e); (s;e;s); (e;s;s); (s;e;e); (e;s;e); (e;e;s); (e;e;e)g

On suppose que la probabilité d’obtenir ssoit égale à pet que la probabilité

d’obtenir esoit égale à q. Comme il n’y a que deux issues, on a, q= 1 p.

Les trois événements A: le résultat de la première épreuve est s,B: le

résultat de la deuxième épreuve est set C: le résultat de la troisième épreuve

est esont indépendants. On en déduit que P(f(s;s;e)g) = P(A\B\C)

3

=P(A)P(B)P(C) = pp(1 p) = p2(1 p). Comme il y a autant de

triplets où sapparaît deux fois que de sous-ensembles à deux éléments dans un

ensemble à trois éléments, on obtient que la probabilité d’obtenir exactement

deux fois le résultat slorsque l’expérience aléatoire est répétée trois fois vaut :

3

2p2(1 p):

.

II. III. 2. iii) Théorème.

On considère une épreuve ayant deux issues : set e. La probabilité d’obtenir

scomme résultat de l’expérience aléatoire est p. La probabilité d’obtenir eest

q= 1 p. On répète nfois cette épreuve dans les conditions de Bernoulli. Soit

Xla variable aléatoire comptabilisant le nombre de réalisations de sau cours

des nrépétitions de l’épreuve . On a, pour tout entier naturel k:

P(X=k) = n

kpk(1 p)nk.

Preuve.

La probabilité d’obtenir slors des kpremières répétitions de l’épreuve, puis e

lors des nksuivantes est , pk(1 p)nk, puisque les répétitions sont indépen-

dantes les unes des autres. Comme il y a autant de nuplets où a apparaît

exactement kfois que de sous-ensembles à kéléments dans un ensemble à n

éléments, on en déduit le théorème.

.

II. III. 2. iv) Dé…nition et notation. (Loi binomiale B(n; p)).

La variable aléatoire Xdu théorème précédent a pour loi de probabilité la

loi binomiale de paramètres net p. Le premier paramètre n, est le nombre de

répétitions de l’épreuve à deux issues ; le second paramètre p, est la probabilité

d’obtenir scomme résultat de l’épreuve à deux issues. La loi binomiale de

paramètres net pse note : B(n;p).

.

II. III. 2. v) Théorème. (Espérance).

L’espérance de la variable aléatoire X, suivant la loi binomiale B(n;p), est :

E(X) = np.

Preuve.

E(X) = P

0kn

kn

kpk(1 p)nk=P

1kn

kn

kpk(1 p)nk

Or, pour k6= 0,kn

k=nn1

k1

Donc, E(X) = np P

1knn1

k1pk1(1 p)n1(k1)

=np P

0kn1n1

kpk(1p)n1k=np (p+ 1 p)n1=np.

.

II. III. 2. vi) Théorème. (Variance).

La variance de la variable aléatoire X, suivant la loi de probabilité B(n;p),

est :

V(X) = np(1 p):

4

Preuve.

V(X) = P

0kn

k2n

kpk(1 p)nk(np)2=P

1kn

k2n

kpk(1

p)nk(np)2

Or, pour k6= 0,kn

k=nn1

k1

Donc, V(X) = np P

1kn

kn1

k1pk1(1 p)n1(k1) (np)2

=np P

0kn1

(k+ 1) n1

kpk(1 p)n1k(np)2

=np P

0kn1

kn1

kpk(1 p)n1k+np P

0kn1n1

kpk(1

p)n1k(np)2

=np (n1) p+np (p+ 1 p)n1(np)2=np (1 p).

.

II. III. 3. Loi de Poisson.

II. III. 3. i) Dé…nition et notation.

Soit 2R

+. On dit que la variable aléatoire discrète X, à valeurs dans N,

suit la loi de Poisson de paramètre , notée : P(), si pour tout kdans N:

P(X=k) = k

k!ek

.

II. III. 3. ii) Théorème. (Espérance).

Soit Xune variable aléatoire suivant la loi de Poisson P(). Alors, E(X) =

:

Preuve.

On sait que : E(X) = P

k0

kk

k!e= lim

n!+1P

0kn

kk

k!e, Or, P

1kn

kk

k!e=

eP

1kn

k1

(k1)! =eP

0kn1

k

k!! ee=.

.

II. III. 3. iii) Théorème. (Variance).

Soit Xune variable aléatoire suivant la loi de Poisson P(). Alors, V(X) =

:

Preuve.

On sait que : V(X) = P

k0

k2k

k!e2= lim

n!+1 P

0kn

kk

k!e!2, Or,

P

0kn

k2k

k!e=eP

1kn

kk1

(k1)! =eP

0kn1

(k+ 1) k

k!=eP

0kn1

kk

k!+

eP

0kn1

k

k!=2eP

0kn2

k

k!+eP

0kn1

k

k!! ee+2ee=

+2. D’où le résultat.

.

.

.

.

5

6

6

7

7

8

8

1

/

8

100%