Master Biologie Intégrative

BIOSTATISTIQUES

AVANCEES

Yves Desdevises

Observatoire Océanologique de Banyuls-sur-Mer

(www.obs-banyuls.fr)

04 68 88 73 13

desdevises@obs-banyuls.fr

http://desdevises.free.fr

http://www.edu.upmc.fr/sdv/desdevises

Master Biologie Intégrative

1ère année

2016-2017

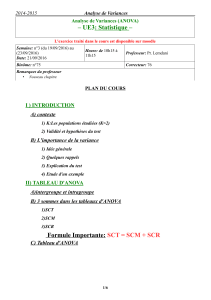

PLAN

1. Rappels : données, tests, plans d’expérience, distributions

2. Comparaison de 2 groupes : variances et moyennes

3. Comparaison de plus de 2 groupes : test d’homogénéité des

variances, analyses de variance à 1 et 2 facteurs

4. Relations entre variables : corrélation

5. Relations entre variables : régression simple

6. Régression multiple et analyse de covariance

7. Analyse multivariable

8. Analyse de survie

Quelques références

•Générales

•Sokal RR & Rohlf FJ. 2012. Biometry. 4th Revised Edition,

Freeman and co., New York.

•Zar JH. 2009. Biostatistical Analysis. 5th Edition, Pearson.

•Frontier S, Davoult D, Gentilhomme V & Lagadeuc Y. 2007.

Statistique pour les sciences de la vie et de l’environnement.

Cours et exercices corrigés. Dunod.

•Triola MM & Triola MF. 2006. Biostatistics for the Biological and

Health Science. Pearson. Traduction française en 2009 :

Biostatistiques pour les sciences de la vie et de la santé.

•Scherrer B. 2008-2009. Biostatistiques volumes 1 et 2. Gaëtan

Morin.

•Millot G. 2014. Comprendre et réaliser les tests statistiques à

l'aide de R. 3ème édition. De Boeck.

•Simplifiées

•Dytham C. 2011. Choosing and Using Statistics. A Biologist’s

Guide. 3rd Edition. Blackwell Publishing.

•McKillup S. 2011. Statistics Explained. 2nd Edition. Cambridge

University Press.

•van Emden H. 2008. Statistics for Terrified Biologists. Blackwell

Publishing.

•Plus spécialisées

•Legendre P & Legendre L. 2012. Numerical Ecology. 3rd English

Edition. Development in Environmental Modelling, 20. Elsevier.

•Underwood AJ. 1997. Experiments in Ecology. Cambridge

University Press.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

1

/

58

100%