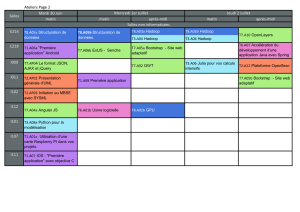

Hadoop - Semaine 3

Hadoop - Semaine 3

Le cours de cette semaine explique comment créer une application

MapReduce pour YARN complète. Deux projets vont être expliqués.

Ils concernent des statistiques sur des documents.

calcul de la variance

calcul de la valeur médiane

On va appliquer ça à la longueur des lignes de textes, mais ça

pourrait être la durée de séjour sur une place de parking payante, la

température mesurée à midi, le nombre de sangliers dans les

forêts. . .

2 / 46 Pierre Nerzic

Hadoop - Semaine 3

Application

Soient des données : des romans sous forme de fichiers texte. On

s’intéresse à la longueur des lignes (pourquoi ? mystère. . . ).

1897

DRACULA

by Bram Stoker

CHAPTER I.

JONATHAN HARKER’S JOURNAL.

(Kept in shorthand.)

3 May. Bistriz.- Left Munich at 8:35 P.M., on 1st May, arriving at

Vienna early next morning; should have arrived at 6:46, but train

was an hour late. Buda-Pesth seems a wonderful place, from the glimpse

which I got of it from the train and the little I could walk through

the streets. I feared to go very far from the station, as we had

arrived late and would start as near the correct time as possible. The

impression I had was that we were leaving the West and entering the

East; the most western of splendid bridges over the Danube, which is

here of noble width and depth, took us among the traditions of Turkish

rule.

3 / 46 Pierre Nerzic

Hadoop - Semaine 3

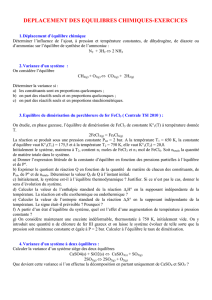

Calcul de la variance

Définition

La variance d’un ensemble de données permet de caractériser la

dispersion des valeurs autour de la moyenne. La variance est le carré

de l’écart type.

La variance Vxest la moyenne des carrés des écarts des xià la

moyenne m:

Vx=1

nX

i

(xi−m)2

Vous pourrez trouver la notation

σ2

pour la variance et

µ

ou

¯x

pour

la moyenne.

Le problème de cette équation, c’est qu’il faut d’abord parcourir les

données pour extraire la moyenne.

5 / 46 Pierre Nerzic

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

1

/

46

100%