3.3 Propriétés des estimateurs

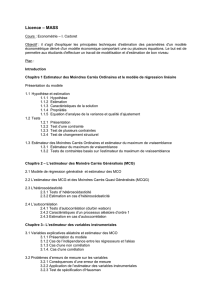

L1 - ELÉMENTS DE STATISTIQUE

Cours 8

3.3 Propriétés des estimateurs

Biais d’un estimateur

Définition 17 – Soit (X1,··· ,Xn)un n-échantillon de v.a. de la loi Pθet

g(X1,··· ,Xn)un estimateur de θ.

On dit que g(X1,··· ,Xn)est un estimateur sans biais (esb) de θssi

Ehg(X1,··· ,Xn)i=θ.

On note bn(θ)=¯¯¯g(X1,··· ,Xn)−θ¯¯¯le biais de l’estimateur.

Exemple : Soit un n-échantillon de loi normale de paramètres (µ,σ2). Nous

avons vu précédemment en utilisant la méthode des moments, que ˆ

µ=Xnet

ˆ

σ2=1

n

n

X

i=1

X2

i−X2

nsont respectivement des estimateurs de µet σ2.

•ˆ

µest-il sans biais ?

Calculons E(ˆ

µ).

E(ˆ

µ)=E(Xn)=1

n

n

X

i=1

E(Xi)=1

n(nµ)=µ.

ˆ

µest donc un estimateur sans biais.

•ˆ

σ2est-il sans biais ?

E(ˆ

σ2)=EÃ1

n

n

X

i=1

X2

i−X2

n!=1

n

n

X

i=1

E(X2

i)−E(X2

n).

On sait que : E(X2

i)=σ2+µ2puisque σ2=E(X2

i)−[E(Xi)]2.

E(X2

n)=1

n2"X

i6=j

E(Xi)E(Xj)+

n

X

i=1

E(X2

i)#

=1

n2[n(n−1)µ2+n(µ2+σ2)]

=µ2+σ2

n.

56

CHAPITRE 3. ESTIMATION PONCTUELLE

d’où

E(ˆ

σ2)=µ2+σ2−µ2−σ2

n=n−1

nσ2.

L’estimateur proposé n’est donc pas sans biais.

Remarquons que l’on peut construire un estimateur sans biais en consi-

dérant :

n

n−1ˆ

σ2

n.

Définition 18 – Soit (X1,··· ,Xn)un n-échantillon de v.a. de la loi Pθet

g(X1,··· ,Xn)un estimateur de θ.

On dit que g(X1,··· ,Xn)est un estimateur asymptotiquement sans biais

ssi

lim

n→+∞Ehg(X1,··· ,Xn)i=θ.

Exemple : L’estimateur de la variance ˆ

σ2est un estimateur asymptotique-

ment sans biais.

En effet,

lim

n→+∞E(ˆ

σ2)=lim

n→+∞µ1−1

n¶σ2=σ2.

Considérons (X1,··· ,Xn) un n-échantillon de v.a. iid. Toute statistique de cet

échantillon i.e. toute fonction, en particulier tout estimateur de (X1,··· ,Xn)

est une variable alétoire. Il semble alors naturel de s’intéresser à la loi de la

v.a. g(X1,··· ,Xn).

On sent intuitivement que la qualité de l’estimation va dépendre du nombre

d’observations.

Nous allons donc étudier le comportement de g(X1,··· ,Xn) en fonction de n,

la quantité d’observations.

Consistance

On dit qu’une suite de v.a. Ynconverge en probabilité vers Yssi

∀ξ>0,lim

n→+∞P(|Yn−Y|>ξ)=0.

57

L1 - ELÉMENTS DE STATISTIQUE

Définition 19 – Soit (X1,··· ,Xn)un n-échantillon iid de Pθ,θ∈Θ. Soit g(X1,··· ,Xn)

une statistique.

On dit que g(X1,··· ,Xn)est consistant ssi g(X1,··· ,Xn)converge en probabi-

lité vers θ.

On note :

g(X1,··· ,Xn)P

−→θ.

Un exemple classique d’estimateur consistant est Xnpour estimer l’espé-

rance mathématique.

On a le théorème suivant :

Théorème 1 – Soit (X1,··· ,Xn)un n-échantillon iid de loi Pθ,θ∈Θet tel que

µ=E(Xi)<+∞.

Alors Xnest un estimateur sans biais et consistant de µ.

Preuve : Montrons que Xnest consistant i.e. converge en probabilité. Il

s’agit de montrer que

∀ξ>0,lim

n→+∞P(|Xn−µ|>ξ)=0,

Ce résultat se démontre en appliquant l’inégalité de Tchebychev que l’on

donne ci-dessous.

Inégalité de Tchebychev – Soit Yune variable aléatoire d’espérance et de

variance finies.

Alors :

∀ε>0,P(|Y−EY |>ε)≤V arY

ε2(3.1)

Preuve : Cette inégalité se déduit de l’inégalité de Markov.

58

CHAPITRE 3. ESTIMATION PONCTUELLE

Inégalité de Markov – Soit Xune variable aléatoire positive d’espérance

finie.

Alors :

∀δ>0,P(X>δ)≤E(X)

δ.(3.2)

qui s’obtient en écrivant :

E(X)=Z+∞

−∞

x fX(x)dx ≥Z+∞

δ

δfX(x)dx ≥δP(X>δ).

Si on pose X=|Y−E(Y)|2, en appliquant l’inégalité de Markov, il vient :

P(|Y−E(Y)|2>δ)≤V ar(Y)

δ

d’où

P(|Y−E(Y)|>pδ)≤V ar(Y)

δ.

On pose ε=pδet on obtient l’inégalité de Tchebychev.

Appliquons cette inégalité à Xnet posons V ar(Xi)=σ2.

On a :

∀ξ,P(|Xn−µ|>ξ)≤V ar(Xn)

ξ=σ2

nξ,

puisque

V ar ³Xn´=1

n2

n

X

i=1

V ar(Xi)=σ2

n.

En passant à la limite de part et d’autre de l’inégalité, il vient :

∀ξ,lim

n→+∞P(|Xn−µ|>ξ)=0,

Ce qui montre que Xnest consistant pour estimer µ.

59

L1 - ELÉMENTS DE STATISTIQUE

Consistance en moyenne quadratique

Définition 20 – Soit X=(X1,··· ,Xn)un n-échantillon de v.a. iid de loi Pθ,

θ∈Θ. Soit gn(X)une statistique de X.

On dit que gn(X)est un estimateur consistant en moyenne quadratique

de θssi

lim

n→+∞Eh(gn(X)−θ)2i=0,∀θ∈Θ.

La quantité Eh(gn(X)−θ)2iest appelée l’erreur quadratique de l’estima-

teur.

Le théorème suivant est un outil pour montrer la convergence en moyenne

quadratique d’un estimateur.

Théorème 2 –gn(X)est consistant en moyenne quadratique ssi

(i) lim

n→+∞V arhgn(X)i=0

(ii) gn(X)est asymptotiquement sans biais.

Preuve : Par définition, V ar³gn(X)−θ´=Eh(gn(X)−θ)2i−hE(gn(X)−θ)i2.

On en déduit :

Eh(gn(X)−θ)2i=V ar³gn(X)−θ´+hE(gn(X)−θ)i2

=V ar³gn(X)´+hE³gn(X)−θ´i2

Il s’agit de la somme de 2 quantités positives. Donc si E[(gn(X)−θ)2] tend

vers 0, V ar gn(X) tend vers 0 et E gn(X) tend vers θi.e. gn(X) est asymptoti-

quement sans biais.

La réciproque est évidente.

Théorème 3 – Si gn(X)est consistant en moyenne quadratique alors gn(X)

est consistant.

60

6

6

7

7

8

8

1

/

8

100%