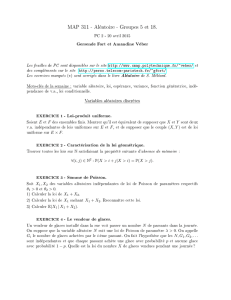

Cours4 Fichier

Probabilités Elémentaires – Licence

Chapitre 4 : Vecteurs aléatoires discrets

1 Couple de variables aléatoires

Définition 1. Soit Xet Ydeux variables aléatoires discrètes définies sur l’espace probabilisable

(Ω,A), et à valeurs respectivement dans Eet F. Le couple (X, Y )définit ce que l’on peut appeler

une variable aléatoire discrète à valeurs dans E×F: à tout ωde Ω, il associe en effet le vecteur

X(ω), Y (ω).

Proposition 1. La loi de probabilité du couple (X, Y ), aussi appelée loi conjointe de (X, Y ), est

déterminée entièrement par la fonction de masse (x, y)7→ P(X=x, Y =y)sur E×F.

Exemple : On lance deux dés à 6 faces équilibrés. Soit Xla somme des résultats et Yleur différence

en valeur absolue : le couple (X, Y )est à valeurs dans {1,· · · ,12} × {0,· · · ,5}. Pour calculer la loi

conjointe de Xet Y, on introduit les variables aléatoires R1et R2représentant les résultats des

deux dés. On a, par exemple :

P(X= 7, Y = 3) =

Définition 2. On appelle lois marginales de Xet de Yles lois respectives de Xet de Y, que l’on

peut calculer à partir de la loi conjointe :

∀x∈E, P(X=x) = Py∈FP(X=x, Y =y).

∀y∈F, P(Y=y) = Px∈EP(X=x, Y =y).

Exemple : En gardant l’exemple précédent, on a :

P(X= 7) =

Définition 3. Soit Xet Ydeux variables aléatoires discrètes définies sur l’espace probabilisable

(Ω,A), et à valeurs respectivement dans les espaces probabilisables (E, E)et (F, F). Soit x∈Etel

que P(X=x)>0. La loi de Yconditionnelle à l’événement (X=x), aussi appelée loi de Y

sachant que X=x, est la probabilité sur (F, F)définie par l’application

B7→ P(X=x)(Y∈B) = P(Y∈B|X=x)

et elle est notée P(X=x)

Y.

Exemple : En gardant l’exemple précédent, la loi conditionnelle P(X=7)

Yest donnée par :

Proposition 2. La famille des probabilités P(X=x)

Y, où xdécrit l’ensemble des éléments de Etels

que P(X=x)>0, et la loi PXde Xdéterminent entièrement la loi du couple aléatoire (X, Y )

Proposition 3. Deux variables aléatoires Xet Ysont indépendantes si et seulement si, pour tout

x∈Etel que P(X=x)>0, la loi conditionnelle P(X=x)

Yest égale à la loi marginale PYde Y.

Définition 4. La moyenne conditionnelle et la variance conditionnelle de Ysachant que

X=xsont la moyenne et la variance calculées à partir de la loi conditionnelle P(X=x)

Y.

Exemple : En gardant l’exemple précédent, la moyenne conditionnelle de Ysachant X= 7 est :

E(Y|X= 7) =

et la variance conditionnelle de Ysachant X= 7 est :

V(Y|X= 7) =

1

2 Vecteur de variables aléatoires

Ce que nous avons dit précédemment se généralise facilement lorsque l’on associe plus de deux

variables aléatoires dans un vecteur.

Définition 5. Soit X1,· · · , Xndes variables aléatoires discrètes définies sur l’espace probabilisable

(Ω,A), et à valeurs respectivement dans E1,· · · , En. Le vecteur (X1,· · · , Xn)définit ce que l’on

peut appeler une variable aléatoire discrète à valeurs dans E1× · · · × En: à tout ωde Ω, il associe

en effet le vecteur X1(ω),· · · , Xn(ω).

Comme précédemment, on peut définir la loi conjointe du vecteur (X1,· · · , Xn), les lois marginales

de X1,· · · , Xnou encore les lois conditionnelles

P(Xj1=xj1,··· ,Xjm=xjm)

Xi,∀{j1,· · · , jm} ⊂ {1,· · · , n}.

Dans de nombreux modèles probabilistes ne sont explicites que la loi de X1,PX1, et les lois condi-

tionnelles de Xisachant X1,· · · , Xi−1, pour tout ientre 2 et n. La loi conjointe du vecteur s’obtient

alors de la manière suivante :

P(X1=x1,· · · , Xn=xn) = P(X1=x1)P(X2=x2|X1=x1)· · · P(Xn=xn|X1=x1,· · · , Xn−1=xn−1).

Parfois, les probabilités conditionnelles P(Xi=xi|X1=x1,· · · , Xi−1=xi−1)ne dépendent que de

xiet de xi−1. On a alors P(Xi=xi|X1=x1,· · · , Xi−1=xi−1) = P(Xi=xi|Xi−1=xi−1)et

P(X1=x1,· · · , Xn=xn) = P(X1=x1)P(X2=x2|X1=x1)· · · P(Xn=xn|Xn−1=xn−1).

Une suite de variables aléatoires (Xi)1≤i≤nsatisfaisant cette condition est dite markovienne.

Exemple : Soit (Ui)1≤i≤nune suite de variables aléatoires indépendantes à valeurs dans Zet soit,

pour i= 1,· · · , n, Xi=U1+· · · +Ui. La suite (Xi)1≤i≤nest markovienne à valeurs dans Z.

En effet, si i≥2,Xi=Xi−1+Ui, si bien qu’on a :

P(Xi=xi|X1=x1,· · · , Xi−1=xi−1) = P(Ui=xi−xi−1|X1=x1,· · · , Xi−1=xi−1)

quels que soient x1,· · · , xi∈Z; la variable aléatoire (X1,· · · , Xi−1)étant indépendante de Ui, on a

P(Xi=xi|X1=x1,· · · , Xi−1=xi−1) = P(Ui=xi−xi−1).

De plus, le même raisonnement conduit à l’égalité

P(Xi=xi|Xi−1=xi−1) = P(Ui=xi−xi−1).

3 Somme de variables aléatoires

On a très souvent besoin de calculer la somme de nvariables aléatoires :

Y=X1+· · · +Xn.

3.1 Loi de probabilité

Quand les variables aléatoires X1,· · · , Xnsont indépendantes, la loi de leur somme peut se calculer

à partir des lois marginales. Nous donnons la méthode de calcul, dite de convolution, dans le cas

où n= 2.

Proposition 4. Soit X1et X2deux variables aléatoires discrètes définies sur l’espace probabilisé

(Ω,A,P), à valeurs dans le même espace probabilisable (E, E), où Eest stable par addition. Alors

la variable aléatoire Y=X1+X2est discrète et sa loi est donnée par :

∀x∈E, P(Y=y) = X

x1∈E

P(X1=x1)P(X2=y−x1).

2

Définition 6. On dit que la loi de probabilité de Y, obtenue à partir de PX1et PX2, est le produit de

convolution ou simplement la convolution des deux probabilités PX1et PX2: elle est notée PX1∗PX2.

Exemple : Loi triangulaire

Soit un entier n≥1et deux variables aléatoires X1et X2indépendantes et de même loi uniforme

sur {0,· · · , n}. On étudie la loi de Y=X1+X2. Pour tout k∈N,ona:

On dit que la loi de Yest symétrique par rapport à n.

Proposition 5. La convolution de deux lois binomiales B(n1, p)et B(n2, p)est une loi binomiale

B(n1+n2, p). La convolution de deux lois de Poisson P(λ1)et P(λ2)est une loi de Poisson P(λ1+

λ2).

3.2 Moments

Proposition 6. La moyenne et la variance de Ysont donnés par

E(Y) =

n

X

i=1

E(Xi)

et

V(Y) =

n

X

i=1

V(Xi)+2

n−1

X

i=1

n

X

j=i+1

cov(Xi, Xj).

Exemple : Moyenne empirique

Supposons que les variables X1,· · · , Xnsoient indépendantes et identiquement distribuées (i.i.d.),

de moyenne met de variance σ2, représentant par exemple nobservations d’une même variable dans

une population. Si la moyenne mest inconnue, il est naturel de l’estimer par la moyenne empirique

des Xi:

¯

X=1

n

n

X

i=1

Xi.

Cette variable aléatoire admet pour moyenne

E(¯

X) =

et pour variance

V(¯

X) =

Ainsi, lorsque le nombre d’observations naugmente, la variance de ¯

Xdiminue et la probabilité que

¯

Xsoit "loin" de mégalement.

3.3 Fonction génératrice

Proposition 7. Soit X1et X2deux variables aléatoires indépendantes à valeurs dans N. La fonction

génératrice de Y=X1+X2est donnée, pour tout s∈[−1,1], par :

GY(s) = GX1(s)GX2(s).

3

1

/

3

100%