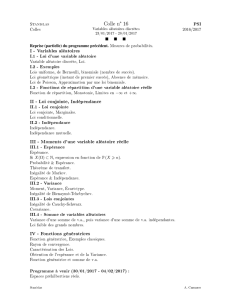

Poly de cours

{P, F }

1 6

1/6

1N

Ω

0 42

26

n[[−n, n]]

Ω

(Ω,T,P)

E

X(Ω)

x∈X(Ω) X−1({x}) = {ω∈Ω; X(ω) = x}y

T

ΩX

ΩXE

X−1(x1)

X−1(xn)

•x1

•x2

•xn

{X=x0}=X−1(x0) = X−1({x0}) = {ω∈Ω; X(ω) = x0}

P(X=x0)P(X>x0)P(X∈A)

ΩX(ω)

P(X=xi) = PX−1({xi})P(X∈A) = PX−1(A)A⊂E

TX

x∈X(Ω) X−1({x})∈ T A⊂E X−1(A)∈ T

TX(Ω)

X−1({x})E

X(Ω) E E =R

X(Ω) = R+

X(ω) Ω

X(ω)

E

X: Ω →EPXEPX(A) = P(X∈A)

PXP(E)

PXP(X=x)x∈E

A E

X(Ω) σ

PX(A) = X

x∈X(Ω)∩A

P(X=x).

R

P(X6t){X6t}

{X=x}x X(Ω)∩]− ∞, t]

X FX

∀t∈R, FX(t) = P(X6t}.

k X1, ..., XkY

{Y6n}=

k

\

i=1

{Xi6n}

FY=FX1FX2...FXkY

X

•FX0 1 −∞ +∞

•FXR\X(Ω)

•FX

•FXtP(X=t)=0

X FX

P(a<X6b) = FX(b)−FX(a)P(a6X6b) = FX(b)−lim

t→a−FX(t).

X

X=x0

X{xi|i∈N}xi(pi)i∈N

Ppi1

P(Ω,T)i∈N P(X=xi) = pi

xi

L {xi|i∈N}P(X=xi)

X → L

B(1/3)

p∈]0,1[ X

p X → B(p)X(Ω) = {0,1}P(X= 1) = pP(X= 0) = 1 −p

1

AA:x∈Ω7→ (1 si x∈A

0 sinon

P(A)

n > 0

B(p)X n

[[0, n]]

k∈[[0, n]] P(X=k) = n

kpk(1 −p)n−kX → B(n, p)

B(8,1/3)

X → B(n, p)kP(X=k)

k>1k−1

k

X(Ω) = N∗∀k∈N∗,P(X=k) = p(1 −p)k−1.

p X → G(p)

G(1/3)

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

1

/

21

100%