Algèbre II Lfma2 Hedi Regeiba

Université de Gabès, Faculté des Sciences de Gabès.

Départements de Mathématiques.

Algèbre II Lfma2

2015-2016

présenté par

Hedi Regeiba

Faculté des Sciences de Gabès, cité Erriadh 6072 Zrig Gabès Tunisie.

II

Contents

1 Formes bilinéaires symetriques. Formes quadratiques. 1

1.1 Formes bilinéaires. ..................................... 1

1.1.1 Généralites. ..................................... 1

1.1.2 Matrice d’une forme bilinéaire. ........................... 2

1.2 Formes quadratiques. .................................... 4

1.2.1 Généralites. ..................................... 4

1.2.2 Matrice d’une forme quadratique. ......................... 5

1.2.3 Epression de q(x)................................... 6

1.3 Formes positives, Formes définies positives. ........................ 7

1.3.1 Formes non dégénérées. ............................... 8

1.4 Décomposition en somme de carrés par la méthode de Gauss. .............. 8

2 Espaces préhilbertiens réels. 15

2.1 Produit scalaire, norme et distance. ........................... 15

2.1.1 Produit scalaire sur un R-espace vectoriel. .................... 15

2.1.2 Norme et distance associée. ............................ 16

2.2 Orthogonalité. ....................................... 17

2.2.1 Vecteurs orthogonaux. ............................... 17

2.2.2 Orthogonal d’une partie. .............................. 18

2.2.3 Algorithme d’orthonormalisation de Schmidt. .................. 19

2.2.4 Produit mixte. ................................... 20

2.2.5 Interprétation du produit mixte. .......................... 21

2.2.6 Supplémentaire orthogonal. ............................ 21

2.3 Hyperplans affines d’un espace euclidien. ......................... 22

2.3.1 Vecteur normal à un hyperplan d’un espace euclidien. .............. 22

2.3.2 Équations d’un hyperplan dans une base orthonormale. ............ 24

2.3.3 Calcul de la distance à un hyperplan affine. ................... 24

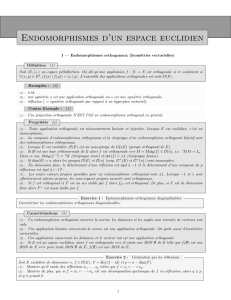

2.4 Isométries vectorielles d’un espace euclidien. ....................... 25

2.4.1 Symétries vectorielles orthogonales. ........................ 26

2.4.2 Matrices orthogonales. ............................... 27

2.4.3 Matrices orthogonales positives ou négatives. .................. 28

2.4.4 Isométries positives, négatives. .......................... 29

2.5 Isométries en dimension 2.................................. 29

2.6 Projection orthogonale. .................................. 31

2.7 Suites orthonormales de vecteurs d’un espace préhilbertien réel. ............ 32

2.8 Adjoint d’un endomorphisme. ............................... 33

III

IV CONTENTS

2.8.1 Endomorphismes autoadjoints (Endomorphismes symétriques d’un espace eu-

clidien). ....................................... 34

2.8.2 Réduction des endomorphismes symétriques. .................. 35

2.8.3 Réduction d’une isométrie vectorielle. ....................... 37

2.8.4 Réduction des isométries positives en dimension 3................ 38

Chapter 1

Formes bilinéaires symetriques. Formes

quadratiques.

1.1 Formes bilinéaires.

1.1.1 Généralites.

Définition 1.1.1. Soit Eun R-e-v et f:E×E−→ R

(x, y)7→ f(x, y)

une application, on dit que f

est une forme bilinéaire si les applications fx:E−→ R

y7→ f(x, y)

et fy:E−→ R

x7→ f(x, y)

sont

linéaires.

Proposition 1.1.2. f:E×E−→ Rest bilinéaire si et seulement si

1. ∀α∈R,(x, y, z)∈E3f(αx +z, y) = αf (x, y) + f(z, y).

2. ∀α∈R,(x, y, z)∈E3f(x, αy +z) = αf(x, y) + f(x, z).

Définition 1.1.3. Soit fune forme bilinéaire sur un R-e-v E. On dit que

1. fest symétrique si f(x, y) = f(y, x).

2. fest antisymétrique si f(x, y) = −f(y, x).

Notations 1.1.4. Soit Eun R-e-v.

1. L’ensemble de forme bilinéaires sur Eest noté L2(E).

2. L’ensemble de forme bilinéaires symétriques sur Eest noté S2(E).

3. L’ensemble de forme bilinéaires antisymétrique sur Eest noté A2(E).

Proposition 1.1.5. Soit Eun R-e-v, alors

1. L2(E)est un R-e-v.

1

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

1

/

43

100%

![[ alg bre ] 2011/2012 Oran 2eme devoir surveill ( 2eme ann e )](http://s1.studylibfr.com/store/data/008146156_1-20a7ad0fb2ddca5a298d6770aaecdd81-300x300.png)